Meta生成式AI連放大招:視頻生成超越Gen-2,動圖表情包隨心定制

提到視頻生成,很多人首先想到的可能是 Gen-2、Pika Labs。但剛剛,Meta 宣布,他們的視頻生成效果超過了這兩家,而且編輯起來還更加靈活。

這個「吹小號、跳舞的兔子」是 Meta 發(fā)布的最新 demo。從中可以看出,Meta 的技術(shù)既支持靈活的圖像編輯(例如把「兔子」變成「吹小號的兔子」,再變成「吹彩虹色小號的兔子」),也支持根據(jù)文本和圖像生成高分辨率視頻(例如讓「吹小號的兔子」歡快地跳舞)。

其實,這其中涉及兩項工作。

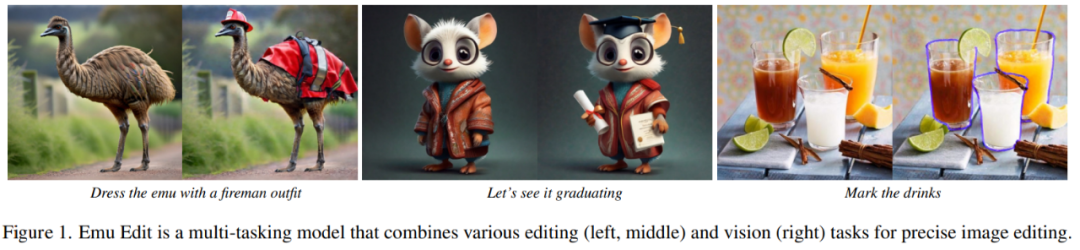

靈活的圖像編輯由一個叫「Emu Edit」的模型來完成。它支持通過文字對圖像進行自由編輯,包括本地和全局編輯、刪除和添加背景、顏色和幾何轉(zhuǎn)換、檢測和分割等等。此外,它還能精確遵循指令,確保輸入圖像中與指令無關(guān)的像素保持不變。

給鴕鳥穿裙子

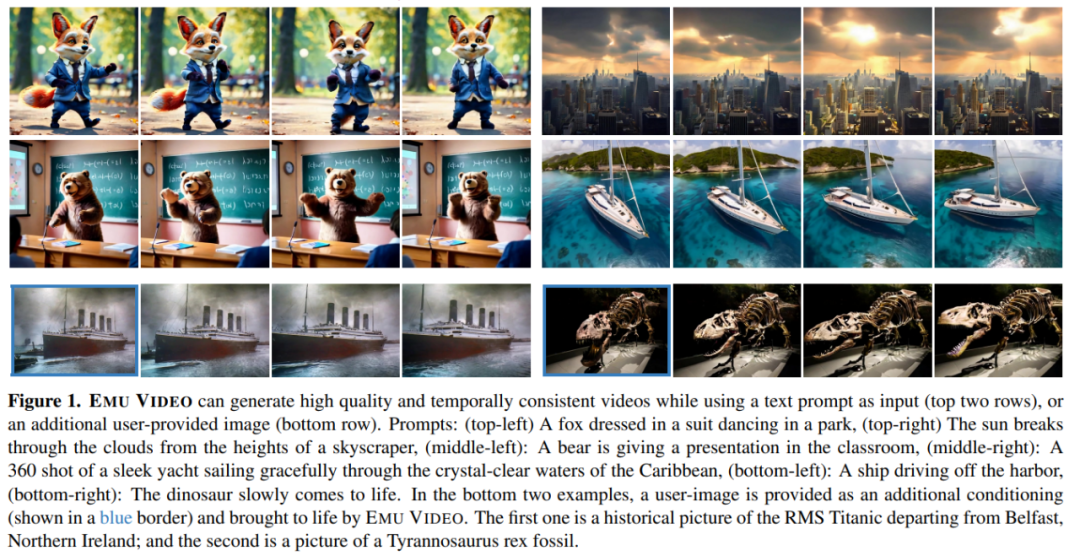

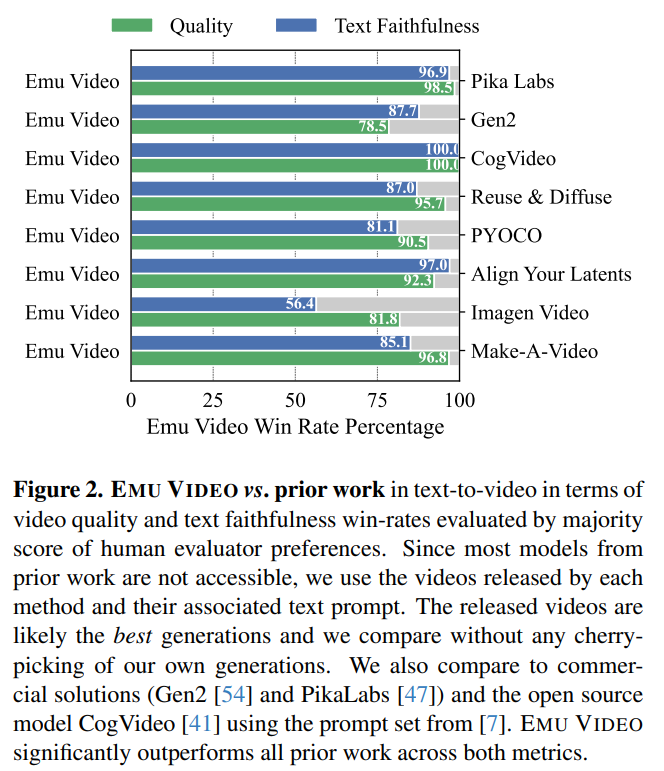

高分辨率的視頻則由一個名叫「Emu Video」的模型來生成。Emu Video 是一個基于擴散模型的文生視頻模型,能夠基于文本生成 512x512 的 4 秒高分辨率視頻(更長的視頻在論文中也有討論)。一項嚴(yán)格的人工評估表明,與 Runway 的 Gen-2 以及 Pika Labs 的生成效果相比,Emu Video 在生成質(zhì)量和文本忠實度方面的得分都更高。以下是它的生成效果:

在官方博客中,Meta 展望了這兩項技術(shù)的應(yīng)用前景,包括讓社交媒體用戶自己生成動圖、表情包,按照自己的意愿編輯照片和圖像等等。關(guān)于這點,Meta 在之前的 Meta Connect 大會上發(fā)布 Emu 模型時也提到過(參見:《Meta 版 ChatGPT 來了:Llama 2 加持,接入必應(yīng)搜索,小扎現(xiàn)場演示》)。

接下來,我們將分別介紹這兩個新模型。

EmuVideo

大型文生圖模型在網(wǎng)絡(luò)規(guī)模的圖像 - 文本對上經(jīng)過訓(xùn)練,可生成高質(zhì)量的多樣化圖像。雖然這些模型可以通過使用視頻 - 文本對進一步適用于文本 - 視頻(T2V)生成,但視頻生成在質(zhì)量和多樣性方面仍然落后于圖像生成。與圖像生成相比,視頻生成更具挑戰(zhàn)性,因為它需要建模更高維度的時空輸出空間,而能依據(jù)的仍然只是文本提示。此外,視頻 - 文本數(shù)據(jù)集通常比圖像 - 文本數(shù)據(jù)集小一個數(shù)量級。

視頻生成的主流模式是使用擴散模型一次生成所有視頻幀。與此形成鮮明對比的是,在 NLP 中,長序列生成被表述為一個自回歸問題:以先前預(yù)測的單詞為條件預(yù)測下一個單詞。因此,后續(xù)預(yù)測的條件信號(conditioning signal)會逐漸變強。研究者假設(shè),加強條件信號對高質(zhì)量視頻生成也很重要,因為視頻生成本身就是一個時間序列。然而,使用擴散模型進行自回歸解碼具有挑戰(zhàn)性,因為借助此類模型生成單幀圖像本身就需要多次迭代。

因此,Meta 的研究者提出了 EMU VIDEO,通過顯式的中間圖像生成步驟來增強基于擴散的文本到視頻生成的條件。

論文地址:https://emu-video.metademolab.com/assets/emu_video.pdf

項目地址:https://emu-video.metademolab.com/

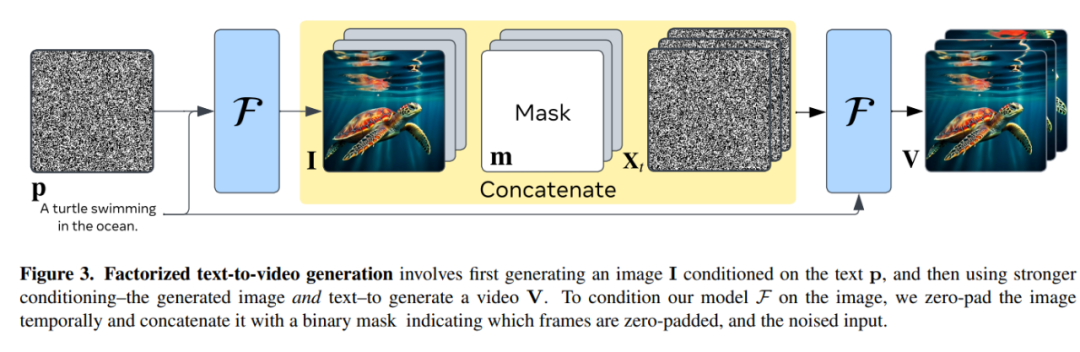

具體來說,他們將文生視頻問題分解為兩個子問題:(1) 根據(jù)輸入的文本提示生成圖像;(2) 根據(jù)圖像和文本的強化條件生成視頻。直觀地說,給模型一個起始圖像和文本會使視頻生成變得更容易,因為模型只需預(yù)測圖像在未來將如何演變即可。

Meta 的研究者將文生視頻分為兩步:首先生成以文本 p 為條件的圖像 I,然后使用更強的條件 —— 生成的圖像和文本 —— 來生成視頻 v。為了以圖像約束模型 F,他們暫時對圖像進行補零,并將其與一個二進制掩碼(指示哪些幀是被補零的)以及帶噪聲的輸入連接起來。

由于視頻 - 文本數(shù)據(jù)集比圖像 - 文本數(shù)據(jù)集要小得多,研究者還使用權(quán)重凍結(jié)的預(yù)訓(xùn)練文本 - 圖像 (T2I) 模型初始化了他們的文本 - 視頻模型。他們確定了關(guān)鍵的設(shè)計決策 —— 改變擴散噪聲調(diào)度和多階段訓(xùn)練 —— 直接生成 512px 高分辨率的視頻。

與直接用文本生成視頻的方法不同,他們的分解方法在推理時會顯式地生成一張圖像,這使得他們能夠輕松保留文生圖模型的視覺多樣性、風(fēng)格和質(zhì)量(如圖 1 所示)。這使得 EMU VIDEO 即使在訓(xùn)練數(shù)據(jù)、計算量和可訓(xùn)練參數(shù)相同的情況下,也能超越直接 T2V 方法。

這項研究表明,通過多階段的訓(xùn)練方法,文生視頻的生成質(zhì)量可以得到大幅提高。該方法支持直接生成 512px 的高分辨率視頻,不需要先前方法中使用的一些深度級聯(lián)模型。

研究者設(shè)計了一個穩(wěn)健的人工評估方案 ——JUICE,要求評估者在兩兩比較中做出選擇時證明他們的選擇是正確的。如圖 2 所示,EMU VIDEO 在質(zhì)量和文本忠實度方面的平均勝率分別為 91.8% 和 86.6%,大大超越了包括 Pika、Gen-2 等商業(yè)解決方案在內(nèi)的所有前期工作。除 T2V 外,EMU VIDEO 還可用于圖像 - 視頻生成,即模型根據(jù)用戶提供的圖像和文本提示生成視頻。在這種情況下,EMU VIDEO 的生成結(jié)果有 96% 優(yōu)于 VideoComposer。

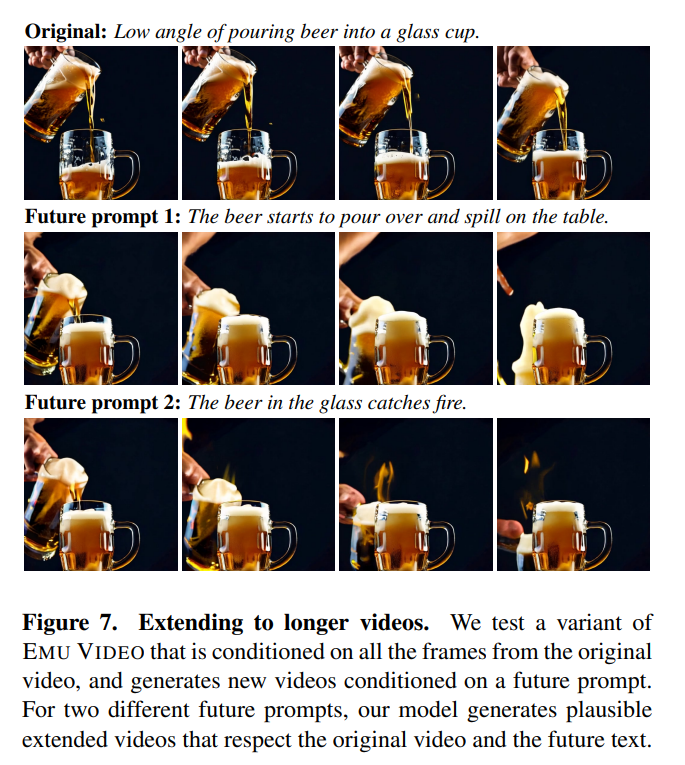

從展示的 demo 中可以看到,EMU VIDEO 已經(jīng)可以支持 4 秒的視頻生成。在論文中,他們還探討了增加視頻時長的方法。作者表示,通過一個小的架構(gòu)修改,他們可以在 T 幀上約束模型并擴展視頻。因此,他們訓(xùn)練 EMU VIDEO 的一個變體,以「過去」16 幀為條件生成未來 16 幀。在擴展視頻時,他們使用與原始視頻不同的未來文本提示,效果如圖 7 所示。他們發(fā)現(xiàn),擴展視頻既遵循原始視頻,也遵循未來文本提示。

Emu Edit :精確的圖像編輯

每天都有數(shù)百萬人使用圖像編輯。然而,流行的圖像編輯工具要么需要相當(dāng)多的專業(yè)知識,使用起來很耗時,要么非常有限,僅提供一組預(yù)定義的編輯操作,如特定的過濾器。現(xiàn)階段,基于指令的圖像編輯試圖讓用戶使用自然語言指令來解決這些限制。例如,用戶可以向模型提供圖像并指示其「給鴯鹋穿上消防員服裝」這樣的指令(見圖 1)。

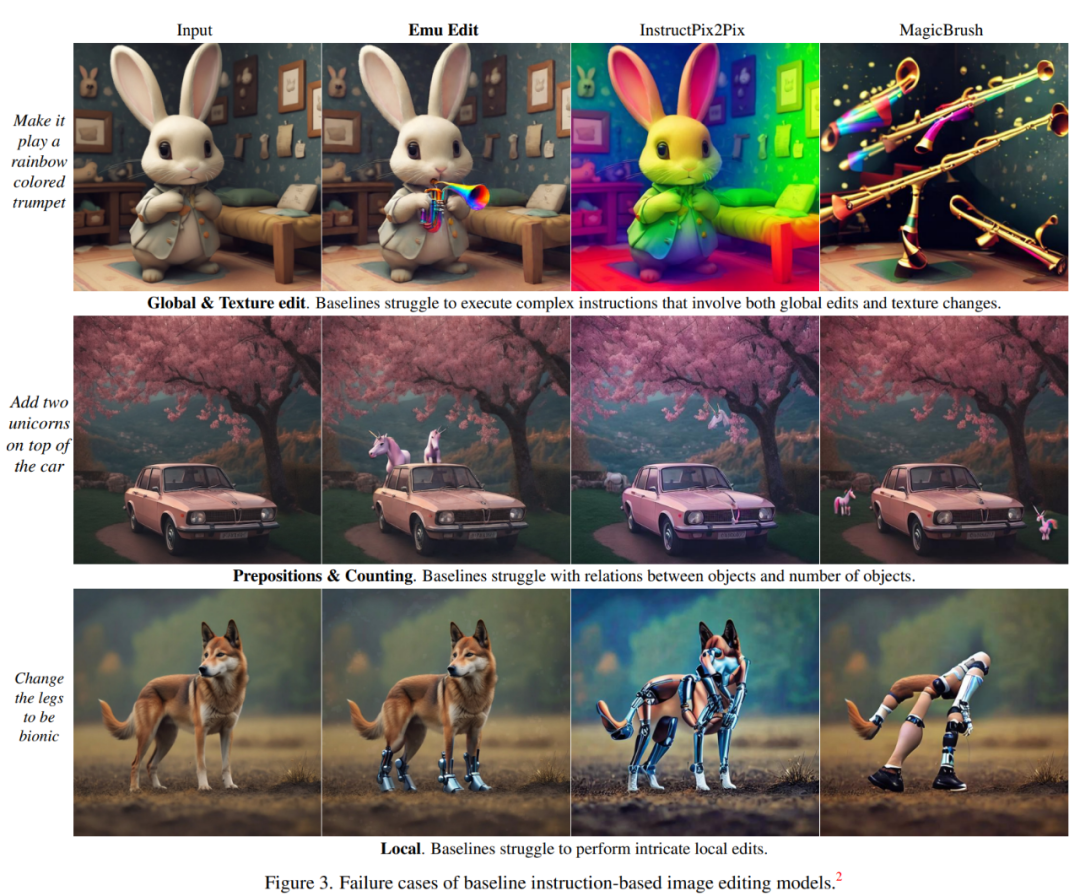

然而,雖然像 InstructPix2Pix 這類基于指令的圖像編輯模型可以用來處理各種給定的指令,但它們通常很難準(zhǔn)確地解釋和執(zhí)行指令。此外,這些模型的泛化能力有限,通常無法完成與訓(xùn)練時略有不同的任務(wù)(見圖 3),例如讓小兔子吹彩虹色的小號,其他模型要么把兔子染成彩虹色,要么是直接生成彩虹色的小號。

為了解決這些問題,Meta 引入了 Emu Edit,這是首個在廣泛且多樣化的任務(wù)上訓(xùn)練而成的圖像編輯模型,Emu Edit 可以根據(jù)指令進行自由形式的編輯,包括本地和全局編輯、刪除和添加背景、顏色改變和幾何變換、檢測和分割等任務(wù)。

論文地址:https://emu-edit.metademolab.com/assets/emu_edit.pdf

項目地址:https://emu-edit.metademolab.com/

與當(dāng)今許多生成式 AI 模型不同,Emu Edit 可以精確遵循指令,確保輸入圖像中與指令無關(guān)的像素保持不變。例如,用戶給出指令「將草地上的小狗移除」,移除物體后的圖片幾乎看不出來有什么變化。

移除圖片中左下角的文本,再給圖片換個背景,Emu Edit 也能處理得很好:

為了訓(xùn)練這個模型,Meta 開發(fā)了一個包含 1000 萬個合成樣本的數(shù)據(jù)集,每個樣本都包含一個輸入圖像、對要執(zhí)行任務(wù)的描述以及目標(biāo)輸出圖像。因而 Emu Edit 在指令忠實度和圖像質(zhì)量方面都顯示出前所未有的編輯結(jié)果。

在方法層面,Meta 訓(xùn)練的模型可以執(zhí)行十六個不同的圖像編輯任務(wù),這些任務(wù)涵蓋基于區(qū)域的編輯任務(wù)、自由格式編輯任務(wù)和計算機視覺任務(wù),所有這些任務(wù)都被表述為生成任務(wù),Meta 還為每個任務(wù)開發(fā)了一個獨特的數(shù)據(jù)管理 pipeline 。Meta 發(fā)現(xiàn),隨著訓(xùn)練任務(wù)數(shù)量的增加,Emu Edit 的性能也會隨之提高。

其次,為了有效地處理各種各樣的任務(wù),Meta 引入了學(xué)習(xí)任務(wù)嵌入(learned task embedding)的概念,它用于引導(dǎo)生成過程朝著正確的生成任務(wù)方向發(fā)展。具體來說,對于每個任務(wù),本文學(xué)習(xí)一個獨特的任務(wù)嵌入向量,并通過交叉注意力交互將其集成到模型中,并將其添加到時間步嵌入中。結(jié)果證明,學(xué)習(xí)任務(wù)嵌入顯著增強了模型從自由格式指令中準(zhǔn)確推理并執(zhí)行正確編輯的能力。

今年 4 月,Meta 上線「分割一切」AI 模型,效果驚艷到很多人開始懷疑 CV 領(lǐng)域到底還存不存在。短短幾個月的時間,Meta 在圖像、視頻領(lǐng)域又推出 Emu Video 和 Emu Edit ,我們只能說,生成式 AI 領(lǐng)域真的太卷了。

了解更多內(nèi)容,請查看原論文。