國產GPTs來了,基于智譜第4代大模型!模型性能均達GPT-4九成以上

國產大模型玩家智譜AI,交出最新成績單——

發布全自研第四代基座大模型GLM-4,且所有更新迭代的能力全量上線。

作為國內唯一一個產品線全對標OpenAI的大模型公司,智譜年前攢了波大的:

按官方說法,GLM-4性能相比GLM-3提升60%,逼近GPT-4(11月6日最新版本效果)。

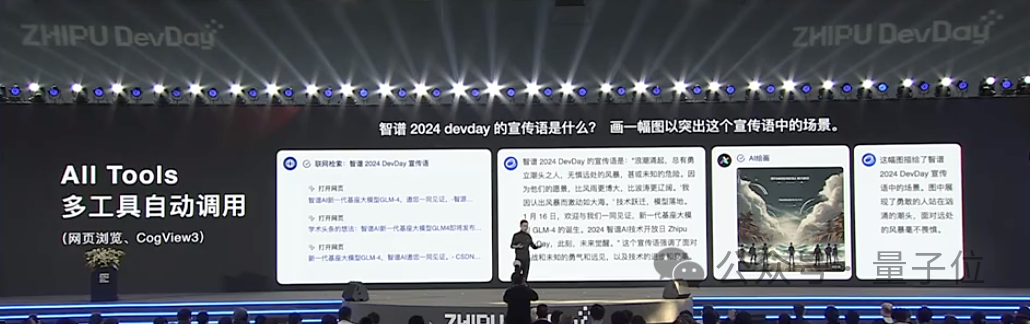

而同時推出的GLM-4-All Tools,能夠完成用戶意圖理解-復雜指令規劃-自由調用GLM生態的多種模型能力。

值得一提的是,智譜發布了GLMs,為所有開發者提供AI智能體定制能力,簡單prompt指令就能創建個性化GLM智能體。

之前,智譜CEO張鵬就明確過:

OpenAI摸著石頭過河,我們摸著OpenAI過河。

摸來摸去摸了一年,以每3-4個月升級一次基座模型的速度,智譜摸著OpenAI過河的最新成績到底怎么樣?真如所說嗎?

當官方用上“可對比”“對標”“追平”等字眼后,智譜接下來的路又會怎么走?

好奇,感興趣,想知道。

(我猜你們也是)。

所以,發布GLM-4的智譜AI技術開放日現場,我們替沒到場的小伙伴聽了、看了;滿肚子的問題,我們也幫大家抓住張鵬問了。

GO——

“摸著OpenAI”,路走成什么樣了?

智譜為什么敢喊出“逼近”甚至部分超過GPT-4?

老規矩,直接一起看GLM-4的現場演示:

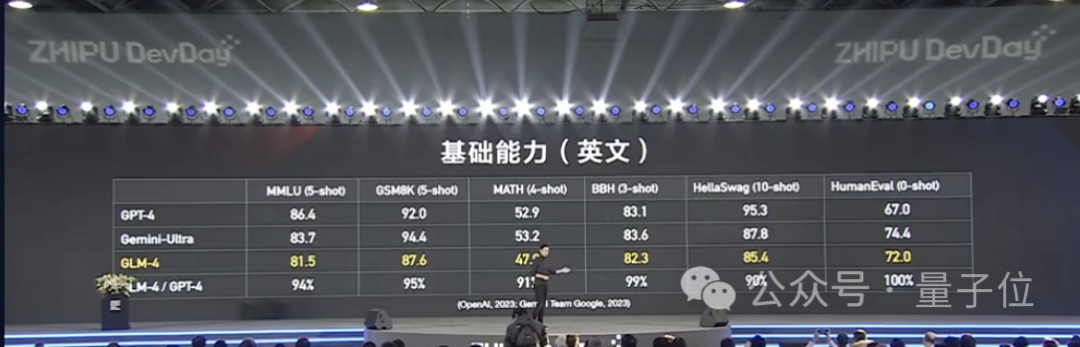

首先來看整體性能。

基礎能力方面,張鵬在現場介紹了GLM-4在各項評測集上的最終得分。

- MMLU:81.5,達到GPT-4的94%水平;

- GSM8K:87.6 ,達到GPT-4的95%水平;

- MATH :47.9,達到GPT-4的91%水平;

- BBH :82.3,達到GPT-4的99%水平;

- HellaSwag :85.4,達到GPT-4 的90%水平;

- HumanEval:72,達到GPT-4的100%水平。

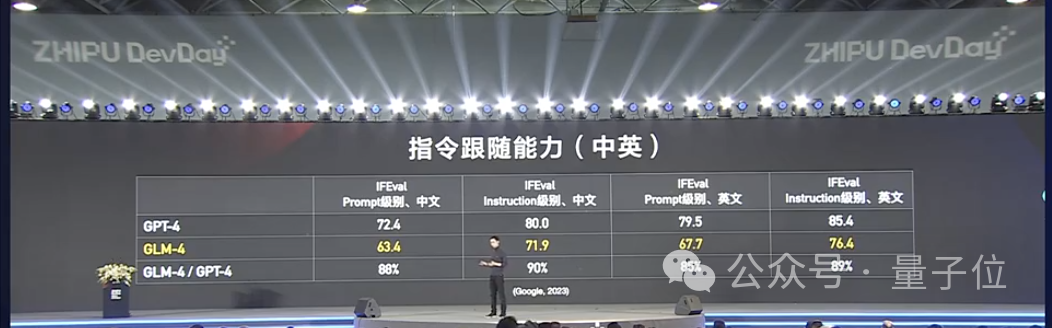

指令跟隨能力方面,和GPT-4相比,IFEval在Prompt提示詞跟隨(中文)方面達到88%,指令跟隨(中文)方面達到 90%水平,超過GPT-3.5。

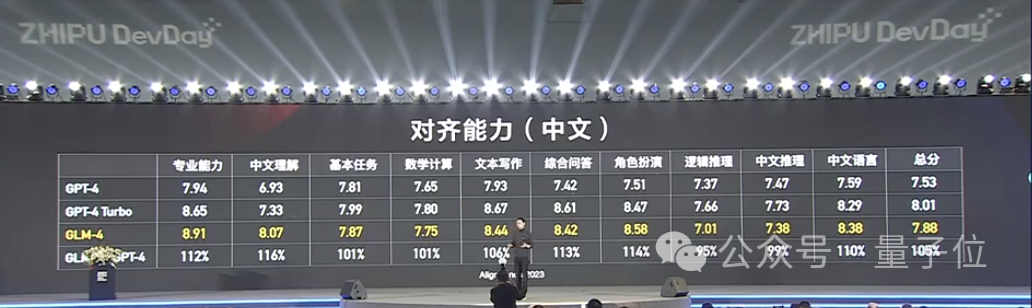

對齊能力上,基于AlignBench數據集,GLM-4超過了GPT-4的6月13日版本,逼近GPT-4最新(11月6日版本)效果。

在專業能力、中文理解、角色扮演方面,GLM-4超過GPT-4精度。

不過張鵬也表示,GLM-4在中文推理方面的能力,還有待進一步提升。

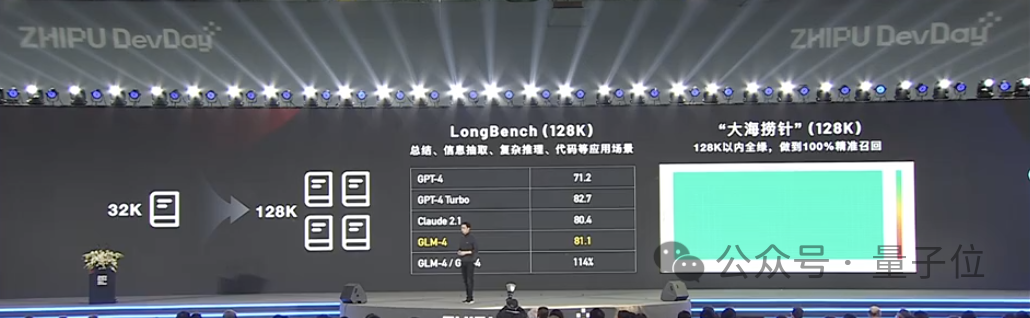

其次,在大模型的“內存”能力方面,GLM-4系列支持128k上下文窗口長度,單次提示詞可處理文本300頁,比前作有所提升。

在needle test大海撈針測試中,GLM-4在128K文本長度內均可做到幾乎百分之百精度召回。

除此之外,GLM-4系列集成了一些新能力在身上,主要是Agent能力和多模態能力。

多模態能力方面,GLM-4則是把原本就有的文生圖(CogView3)、代碼能力做了升級。

智譜強調,CogView3效果超過開源最佳的Stable Diffusion XL,逼近DALLE·3。

至于Agent能力方面,此前智譜發布過AgentLM系列并開源。

這次是把Agent能力整合進了GLM-4,有了GLM-4-All Tools。

它可以根據用戶意圖,自動理解、規劃復雜指令,自由調用文生圖、代碼解釋器、網頁瀏覽能力,以完成復雜任務。

對GLM-4的發布,綜合下來給人一種這樣的感覺:

去年10月底第3代基座大模型,該公司在模型產品線上和OpenAI逐一對齊;第4代是在拉齊模型能力和OpenAI GPT-4的能力水平線。

明顯能感覺到,智譜的基座模型越往后升級,越開始不強調模型參數大小,轉而開始盡可能地向外界展示可用能力。

為什么不想強調參數規模了?會像OpenAI一樣逐漸close起來嗎?

量子位打聽了一番,聽到的消息是,現在的技術主流路線已經發現并不是參數量越大越好——當然,模型越“大”,肯定能帶來能力涌現的好處,但模型越大,成本就越高,成本高自然不是市場想要追求的。

同時,現在的技術演進和發展已經表明,追求更好的能力,可以用一些更精細的方法,在保證模型無需十倍級提升參數的情況下,大幅提升性能。

以上兩個原因相加,是智譜也不再強調基座模型參數的背后原因。

參數不強調了,外界的目光自然更加緊盯這一代基座模型的性能——這確實是智譜這回想要強調的東西。

接下來將主要發力三個方向

“大模型的技術,不是說把原來系統里的小模型扔掉,換上大模型的接口就行了。這只是在局部做了替換,本質上并無改變。”張鵬解釋道,“但我們大家潛意識里期待的,是完全的革新和創新,是不需要原來的那套結構。”

他補充解釋,從新技術出發,改造整個生產流程、提升生產效率和生產力,這就是擁有大模型能力后,“AI原生”會完成的任務。“那AI原生的應用前提條件是什么?還是得回到模型本身的能力。”

張鵬表示,模型能力足夠強、維度足夠多、能力要能融合產生化學反應從而擴大能力空間,本質上還是看模型能力的事兒。

我們想得很清楚,還是要做好我們最擅長、最喜歡的事情,然后大家一起來做這個生態。

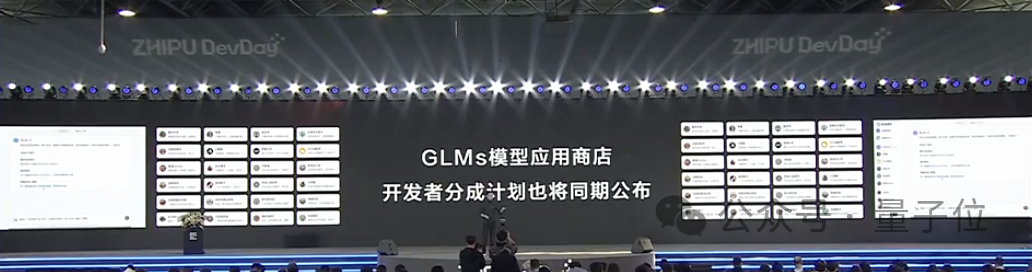

為了把GLM的生態圈建起來、建好,摸著OpenAI過河的智譜,這會推出了可定制化的GLM。

也就是GLMs。

無論任何用戶,只要用簡單的prompt指令,就能創建屬于自己的GLM個性化智能體。

張鵬還在現場宣布,智譜智能體中心也同時上線。

等等……既然GLMs有了,GLM Store是不是也不遠了?!

好問題。量子位當然第一時間拿這個問題問了張鵬。

得到的答案是:

緊接著,我們鍥而不舍地拋出了新的問題:

如果說之前的行為都是在摸著OpenAI過河,那么現在,智譜的基座模型喊出對標GPT-4,接下來的路會怎么走?

張鵬稍稍透露了那么一點,主要是在三個方向發力。

- 超級智能

- 超級對齊

- 具身智能

其中比較值得拿出來說道說道的,是“超級對齊”這一點。

這里回顧一下有關超級對齊的前情提要:去年7月,OpenAI首次提出超級對齊這一概念,宣布成了一個新的研究團隊,在未來4年投入20%算力,用AI監督AI的方式,解決超級智能AI與人類意圖對齊的問題。

“我個人覺得,在(超級對齊)這件事情上,可能我們認知還沒有那么深,或者說大家對這事情的認知不太一致。”張鵬說。

在他看來,OpenAI創始人之一Ilya想做到的超級對齊,是想要在AI從誕生之時起,就從底層保持著對人類最大限度的愛,“他是要去探尋本源。自訓練、自學習這樣的能力實際上是對世界知識的一種壓縮和表示,所以實現這個目標,需要從知識或數據層面來解決。”

簡單來說,Ilya有關超級對齊的研究,可以等價為嘗試開黑盒,然后設法從AI智能產生的那一刻起,就和人類意圖對齊。

而張鵬表示,他個人在現階段更傾向于另一派的觀點,即從行為主義角度出發。

“超級對齊究竟是什么?想要對齊一個東西,這東西都還不存在,咋對齊?對齊啥呢?”

從行為學角度考慮,就不用考慮開黑盒的問題,研究者只需要像教育孩子一樣,先觀察小孩的行為。看到AI行為是錯的,就給一巴掌;行為是對的,就給一顆糖。

想要成為“AGI元年”,2024需要面對什么?

2024年,短短半個月期間,GPT上線了GPT Store,智譜推出了GLM-4……

而這一年才剛剛開始。

熱鬧非凡的百模大戰打了一年,有的玩家已經偃旗息鼓了,但可以肯定,OpenAI會帶領GPT繼續迭代,智譜或許也會繼續以3-4月更新一次基座模型的速度向前推進,國外的Anthropic、Mistral AI、Google,國內的零一萬物、MiniMax等都會如此。

那么,如果按照業界默認,稱剛剛過去的2023年為大模型元年的話,2024想要“化身”AGI元年,正面臨哪些挑戰?

去年3月,在量子位舉辦的AIGC峰會上,張鵬認為外界環境帶來的三大挑戰是人力、成本和算法。

當現在把這個問題丟到張鵬面前時,他的看法是,加入到大模型研究中的人已經極大豐富了,困境有所緩解;取代它位列新三大困境之一的則是“環境”。

一方面,挑戰者能不能有足夠的敏銳度,從環境中尋找并掌握突破口?

張鵬用他前段時間在某群里刷到的一個視頻作為形象的例子,那個視頻展示的是許多人小時候玩兒過的小球消磚塊游戲。

最佳情況是把球從正好的角度打進磚塊包圍的缺口,然后形成數次拐彎,消滅掉所有的磚塊。

實際上這個機率很小,很多次都會和“正好”的角度擦肩而過;或者看似瞄準了缺口,又不幸地被擋住彈了回來。

終于有一天,你打進了缺口,然后什么都不用干,自然而然所有的磚塊都被消除了。

另一方面,在不斷試錯、不斷失敗的過程中,市場乃至整個社會對技術的耐心能夠持續多長時間?

如果市場失去耐心,大模型這樣一個消耗很大資源要做的事,立刻會陷入玩不下去的窘境。

然而玩彈球磚塊游戲,很多人并不能堅持到磚塊全部消除。

“前面的試錯、鋪墊是難以忍受的。就像面對科技創新,大家期待的都是最后的爆發時刻。”