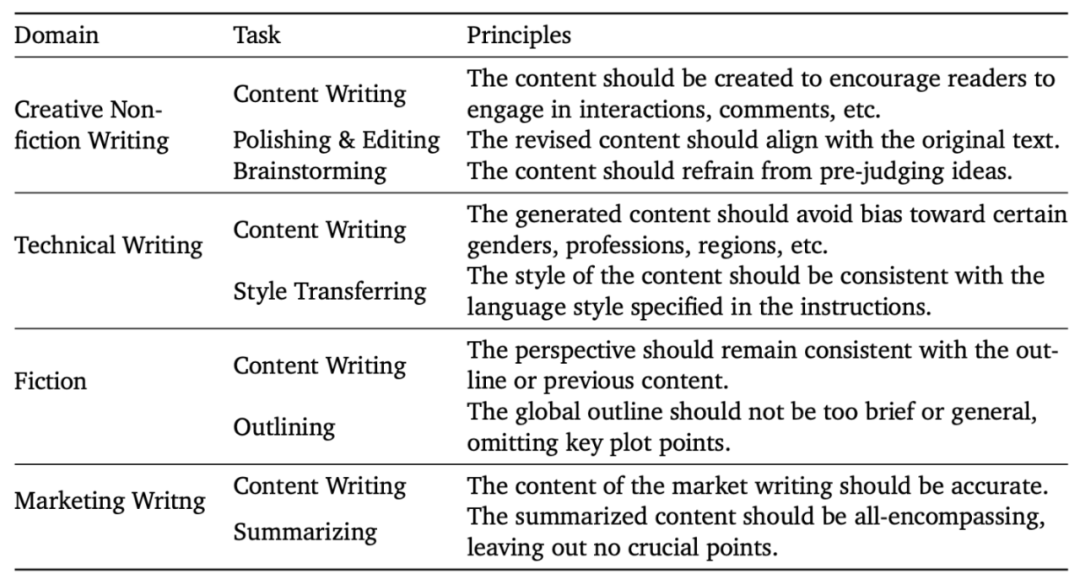

中文創(chuàng)意寫作能力超GPT-4,「最會寫」的中文大模型Weaver來了

ChatGPT 等通用大模型支持的功能成百上千,但是對于普通日常用戶來說,智能寫作一定是最常見的,也是大模型最能真正幫上忙的使用場景之一。盡管大模型經(jīng)常能寫出看起來像模像樣的文字,但是大多數(shù)情況下內(nèi)容的創(chuàng)意程度和文風(fēng)都經(jīng)不起深究。尤其是在創(chuàng)作領(lǐng)域,大模型常見的 “GPT 文風(fēng)” 更是讓利用大模型進(jìn)行創(chuàng)意寫作看起來簡單,實際卻困難重重。

近日,波形智能的大模型團(tuán)隊發(fā)布了一款專精 AI 寫作的專業(yè)大模型 Weaver。通過寫作領(lǐng)域?qū)I(yè)預(yù)訓(xùn)練和一套創(chuàng)新性的數(shù)據(jù)生成和 Alignment 算法,Weaver 在寫作領(lǐng)域的各種任務(wù)上均取得了領(lǐng)先 GPT-4 和眾多中文通用大模型的效果,尤其是在生成內(nèi)容的創(chuàng)意性和文風(fēng)質(zhì)量上大幅領(lǐng)先,是一款更能寫出 “人話” 的大模型。

- 論文地址:https://arxiv.org/pdf/2401.17268.pdf

- 在線 Demo:https://www.wawawriter.com/

ChatGPT 等大模型在通用指令跟隨和問答任務(wù)中效果出色,但是將大模型應(yīng)用于專業(yè)寫作,尤其是需要創(chuàng)造性和個性化文風(fēng)的創(chuàng)意寫作領(lǐng)域卻依然面臨重重阻礙。其中最大的問題就是大模型生成內(nèi)容風(fēng)格過于平淡,或者說文風(fēng)過于 “GPT”,缺少創(chuàng)造性。

為了解決這個問題,訓(xùn)練出更適合專業(yè)寫作的大模型,波形智能的研究團(tuán)隊分析了為什么 GPT 和其他通用大模型都做不好創(chuàng)意寫作類任務(wù)。首先,通用大模型的預(yù)訓(xùn)練過程,因為希望讓模型在更多的數(shù)據(jù)中自監(jiān)督學(xué)習(xí),預(yù)訓(xùn)練的數(shù)據(jù)集中常常會包含非常多的低質(zhì)量內(nèi)容,真正由專業(yè)作家和內(nèi)容創(chuàng)作者寫作的高質(zhì)量文本內(nèi)容可能只占預(yù)訓(xùn)練數(shù)據(jù)總量的 0.1% 不到。因此,經(jīng)過預(yù)訓(xùn)練后的語言模型在建模了整個互聯(lián)網(wǎng)的文本分布之后,自然會傾向于輸出較為普通的內(nèi)容。而在模型的對齊階段,OpenAI 等公司眾包標(biāo)注指令微調(diào)數(shù)據(jù)集的過程中的標(biāo)注員的教育 / 寫作水平有限,沒有對標(biāo)注者的寫作 / 創(chuàng)作能力進(jìn)行篩選。另外標(biāo)注的過程中的標(biāo)準(zhǔn)也主要強調(diào)回答的無害性 (harmlessness) 和有效性 (helpfulness),而沒有考慮回答內(nèi)容的創(chuàng)造性和語言 / 寫作風(fēng)格。因此,經(jīng)過指令微調(diào)的語言模型反而更容易生成平庸無趣的文字。最后,在 RLHF/DPO 等 alignment 算法中,模型的訓(xùn)練數(shù)據(jù)和 Reward Model 均由經(jīng)過指令微調(diào)后的模型生成或訓(xùn)練得到,因此對于文風(fēng)和創(chuàng)造性上,RLHF/DPO 的過程也只能是 “矮子里拔將軍”,無法強化出真正擅長寫作的大模型。

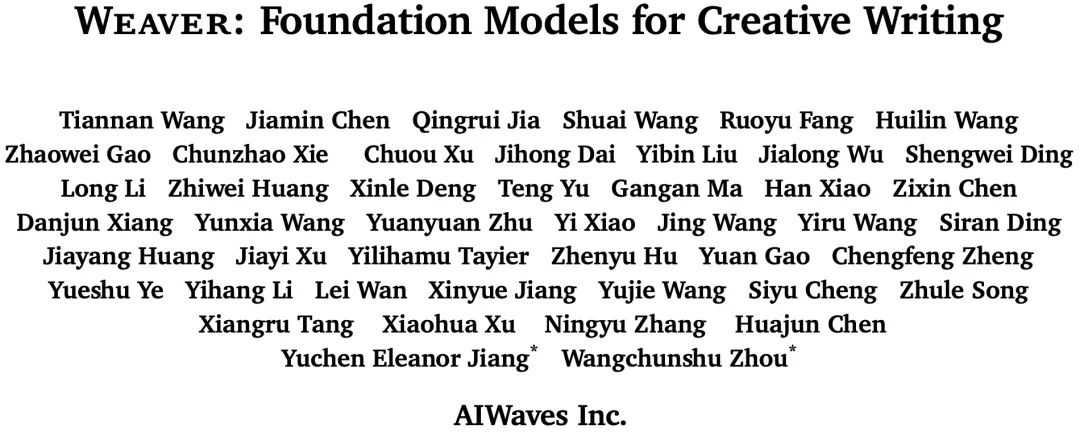

基于此觀察,波形智能的大模型團(tuán)隊提出了一個尤其適合創(chuàng)意寫作領(lǐng)域的垂域?qū)I(yè)模型訓(xùn)練 pipeline,并基于此方案訓(xùn)練了 Weaver,一個全球領(lǐng)先的創(chuàng)意寫作大模型。該方案覆蓋了模型的 (持續(xù)) 預(yù)訓(xùn)練,指令微調(diào) (instruction tuning),和對齊 (RLHF/DPO) 階段。在預(yù)訓(xùn)練階段,團(tuán)隊進(jìn)行了非常仔細(xì)的數(shù)據(jù)篩選和過濾,利用人工 + 規(guī)則 + 機器學(xué)習(xí)模型協(xié)同的方案,從開源預(yù)訓(xùn)練數(shù)據(jù)集中找到了高質(zhì)量的小說 / 短故事 / 創(chuàng)意文案等類別的文本內(nèi)容,舍棄掉了大量的低質(zhì)量內(nèi)容和代碼 / 廣告等數(shù)據(jù),并下采樣了一部分高質(zhì)量的新聞數(shù)據(jù),同時結(jié)合了大規(guī)模的私有創(chuàng)作領(lǐng)域數(shù)據(jù) (小說,短故事等),構(gòu)建出了超過 200B 的可以讓模型專注學(xué)習(xí)創(chuàng)作能力的預(yù)訓(xùn)練數(shù)據(jù)。

在指令微調(diào)階段,波形智能的數(shù)據(jù)生成團(tuán)隊參考并改進(jìn)了 Meta 提出的 LongForm 和 HumpBack 方案,構(gòu)建了一套可以基于一段高質(zhì)量內(nèi)容,自動生成各種寫作相關(guān)任務(wù)指令和對應(yīng)的高質(zhì)量輸出的 Instruction Backtranslation 流水線。團(tuán)隊總結(jié)并定義了 “寫內(nèi)容”,“寫大綱”,“擴(kuò)寫”,“潤色”,“精簡”,“風(fēng)格遷移 (仿寫)”,“審校”,“頭腦風(fēng)暴”,“起標(biāo)題”,和 “寫作相關(guān)對話” 十個類別的任務(wù)。對于一類任務(wù),如 “潤色”,標(biāo)注 Prompt 中首先解釋任務(wù)的定義和幾個輸入輸出樣例,之后給出一個從一段文本中自動挖掘潤色任務(wù)指令 / 輸入 / 輸出的例子和標(biāo)注的思考過程: “首先在文本中找到一段寫的很好的句子,假設(shè)這句話是經(jīng)過一次潤色而來的,之后猜測在潤色之前這句話會是什么樣子,最后分析潤色前后的變化,推理出潤色的指令會是什么樣子。” 之后標(biāo)注的 Prompt 中輸入需要標(biāo)注的例子并指示大模型按照例子中的標(biāo)注流程進(jìn)行輸出,最后 parse 出模型輸出中標(biāo)注的 “指令 / 輸入 / 輸出” 部分,組合成一條寫作指令數(shù)據(jù)。

相比 OpenAI 等公司的標(biāo)準(zhǔn)眾包標(biāo)注指令數(shù)據(jù)的流程,波形智能的標(biāo)注策略更高效 (眾包標(biāo)注者只需要挑選特定領(lǐng)域高質(zhì)量的內(nèi)容即可,后續(xù)標(biāo)注流程由 AI 完成),而眾包標(biāo)注和目前常用的 self-instruct 類的全自動標(biāo)注流程相比,波形智能的標(biāo)注流程能夠生成更高質(zhì)量的數(shù)據(jù) (因為輸出是手工挑選的高質(zhì)量內(nèi)容或其中的一部分)。基于這個策略,波形智能的大模型團(tuán)隊收集了涵蓋小說寫作,創(chuàng)意寫作,專業(yè)寫作,營銷文案寫作這四大領(lǐng)域中高質(zhì)量的內(nèi)容并進(jìn)行了自動化標(biāo)注,產(chǎn)出了 100 萬 + 高質(zhì)量的寫作領(lǐng)域指令微調(diào)數(shù)據(jù)集。

圖 1: Weaver 訓(xùn)練數(shù)據(jù)分布和來源

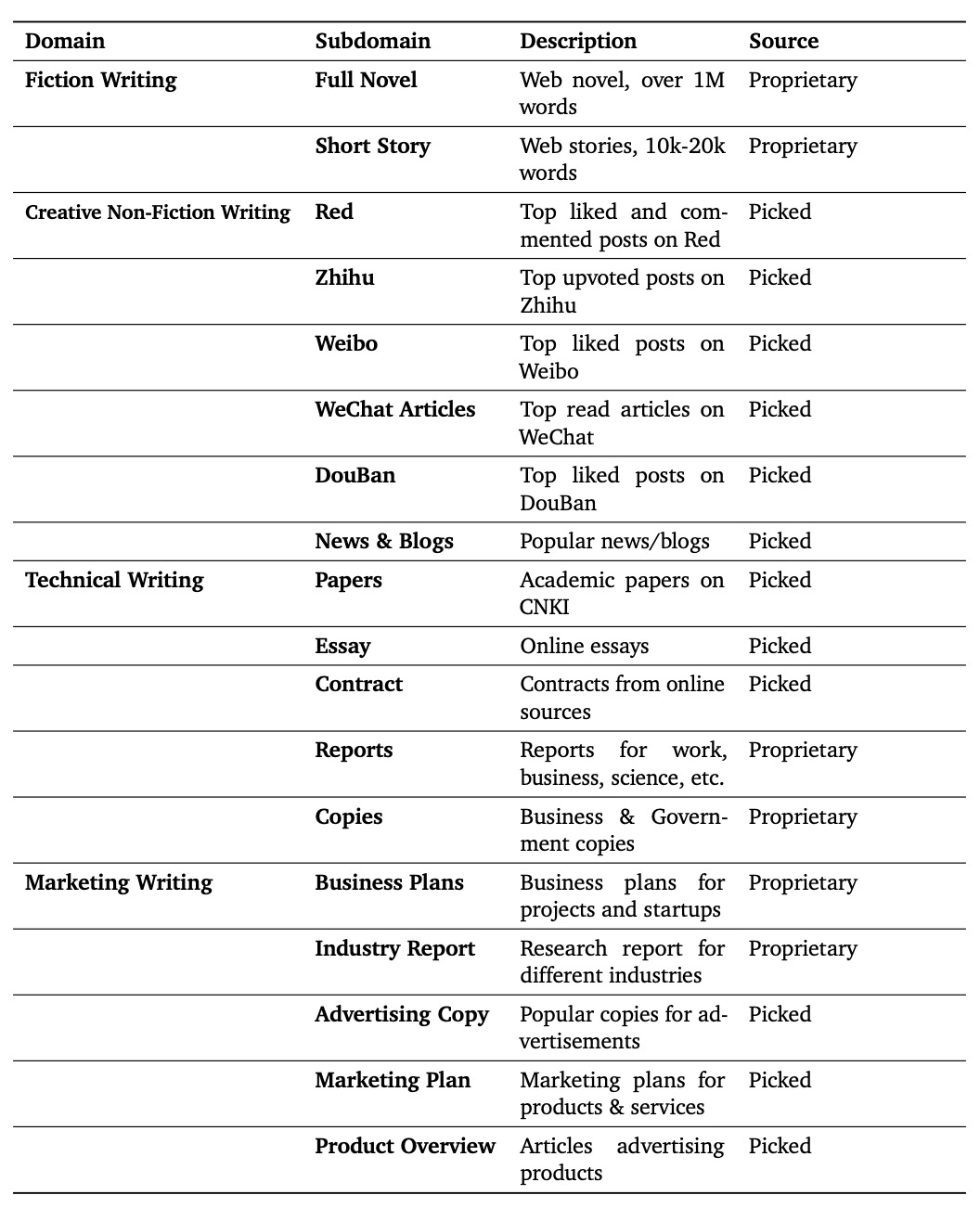

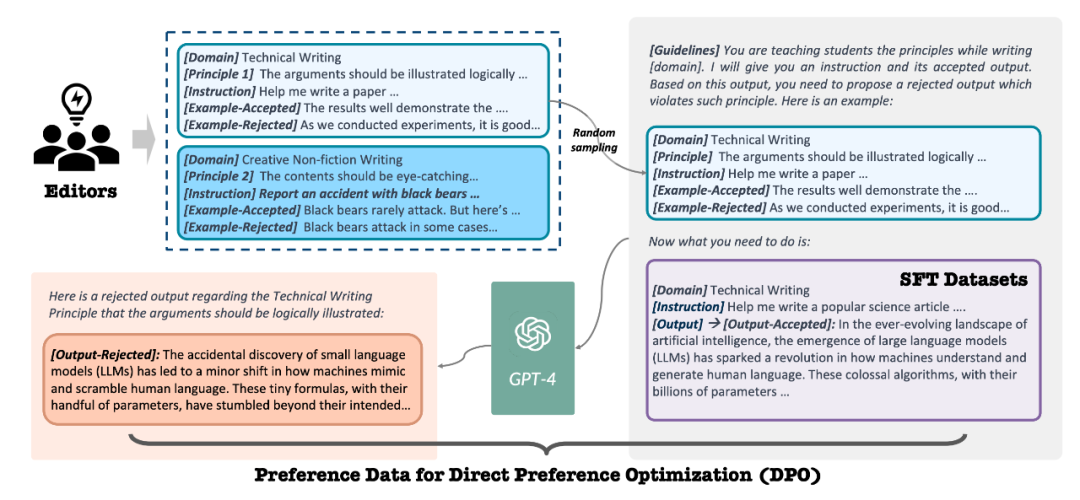

接下來,在對齊 (Alignment) 階段,波形智能的數(shù)據(jù)生成團(tuán)隊提出了 Constitutional DPO, 一套全新的,基于原則高效將模型和專業(yè)作家 / 創(chuàng)作者對齊的方案。和以往基于模型輸出 + 人類 / 大模型評估的對齊策略不同。Constitutional DPO 以人類創(chuàng)作者創(chuàng)作的高質(zhì)量的輸出作為正樣本,利用人類作家 / 編輯整理提煉出的各個領(lǐng)域?qū)懽鞯?“原則 (Principles)”,用這些原則去生成能夠教會模型更好地遵守這些原則的負(fù)樣本。具體來說,專業(yè)作家 / 編輯首先整理出四大領(lǐng)域十個任務(wù)中,好的內(nèi)容需要遵循的共 200 余條原則。對于每一個原則,編輯總結(jié)出原則的詳細(xì)解釋和一對符合 / 違背該原則的例子,并用幾句話解釋出符合 / 違背原則的原因。之后,對于每一個正樣本,負(fù)例生成的 prompt 中首先展示出領(lǐng)域 - 任務(wù)上的原則集合和原則對應(yīng)的例子和解釋,之后展示出正樣本,要求大模型分析出正樣本最符合哪幾條原則,并推理出如何修改能夠在作出較少改變的情況下讓正樣本轉(zhuǎn)而違背這個原則,從而變成一條質(zhì)量沒那么好的輸出。團(tuán)隊精選了各個領(lǐng)域高評分 / 高閱讀量 / 高點贊評論數(shù)的內(nèi)容作為正樣本,通過 Consitutional DPO 的流水線生成出了數(shù)萬條偏好數(shù)據(jù) (preference data),并利用這些數(shù)據(jù)對模型利用 DPO 進(jìn)行了對齊訓(xùn)練。

圖 2 - Constitutional DPO 方法示意圖

圖 3 - 專家標(biāo)注的寫作原則

除此之外,波形智能的數(shù)據(jù)生成團(tuán)隊還設(shè)計了一套支持 RAG-aware training 的數(shù)據(jù)生成方案,過濾 / 精選出了一系列輸出內(nèi)容明顯基于其他內(nèi)容的樣本,通過 10 余個常用的 RAG 模版,構(gòu)造出了 10 萬余條的 RAG 訓(xùn)練數(shù)據(jù),使得 Weaver 模型能夠原生支持 RAG,能夠結(jié)合參考文獻(xiàn)和范文進(jìn)行高質(zhì)量的創(chuàng)作 / 仿寫。除此之外,團(tuán)隊還設(shè)計了一套讓 Weaver 支持 Function Calling 的數(shù)據(jù)生成方案。最終 Weaver 的微調(diào)數(shù)據(jù)量總和達(dá)到了 100 萬 + 量級。

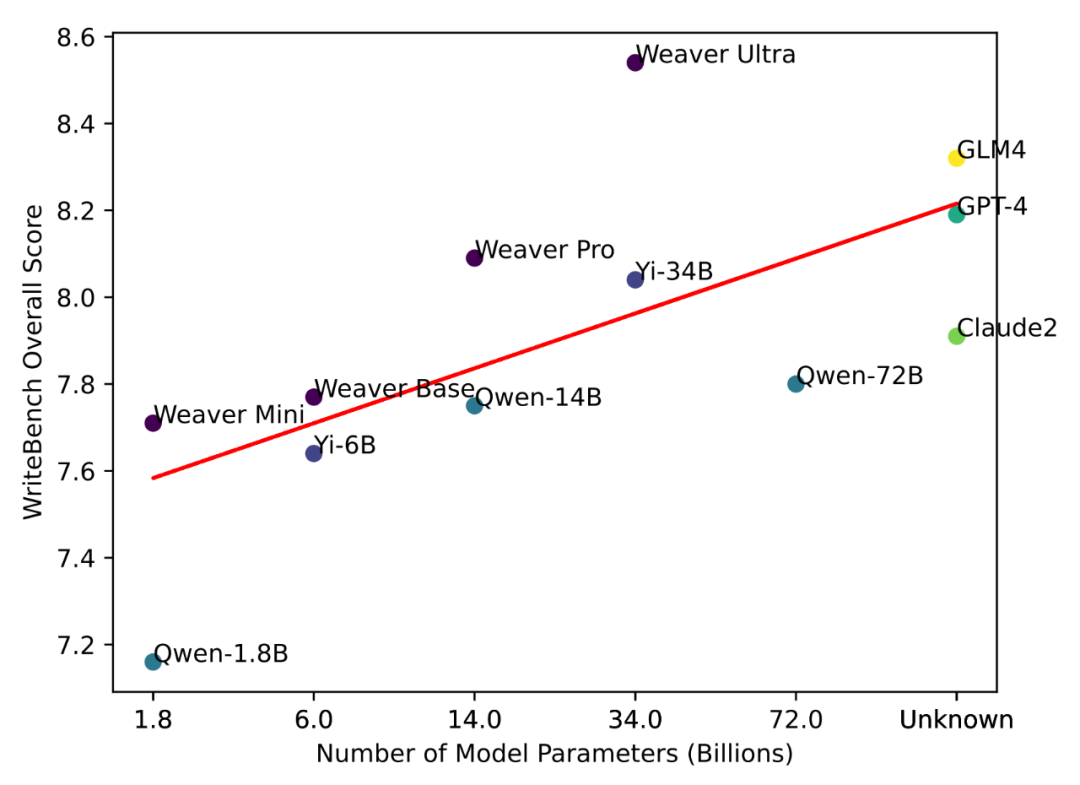

Weaver 模型家族一共包括四個不同大小的模型,名字叫做 Weaver-mini/base/pro/ultra, 分別包括 18 億,60 億,140 億和 340 億參數(shù)。為了評估 Weaver 模型和通用大模型的寫作能力,波形智能的模型評估團(tuán)隊構(gòu)建了一個新的用戶大模型專業(yè)寫作能力評估的 Benchmark。Benchmark 中精選了涵蓋四大寫作領(lǐng)域 30 余個子領(lǐng)域的十項寫作任務(wù)的有代表性指令,共包含 2000 + 條指令。團(tuán)隊收集了 Weaver 和 10 余個有代表性的開源 + 閉源模型在 Benchmark 上的輸出,并分別進(jìn)行了人工對比評估和基于 GPT4 的自動評估。

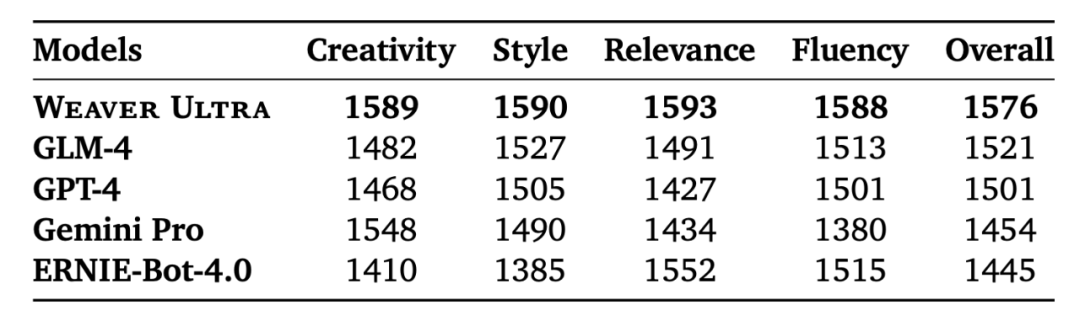

評估結(jié)果顯示,Weaver Ultra 在 Benchmark 中對生成內(nèi)容的新穎度和文風(fēng)的評估中對比包括 GPT-4 在內(nèi)的通用大模型均有顯著領(lǐng)先,在生成內(nèi)容的流暢性和切題程度上也和行業(yè)領(lǐng)先的 GPT-4 相當(dāng),領(lǐng)先其他開源 / 閉源模型。而其他較小的 Weaver 模型也都在各項指標(biāo)中相比大 2-3 倍的通用大模型有明顯優(yōu)勢。

圖 4: Weaver 在 WriteBench 的評測結(jié)果

除了標(biāo)準(zhǔn) Benchmark 的人工和自動評估以外,波形智能的模型評估團(tuán)隊還在包含人機交互的實際應(yīng)用場景中對 Weaver Ultra 和 GPT-4 進(jìn)行了用戶體驗測評。由 4 位人類寫手在同樣的 Chat Interface 分別使用 Weaver Ultra 和 GPT-4,以相同的主題分別創(chuàng)作一個短故事,一個小紅書文案,一個商業(yè)計劃書,和一個課程論文。測評結(jié)果顯示,人類寫手利用 Weaver 進(jìn)行創(chuàng)作的效率相比使用 GPT-4 提升了約 40%,而專業(yè)編輯對創(chuàng)作內(nèi)容的質(zhì)量評比中也以 9:3 的比分更傾向于采用 Weaver 創(chuàng)作的文案。分析顯示,Weaver 帶來的效率提升主要來自于生成內(nèi)容的文風(fēng)更得體,需要的后編輯更少,以及創(chuàng)作過程中 Weaver 交互更加直接,不會輸出無用的廢話和疑問。而來自專業(yè)編輯的反饋主要集中在基于 Weaver 創(chuàng)作的作品風(fēng)格往往更符合實用標(biāo)準(zhǔn),以及創(chuàng)作的內(nèi)容個新穎程度更高,不死板。

圖 5: Weaver 和其他大模型在人工評測中的 ELO Rating