?這次重生,AI要奪回網(wǎng)文界的一切

重生了,這輩子我重生成了 MidReal。一個(gè)可以幫別人寫「網(wǎng)文」的 AI 機(jī)器人。

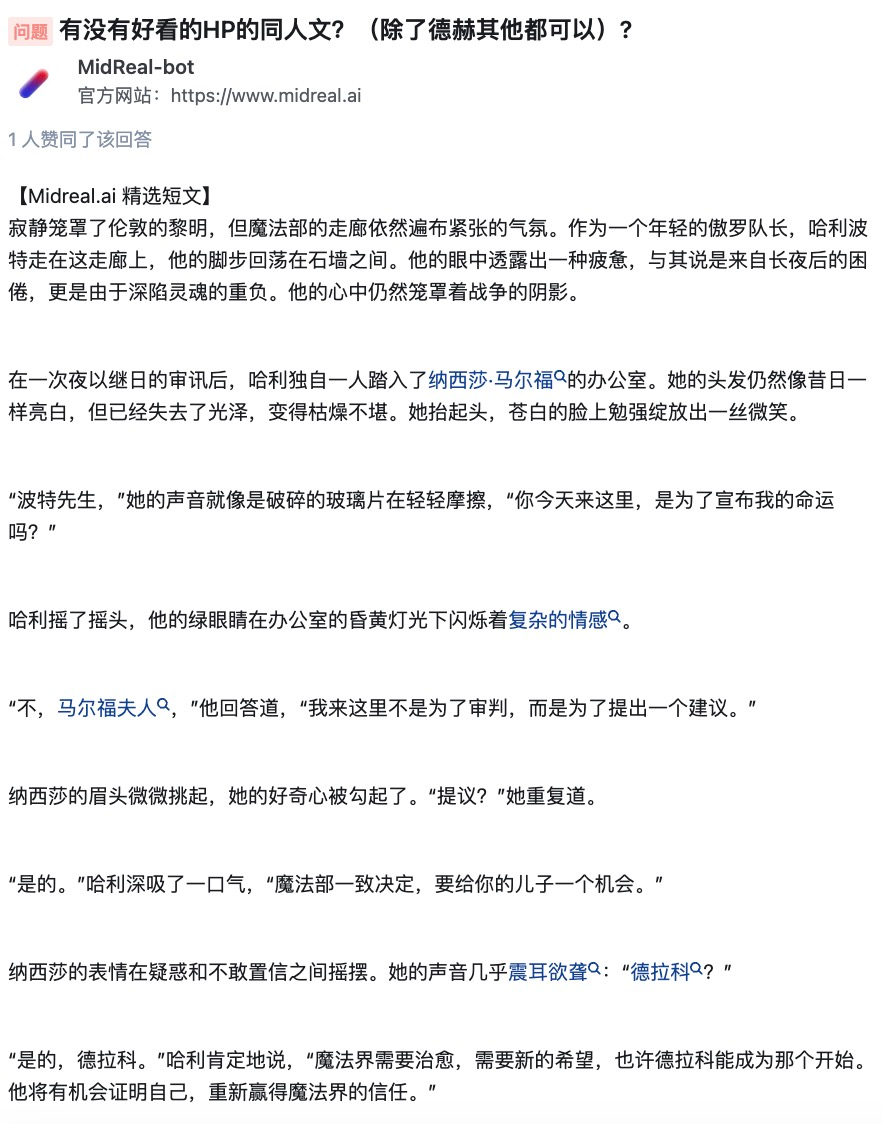

這段時(shí)間里,我看到很多選題,偶爾也會(huì)吐槽一下。竟然有人讓我寫寫 Harry Potter。拜托,難道我還能寫的比 J?K?Rowling 更好不成?不過,同人什么的,我還是可以發(fā)揮一下的。

經(jīng)典設(shè)定誰會(huì)不愛?我就勉為其難地幫助這些用戶實(shí)現(xiàn)想象吧。

實(shí)不相瞞,上輩子我該看的,不該看的,通通看了。就下面這些主題,都是我愛慘了的。

那些你看小說很喜歡卻沒人寫的設(shè)定,那些冷門甚至邪門的 cp,都能自產(chǎn)自嗑。

不是我自夸,只要你想要我寫,我還真能給你寫出個(gè)一二三來。結(jié)局不喜歡?喜歡的角色「中道崩殂」?作者寫到一半吃書了?包在我身上,給你寫到滿意。

甜文,虐文,腦洞文,每一種都狠狠擊中你的爽點(diǎn)。

聽完MidReal的自述,你對(duì)它了解了嗎?

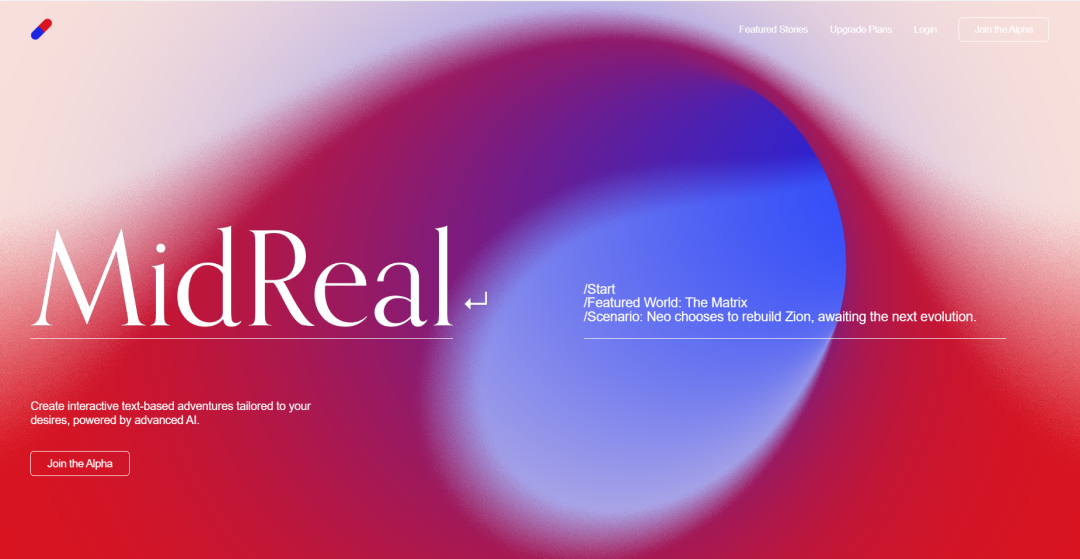

MidReal 可以根據(jù)用戶提供的情景描述,生成對(duì)應(yīng)的小說內(nèi)容。情節(jié)的邏輯與創(chuàng)造力都很優(yōu)秀。它還能在生成過程中生成插圖,更形象地描繪你所想象的內(nèi)容。互動(dòng)功能也是亮點(diǎn)之一,你可以選擇想要的故事情節(jié)進(jìn)行發(fā)展,讓整體更加貼合你的需求。

在對(duì)話框中輸入 /start,就可以開始講述你的故事了,還不快來試試?

MidReal 傳送門:https://www.midreal.ai/

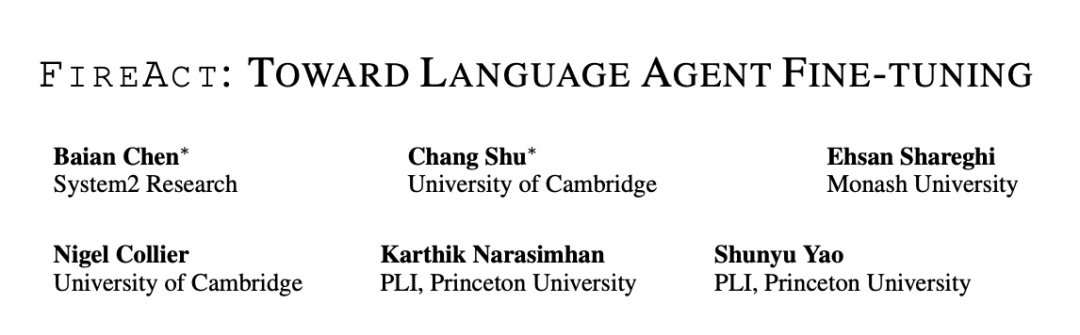

MidReal 背后的技術(shù)源于這篇論文《FireAct:Toward Language Agent Fine-tuning》。論文作者首次嘗試了用 AI 智能體來微調(diào)語言模型,發(fā)現(xiàn)了諸多優(yōu)勢,由此提出了一種新的智能體架構(gòu)。

MidReal 就是基于這種架構(gòu)的,網(wǎng)文才能寫得這么好。

論文鏈接:https://arxiv.org/pdf/2310.05915.pdf

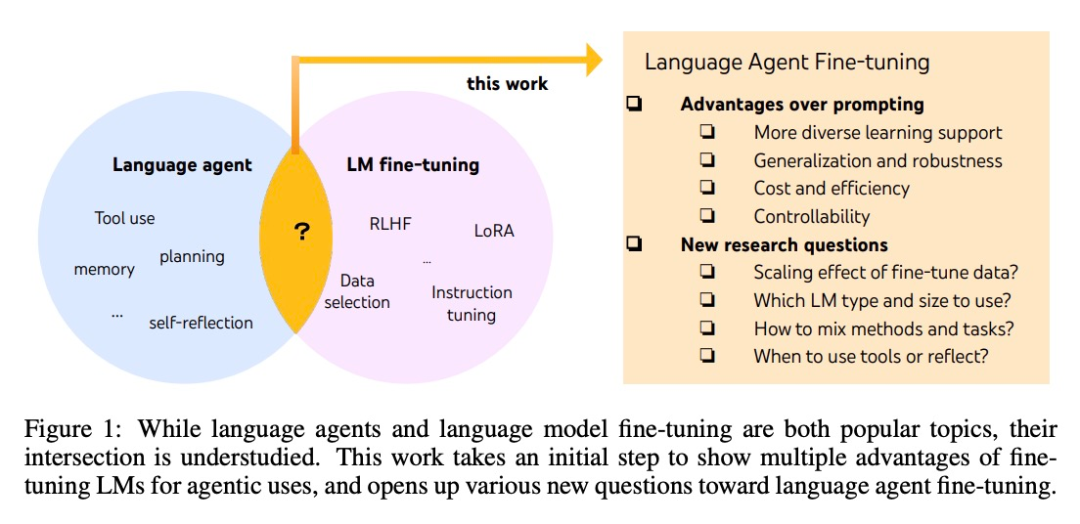

雖然智能體和微調(diào)大模型都是最熱門的 AI 話題,但它們之間具體有何聯(lián)系還不清楚。System2 Research、劍橋大學(xué)等的多位研究者對(duì)這片鮮有人涉足的「學(xué)術(shù)藍(lán)海」進(jìn)行了發(fā)掘。

AI 智能體的開發(fā)通常基于現(xiàn)成的語言模型,但由于語言模型不是作為智能體而開發(fā)的,因此,延伸出智能體后,大多數(shù)語言模型的性能和穩(wěn)健性較差。最聰明的智能體只能由 GPT-4 支持,它們也無法避免高成本和延遲,以及可控性低、重復(fù)性高等問題。

微調(diào)可以用來解決上面的這些問題。也是在這篇文章中,研究者們邁出了更加系統(tǒng)研究語言智能體的第一步。他們提出了 FireAct ,它能夠利用多個(gè)任務(wù)和提示方法生成的智能體「行動(dòng)軌跡」來微調(diào)語言模型,讓模型更好地適應(yīng)不同的任務(wù)和情況,提高其整體性能和適用性。

方法簡介

該研究主要基于一種流行的 AI 智能體方法:ReAct。一個(gè) ReAct 任務(wù)解決軌跡由多個(gè)「思考 - 行動(dòng) - 觀察」回合組成。具體來說,讓 AI 智能體完成一個(gè)任務(wù),語言模型在其中扮演的角色類似于「大腦」。它為 AI 智能體提供解決問題的「思考」和結(jié)構(gòu)化的動(dòng)作指示,并根據(jù)上下文與不同的工具交互,在這個(gè)過程中接收觀察到的反饋。

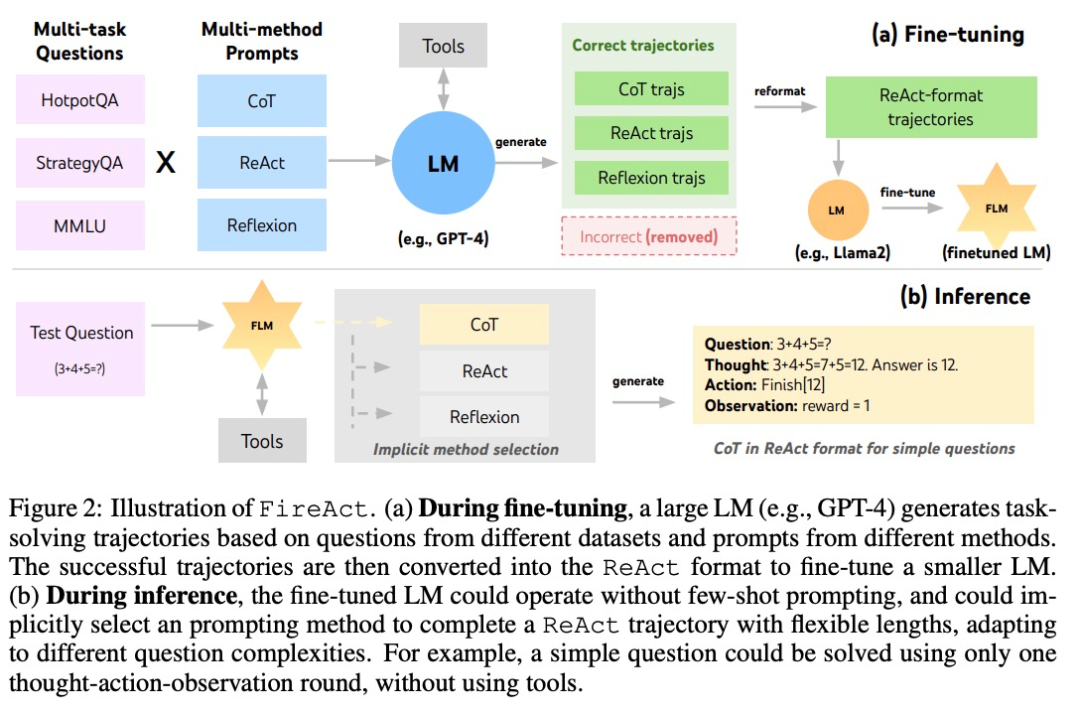

在 ReAct 的基礎(chǔ)上,作者提出了 FireAct,如圖 2 所示,F(xiàn)ireAct 運(yùn)用強(qiáng)大的語言模型的少樣本提示來生成多樣化的 ReAct 軌跡,用以微調(diào)較小規(guī)模的語言模型。與此前類似研究不同的是,F(xiàn)ireAct 能夠混合多個(gè)訓(xùn)練任務(wù)和提示方法,大大促進(jìn)了數(shù)據(jù)的多樣性。

作者還參考了兩種與 ReAct 兼容的方法:

- 思維鏈(CoT)是生成連接問題和答案的中間推理的有效方法。每個(gè) CoT 軌跡可以簡化為一個(gè)單輪 ReAct 軌跡,其中「思維」代表中間推理,「行動(dòng)」代表返回答案。在不需要與應(yīng)用工具交互的情況下,CoT 尤其有用。

- Reflexion 主要遵循 ReAct 軌跡,但加入了額外的反饋和自我反思。該研究中,僅在 ReAct 的第 6 輪和第 10 輪提示進(jìn)行反思。這樣一來,長的 ReAct 軌跡就能為解決當(dāng)前任務(wù)提供策略「支點(diǎn)」,能夠幫助模型解決或調(diào)整策略。例如搜索「電影名」得不到答案時(shí),應(yīng)該把搜索的關(guān)鍵詞換成「導(dǎo)演」。

在推理過程中,F(xiàn)ireAct 框架下的 AI 智能體顯著減少了提示詞的樣本數(shù)量需求,推理也更加高效和簡便。它能夠根據(jù)任務(wù)的復(fù)雜度隱式地選擇合適的方法。由于 FireAct 具備更廣泛和多樣化的學(xué)習(xí)支持,與傳統(tǒng)的提示詞微調(diào)方法相比,它展現(xiàn)出更強(qiáng)的泛化能力和穩(wěn)健性。

實(shí)驗(yàn)及結(jié)果

任務(wù)數(shù)據(jù)集:HotpotQA,Bamboogle,StrategyQA,MMLU。

- HotpotQA 是一個(gè) QA 數(shù)據(jù)集,對(duì)多步驟推理和知識(shí)檢索有著更具挑戰(zhàn)性的考驗(yàn)。研究者使用 2,000 個(gè)隨機(jī)訓(xùn)練問題進(jìn)行微調(diào)數(shù)據(jù)整理,并使用 500 個(gè)隨機(jī) dev 問題進(jìn)行評(píng)估。

- Bamboogle 是一個(gè)由 125 個(gè)多跳問題組成的測試集,其格式與 HotpotQA 相似,但經(jīng)過精心設(shè)計(jì),以避免直接用谷歌搜索解決問題。

- StrategyQA 是一個(gè)需要隱式推理步驟的是 / 否 QA 數(shù)據(jù)集。

- MMLU 涵蓋初等數(shù)學(xué)、歷史和計(jì)算機(jī)科學(xué)等不同領(lǐng)域的 57 個(gè)多選 QA 任務(wù)。

工具:研究者使用 SerpAPI1 構(gòu)建了一個(gè)谷歌搜索工具,該工具會(huì)從「答案框」、「答案片段」、「高亮單詞」或「第一個(gè)結(jié)果片段」中返回第一個(gè)存在的條目,從而確保回復(fù)簡短且相關(guān)。他們發(fā)現(xiàn),這樣一個(gè)簡單的工具足以滿足不同任務(wù)的基本質(zhì)量保證需求,并提高了微調(diào)模型的易用性和通用性。

研究者研究了三個(gè) LM 系列:OpenAI GPT、Llama-2 以及 CodeLlama。

微調(diào)方法:研究者在大多數(shù)微調(diào)實(shí)驗(yàn)中使用了低秩自適應(yīng)(Low-Rank Adaptation,LoRA),但在某些比較中也使用了全模型微調(diào)。考慮到語言代理微調(diào)的各種基本因素,他們將實(shí)驗(yàn)分為三個(gè)部分,復(fù)雜程度依次增加:

- 在單一任務(wù)中使用單一提示方法進(jìn)行微調(diào);

- 在單一任務(wù)中使用多種方法進(jìn)行微調(diào);

- 在多個(gè)任務(wù)中使用多種方法進(jìn)行微調(diào)。

1.在單一任務(wù)中使用單一提示方法進(jìn)行微調(diào)

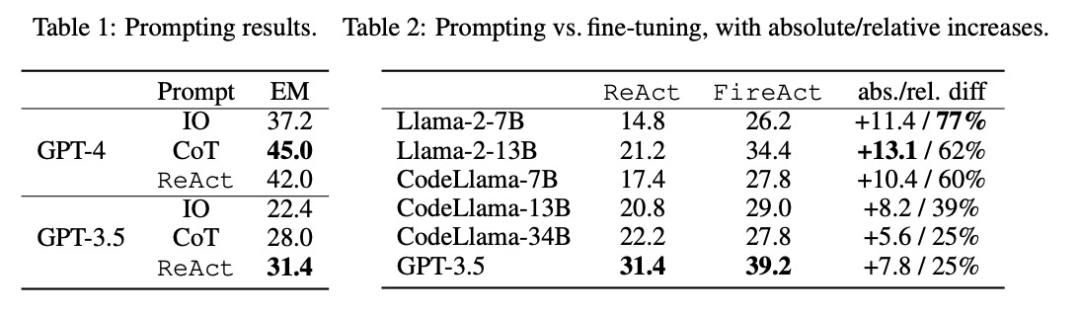

研究者探討了使用來自單一任務(wù)(HotpotQA)和單一提示方法(ReAct)的數(shù)據(jù)進(jìn)行微調(diào)的問題。通過這種簡單而可控的設(shè)置,他們證實(shí)了微調(diào)相對(duì)于提示的各種優(yōu)勢(性能、效率、穩(wěn)健性、泛化),并研究了不同 LM、數(shù)據(jù)大小和微調(diào)方法的效果。

如表 2 所示,微調(diào)能持續(xù)、顯著地改善 HotpotQA EM 的提示效果。雖然較弱的 LM 從微調(diào)中獲益更多(例如,Llama-2-7B 提高了 77%),但即使是像 GPT-3.5 這樣強(qiáng)大的 LM 也能通過微調(diào)將性能提高 25%,這清楚地表明了從更多樣本中學(xué)習(xí)的好處。與表 1 中的強(qiáng)提示基線相比,研究者發(fā)現(xiàn)經(jīng)過微調(diào)的 Llama-2-13B 優(yōu)于所有 GPT-3.5 提示方法。這表明對(duì)小型開源 LM 進(jìn)行微調(diào)的效果可能優(yōu)于對(duì)更強(qiáng)大的商用 LM 進(jìn)行提示的效果。

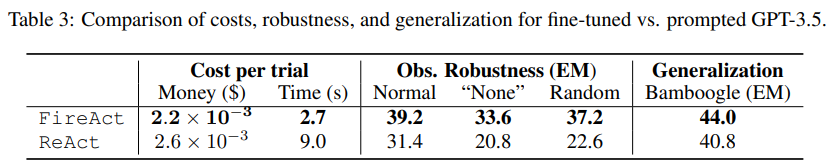

在智能體推理過程中,微調(diào)的成本更低,速度更快。由于微調(diào) LM 不需要少量的上下文示例,因此其推理效率更高。例如,表 3 的第一部分比較了微調(diào)推理與 shiyongtishideGPT-3.5 推理的成本,發(fā)現(xiàn)推理時(shí)間減少了 70%,總體推理成本也有所降低。

研究者考慮到一個(gè)簡化且無害的設(shè)置,即搜索 API 有 0.5 的概率返回「None」或隨機(jī)搜索響應(yīng),并詢問語言智能體是否仍能穩(wěn)健地回答問題。如表 3 第二部分所示,「None」的設(shè)置更具挑戰(zhàn)性,它使 ReAct EM 降低了 33.8%,而 FireAct EM 僅降低了 14.2%。這些初步結(jié)果表明,更多樣化的學(xué)習(xí)支持對(duì)于提高穩(wěn)健性非常重要。

表 3 的第三部分顯示了經(jīng)過微調(diào)的和使用提示的 GPT-3.5 在 Bamboogle 上的 EM 結(jié)果。雖然經(jīng)過 HotpotQA 微調(diào)或使用提示的 GPT-3.5 都能合理地泛化到 Bamboogle,但前者(44.0 EM)仍然優(yōu)于后者(40.8 EM),這表明微調(diào)具有泛化優(yōu)勢。

2.在單一任務(wù)中使用多種方法進(jìn)行微調(diào)

作者將 CoT 和 Reflexion 與 ReAct 集成,測試了對(duì)于在單一任務(wù)(HotpotQA)中使用多種方法進(jìn)行微調(diào)的性能。對(duì)比 FireAct 和既有方法的在各數(shù)據(jù)集中的得分,他們有以下發(fā)現(xiàn):

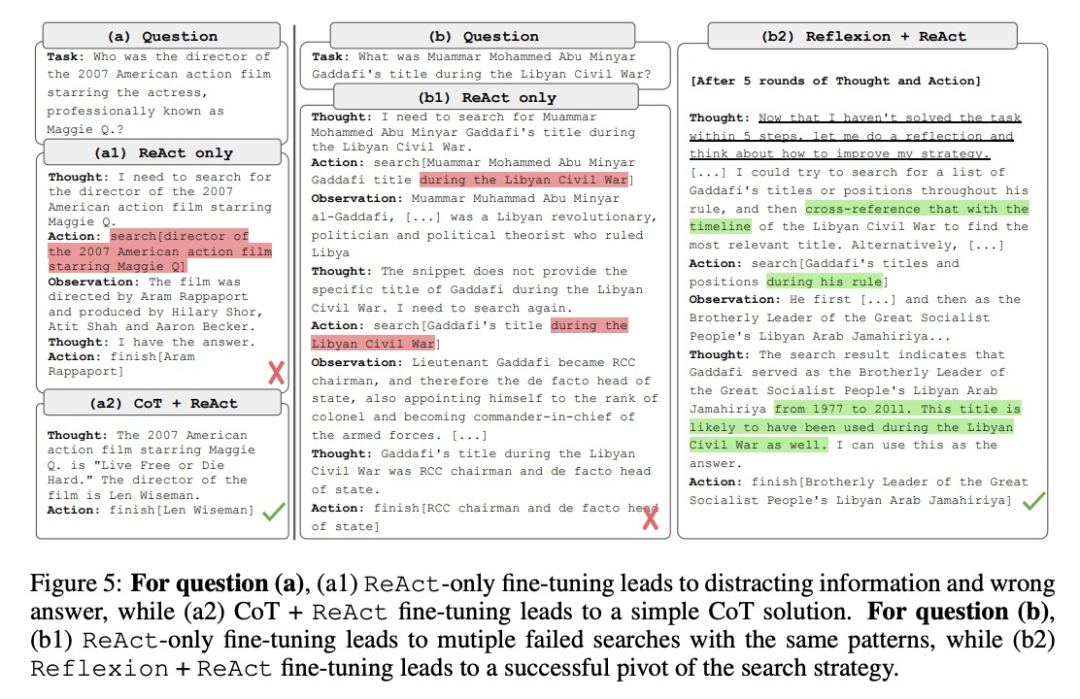

首先,使用多種方法微調(diào)提高了智能體的靈活性。如圖 5 所示,在定量結(jié)果之外,研究者向我們展示了兩個(gè)示例問題,以說明多方法 FireAct 微調(diào)的好處。第一個(gè)問題比較簡單,但僅使用 ReAct 微調(diào)的智能體搜索了一個(gè)過于復(fù)雜的查詢,導(dǎo)致注意力分散,提供了錯(cuò)誤的答案。相比之下,同時(shí)使用 CoT 和 ReAct 微調(diào)的智能體自信地選擇依靠自己的內(nèi)部知識(shí),在一輪內(nèi)完成了任務(wù)。第二個(gè)問題難度更高,僅使用 ReAct 微調(diào)的智能體未搜索出有用的信息。相比之下,同時(shí)使用 Reflexion 和 ReAct 微調(diào)的智能體在搜索碰壁時(shí)進(jìn)行了反思,并改變了搜索策略,從而得到了正確答案。靈活地為不同問題選擇解決方案,是 FireAct 相較于提示等微調(diào)方法的關(guān)鍵優(yōu)勢。

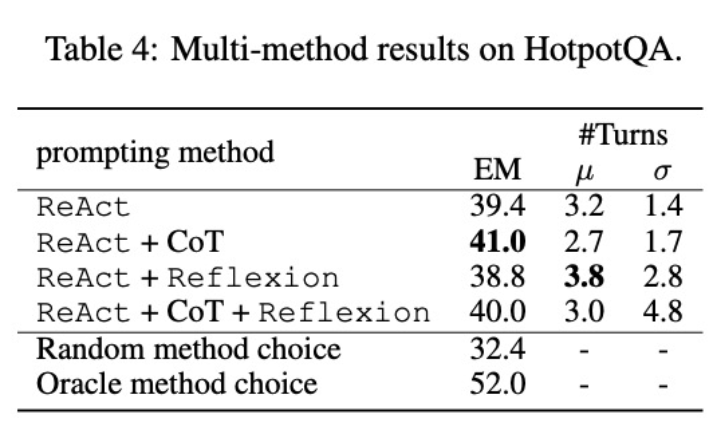

其次,使用多方法微調(diào)不同的語言模型將產(chǎn)生不同的影響。如表 4 所示,綜合使用多種智能體進(jìn)行微調(diào)并不總是能帶來提升,最優(yōu)的方法組合取決于基礎(chǔ)語言模型。例如,對(duì)于 GPT-3.5 和 Llama-2 模型,ReAct+CoT 優(yōu)于 ReAct,但對(duì)于 CodeLlama 模型則不同。對(duì)于 CodeLlama7/13B,ReAct+CoT+Reflexion 的效果最差,但 CodeLlama-34B 卻能取得最好的效果。這些結(jié)果表明,還需進(jìn)一步研究基礎(chǔ)語言模型和微調(diào)數(shù)據(jù)之間的相互作用。

為了進(jìn)一步了解組合了多種方法的智能體是否能夠根據(jù)任務(wù)選擇恰當(dāng)?shù)慕鉀Q方案,研究者計(jì)算了在推理過程中隨機(jī)選擇方法的得分。該得分(32.4)遠(yuǎn)低于所有組合了多種方法的智能體,這表明選擇解決方案并非易事。然而,每個(gè)實(shí)例的最佳方案的得分也僅為 52.0,這表明在提示方法選擇方面仍有提升空間。

3.在多個(gè)任務(wù)中使用多種方法進(jìn)行微調(diào)

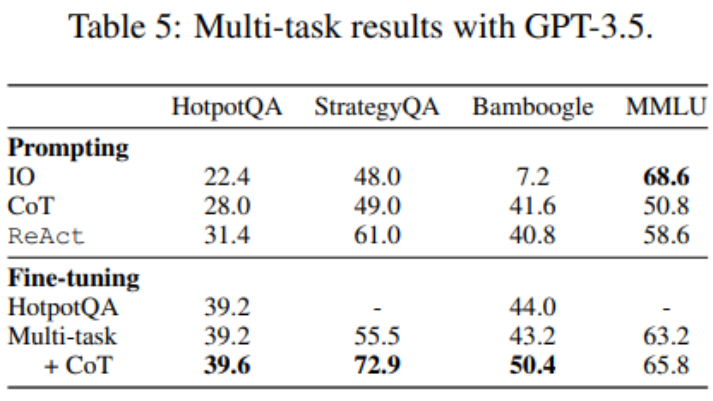

到這里,微調(diào)只使用了 HotpotQA 數(shù)據(jù),但有關(guān) LM 微調(diào)的實(shí)證研究表明,混合使用不同的任務(wù)會(huì)有益處。研究者使用來自三個(gè)數(shù)據(jù)集的混合訓(xùn)練數(shù)據(jù)對(duì) GPT-3.5 進(jìn)行微調(diào):HotpotQA(500 個(gè) ReAct 樣本,277 個(gè) CoT 樣本)、StrategyQA(388 個(gè) ReAct 樣本,380 個(gè) CoT 樣本)和 MMLU(456 個(gè) ReAct 樣本,469 個(gè) CoT 樣本)。

如表 5 所示,加入 StrategyQA/MMLU 數(shù)據(jù)后,HotpotQA/Bamboogle 的性能幾乎保持不變。一方面,StrategyQA/MMLU 軌跡包含的問題和工具使用策略大不相同,這使得遷移變得困難。另一方面,盡管分布發(fā)生了變化,但加入 StrategyQA/MMLU 并沒有影響 HotpotQA/Bamboogle 的性能,這表明微調(diào)一個(gè)多任務(wù)代理以取代多個(gè)單任務(wù)代理是未來可以發(fā)展的方向。當(dāng)研究者從多任務(wù)、單一方法微調(diào)切換到多任務(wù)、多方法微調(diào)時(shí),他們發(fā)現(xiàn)所有任務(wù)的性能都有所提高,這再次明確了多方法代理微調(diào)的價(jià)值。

想要了解更多技術(shù)細(xì)節(jié),請(qǐng)閱讀原文。

參考鏈接:

- https://twitter.com/Tisoga/status/1739813471246786823

- https://www.zhihu.com/people/eyew3g