李飛飛吳恩達等2024年AI十大預測!GPU短缺,AI智能體一年內大爆發

2023,可以說是人工智能的春天。

在過去的一年里,ChatGPT成為家喻戶曉的名字,

這一年中,AI和AI公司的各種變革,讓我們震驚,也成為我們茶余飯后的瓜果。

這一年中,生成式AI取得了重大進展,使得人工智能初創公司吸引了大量資金。

人工智能領域的大佬們開始討論AGI的可能性,政策制定者開始認真對待人工智能監管。

但在人工智能和科技行業們的領袖眼中,AI浪潮可能才剛剛起步。之后的每一年,可能都是浪潮最洶涌澎湃的一年。

比爾蓋茨,李飛飛,吳恩達等人,都在最近對未來AI的發展趨勢談了自己的看法。

他們都不約而同地談到了期待更大的多模態模型、更令人興奮的新功能,以及圍繞我們如何使用和監管這項技術的更多對話。

比爾蓋茨:2個預測,1個經驗,6個問題

比爾蓋茨在自己的官方博客上發表了一篇萬字長文,將他眼里的2023年描繪成了一個新時代的全新開端。

文章地址:https://www.gatesnotes.com/The-Year-Ahead-2024?WT.mc_id=20231218210000_TYA-2024_MED-ST_&WT.tsrc=MEDST#ALChapter2

這篇博客依然還是從他在蓋茨基金會的工作為切入,談到了世界范圍內已經出現或者將會出現哪些影響深遠的變化。

針對AI技術的發展,他說:

如果我必須做出預測,那在像美國這樣的高收入國家,我猜我們距離普通大眾廣泛地使用人工智能還有18到24個月的時間。

在非洲國家,我預計在三年左右的時間里會看到類似的使用水平。這其中仍然存在差距,但它比我們在其他創新中看到的滯后時間要短得多。

比爾蓋茨認為,AI作為目前地球范圍內影響最深遠地創新技術,將會在3年內徹底席卷全球。

蓋茨在博文中表示,2023年是他第一次在工作中出于「嚴肅的原因」使用人工智能。

與前幾年相比,世界對AI能夠自己完成哪些工作以及「充當哪些工作的輔助工具」有了更好的認識。

但對于大部分人來說,要讓AI在工作場景中充分發揮作用還有一定距離。

基于他自己獲得的數據和觀察體驗,他表示行業應該吸取的一個最重要的教訓是:產品必須適合使用它的人。

他舉了一個簡單的例子,巴基斯坦人通常互相發送語音留言,而不是發送短信或電子郵件。因此,創建一個依賴語音命令而不是輸入長查詢的應用程序是有意義的。

從他本人最關心的角度,蓋茨提出了5個問題,希望工智能可以在相關領域發揮巨大作用:

-人工智能可以對抗抗生素耐藥性嗎?

-人工智能能否為每個學生創造出個性化的導師?

-人工智能可以幫助治療高危妊娠嗎?

-人工智能可以幫助人們評估感染艾滋的風險嗎?

-人工智能能否讓每個醫務工作者更輕松地獲取醫療信息?

如果我們現在做出明智的投資,人工智能可以讓世界變得更加公平。它可以減少甚至消除富裕世界獲得創新與貧窮世界獲得創新之間的滯后時間。

吳恩達:LLM可以理解世界,不會監管AI不如不管

吳恩達最近在接受金融時報采訪時表示,人工智能末日論非常荒謬,AI監管將會阻礙AI技術本身的發展。

在他看來,目前人工智能的相關監管措施對防止某些問題產生幾乎沒有任何效果。這樣無效的監管除了會阻礙技術的進步,不會有任何正面的受益。

所以在他看來,與其做低質量的監管,不如不要監管。

他舉了最近美國政府讓大科技公司自我承諾對AI生成內容自行添加「水印」,來應對虛假信息等問題為例。

在他看來,自從白宮自愿承諾以來,一些公司反而不再對文本內容加水印。因此,他認為自愿承諾方法作為一種監管方法是失敗的。

而另一方面,如果監管機構將這種無效的監管移植到諸如「監管開源AI」等問題上,很有可能會完全扼殺開源的發展并且造成大型科技公司的壟斷。

那如果AI獲得的監管水平是目前的樣子,那確實沒有監管的意義。

吳恩達重申,實際上,他希望政府能夠親自動手并制定良好的監管規定,而不是現在看到的糟糕的監管提案。所以他并不主張放手不管。但在糟糕的監管和沒有監管之間,他寧愿沒有監管。

吳恩達還在訪談中談到,現在LLM已經了具備了世界模型的雛形。

「我所看到的科學證據來看,人工智能模型確實可以構建世界模型。因此,如果人工智能有一個世界模型,那么我傾向于相信它確實理解世界。但這是我自己對理解一詞含義的理解。

如果你有一個世界模型,那么你就會了解世界如何運作,并可以預測它在不同場景下如何演變。有科學證據表明,LLM在接受大量數據訓練后,確實可以建立一個世界模型。」

李飛飛攜手斯坦福HAI發布七大預測

知識工作者的挑戰

斯坦福數字經濟實驗室主任Erik Brynjolfsson等人預計,人工智能公司將能夠提供真正影響生產力的產品。

而知識工作者將受到前所未有的影響,比如創意工作者、律師、金融學教授的工作將發生很大變化。

在過去的30年中,這些人基本沒有受到計算機革命的影響。

我們應該接受人工智能帶來的改變,讓我們的工作變得更好,讓我們能做以前做不到的新事情。

虛假信息擴散

斯坦福大學工程學院教授James Landay等人認為,我們將看到新的大型多模態模型,特別是在視頻生成方面。

所以我們還必須對嚴重的深度偽造更加警惕,

作為消費者需要意識到這一點,作為民眾也需要意識到這一點。

我們將看到OpenAI等公司和更多的初創公司,發布下一個更大的模型。

我們仍然會看到很多關于「這是AGI嗎?什么是AGI?」的討論,——但我們不必擔心人工智能會接管世界,這都是炒作。

我們真正應該擔心的是現在正在發生的危害——虛假信息和深度偽造。

GPU短缺

斯坦福大學教授Russ Altman等人對于全球性的GPU短缺表示擔心。

大公司們都在嘗試將AI功能引入內部,而英偉達等GPU制造商已經滿負荷運轉。

GPU,或者說AI的算力,代表了新的時代的競爭力,對于公司甚至是國家來說都是如此。

對于GPU的爭奪也會給創新者帶來巨大的壓力,他們需要提出更便宜、更易于制造和使用的硬件解決方案。

斯坦福大學和許多其他科研機構,都在研究當前GPU的低功耗替代方案。

想要達到大規模商用,這項工作還有很長的路要走,但為了實現人工智能技術的民主化,我們必須繼續前進。

更有用的代理

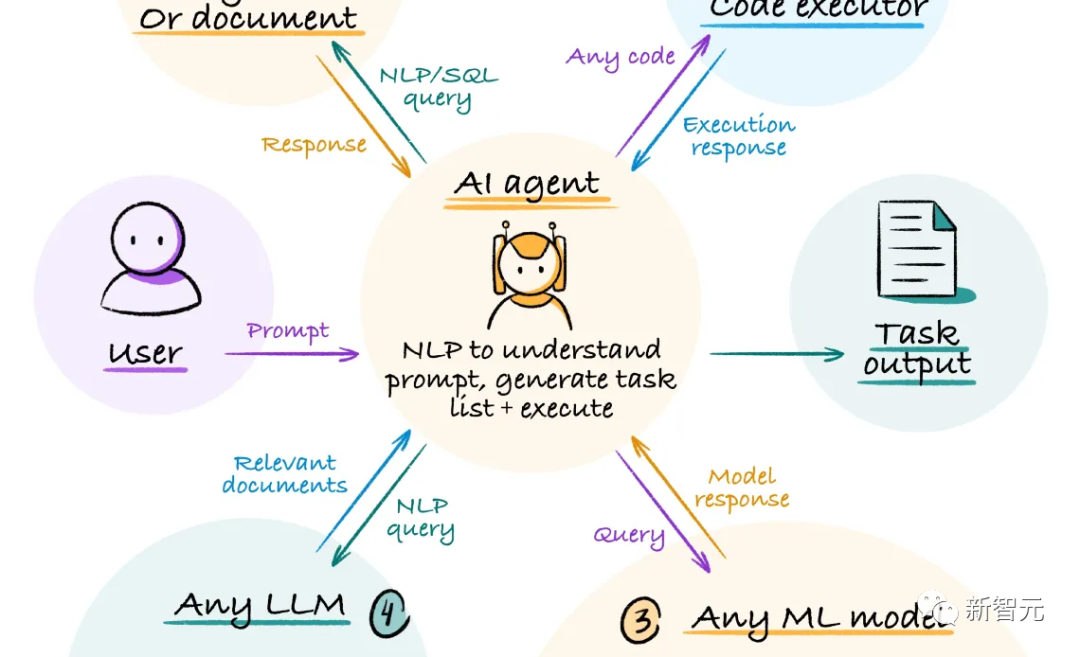

斯坦福大學杰出教育研究員Peter Norvig認為,未來的一年代理(Agent)將會興起,AI將能夠連接到其他服務,并解決實際的問題。

2023年是能夠與AI聊天的一年,人們與AI的關系只是通過輸入和輸出來進行的互動。

而到了2024年,我們將看到代理為人類完成工作的能力,——進行預訂、計劃旅行等等。

此外,我們將朝著多媒體邁進。

到目前為止,人們已經非常關注語言模型,然后是圖像模型。之后,我們也將有足夠的處理能力來發展視頻模型,——這將非常有趣。

我們現在正在訓練的東西都是非常有目的性的,——人們在頁面和段落中寫下自己認為有趣和重要的事情;人們利用相機紀錄某些正在發生的事。

但是對于視頻來說,有些攝像機可以24小時運行,它們捕捉發生的事情,沒有任何過濾,沒有任何目的性的篩選。

——人工智能模型以前沒有這種數據,這將使模型對一切有更好的理解。

對監管的希望

斯坦福大學HAI聯合主任李飛飛表示,2024年,人工智能政策將值得關注。

我們的政策應該保障學生和研究人員能夠獲得AI資源、數據和工具,以此來提供更多人工智能開發的機會。

圖片

圖片

另外,我們需要安全、可靠和可信賴地開發和使用人工智能,

所以,政策除了要致力于培養充滿活力的人工智能生態系統,還應致力于利用和管理人工智能技術。

我們需要相關的立法和行政命令,相關的公共部門也應該獲得更多投資。

提出問題,給出對策

斯坦福大學HAI高級研究員Ge Wang希望,我們將有足夠的資金來研究,生活、社區、教育和社會能夠從人工智能中得到什么。

越來越多的這種生成式人工智能技術將嵌入到我們的工作、娛樂和交流中。

我們需要給自己留出時間和空間,來思考什么是允許的,以及我們應該在哪些方面做出限制。

早在今年2月,學術期刊出版商Springer Publishing就發表了一份聲明,表示可以在起草文章時使用大型語言模型,但不允許在任何出版物上作為合著者。他們引用的理由是問責制,這一點非常重要。

——認真地把一些東西擺在那里,闡述理由是什么,并表示這就是現在的理解方式,將來可能會在政策中加入更多改進。

機構和組織必須有這樣的視角,并努力在2024年落實在紙上。

公司將面臨復雜的法規

斯坦福大學 HAI 隱私和數據政策研究員Jennifer King表示,除了今年歐盟的《人工智能法案》,到2024年年中,加利福尼亞州和科羅拉多州將通過法規,解決消費者隱私背景下的自動決策問題。

雖然這些法規僅限于,對個人個人信息進行訓練或收集的人工智能系統,但兩者都為消費者提供了選擇,即是否允許某些系統使用AI以及個人信息。

公司將不得不開始思考,當客戶行使他們的權利時(特別是集體行使權利時),將意味著什么。

比如一家使用人工智能來協助招聘流程的大公司,如果數百名應聘者都拒絕使用AI,那要怎么辦?必須人工審查這些簡歷嗎?這又有什么不同?人類能夠做的更好嗎?——我們才剛剛開始解決這些問題。