一文總結特征增強&個性化在CTR預估中的經典方法和效果對比

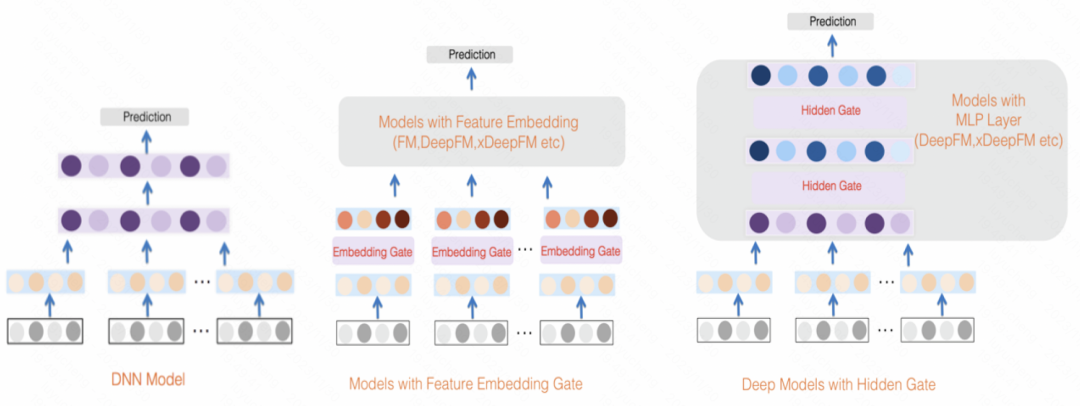

在CTR預估中,主流都采用特征embedding+MLP的方式,其中特征非常關鍵。然而對于相同的特征,在不同的樣本中,表征是相同的,這種方式輸入到下游模型,會限制模型的表達能力。

為了解決這個問題,CTR預估領域提出了一系列相關工作,被稱為特征增強模塊。特征增強模塊根據不同的樣本,對embedding層的輸出結果進行一次矯正,以適應不同樣本的特征表示,提升模型的表達能力。

最近,復旦大學和微軟亞研院聯合發布了一篇特征增強工作的總結,對比了不同特征增強模塊實現方法的效果。下面給大家介紹一下幾種特征增強模塊的實現方法,以及本文進行的相關對比實驗。

論文標題:A Comprehensive Summarization and Evaluation of Feature Refinement Modules for CTR Prediction

論文標題:A Comprehensive Summarization and Evaluation of Feature Refinement Modules for CTR Prediction

下載地址:https://arxiv.org/pdf/2311.04625v1.pdf

1、特征增強建模思路

特征增強模塊,旨在提升CTR預估模型中Embedding層的表達能力,實現相同特征在不同樣本下的表征差異化。特征增強模塊可以用下面這個統一公式表達,輸入原始的Embedding,經過一個函數后,生成這個樣本個性化的Embedding。

圖片

圖片

這類方法的大致思路為,在得到初始的每個特征的embedding后,使用樣本本身的表征,對特征embedding做一個變換,得到當前樣本的個性化embedding。下面給大家介紹一些經典的特征增強模塊建模方法。

2、特征增強經典方法

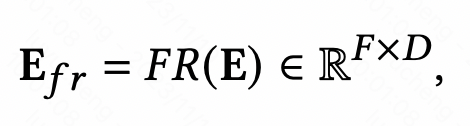

An Input-aware Factorization Machine for Sparse Prediction(IJCAI 2019)這篇文章在embedding層之后增加了一個reweight層,將樣本初始embedding輸入到一個MLP中得到一個表征樣本的向量,使用softmax進行歸一化。Softmax后的每個元素對應一個特征,代表這個特征的重要程度,使用這個softmax結果和每個對應特征的初始embedding相乘,實現樣本粒度的特征embedding加權。

圖片

圖片

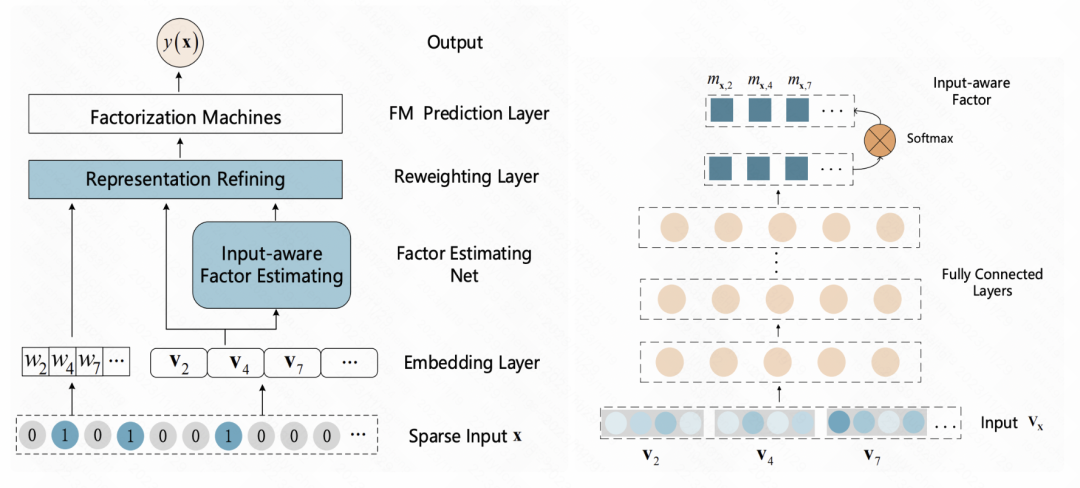

FiBiNET: Combining Feature Importance and Bilinear feature Interaction for Click-Through Rate Prediction(RecSys 2019)也是類似的思路,為每個樣本學習一個特征的個性化權重。整個過程分為squeeze、extraction、reweight三個步驟。在squeeze中,將每個特征embedding通過pooling得到一個其對應的統計標量。在extraction中,將這些標量輸入到MLP中,得到每個特征的權重。最后,使用這個權重和每個特征embedding向量相乘,得到加權后的embedding結果,相當于在樣本粒度做一個特征重要性篩選。

圖片

圖片

A Dual Input-aware Factorization Machine for CTR Prediction(IJCAI 2020)和上一篇文章類似,也是利用self-attention對特征進行一層增強。整體分為vector-wise和bit-wise兩個模塊。Vector-wise將每個特征的embedding當成序列中的一個元素,輸入到Transformer中得到融合后的特征表示;bit-wise部分使用多層MLP對原始特征進行映射。兩部分的輸入結果相加后,得到每個特征元素的權重,乘到對應的原始特征的每一位上,得到增強后的特征。

圖片

圖片

GateNet: Gating-Enhanced Deep Network for Click-Through Rate Prediction(2020)利用每個特征的初始embedding過一個MLP和sigmoid函數生成其獨立的特征權重分,同時也使用MLP對所有特征進行映射生成bit-wise的權重分,兩者融合對輸入特征進行加權。除了特征層外,在MLP的隱層,也利用類似的方法,對每個隱層的輸入進行加權。

圖片

圖片

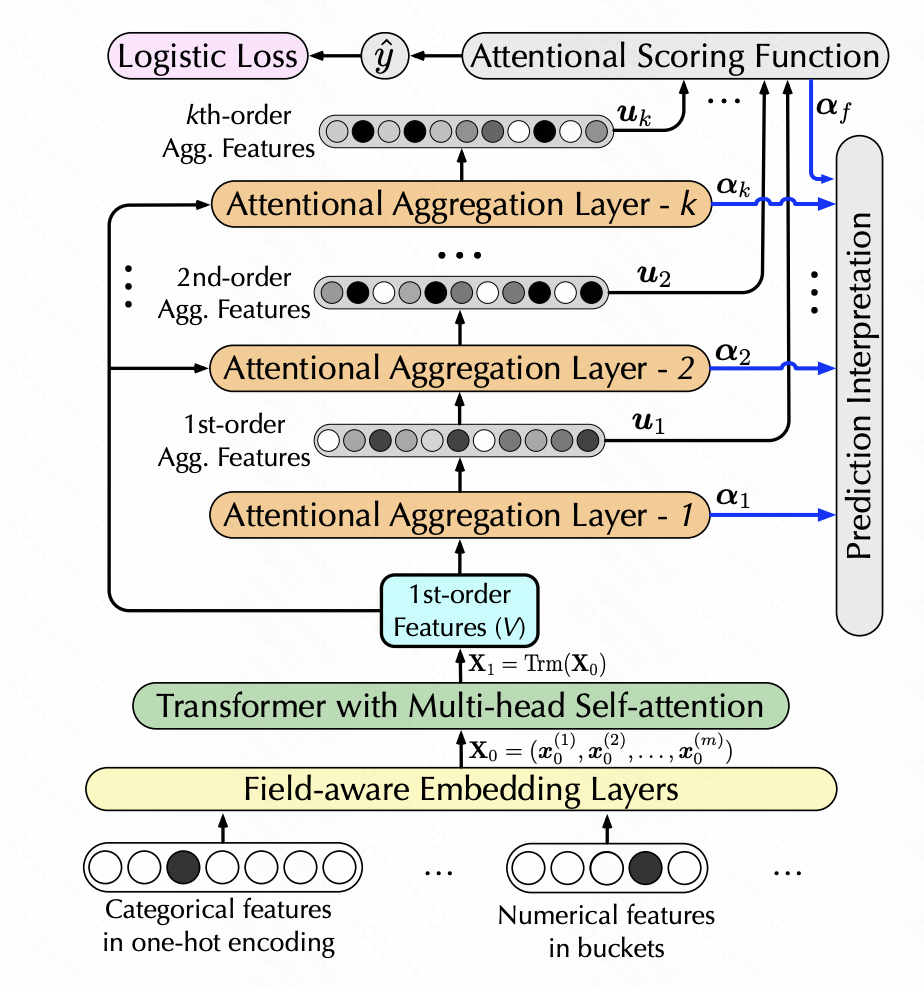

Interpretable Click-Through Rate Prediction through Hierarchical Attention(WSDM 2020)也是利用self-attention實現特征的轉換,但是增加了高階特征的生成。這里面使用層次self-attention,每一層的self-attention以上一層sefl-attention的輸出作為輸入,每一層增加了一階高階特征組合,實現層次多階特征提取。具體來說,每一層進行self-attention后,將生成的新特征矩陣經過softmax得到每個特征的權重,根據權重對原始特征加權新的特征,再和原始特征進行一次點積,實現增加一階的特征交叉。

圖片

圖片

ContextNet: A Click-Through Rate Prediction Framework Using Contextual information to Refine Feature Embedding(2021)也是類似的做法,使用一個MLP將所有特征映射成一個每個特征embedding尺寸的維度,對原始特征做一個縮放,文中針對每個特征使用了個性化的MLP參數。通過這種方式,利用樣本中的其他特征作為上下位增強每個特征。

圖片

圖片

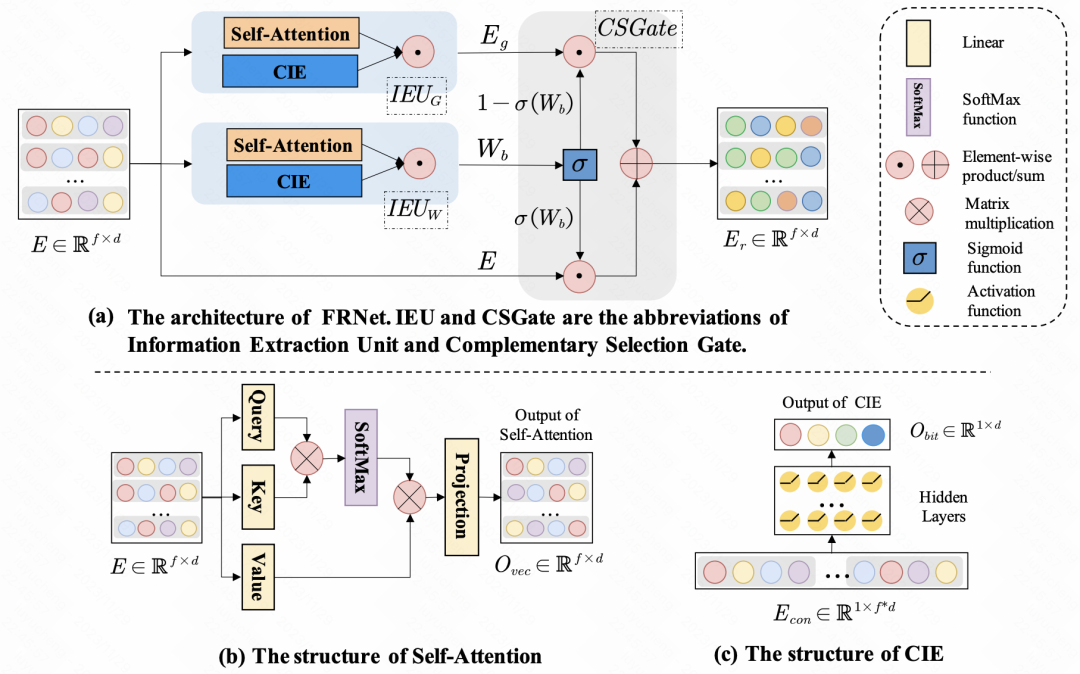

Enhancing CTR Prediction with Context-Aware Feature Representation Learning(SIGIR 2022)采用了self-attention進行特征增強,對于一組輸入特征,每個特征對于其他特征的影響程度是不同的,通過self-attention,對每個特征的embedding進行一次self-attention,實現樣本內特征間的信息交互。除了特征間的交互,文中也利用MLP進行bit級別的信息交互。上述生成的新embedding,會通過一個gate網絡,和原始的embedding進行融合,得到最終refine后的特征表示。

圖片

圖片

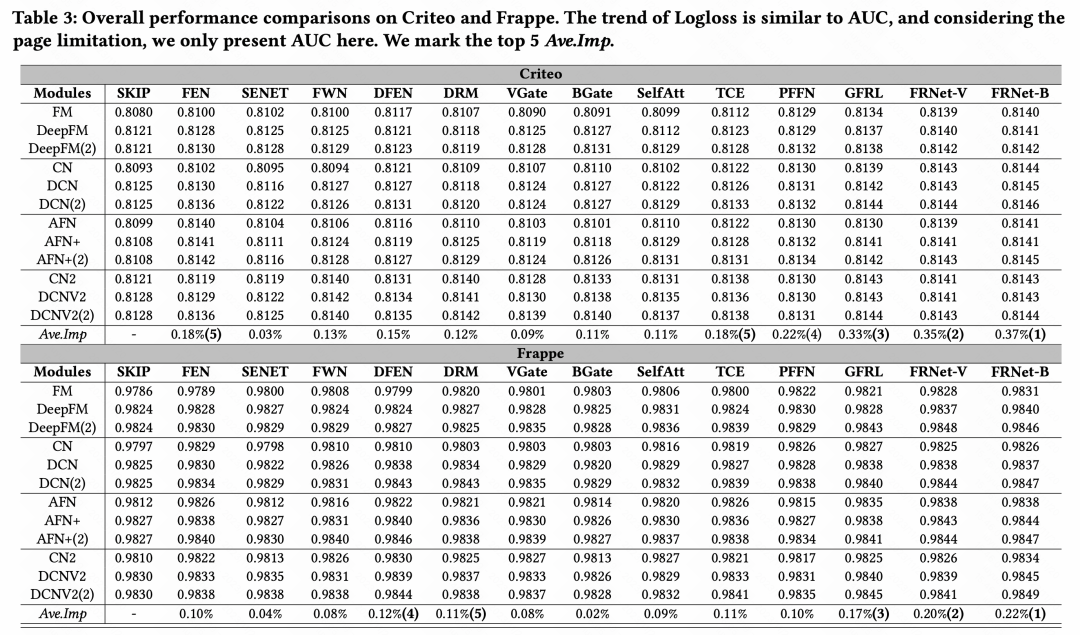

3、實驗效果

文中進行了各類特征增強方法的效果對比,整體結論為,在眾多特征增強模塊中,GFRL、FRNet-V、FRNetB 表現的最好,并且效果要優于其他的特征增強方法。