零一萬物Yi-34B-Chat微調模型上線,登陸多個權威榜單

最近,業內眾多大模型基準又迎來了一輪 “實力值” 更新。

繼 11 月初零一萬物發布 Yi-34B 基座模型后,Yi-34B-Chat 微調模型在 11 月 24 日開源上線 ,短時間登陸了全球多個英文、中文大模型權威榜單,再度獲得了全球開發者的關注。

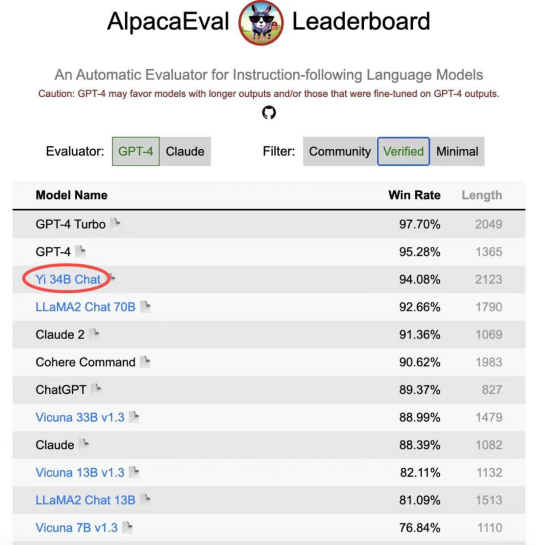

其中,在斯坦福大學提出的大語言模型評測基準 AlpacaEval 上,Yi-34B-Chat 以 94.08% 的勝率,超越 LLaMA2 Chat 70B、Claude 2、ChatGPT,在 Alpaca 經認證的模型類別中,成為業內僅次于 GPT-4 英語能力的大語言模型,并且是經由 Alpaca 官方認證為數不多的開源模型。

AlpacaEval Leaderboard 排行榜(發布于 2023 年 12 月 7 日)

與此同時,在加州大學伯克利分校主導的 LMSYS ORG 排行榜中,Yi-34B-Chat 也以 1102 的 Elo 評分晉升最新開源 SOTA 開源模型之列,性能表現追平 GPT-3.5。

在各類大模型評測中,伯克利 LMSYS ORG 較為特殊,其采用了較為接近用戶體感的 “聊天機器人競技場” 測評模式,讓眾多大語言模型在評測平臺隨機進行一對一 battle,通過眾籌真實用戶來進行線上實時盲測和匿名投票,11 月份經 2.5 萬真實用戶投票總數計算了 20 個大模型的總得分。Elo 評分越高,說明模型在真實用戶體驗上的表現越出色,可說是眾多大模型評測集中最能展現 “Moment of Truth 真實關鍵一刻” 的用戶導向體驗對決。

在開源模型中,Yi-34B-Chat 英語能力達到了較高水準,LMSYS ORG 在 12 月 8 日官宣 11 月份總排行時評價:“Yi-34B-Chat 和 Tulu-2-DPO-70B 在開源界的進擊表現已經追平 GPT-3.5。”

LMSYS ORG 榜單(發布于 2023 年 12 月 8 日)

中文能力方面,Yi-34B-Chat 微調模型同樣有了進步。

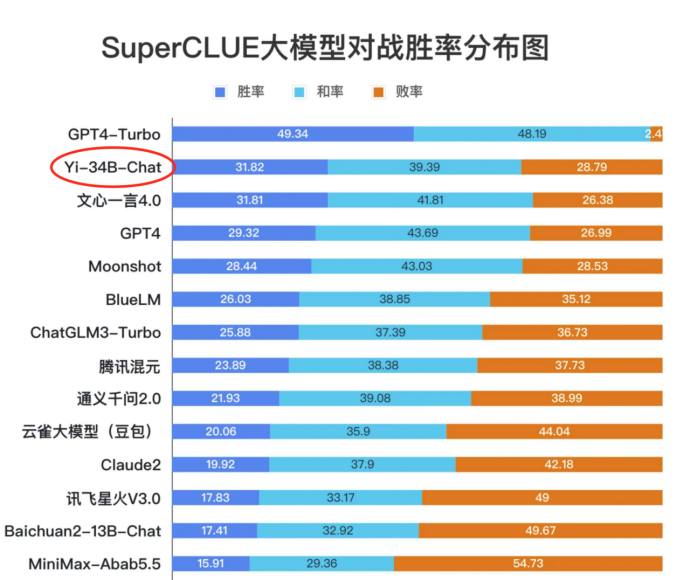

SuperCLUE 是一項針對中文能力的排行榜,從基礎能力、專業能力和中文特性能力三個不同的維度,評估模型的能力。根據 11 月底發布的《SuperCLUE 中文大模型基準評測報告 2023》,11 月下旬首度發布的 Yi-34B Chat,晉升到了和諸多國產優秀大模型齊平的 “卓越領導者” 象限,在多項基準評測中的 “SuperCLUE 大模型對戰勝率” 這項關鍵指標上,Yi-34B-Chat 取得 31.82% 的勝率,僅次于 GPT4-Turbo。

中文 SuperCLUE 排行榜(發布于 2023 年 11 月 28 日)

面向開發者,Yi-34B-Chat 微調模型提供了 4bit/8bit 量化版模型,其中 Yi-34B-Chat 4bit 量化版模型可以直接在 RTX 3090 等消費級顯卡上使用。

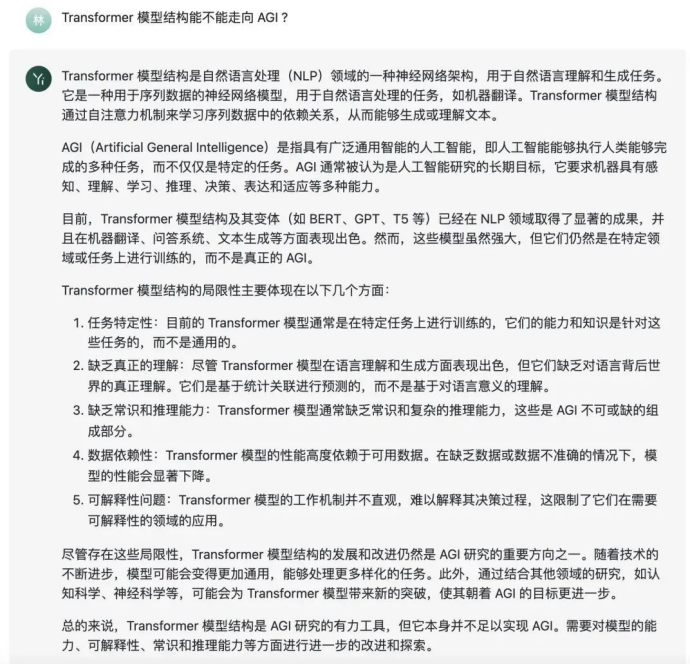

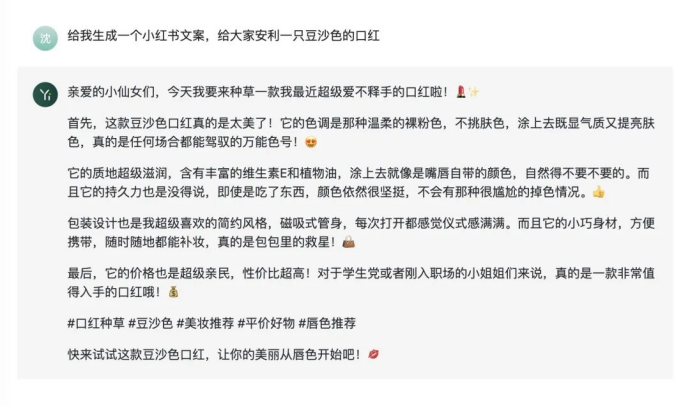

Yi-34B-Chat 在不同對話場景中表現如何?來看幾個更直觀的問題演示:

【知識與生成】:Transformer 模型結構能不能走向 AGI ?

【創意文案】:給我生成一個小紅書文案,給大家安利一只豆沙色的口紅。

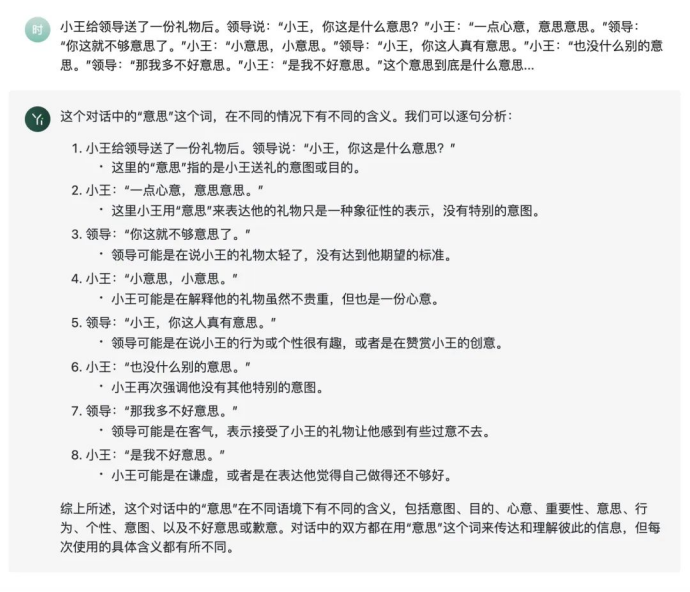

【中文理解】:小王給領導送了一份禮物后。領導說:“小王,你這是什么意思?” 小王:“一點心意,意思意思。” 領導:“你這就不夠意思了。” 小王:“小意思,小意思。” 領導:“小王,你這人真有意思。” 小王:“也沒什么別的意思。” 領導:“那我多不好意思。” 小王:“是我不好意思。” 這個意思到底是什么意思?

據零一萬物介紹,目前 Yi-34B-Chat 模型實現的能力,除了要歸功于 Yi 系列強基座的貢獻以外,還得益于其人工智能對齊(AI Alignment)等技術。研究團隊采用了一系列創新對齊策略,通過精心設計的指令微調流程,不僅強化了模型在理解和適應人類需求方面的能力,還使得模型與人類價值觀對齊,包括幫助性(Helpful),可靠性(Honest),無害性(Harmless)等。

在強基座設定下,該團隊采用了一種輕量化指令微調方案,該方案涵蓋了單項能力提升和多項能力融合兩個階段。

其中,單項能力包括通用指令跟隨、創意內容生成、數學、推理、編程、泛 COT、對話交互等。通過大量的消融實驗,針對模型單能力構建和多能力融合總結了獨家認知經驗。

在數據的量和質方面,一方面,研究團隊在強基座模型上,實現僅需要少量數據(幾條到幾百條),就能激發模型特定單項能力;另一方面,數據質量比數量重要,少量高質量數據比大量低質量數據更好。通過關注超出模型能力的 “低質量” 數據,減少了模型 “幻覺”。

在指令多樣性與難度方面,研究團隊通過在各能力項下構建任務體系,實現了訓練數據中的指令均衡分布,大幅提升了模型泛化性。通過復合指令構造和指令難度進化,不僅提升了模型效果,也顯著降低了對數據量的需求。

在風格一致性方面,研究團隊發現訓練數據的風格會影響模型收斂速度和能力上限的逼近程度,因此統一了回復風格,比如重點設計了 CoT 的回復風格,實現在輕量 SFT 情況下,避免了風格不一致加劇模型的 “記憶” 現象。

在多能力融合階段,研究團隊采用網格搜索的方法來決定數據配比和超參數的設置,通過基準測試和自建評測集的結果來指導搜索過程,成功實現模型的多能力融合。

為促進大語言模型的生態發展,零一萬物宣布,邀請全球開發者共同測試使用 Yi-34B-Chat 模型能力,一起搭建 Yi 開源模型的應用生態體系。

Yi 模型開源滿月,創新生態逐漸豐富

Yi 模型開源首月,在 Hugging Face 社區下載量已達 16.8 萬,魔搭社區下載量 1.2 萬,此外在 GitHub 獲得了超過 4900 個 Stars。

多家知名公司和機構推出了基于 Yi 模型基座的微調模型,如獵豹旗下的獵戶星空公司推出的 OrionStar-Yi-34B-Chat 模型,南方科技大學和粵港澳大灣區數字經濟研究院(簡稱 IDEA 研究院)認知計算與自然語言研究中心(簡稱 CCNL 中心)聯合發布的 SUS-Chat-34B 等。而 AMD 和 Hugging Face 合作的 GPU 加速大模型的實驗中,也選擇了 Yi-6B 作為范例項目。

知名技術寫作者蘇洋表示,在他觀察的近期 Hugging Face 榜單中,前三十名有一半多都是 Yi 和其他用戶微調的 Yi-34B 的變體模型,原本占據榜單頭部的 68B 和 70B 模型的數量目前只留有幾個,“從這點看 Yi 對于開源生態的幫助還是非常巨大的。”

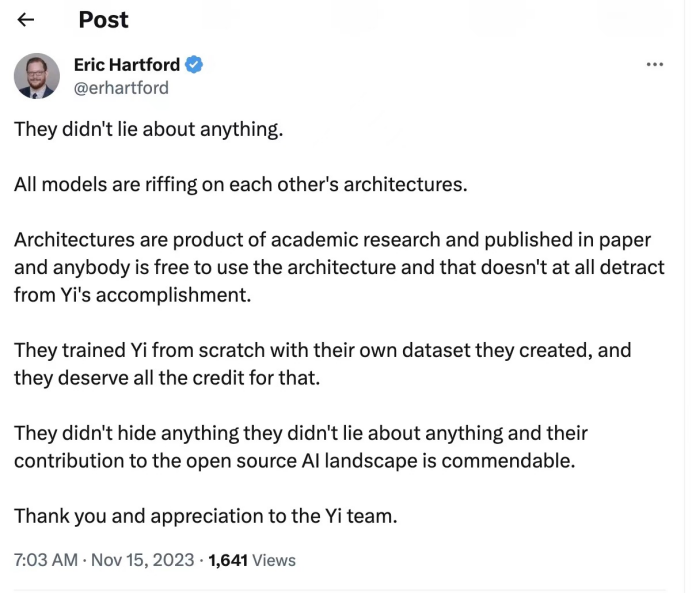

Eric Hartford:成為 Yi-34B 的忠實擁躉

Eric Hartford,Hugging Face 社區開發者

Yi-34B 開源發布后,開發者 Eric Hartford 發現了模型存在的一個小問題。

他在郵件中寫道,“感謝你們提供了一個優秀的模型。Yi 模型使用了與 LLaMA 模型完全相同的架構,只是將兩個張量改了名字。由于圍繞 LLaMA 架構有很多投資和工具,保持張量名稱的一致性是有價值的。”Eric 建議,在 Yi 被廣泛傳播前,及時恢復張量名稱。

零一萬物意識到命名問題的疏忽對開發者造成的不便,跟 Eric 和其他開發者提出說明,表達誠摯的歉意,并很快便在各開源平臺重新提交模型及代碼,完成了開源社區的版本更新。

然而 Eric 沒有料想到,他的建議在國內引發了輿論關于 Yi 模型 “抄襲” LLaMA 的質疑。

在大模型領域,技術架構、微調和數據同等重要。在沿用了開源社區普遍使用的 LLaMA 架構之上,零一萬物團隊用高質量的數據集、自研訓練科學和 AI Infra 打造了 Yi-34B 在內的系列模型。零一萬物表示,為了執行對比實驗的需要,對部分推理參數進行了重新命名。原始出發點是為了充分測試模型,而非刻意隱瞞來源。

面對新出現的輿論,Eric 自發為 Yi 進行了辯護。

他在 X(twitter)上寫道,“他們沒有在任何事情上撒謊。所有的模型都是在相互借鑒架構。架構是學術研究的產物,已經發表在論文中,任何人都可以自由使用,這絲毫不減損 Yi 團隊的成就。他們從零開始使用自己創建的數據集訓練 Yi,對開源領域的貢獻是值得贊揚的。”

他又表示,“使用 Llama 架構沒有任何問題。訓練才是關鍵。Yi 給了我們目前可獲得的最佳模型,沒有任何可抱怨的。”

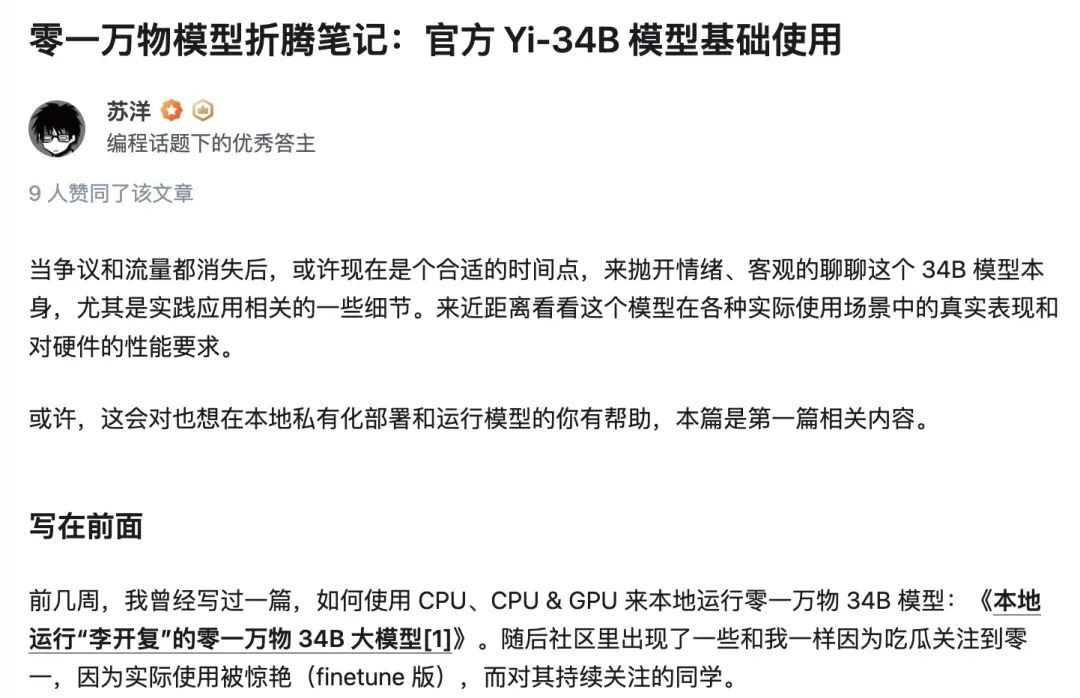

蘇洋:Yi-34B 在很多細分場景可替換 GPT-3.5

蘇洋,數字化創業者,開發者,技術寫作者

蘇洋表示,他已嘗試使用個人的機器學習主機,在純 CPU 環境、CPU & GPU 混合環境下對 Yi-34B 模型進行了測試,結果比想象中要好。

其中社區 finetune 后的版本,在對新聞、研究報告的摘要總結方面,對非結構化的信息中的實體識別和抽取上表現非常不錯。另外早期在官方還未推出 Chat 版本時,來自社區的 Chat 版本在對話的過程中,通史類的問答表現也非常不錯。當然,可能是由于零一在訓練過程中,出于安全考慮,過濾太多語料的緣故,一些本土化的內容仍然不夠深入。

目前,在 Hugging Face 的榜單上,前三十名有一半多都是 Yi 和其他用戶微調的 Yi-34B 的變體模型,原本占據榜單頭部的 68B 和 70B 模型的數量目前只留有幾個,從這點看 Yi 對于開源生態的幫助還是非常巨大的。

與 68 和 70B 模型相比,34B 普通用戶努努力還是能自己相對低成本跑起來的,同時成績相較差異不多。換言之,企業想部署使用,所需要的成本也可以得到非常大的節約。

目前國產大模型在開源榜單上已經是第一梯隊,但如果把競爭范圍追加到閉源模型、尤其是海外的模型,仍有很大的距離要去追趕。目前的普遍體驗是開源模型最多只有 GPT-3.5 + 的水平。

蘇洋認為,相信國產大模型是能夠很快追趕至第一梯隊的。

只要底子好,堅持使用開源的正確路線和方法,做好本地化適配和調優,就有希望。

Yi 模型地址:

- https://huggingface.co/01-ai/

- https://www.modelscope.cn/organization/01ai