「無(wú)需配對(duì)數(shù)據(jù)」就能學(xué)習(xí)!浙大等提出連接多模態(tài)對(duì)比表征C-MCR

多模態(tài)對(duì)比表示(multi-modal contrastive representation, MCR)的目標(biāo)是將不同模態(tài)的輸入編碼到一個(gè)語(yǔ)義對(duì)齊的共享空間中。

隨著視覺(jué)-語(yǔ)言領(lǐng)域中CLIP模型的巨大成功,更多模態(tài)上的對(duì)比表征開(kāi)始涌現(xiàn)出來(lái),并在諸多下游任務(wù)上得到了明顯的提升,但是這些方法嚴(yán)重依賴于大規(guī)模高質(zhì)量的配對(duì)數(shù)據(jù)。

為了解決這個(gè)問(wèn)題,來(lái)自浙江大學(xué)等機(jī)構(gòu)的研究人員提出了連接多模態(tài)對(duì)比表示(C-MCR),一種無(wú)需配對(duì)數(shù)據(jù)且訓(xùn)練極為高效的多模態(tài)對(duì)比表征學(xué)習(xí)方法。

論文地址:https://arxiv.org/abs/2305.14381

項(xiàng)目主頁(yè):https://c-mcr.github.io/C-MCR/

模型和代碼地址:https://github.com/MCR-PEFT/C-MCR

該方法在不使用任何配對(duì)數(shù)據(jù)的情況下,通過(guò)樞紐模態(tài)連接不同的預(yù)訓(xùn)練對(duì)比表征,我們學(xué)習(xí)到了強(qiáng)大的音頻-視覺(jué)和3D點(diǎn)云-文本表征,并在音頻-視覺(jué)檢索、聲源定位、3D物體分類等多個(gè)任務(wù)上取得了SOTA效果。

介紹

多模態(tài)對(duì)比表示(MCR)旨在將不同模態(tài)的數(shù)據(jù)映射到統(tǒng)一的語(yǔ)義空間中。隨著CLIP在視覺(jué)-語(yǔ)言領(lǐng)域的巨大成功,學(xué)習(xí)更多模態(tài)組合之間的對(duì)比表示已成為一個(gè)熱門(mén)研究課題,吸引了越來(lái)越多的關(guān)注。

然而,現(xiàn)有多模態(tài)對(duì)比表示的泛化能力主要受益于大量高質(zhì)量數(shù)據(jù)對(duì)。這嚴(yán)重限制了對(duì)比表征在缺乏大規(guī)模高質(zhì)量數(shù)據(jù)的模態(tài)上的發(fā)展。例如,音頻和視覺(jué)數(shù)據(jù)對(duì)之間的語(yǔ)義相關(guān)性往往是模糊的,3D點(diǎn)云和文本之間的配對(duì)數(shù)據(jù)稀缺且難以獲得。

不過(guò),我們觀察到,這些缺乏配對(duì)數(shù)據(jù)的模態(tài)組合,往往和同一個(gè)中間模態(tài)具有大量高質(zhì)量配對(duì)數(shù)據(jù)。比如,在音頻-視覺(jué)領(lǐng)域,盡管視聽(tīng)數(shù)據(jù)質(zhì)量不可靠,但音頻-文本和文本-視覺(jué)之間存在大量高質(zhì)量的配對(duì)數(shù)據(jù)。

同樣,雖然3D點(diǎn)云-文本配對(duì)數(shù)據(jù)的可用性有限,但3D點(diǎn)云-圖像和圖像-文本數(shù)據(jù)卻非常豐富。這些樞紐模態(tài)可以為模式之間建立進(jìn)一步關(guān)聯(lián)的紐帶。

考慮到具有大量配對(duì)數(shù)據(jù)的模態(tài)間往往已經(jīng)擁有預(yù)訓(xùn)練的對(duì)比表示,本文直接嘗試通過(guò)樞紐模態(tài)來(lái)將不同模態(tài)間的對(duì)比表征連接起來(lái),從而為缺乏配對(duì)數(shù)據(jù)的模態(tài)組合構(gòu)建新的對(duì)比表征空間。

連接多模態(tài)對(duì)比表示(C-MCR)可以通過(guò)重疊模態(tài)為現(xiàn)有大量多模態(tài)對(duì)比表示構(gòu)建連接,從而學(xué)習(xí)更廣泛的模態(tài)之間的對(duì)齊關(guān)系。其中,學(xué)習(xí)過(guò)程不需要任何配對(duì)數(shù)據(jù)且極為高效。

C-MCR具有兩個(gè)關(guān)鍵優(yōu)勢(shì):

1. 靈活性:

C-MCR能夠?yàn)槿狈χ苯优鋵?duì)配對(duì)的模態(tài)學(xué)習(xí)對(duì)比表征。從另一個(gè)視角來(lái)看,C-MCR將每個(gè)已有的多模態(tài)對(duì)比表示空間視為一個(gè)節(jié)點(diǎn),并將不同表示空間的重疊模態(tài)視為樞紐模態(tài)。

通過(guò)連接各個(gè)孤立的多模態(tài)對(duì)比表征,我們可以靈活地?cái)U(kuò)展了獲得的多模態(tài)對(duì)齊知識(shí),并挖掘出更廣泛模態(tài)間的對(duì)比表示。

2、高效性:

由于C-MCR僅需為已有的表征空間構(gòu)建連接,因此只用學(xué)習(xí)兩個(gè)簡(jiǎn)單的映射器,其訓(xùn)練參數(shù)和訓(xùn)練成本都是極低的。

實(shí)驗(yàn)利用文本作為樞紐連接視覺(jué)-文本(CLIP)和文本-音頻(CLAP)對(duì)比表示空間,獲得了高質(zhì)量的視覺(jué)-音頻表示。

類似地,通過(guò)使用圖像連接文本-視覺(jué)(CLIP)和視覺(jué)-3D點(diǎn)云(ULIP)對(duì)比表示空間,也可以獲得一組3D點(diǎn)云-文本對(duì)比表示。

方法

圖1 (a) 介紹了C-MCR的算法流程(以使用文本連接CLIP和CLAP為例)。

文本(重疊模態(tài))的數(shù)據(jù)分別被CLIP和CLAP的文本編碼器編碼為文本特征:、。

同時(shí),大量非配對(duì)單模態(tài)數(shù)據(jù)也分別被編碼到CLIP和CLAP空間,構(gòu)成image memory 和 audio memory

1. 特征語(yǔ)義增強(qiáng)

我們首先提出從語(yǔ)義一致性和語(yǔ)義完整性兩個(gè)角度來(lái)增強(qiáng)表征中的語(yǔ)義信息,從而實(shí)現(xiàn)更魯棒更全面的空間連接。

模態(tài)間語(yǔ)義一致性

CLIP和CLAP分別已經(jīng)學(xué)到了可靠的對(duì)齊的圖像-文本和文本-音頻表征。

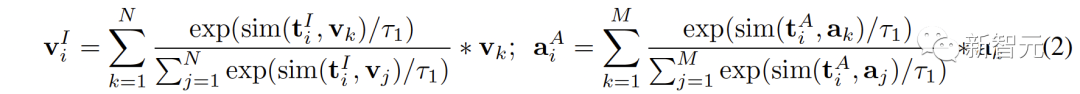

我們利用CLIP和CLAP中這種內(nèi)在的模態(tài)對(duì)齊性來(lái)生成與第i個(gè)文本語(yǔ)義一致的圖像和音頻特征,從而更好地量化對(duì)比表征空間中的modality gap以及更直接的挖掘非重疊模態(tài)間的關(guān)聯(lián)性:

模態(tài)內(nèi)語(yǔ)義完整性

不同表征空間對(duì)于數(shù)據(jù)的語(yǔ)義表達(dá)會(huì)有不同的傾向性,因此不同空間下的同一個(gè)文本也會(huì)不可避免的存在語(yǔ)義偏差和丟失。在連接表示空間時(shí),這種語(yǔ)義偏差會(huì)被累積并且放大。

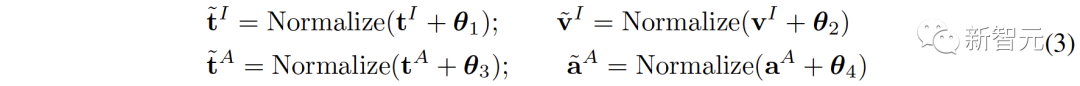

為了增強(qiáng)每個(gè)表征的語(yǔ)義完整性,我們提出將零均值高斯噪聲添加到表征中,并將它們重新歸一化為單位超球面上:

如圖1 (c) 中所示,在對(duì)比表征空間中,每個(gè)表征可以看代表是在單位超球面上的一個(gè)點(diǎn)。添加高斯噪聲并重新歸一化則使表征能夠代表了單位球面上的一個(gè)圓。

因?yàn)閮蓚€(gè)特征的空間距離越接近,其語(yǔ)義相似度也越高。所以圓內(nèi)的特征都具有相似語(yǔ)義,圓所能表示的語(yǔ)義更加完整。

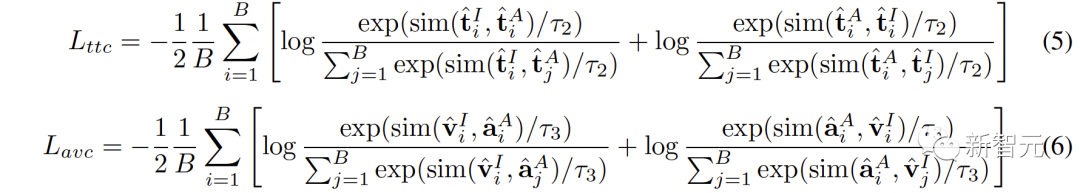

2. Inter-MCR的對(duì)齊

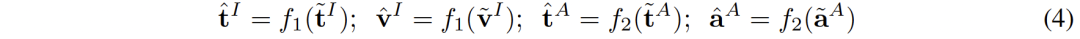

完成表征語(yǔ)義增強(qiáng)后,我們學(xué)習(xí)兩個(gè)映射器 和 來(lái)分別將CLIP和CLAP表征重新映射到一個(gè)新的共享空間:

新空間需要確保來(lái)自不同空間的語(yǔ)義相似的表征彼此接近。

來(lái)源于同一文本的 (,

) 是天然語(yǔ)義一致的,可以被看做真實(shí)標(biāo)簽對(duì),而源自于 (

,

) 的 (

,

) 可以被視為偽標(biāo)簽對(duì)。

(,

) 之間的語(yǔ)義高度一致,但從它們中學(xué)習(xí)到的連接對(duì)于音頻-視覺(jué)來(lái)說(shuō)是間接的。 而(

,

)對(duì)的語(yǔ)義一致性雖然不太可靠,但其更直接地有利于音頻-視覺(jué)表征。

為了更全面地連接兩個(gè)對(duì)比表征空間,我們同時(shí)對(duì)齊 (,

) 和 (

,

):

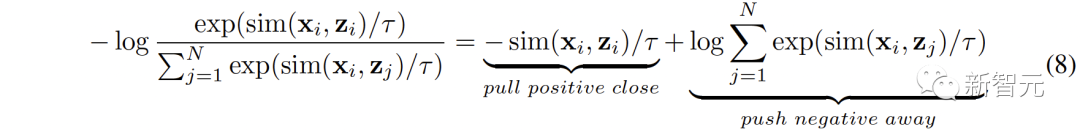

3. Intra-MCR的對(duì)齊

除了空間之間的連接,對(duì)比表征空間內(nèi)部還存在著modality gap的現(xiàn)象。即在對(duì)比表征空間中,不同模態(tài)的表征雖然語(yǔ)義對(duì)齊,但它們分布在完全不同的子空間中。這意味著從 (,

) 學(xué)習(xí)到的更穩(wěn)定的連接可能不能很好的被音頻-視覺(jué)繼承。

為了解決這個(gè)問(wèn)題,我們提出重新對(duì)齊各個(gè)對(duì)比表征空間的不同模態(tài)表征。具體來(lái)說(shuō),我們?nèi)コ龑?duì)比損失函數(shù)中的負(fù)例排斥結(jié)構(gòu),來(lái)推導(dǎo)出用于減小modality gap的損失函數(shù)。典型的對(duì)比損失函數(shù)可以表述為:

我們?nèi)コ渲胸?fù)對(duì)排斥項(xiàng),最終的公式可以被簡(jiǎn)化為:

實(shí)驗(yàn)

實(shí)驗(yàn)上,我們通過(guò)使用文本連接音頻-文本空間(CLAP)和文本-視覺(jué)空間(CLIP)來(lái)獲得音頻-視覺(jué)表征,使用圖像連接3D點(diǎn)云-圖像空間(ULIP)和圖像-文本空間(CLIP)來(lái)獲得3D點(diǎn)云-文本表征。

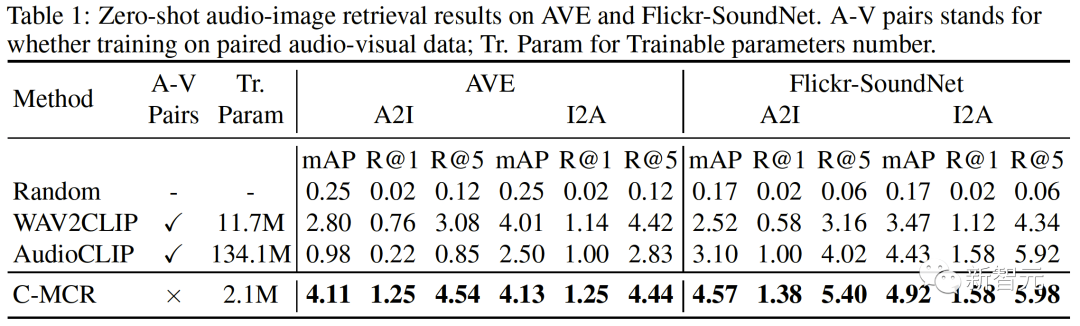

在AVE和Flickr-SoundNet上的zero-shot 音頻圖像檢索結(jié)果如下:

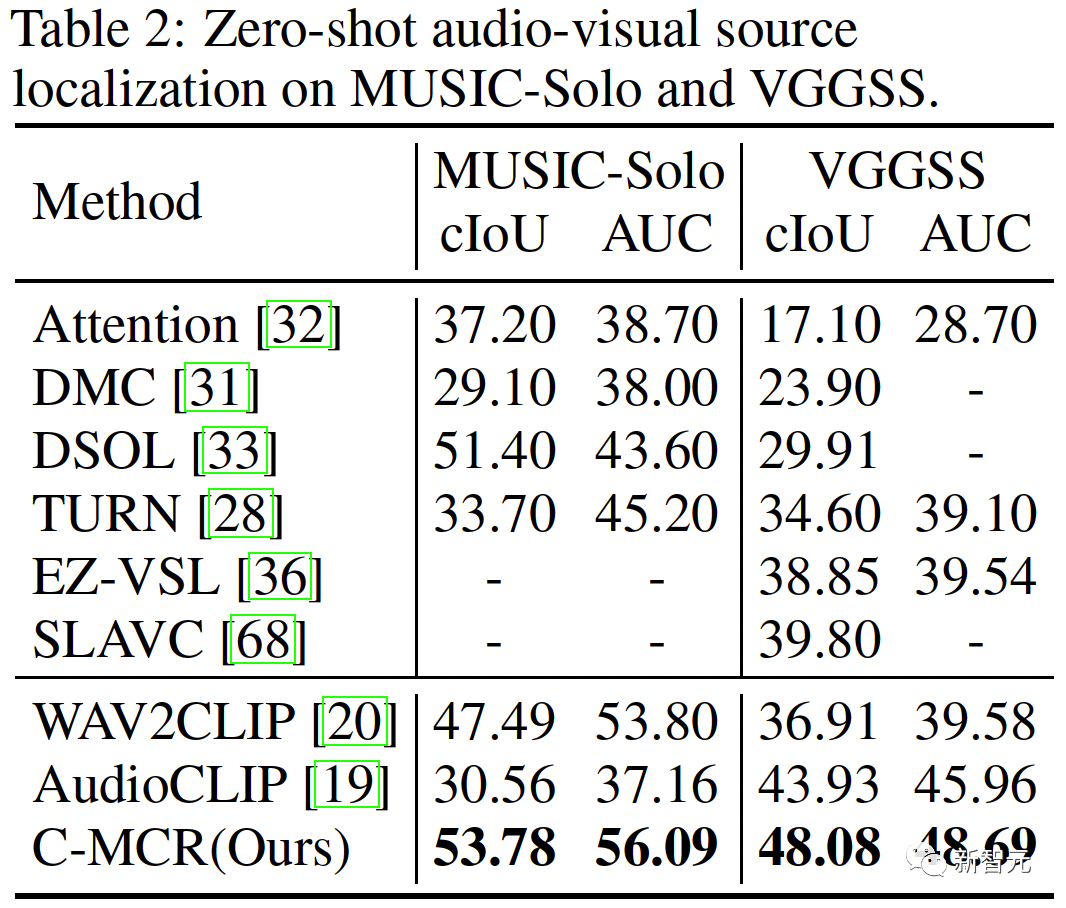

在MUSIC-Solo和VGGSS上的zero-shot 聲源定位結(jié)果如下:

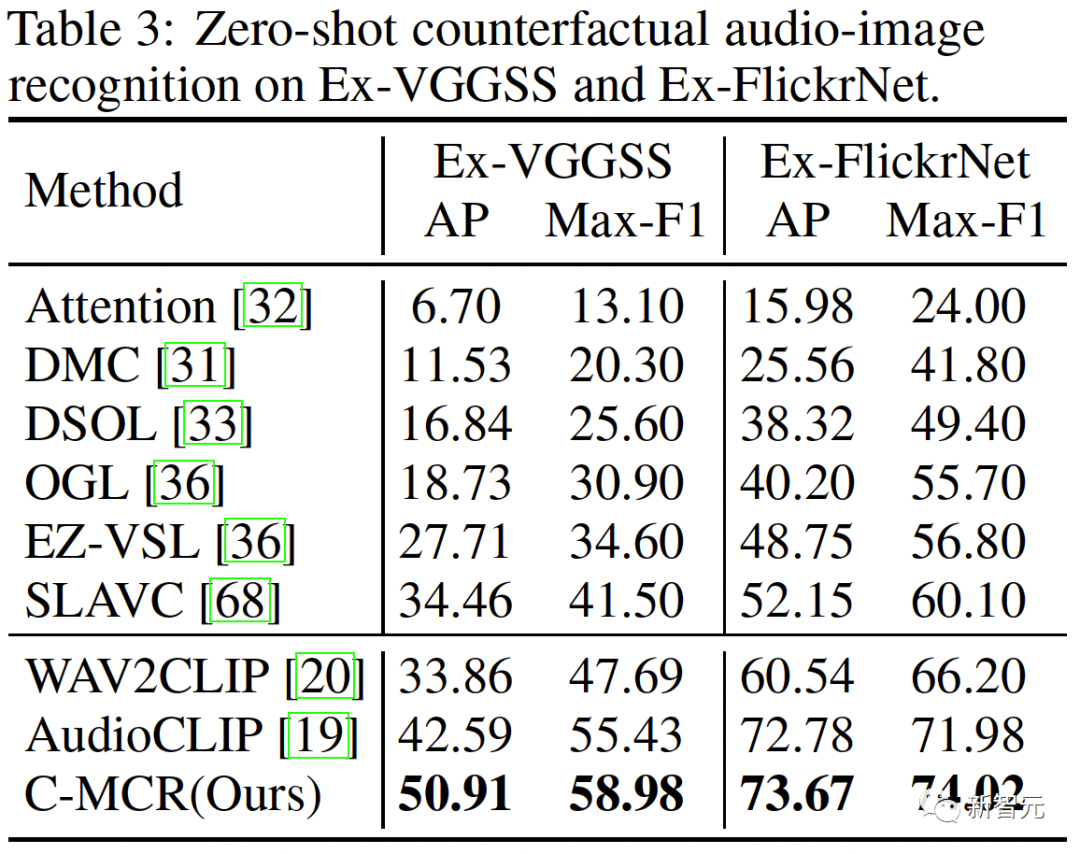

在Ex-VGGSS和Ex-FlickrNet上的zero-shot反事實(shí)音頻圖像識(shí)別結(jié)果如下:

在ModelNet40上的zero-shot 3D點(diǎn)云分類結(jié)果如下: