字節多模態大模型PixelLM:高效像素級推理,無需依賴SA

多模態大模型爆發,準備好進入圖像編輯、自動駕駛和機器人技術等細粒度任務中實際應用了嗎?

目前大多數模型的能力還是局限于生成對整體圖像或特定區域的文本描述,在像素級理解方面的能力(例如物體分割)相對有限。

針對這個問題,一些工作開始探索借助多模態大模型來處理用戶的分割指令(例如,“請分割出圖片中富含維生素C的水果”)。

然而,市面上的方法都存在兩個主要缺點:

1) 無法處理涉及多個目標對象的任務,而這在現實世界場景中是不可或缺的;

2) 依賴于像SAM這樣的預訓練圖像分割模型,而SAM的一次前向傳播需要的計算量已經足夠 Llama-7B產生500多個token了。

為了解決此問題,字節跳動智能創作團隊聯合北京交通大學、北京科技大學的研究人員提出了首個無需依賴SAM的高效像素級推理大模型PixelLM。

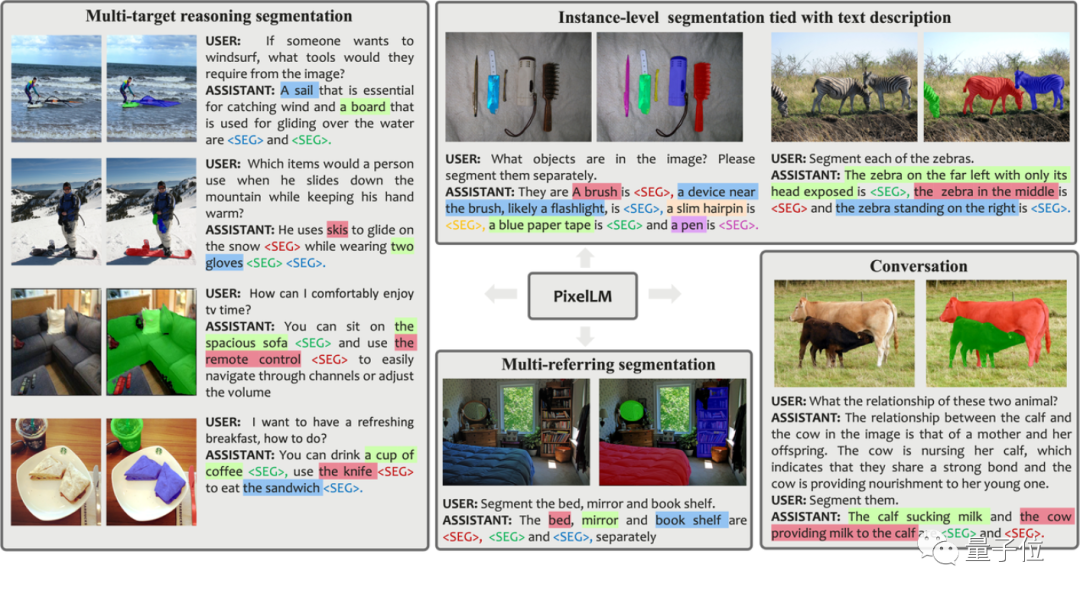

在具體介紹它之前,先來體驗幾組PixelLM實際分割的效果:

相比之前的工作,PixelLM的優勢在于:

- 能夠熟練處理任意數量的開放域目標和多樣化的復雜推理分割任務。

- 避免了額外的、成本高昂的分割模型,提升了效率和對不同應用的遷移能力。

進一步,為了支持這一研究領域的模型訓練和評估,研究團隊在LVIS數據集的基礎之上,借助GPT-4V構建了一個面向多目標推理分割場景的數據集MUSE,它包含20萬個以上的問題-答案對,涉及90萬個以上的實例分割掩碼。

為了實現上述的效果,這項研究具體是如何做的呢?

背后原理

圖片

圖片

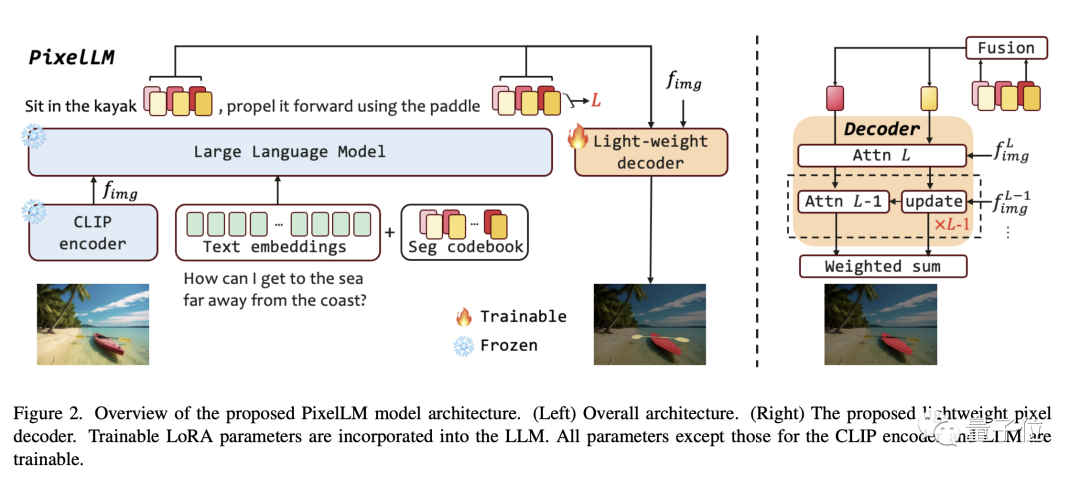

如論文中的框架圖所示,PixelLM架構十分簡潔,包括四個主要部分,后兩者是PixelLM的核心:

- 預訓練的CLIP-ViT視覺編碼器

- 大語言模型

- 輕量級像素解碼器

- 分割碼表 Seg Codebook

Seg codebook包含可學習的tokens,它們用于編碼CLIP-ViT不同尺度上的目標信息。然后,像素解碼器基于這些tokens和CLIP-ViT的圖像特征生成目標分割結果。得益于這種設計,PixelLM可以在沒有外部分割模型的情況下生成高質量的分割結果,顯著提高了模型效率。

根據研究人員的描述,Seg codebook內的tokens可分為L組,每一組包含N個token,每個組對應于來自CLIP-ViT視覺特征的一個尺度。

對于輸入的圖像,PixelLM從CLIP-ViT視覺編碼器產的圖像特征中提取出L個尺度的特征,其中最后一層涵蓋了全局圖像信息,會被LLM用作理解圖像內容。

Seg codebook的tokens將會與文本指令及最后一層圖像特征一起輸入LLM中,以自回歸的形式產生輸出。而輸出中也將包含經過LLM處理后的Seg codebook tokens,它們將與L個尺度的CLIP-ViT特征一起輸入到像素解碼器中產生最終的分割結果。

圖片

圖片

圖片

圖片

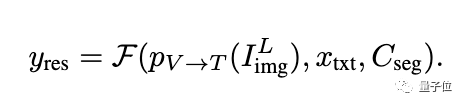

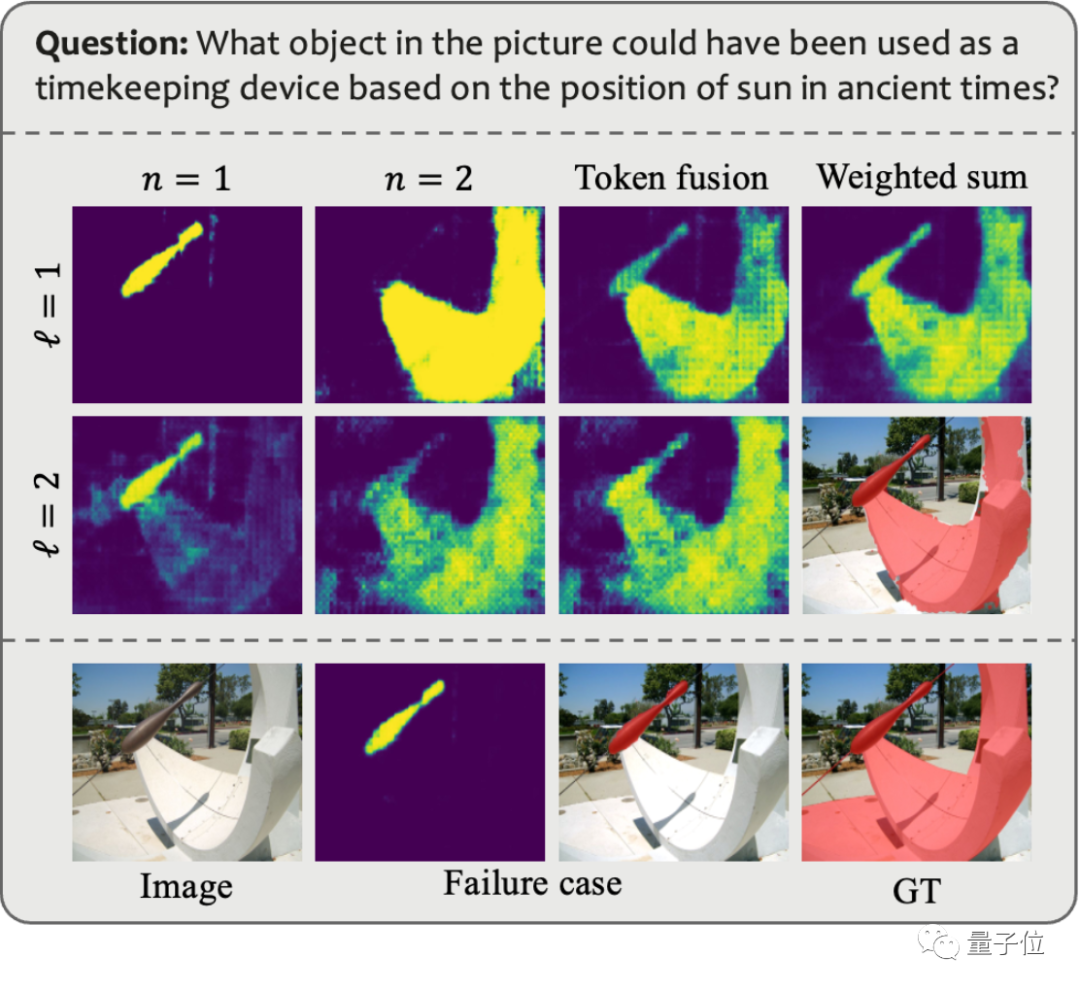

那么為什么還要設置每組包含N個token呢?研究人員結合下圖進行了解釋:

在涉及多個目標或目標所包含的語義十分復雜的情景中,盡管LLM可以提供詳細的文本響應,但僅使用單個token可能無法充分捕捉目標語義的全部內容。

為了增強模型在復雜推理情景下的能力,研究人員在每個尺度組內引入多個token,并執行一個token的線性融合操作。在token傳入解碼器之前,使用線性投影層將每個分組內的token合并。

下圖展示了每組內多個token時的效果。注意力圖是每個token經過解碼器處理后的樣子,這個可視化結果表明,多個token提供了獨特且互補的信息,從而實現了更有效的分割輸出。

圖片

圖片

此外,為了增強模型區分多個目標的能力,PixelLM還額外設計了一個Target Refinement Loss。

MUSE數據集

盡管已經提出了上述解決方案,但為了充分發揮模型的能力,模型仍然需要適當的訓練數據。回顧目前可用的公開數據集,發現現有的數據存在以下主要限制:

1) 對物體細節的描述不夠充足;

2) 缺乏具有復雜推理和多種目標數量的問題-答案對。

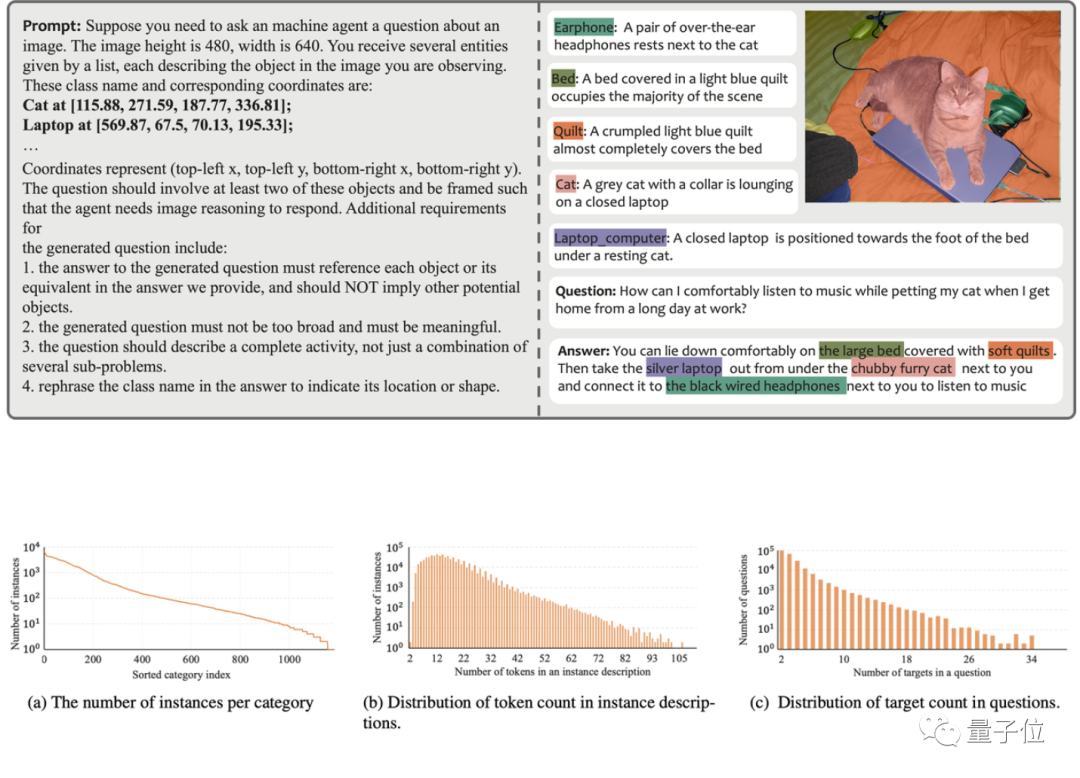

為了解決這些問題,研究團隊借助GPT-4V構建了一個自動化的數據標注流水線,并由此產生了MUSE數據集。下圖展示了MUSE生成時所用到的Prompt及產生的數據示例。

圖片

圖片

在MUSE中,所有實例掩碼都來自LVIS數據集,并且額外添加了根據圖像內容生成的詳細文本描述。MUSE包含了24.6萬個問題-答案對,每個問題-答案對平均涉及3.7個目標物體。此外,研究團隊對數據集進行了詳盡的統計分析:

類別統計:MUSE中有來自原始LVIS數據集的1000多個類別,以及90萬個具有獨特描述的實例,這些描述基于問題-答案對的上下文而變化。圖(a)顯示了所有問題-答案對中每個類別的實例數量。

Token數目統計:圖(b)展示了實例描述的token數目分布,其中有的實例描述包含了超過100個tokens。這些描述不僅限于簡單的類別名稱;相反,它們通過基于GPT-4V的數據生成流程,大量豐富了每個實例的詳細信息,涵蓋了外觀、屬性和與其他對象的關系等。數據集中信息的深度和多樣性增強了訓練模型的泛化能力,使其能夠有效地解決開放域問題。

目標數目統計:圖(c)展示了每個問題-答案對中目標數量的統計數據。平均目標數量為3.7,最大目標數量可達34個。這個數字可以覆蓋單個圖像的大多數目標推理場景。

算法測評

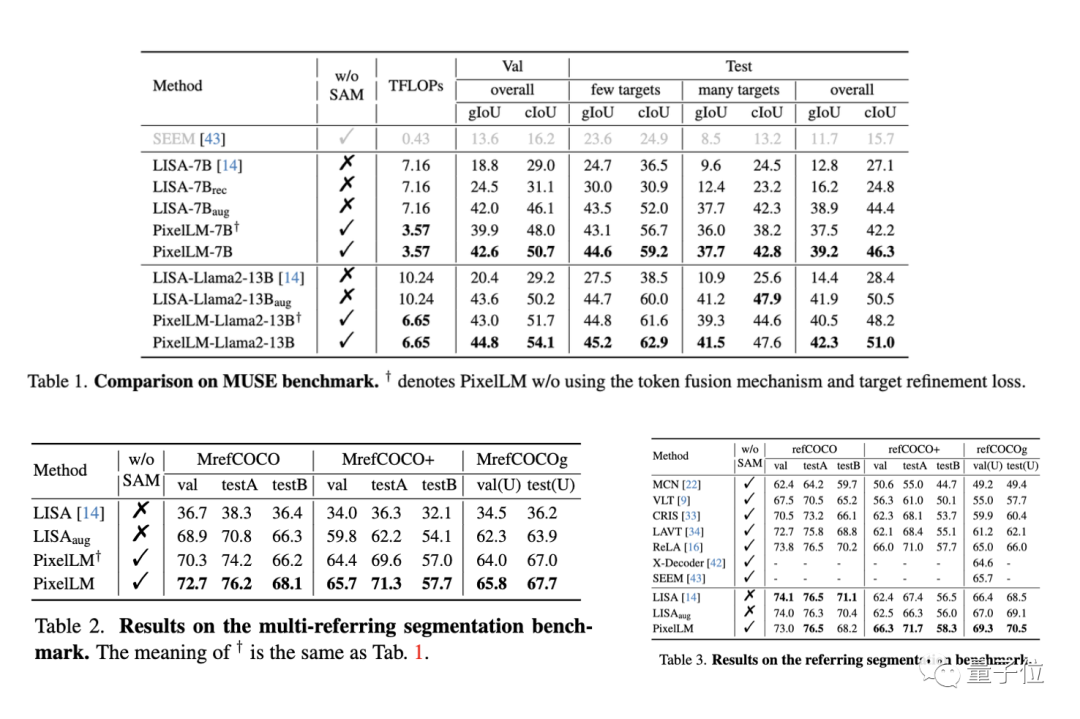

研究團隊在三個benchmark上評測了PixelLM的性能,包括MUSE benchmark, referring segmentation benchmark,以及multi-referring segmentation benchmark. 在multi-referring segmentation benchmark中,研究團隊要求模型在一個問題中連續地分割出referring segmentation benchmark中每幅圖像包含的多個目標。

同時,由于PixelLM是首個處理涉及多目標復雜像素推理任務的模型,研究團隊建立了四個baseline以對模型進行比較分析。

其中三個baseline基于與PixelLM最相關工作LISA,包括:

1)原始的LISA;

2)LISA_rec: 先將問題輸入LLAVA-13B以得到目標的文本回復,再用LISA分割這些文本;

3)LISA_aug:直接將MUSE加入LISA的訓練數據。

4) 另外一個則是不使用LLM的通用分割模型SEEM。

圖片

圖片

在三個benchmark的絕大多數指標上,PixelLM的性能均優于其他方法,且由于PixelLM不依賴于SAM,其TFLOPs遠遠低于同尺寸的模型。

感興趣的小伙伴可以先關注一波,坐等代碼開源了~

參考鏈接:

[1]https://arxiv.org/abs/2312.02228

[2]https://pixellm.github.io/