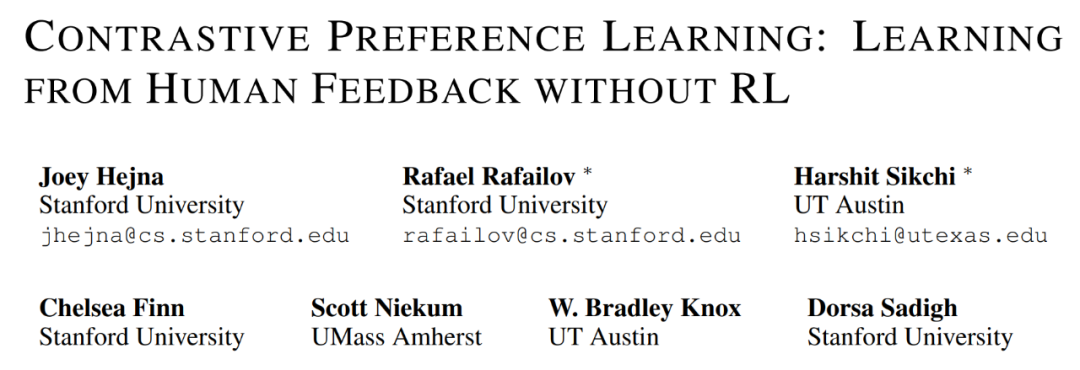

斯坦福提出對比偏好學習:無需強化學習即可從人類反饋中學習

在模型與人類意圖對齊方面,根據人類反饋的強化學習(RLHF)已經成為一大流行范式。通常來說,RLHF 算法的工作過程分為兩個階段:一、使用人類偏好學習一個獎勵函數;二、通過使用強化學習優化所學習的獎勵來對齊模型。

RLHF 范式假定人類偏好的分布遵照獎勵,但近期有研究認為情況并非如此,人類偏好其實遵循用戶最優策略下的后悔值(regret)。因此,根據反饋學習獎勵函數不僅基于一個有漏洞的對于人類偏好的假設,而且還會導致出現難以處理的優化難題 —— 這些難題來自強化學習階段的策略梯度或 bootstrapping。

由于存在這些優化難題,當今的 RLHF 方法都會將自身限定在基于上下文的 bandit 設置中(比如在大型語言模型中)或會限制自己的觀察維度(比如基于狀態的機器人技術)。

為了克服這些難題,斯坦福等多所大學的一個研究團隊提出了一系列新算法,可使用基于后悔的人類偏好模型來優化采用人類反饋時的行為,而沒有采用社區廣泛接受的僅考慮獎勵總和的部分回報模型。不同于部分回報模型,基于后悔的模型可直接提供有關最優策略的信息。

這樣一種機制帶來了一個幸運的結果:完全不需要強化學習了!

這樣一來,就能在具有高維狀態和動作空間的通用型 MDP 框架中來解決 RLHF 問題了。

研究者提出,他們這項研究成果的核心見解是:將基于后悔的偏好框架與最大熵(MaxEnt)原理結合起來,可得到優勢函數與策略之間的雙射。通過將對優勢的優化換成對策略的優化,可以推導出一個純監督學習的目標,其最優值為專家獎勵下的最優策略。該團隊將這種方法命名為對比偏好學習(Contrastive Preference Learning/CPL),因為其類似于人們廣為接受的對比學習目標。

- 論文地址:https://arxiv.org/pdf/2310.13639.pdf

- 代碼地址:https://github.com/jhejna/cpl

相比于之前的方法,CPL 有三大關鍵優勢。

一、CPL 能像監督學習一樣擴展,因為它只使用監督式目標來匹配最優優勢,而無需使用任何策略梯度或動態規劃。

二、CPL 是完全離策略的方法,因此其可有效使用任何離線的次優數據源。

三、CPL 可應用于任意馬爾可夫決策過程(MDP),使其可以從序列數據上的偏好查詢中學習。

該團隊表示,之前的 RLHF 方法都無法同時滿足以上三點。為了表明 CPL 方法符合以上三點描述,研究者進行了實驗,結果表明該方法確實能有效應對帶有次優和高維離策略數據的序列決策問題。

值得注意的是,他們在實驗中發現:在 MetaWorld 基準上,CPL 竟能有效地使用與對話模型一樣的 RLHF 微調流程來學習在時間上擴展的操作策略。

具體來說,他們使用監督學習方法,在高維圖像觀察上對策略進行預訓練,然后使用偏好來對其進行微調。無需動態規劃或策略梯度,CPL 就能達到與基于先驗式強化學習的方法一樣的性能表現。與此同時,CPL 方法要快 1.6 倍,參數效率也提高了四倍。當使用更密集的偏好數據時,CPL 的性能表現在 6 項任務的 5 項上超越了強化學習。

對比偏好學習

這種方法的核心思想很簡單:研究者發現,當使用最大熵強化學習框架時,后悔偏好模型中使用的優勢函數可被輕松替換成策略的對數概率。但是,這種簡單的替換能帶來巨大的好處。如果使用策略的對數概率,就不需要學習優勢函數或應付與類強化學習算法相關的優化難題了。

研究者表示,這不僅能造就對齊更緊密的后悔偏好模型,還能完全依靠監督學習來學習人類反饋。

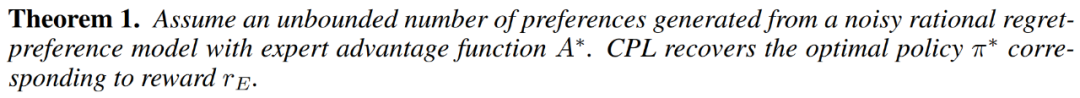

下面首先將推導 CPL 目標,并表明對于帶有無界數據的專家用戶獎勵函數 r_E,該方法可以收斂到最優策略。然后將說明 CPL 與其它監督學習方法的聯系。最后,研究者將說明如何在實踐中使用 CPL。他們表示,這些算法屬于一個用于解決序列決策問題的新方法類別,這類方法非常高效,因為它能直接從基于后悔的偏好中學習出策略,而無需強化學習。

從最優優勢到最優策略

在使用后悔偏好模型時,偏好數據集 D_pref 包含有關最優優勢函數 A^? (s, a) 的信息。我們可以直觀地認為,該函數度量的是一個給定動作 a 比最優策略在狀態 s 時生成的動作的糟糕程度。

因此根據定義,最大化最優優勢的動作就是最優動作,并且從偏好學習最優優勢函數應該讓人能直觀地提取出最優策略。

具體而言,該團隊證明了以下定理:

直接學習策略的好處。以這種方式直接學習 π 有諸多實踐和理論上的好處。其中最明顯的可能是:直接學習策略的話,就無需學習其它任何函數了,比如獎勵函數或價值函數。這使得 CPL 比之前的方法簡單很多。

與對比學習的聯系。CPL 方法直接使用一個對比目標來進行策略學習。研究者表示,鑒于對比學習目標已經在大型數據集和神經網絡方面取得了有目共睹的成功,因此他們預計 CPL 能比使用傳統強化學習算法的強化學習方法進行更好的擴展。

實踐方面需要考慮的問題

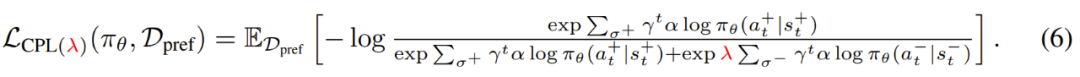

對比偏好學習框架提供了一個通用的損失函數,可用于從基于優勢的偏好中學習策略,基于此可以派生出許多算法。下面將基于一個實踐效果很好的特定 CPL 框架實例介紹實踐方面需要考慮的問題。

使用有限離線數據的 CPL。盡管 CPL 可通過無界偏好數據收斂到最優策略,但實際上我們通常關心的是學習有限離線數據集。在這種設置下,外推到數據集支持之外太遠的策略表現很差,因為它們采取的動作會導致出現分布之外的狀態。

正則化。在有限設置中,我們希望選擇能最小化 CPL 損失函數的策略,同時為該數據集中的動作賦予更高的可能性。為了做到這一點,研究者使用一個保守的正則化器得到了以下損失函數:當策略在 D_pref 中的動作上有更高的可能性時,就分配更低的損失,從而保證其在分布內。

預訓練。該團隊發現,如果使用行為克隆(BC)方法對策略 π_θ 進行預訓練,往往能得到更優的結果。因此,在通過 CPL 損失使用偏好來進行微調之前,該團隊使用了標準的最大似然行為克隆目標來訓練策略,即:

實驗及結果

這一節將解答以下有關 CPL 的問題:一、CPL 能否有效地根據基于后悔的偏好來微調策略?二、CPL 能否擴展用于高維控制問題和更大的網絡?三、CPL 的哪些組件對于獲得高性能很重要?

偏好數據。使用次優的離策略 rollout 數據和偏好,研究者評估了 CPL 為一般性 MDP 學習策略的能力。

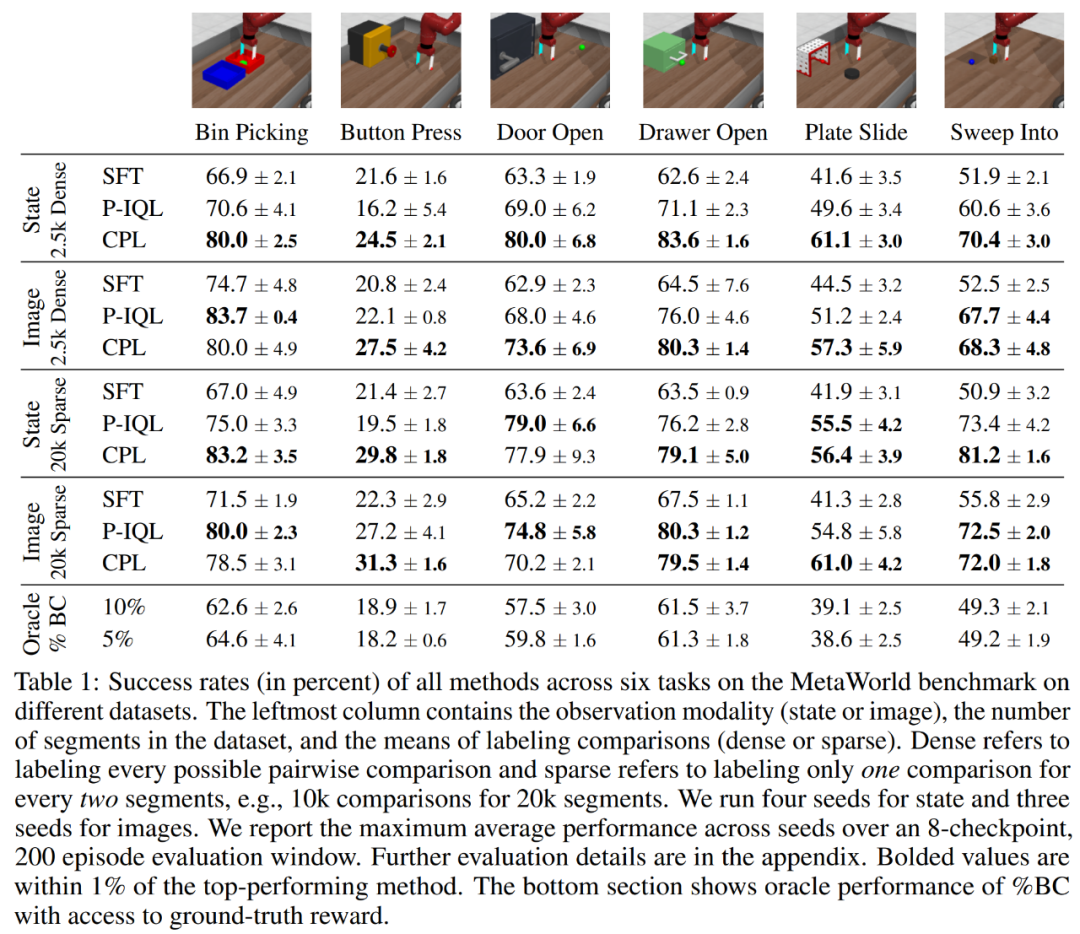

基準方法。實驗中考慮了三種基準方法:監督式微調(SFT)、偏好隱式 Q 學習(P-IQL)、% BC(通過對 rollout 的 top X% 進行行為克隆來訓練策略)。

CPL 表現如何?

使用基于狀態的觀察數據時,CPL 表現如何?對于基于狀態的實驗結果,主要可見表 1 的第 1 和 3 行。

當使用更稀疏的比較數據時(第 3 行),CPL 在 6 個環境中的 5 個上都優于之前的方法,并且相比于 P-IQL 的優勢大都很明顯,尤其是 Button Press、Bin Picking 和 Sweep Into 環境。當應用于具有更密集比較的數據集時,CPL 比 P-IQL 的優勢還要更大(第 1 行),并且在所有環境上都很顯著。

CPL 如何擴展用于高維觀察數據?為了測試 CPL 的監督目標能否擴展用于高維連續控制問題,該團隊將 MetaWorld 數據集渲染成了 64 × 64 的圖像。

表 1 的第 2 和 4 行給出了基于圖像的實驗結果。他們得到了有趣的發現:對 SFT 來說,性能表現略有提升,但 P-IQL 的提升卻很明顯。當學習更密集的偏好數據時(第 2 行),CPL 仍舊在 6 個環境中的 4 個上優于 P-IQL,在 Sweep Into 上兩者相當。當學習更稀疏的比較數據時(第 4 行),CPL 和 P-IQL 在大多數任務上都表現相當。

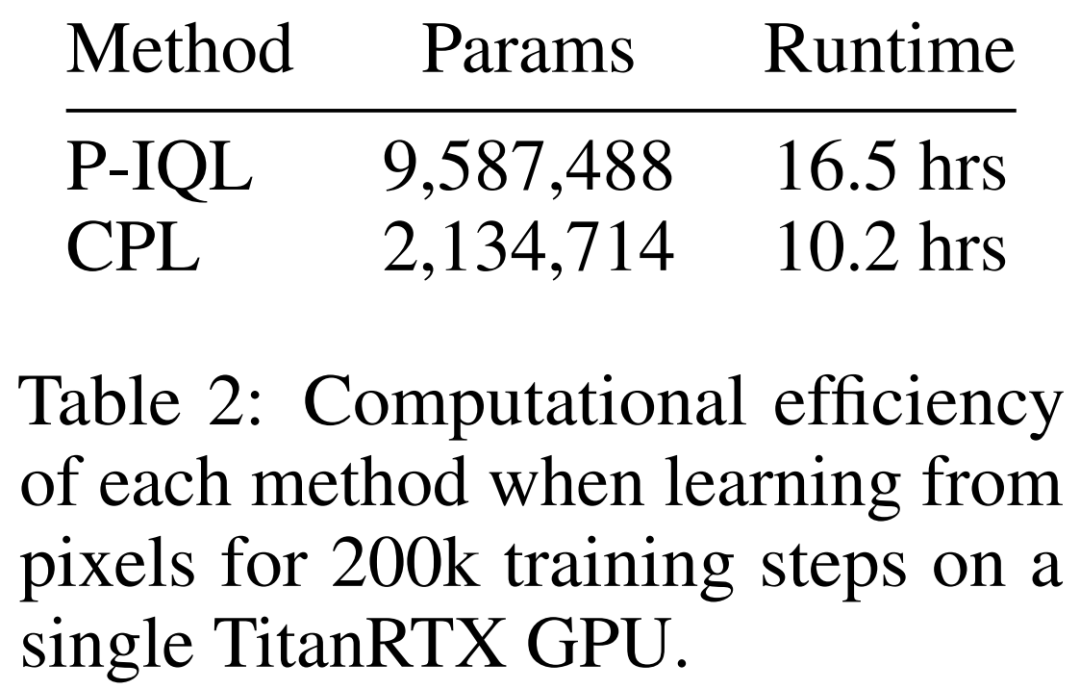

考慮到 CPL 有明顯更低的復雜性,這樣的結果就更驚人了!P-IQL 必須學習一個獎勵函數、一個 Q 函數、一個價值函數和一個策略。CPL 則都不需要,它只需學習一個策略,這能極大減少訓練時間和參數數量。

正如下表 2 所示,在圖像任務上,CPL 的運行速度比 P-IQL 快 1.62 倍,并且參數數量還不到 P-IQL 的四分之一。隨著網絡越來越大,使用 CPL 所帶來的性能增益只會有增無減。

哪些組件有助于 CPL 的性能表現?

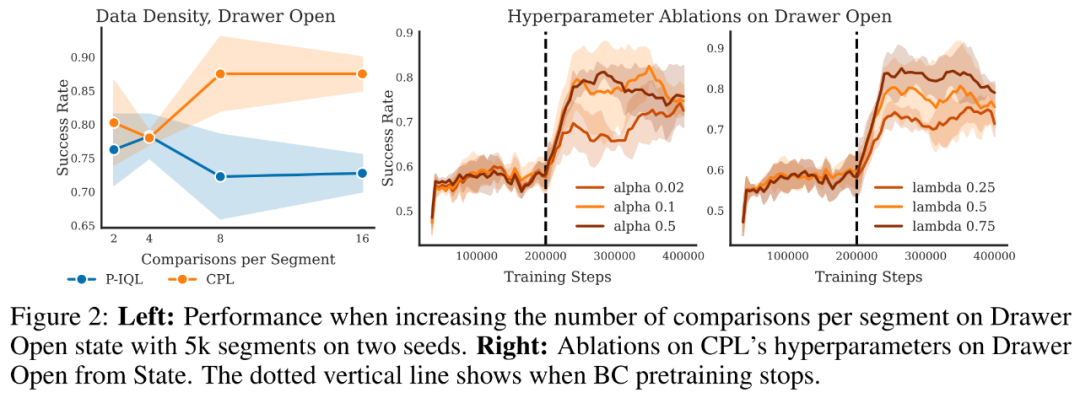

從實驗結果可以看到,當使用有更密集比較的數據集時,CPL 和基準方法之間的差距會更大。這與之前在對比學習方面的研究成果一致。

為了研究這種效果,研究者基于一個包含 5000 個片段的固定大小的數據集,通過增加每個片段采樣的比較數量,對 CPL 的性能進行了評估。下圖 2 給出了在基于狀態的觀察數據的開抽屜(Drawer Open)任務上的結果。

整體上看,當每片段采樣的比較數量增加時,CPL 都能從中受益,僅有 Plate Slide 任務例外。

最后,該團隊也對 CPL 的超參數(溫度值 α 和偏差正則化器 λ)進行了消融研究;該研究也基于開抽屜任務,結果見圖 2 右側。盡管 CPL 使用這些值的表現已經很好了,但實驗發現通過適當調整超參數(尤其是 λ),其表現還能更好。