多篇論文入選Interspeech 2023 火山語音有效解決多類實踐問題

日前,火山語音團隊多篇論文入選Interspeech 2023,內容涵蓋短視頻語音識別、跨語言音色與風格以及口語流利度評估等多個應用方向的創新突破。Interspeech作為國際語音通信協會ISCA組織的語音研究領域的頂級會議之一,也被稱為全球最大的綜合性語音信號處理盛會,受到全球語言領域人士的廣泛關注。

Interspeech2023活動現場

基于隨機語句串聯的數據增強改進短視頻語音識別(Random Utterance Concatenation Based Data Augmentation for Improving Short-video Speech Recognition)

一般來說,端到端自動語音識別(ASR)框架的限制之一,就是如果訓練和測試語句的長度不匹配,其性能可能會受到影響。在該論文中,火山語音團隊提出了一種基于即時隨機語句串聯(RUC)的數據增強方法作為前端數據增強,以減輕短視頻ASR任務中訓練和測試語句長度不匹配的問題。

具體而言,團隊得出這樣的創新實踐主要來自以下觀察:通常人工轉錄的訓練語句在短視頻自發語音中要短很多(平均約3秒),相比而言從語音活動檢測前端生成的測試語句要長得多(平均約10秒),所以這種不匹配可能會導致性能不佳。

“對此,我們使用了來自15種語言的多類ASR模型進行了實證,這些語言的數據集范圍從1,000小時到30,000小時不等。在模型微調階段,還即時加入采樣多條數據后并拼接的數據,相比于沒有增強過的數據,此方法在所有語言上平均達到了5.72%的相對詞錯誤率降低。”火山語音團隊表示。

測試集上長句的 WER 通過 RUC 訓練過后顯著下降(藍色 vs. 紅色)

根據實驗觀察,所提出的RUC方法明顯改善了長語句的識別,而短語句的性能則沒有下降。通過進一步的分析,團隊發現所提出的數據增強方法可以使ASR模型對于長度歸一化的變化變得不太敏感,這或許意味著ASR模型對于多樣環境更具魯棒性。總結來說,RUC數據增強方法雖然實操簡單,但效果相當顯著。

基于語音和韻律自監督方法的流利度打分(Phonetic and Prosody-aware Self-supervised Learning Approach for Non-native Fluency Scoring)

口語的流利程度是評價二語學習者語言能力的重要維度之一。流利的發音主要反映在輕松正常發出語音的同時很少伴隨停頓、猶豫或自我糾正等異常現象,因為大多數二語學習者與母語者相比,通常會表現出較慢的語速以及更頻繁的停頓。對此火山語音團隊提出了一種基于語音和韻律相關的自監督建模方法用于口語流利度打分。

具體來說,在預訓練階段,需要對模型的輸入序列特征(聲學特征、音素id、音素時長)進行掩碼,將掩碼后的特征送入模型,利用上下文相關的編碼器根據時序信息來還原掩碼部分的音素id和音素時長信息,從而模型具有更強大的語音和韻律表征能力。該方案將序列建模框架中原始時長、音素和聲學信息這三種特征進行掩碼重構,讓機器自動去學習上下文的語音和時長表征,更好用于流利度打分。

這種基于語音和韻律的自監督學習方法超過了領域內其他方法,在內部測試集上機器預測結果和人類專家打分之間相關性達到了0.833,與專家和專家之間的相關性 0.831持平。在開源數據集上,機器預測結果和人類專家打分之間相關性達到了0.835,性能超越過去在該任務上提出的一些自監督方法。應用場景方面,該方法可被應用于有流利度自動評估的需求場景中,例如口語考試以及各種在線口語練習等。

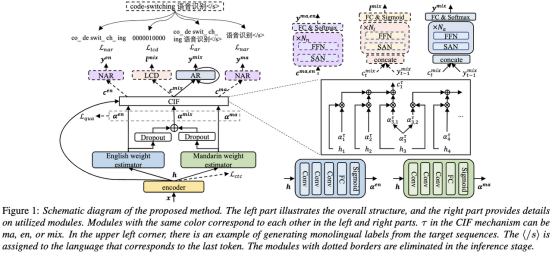

解耦非母語語音在發音評估中的貢獻(Disentangling the Contribution of Non-native Speech in Automated Pronunciation Assessment)

非母語發音評估的一個基本思想就是量化學習者發音與母語者發音的偏差,因此早期用于發音評測的聲學模型通常僅僅使用目的語的數據進行訓練,但最近的一些研究開始將非母語語音數據納入模型訓練。將非母語語音納入二語ASR 與非母語評估或發音錯誤檢測中的目的存在根本區別:前者的目標是盡可能使模型適應非母語數據以達到最優 ASR 性能;后者則需要平衡兩個看似相悖的需求,即在非母語語音的較高識別精度以及對非母語發音的發音水平實現客觀的評估。

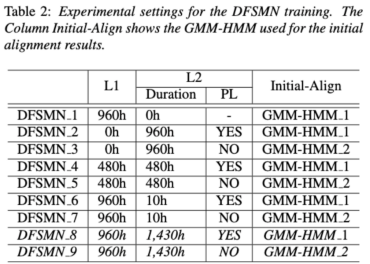

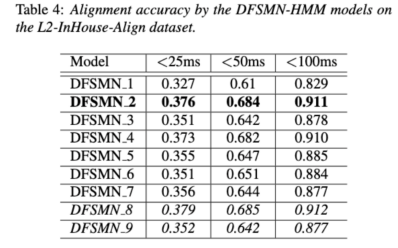

基于此,火山語音團隊旨在從兩個不同角度,即對齊精度和評估表現,研究非母語語音在發音評估中的貢獻,從而設計了不同的數據組合和訓練聲學模型時的文本轉錄形式,如上圖所示。

上述兩個表格分別展現了不同組合的聲學模型在對齊精度和評估中的性能。實驗結果表明,在聲學模型訓練期間僅使用帶有人工標注的音素序列的非母語數據,可以實現非母語語音的對齊以及發音評估的最高準確度。具體來說,在訓練中將一半母語數據和一半非母語數據(人工標注的音素序列)混合可能會稍差,但可以媲美僅使用非母語數據與人工標注的音素序列。

此外,上述這種混合情況在母語數據的發音評估上表現更好。在低資源條件下,與僅使用母語數據進行聲學模型訓練相比,無論使用哪種文本轉錄類型,添加10小時的非母語數據都可以顯著提高對齊準確性和評估性能,該研究對于語音評估領域數據的運用具有指導性意義。

在端到端語音識別通過非尖峰的CTC優化幀分類器解決時間戳問題(Improving Frame-level Classifier for Word Timings with Non-peaky CTC in End-to-End Automatic Speech Recognition)

自動語音識別(ASR)領域的端到端系統已經展示出與混合系統相媲美的性能。作為ASR的附帶產物,時間戳在許多應用中都是至關重要的,特別在字幕生成和計算輔助發音訓練等場景,本論文旨在優化端到端系統中的幀級分類器來獲取時間戳。對此團隊引入使用CTC(connectionist temporal classification)損失來訓練幀級分類器,并且引入標簽先驗的信息使得CTC的尖峰現象有所緩解,還將梅爾濾波器與ASR編碼器的輸出相結合,作為輸入特征。

在內部的中文實驗上,該方法在單詞時間戳200ms準確性上達到了95.68%/94.18%,而傳統混合系統僅為93.0%/90.22%。此外,相對于之前的端到端方法,團隊在內部的7種語言上取得了4.80%/8.02%的絕對性能提升。通過逐幀的知識蒸餾方法,還進一步提高了單詞定時的準確性,盡管此實驗僅針對LibriSpeech進行。

這項研究結果表明,端到端語音識別系統中的時間戳性能可以通過引入標簽先驗和融合不同級別的特征進行有效優化。在內部中文實驗上,該方法相較于混合系統和之前的端到端方法,都取得了顯著的改進;此外對于多種語言,方法也展現出了明顯的優勢;通過知識蒸餾方法的應用進一步提高了單詞定時的準確性。這些結果不僅對字幕生成和發音訓練等應用具有重要意義,還為自動語音識別技術的發展提供了有益的探索方向。

基于語種區分聲學邊界學習的中英混語音識別(Language-specific Acoustic Boundary Learning for Mandarin-English Code-switching Speech Recognition )

眾所周知Code-switch(CS)的主要目標是促進跨不同語言或技術領域的有效交流。 CS 需要在一個句子中交替使用兩種或多種語言,然而合并來自多種語言的單詞或短語可能會導致語音識別的錯誤和混淆,這使Code-switching語音識別(CSSR) 成為一項更具挑戰性的任務。

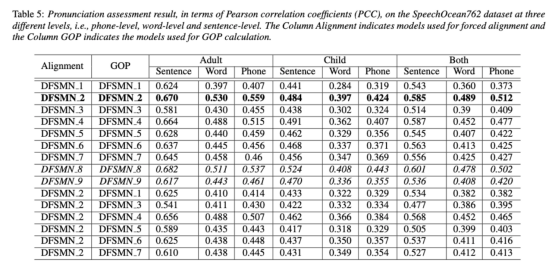

通常端到端ASR模型由編碼器、解碼器和對齊機制組成。 現有的端到端 CSASR 模型大多只關注優化編碼器和解碼器結構,很少會探討對齊機制是否需要進行語種相關的設計,大多數已有工作都是針對中英混場景使用普通話字符和英語子詞的混合作為建模單元。 通常普通話字符表示普通話中的單個音節,并且聲學邊界清晰;而英文子詞是在不參考任何聲學知識的情況下獲得的,所以它們的聲學邊界可能是模糊的。 為了在 CSASR 系統中獲得普通話和英語的良好聲學邊界(對齊),進行語種相關的聲學邊界學習是十分必要的。對此團隊在CIF模型的基礎上進行了改進,提出了一種語種區分的聲學邊界學習方法來用于CSASR任務,模型架構的詳細信息見下圖。

該模型由六個組件組成,分別是編碼器、語種區分的權重估計器(LSWE)、CIF模塊、自回歸(AR)解碼器、非自回歸(NAR)解碼器和語種變化檢測(LCD)模塊。編碼器和自回歸解碼器以及CIF的計算過程與原始的CIF-based的ASR方法無異,語種區分的權重估計器負責完成語種獨立的聲學邊界的建模,非自回歸(NAR)解碼器和語種變化檢測(LCD)模塊都是設計來輔助模型的訓練,在解碼階段不再保留。

實驗結果顯示,該方法在開源中英混數據集SEAME的兩個測試集testman和testsge上獲得了新的SOTA效果,分別是16.29%和22.81%的MER。為了進一步驗證該方法在更大數據量中的效果,團隊在9000小時的內部數據集上進行了實驗,最終也是獲得了相對7.9%的MER收益。據了解,本論文也是第一篇在CSASR任務中進行語種區分的聲學邊界學習的工作內容。

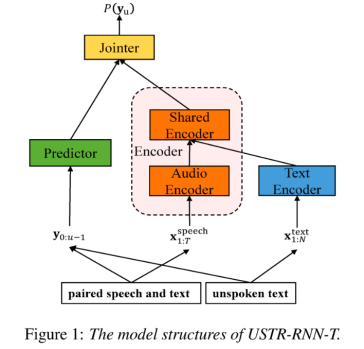

USTR:基于統一的表征和純文本進行 ASR 領域適應(Text-only Domain Adaptation using Unified Speech-Text Representation in Transducer)

眾所周知,領域遷移一直是ASR中十分重要的任務,但在目標領域獲取成對的語音數據非常耗時且成本很高,因此其中很多工作都是利用目標領域相關文本數據來提升識別效果。傳統方法中,TTS 會增加訓練的周期和相關數據的存儲成本,ILME和Shallow fusion等方法會增加推理時的復雜度。

基于該任務,團隊在 RNN-T的基礎上,將Encoder拆分成Audio Encoder和Shared Encoder,同時引入Text Encoder用于學習和語音信號類似的表征;語音和文本的表征則通過Shared Encoder,使用RNN-T loss進行訓練,被稱為 USTR(Unified Speech-Text Representation)。“對于Text Encoder這部分,我們探究了不同類型的表征形式,包括Character序列,Phone序列和Sub-word 序列,最終結果表明Phone序列的效果最好。對于訓練方式,本文探究了基于給定RNN-T模型的Multi-step訓練方式和完全隨機初始化的Single-step訓練方式。”

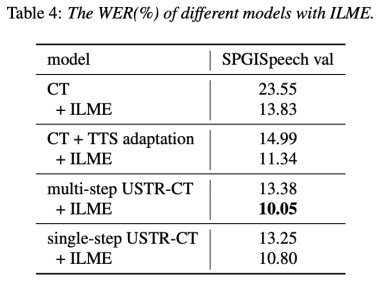

具體來說,團隊使用LibriSpeech數據集作為Source domain,并利用 SPGISpeech 的標注文本作為純文本進行領域遷移實驗。實驗結果表明,該方法在目標領域的效果提升可以和 TTS 基本持平;Single-step訓練效果更高,效果和 Multi-step基本持平;同時還發現USTR方法可以和ILME這種外掛語言模型的方法進一步結合,即便LM使用的是相同的文本訓練語料。最終,在目標領域測試集上,不結合外部語言模型,本方法相對基線 WER 23.55% -> 13.25%,相對下降 43.7%。

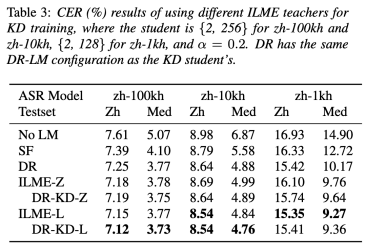

基于知識蒸餾的高效內部語言模型估計方法 (Knowledge Distillation Approach for Efficient Internal Language Model Estimation)

盡管內部語言模型估計(ILME)已經證明其在端到端ASR語言模型融合中的有效性,但是與傳統的Shallow fusion相比,ILME額外引入了內部語言模型的計算,增加了推理成本。為了估計內部語言模型,需要基于ASR解碼器上做一次額外的前向計算,或者基于密度比率(Density Ratio)方法,用ASR訓練集文本訓練一個獨立的語言模型(DR-LM),作為內部語言模型的近似。基于ASR解碼器的ILME方法,由于直接利用ASR參數進行估計,通常可以取得優于密度比率方法的性能,但其計算量取決于ASR解碼器的參數量;密度比率方法的優勢則在于可以通過控制DR-LM的大小實現高效的內部語言模型估計。

為此火山語音團隊提出在密度比率方法的框架下,用基于ASR解碼器的ILME方法作為教師,蒸餾學習DR-LM,從而在保持ILME性能的同時,大幅降低ILME的計算成本。

實驗結果表明,這一方法能夠減少95%的內部語言模型參數量,同時性能與基于ASR解碼器的ILME方法相當;采用性能更好的ILME方法作為教師時,相應的學生模型也能取得更好的效果;與計算量相當的傳統密度比率方法相比,這一方法在高資源場景下性能略優,在低資源跨領域遷移場景下CER收益可達8%,并且對于融合權重更加魯棒。

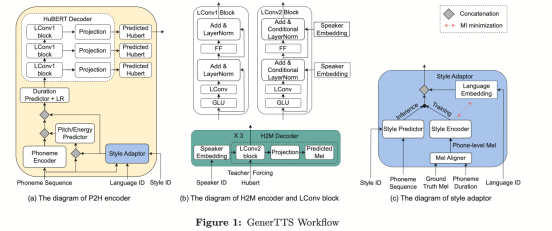

GenerTTS:跨語言語音合成中音色和風格與發音解耦和泛化(GenerTTS: Pronunciation Disentanglement for Timbre and Style Generalization in Cross-Lingual Text-to-Speech)

跨語言音色和風格可泛化的語音合成(TTS)旨在合成具有特定參考音色或風格的語音,該音色或風格并未在目標語言中進行過訓練。它面臨著這樣的挑戰,例如音色和發音之間難以分離,因為通常很難獲取特定說話人的多語言語音數據;風格和發音混合在一起,因為語音風格包含語言無關和語言相關兩部分。

為了解決這些挑戰,火山語音團隊提出了GenerTTS,分別精心設計了基于HuBERT的信息瓶頸,以解藕音色和發音/風格之間的聯系;最小化風格和語言之間的互信息,以去除風格中的語言特定信息。

實驗證明,GenerTTS在風格相似性和發音準確性方面優于基準系統,并實現了跨語言音色和風格的可泛化性。

一直以來,火山語音團隊面向字節跳動內部各業務線,提供優質的語音AI技術能力以及全棧語音產品解決方案,并通過火山引擎對外提供服務。自 2017 年成立以來,團隊專注研發行業領先的 AI 智能語音技術,不斷探索AI 與業務場景的高效結合,以實現更大的用戶價值。