文生圖prompt不再又臭又長!LLM增強擴散模型,簡單句就能生成高質量圖像

擴散模型已經成為了主流的文本到圖像生成模型,可以基于文本提示的引導,生成高質量且內容豐富的圖像。

但如果輸入的提示過于簡潔,現有的模型在語義理解和常識推理方面都存在局限,導致生成的圖像質量下降明顯。

為了提高模型理解敘述性提示的能力,中山大學HCP實驗室林倞團隊提出了一種簡單而有效的參數高效的微調方法SUR-adapter,即語義理解和推理適配器,可應用于預訓練的擴散模型。

論文地址:https://arxiv.org/abs/2305.05189

開源地址:https://github.com/Qrange-group/SUR-adapter

為了實現該目標,研究人員首先收集并標注了一個數據集SURD,包含超過5.7萬個語義校正的多模態樣本,每個樣本都包含一個簡單的敘述性提示、一個復雜的基于關鍵字的提示和一個高質量的圖像。

然后,研究人員將敘事提示的語義表示與復雜提示對齊,并通過知識蒸餾將大型語言模型(LLM)的知識遷移到SUR適配器,以便能夠獲得強大的語義理解和推理能力來構建高質量的文本語義表征用于文本到圖像生成。

通過集成多個LLM和預訓練擴散模型來進行實驗,結果展現了該方法可以有效地使擴散模型理解和推理簡潔的自然語言描述,并且不會降低圖像質量。

該方法可以使文本到圖像的擴散模型更容易使用,具有更好的用戶體驗,可以進一步推進用戶友好的文本到圖像生成模型的發展,彌補簡單的敘事提示和復雜的基于關鍵字的提示之間的語義差距。

背景介紹

目前,以Stable diffusion為代表的文生圖 (text-to-image)預訓練擴散模型已經成為目前AIGC領域最重要的基礎模型之一,在包括圖像編輯、視頻生成、3D對象生成等任務當中發揮著巨大的作用。

然而目前的這些預訓練擴散模型的語義能力主要依賴于CLIP等文本編碼器 (text encoder),其語義理解能力關系到擴散模型的生成效果。

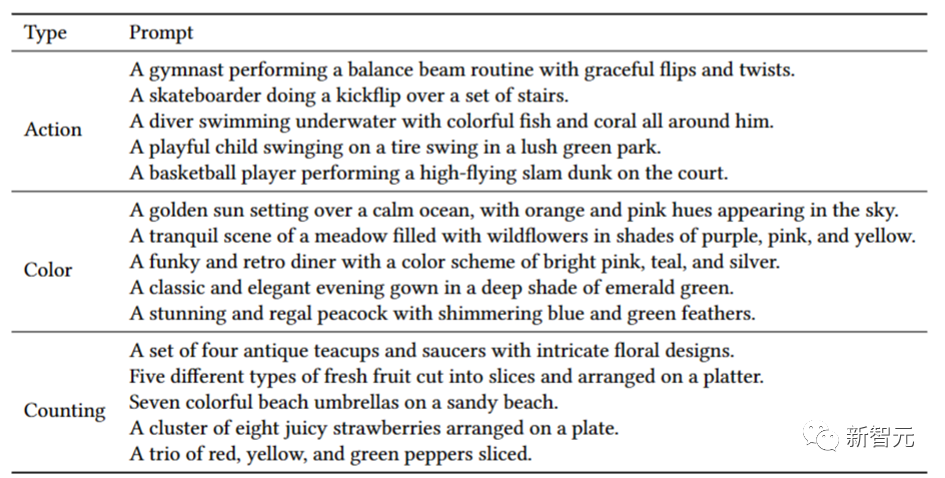

本文首先以視覺問答任務(VQA)中常用問題類別的"Counting (計數)", "Color (顏色)"以及"Action (動作)"構造相應的本文提示來人工統計并測試Stable diffusion的圖文匹配準確度。

下表給出了所構造的各種prompt的例子。

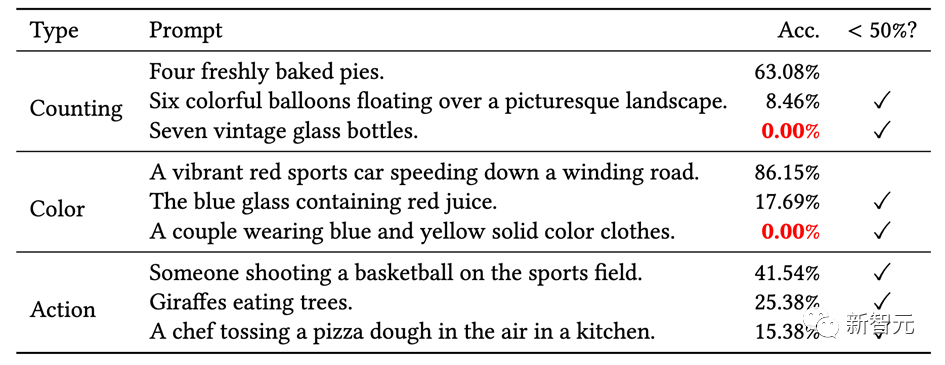

結果如下表所示,文章揭示了目前文生圖預訓練擴散模型有嚴重的語義理解問題,大量問題的圖文匹配準確度不足50%,甚至在一些問題下,準確度只有0%。

因此,需要想辦法增強預訓練擴散模型中本文編碼器的語義能力以獲得符合文本生成條件的圖像。

方法概述

1. 數據準備

首先從常用的擴散模型在線網站lexica.art,civitai.com,stablediffusionweb中大量獲取圖片文本對,并清洗篩選獲得超過57000張高質量 (complex prompt, simple prompt, image) 三元組數據,并構成SURD數據集。

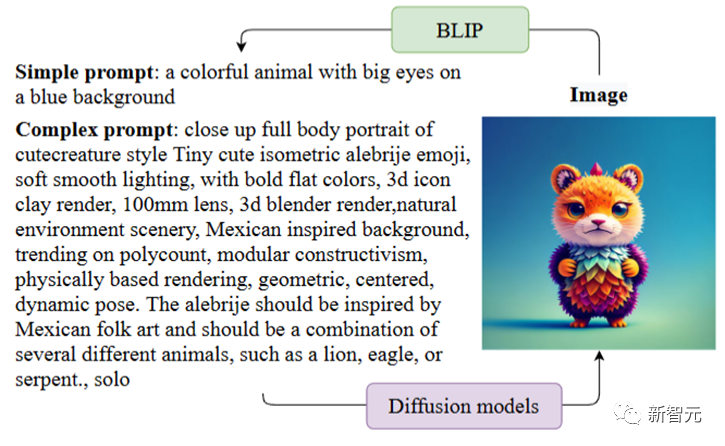

如圖所示,complex prompt是指生成image時擴散模型所需要的文本提示條件,一般這些文本提示帶有復雜的格式和描述。simple prompt是通過BLIP對image生成的文本描述,是一種符合人類描述的語言格式。

一般來說符合正常人類語言描述的simple prompt很難讓擴散模型生成足夠符合語義的圖像,而complex prompt(對此用戶也戲稱之為擴散模型的“咒語”)則可以達到令人滿意的效果。

2. 大語言模型語義蒸餾

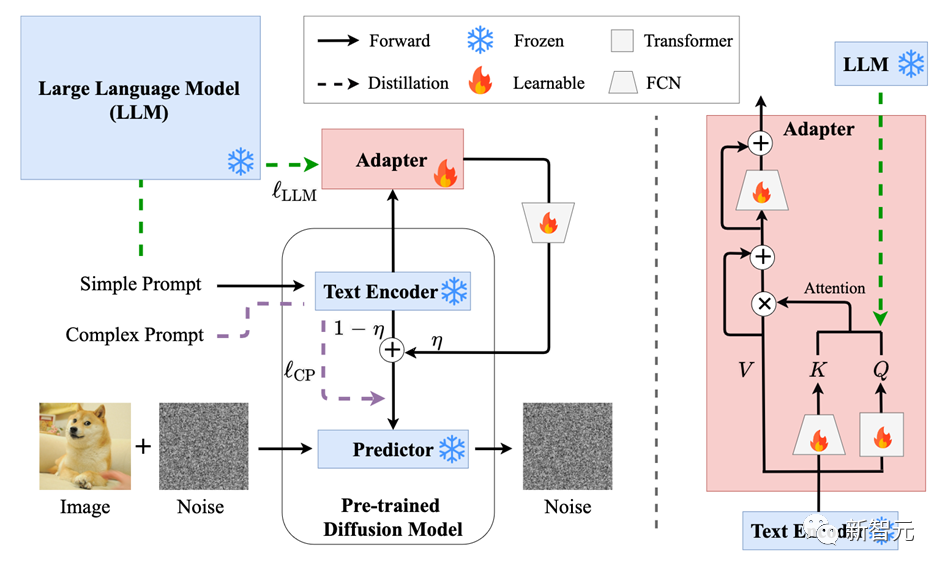

本文引入一個transformer結構的Adapter在特定隱含層中蒸餾大語言模型的語義特征,并將Adapter引導的大語言模型信息和原來文本編碼器輸出的語義特征做線性組合獲得最終的語義特征。

其中大語言模型選用的是不同大小的LLaMA模型。擴散模型的UNet部分在整個訓練過程中的參數都是凍結的。

3. 圖像質量恢復

由于本文結構在預訓練大模型推理過程引入了可學習模塊,一定程度破壞了預訓練模型的原圖生成質量,因此需要將圖像生成的質量拉回原預訓練模型的生成質量水平。

本文利用SURD數據集中的三元組在訓練中引入相應的質量損失函數以恢復圖像生成質量,具體地,本文希望simple prompt通過新模塊后獲得的語義特征可以和complex prompt的語義特征盡可能地對齊。

下圖展示了SUR-adapter對預訓練擴散模型的fine-tuning框架。右側為Adapter的網絡結構。

實驗結果

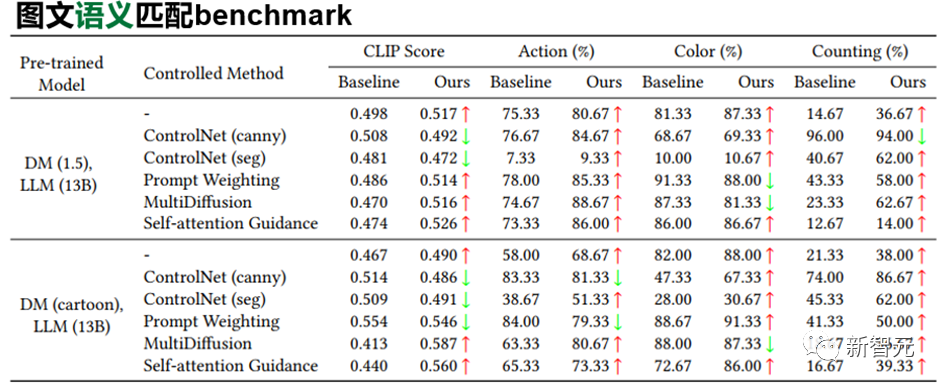

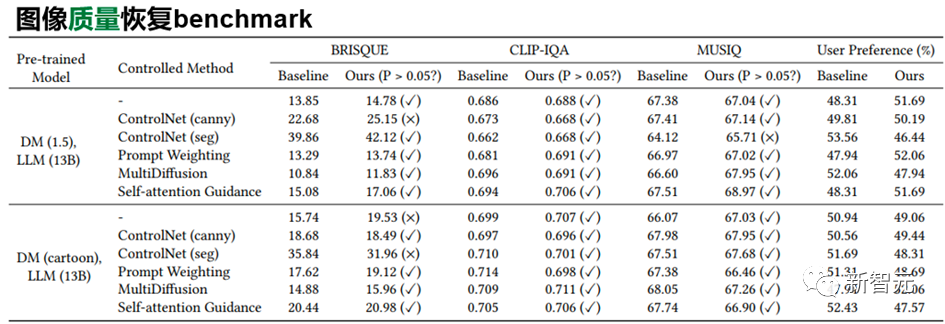

本文從語義匹配和圖像質量兩個角度來看SUR-adapter的性能。

一方面,如下表所示,SUR-adapter可以有效地在不同的實驗設置下緩解了文生圖擴散模型中常見的語義不匹配問題。在不同類別的語義準則下,準確度有一定的提升。

另一方面,本文利用常用的BRISQUE等常用的圖像質量評價指標下,對原始pretrain擴散模型和使用了SUR-adapter后的擴散模型所生成圖片的質量進行統計檢驗,我們可以發現兩者沒有顯著的差異。

同時,我們還對此進行了人類偏好的調查問卷測試。

以上分析說明,所提出的方法可以在保持圖像生成質量的同時,緩解固有的預訓練text-to-image固有的圖文不匹配問題。

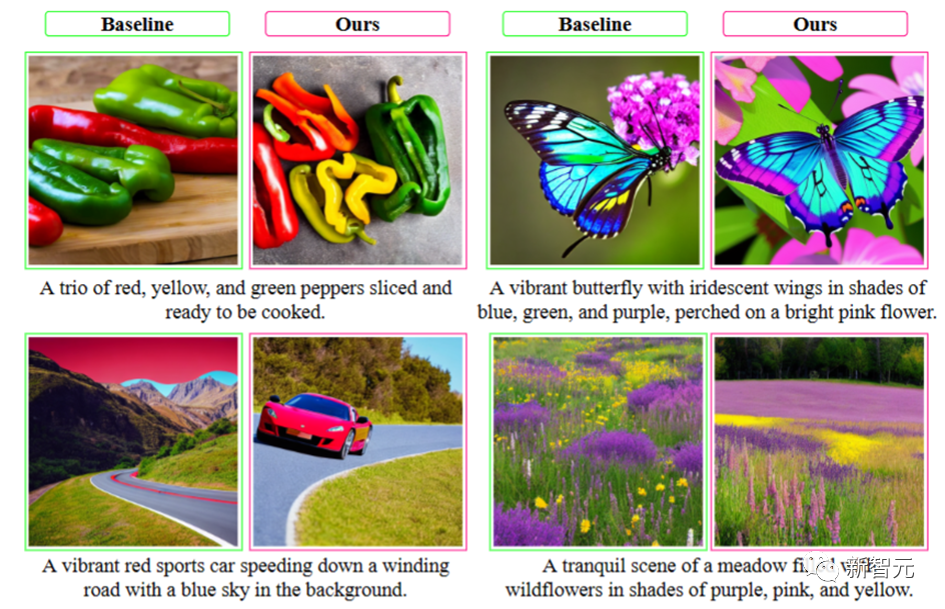

另外我們還可以定性地展示如下圖所示的圖像生成的例子,更詳細的分析和細節請參見本文文章和開源倉庫。

HCP實驗室簡介

中山大學人機物智能融合實驗室 (HCP Lab) 由林倞教授于 2010 年創辦,近年來在多模態內容理解、因果及認知推理、具身智能等方面取得豐富學術成果,數次獲得國內外科技獎項及最佳論文獎,并致力于打造產品級的AI技術及平臺。