你要跳舞么?復旦&微軟提出StableAnimator:可實現高質量和高保真的ID一致性人類視頻生成

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

由復旦、微軟、虎牙、CMU的研究團隊提出的StableAnimator框架,實現了高質量和高保真的ID一致性人類視頻生成。

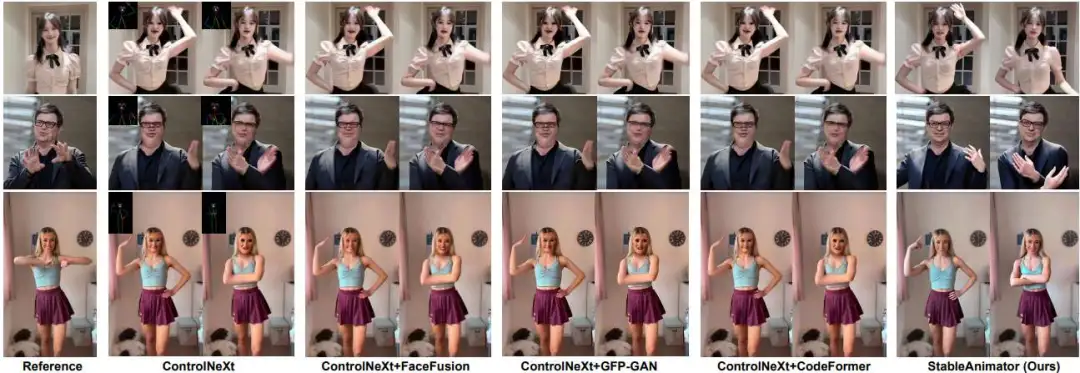

StableAnimator 生成的姿勢驅動的人體圖像動畫展示了其合成高保真和 ID 保留視頻的能力。FaceFusion 是一個換臉工具。GFP-GAN 和 CodeFormer 是人臉恢復模型。ControlNeXt 是最新的開源動畫模型。

StableAnimator 生成的姿勢驅動的人體圖像動畫展示了其合成高保真和 ID 保留視頻的能力。FaceFusion 是一個換臉工具。GFP-GAN 和 CodeFormer 是人臉恢復模型。ControlNeXt 是最新的開源動畫模型。

相關鏈接

- 論文:https://arxiv.org/abs/2411.17697

- 主頁:https://francis-rings.github.io/StableAnimator/

- 代碼:https://github.com/Francis-Rings/StableAnimator

- Demo: https://www.bilibili.com/video/BV1X5zyYUEuD

論文閱讀

StableAnimator:高質量且可保留身份的人體圖像動畫

StableAnimator:高質量且可保留身份的人體圖像動畫

論文介紹

當前用于人體圖像動畫的擴散模型難以確保身份 (ID) 一致性。論文介紹了 StableAnimator,這是第一個端到端 ID 保留視頻擴散框架,它以參考圖像和一系列姿勢為條件,無需任何后期處理即可合成高質量視頻。基于視頻擴散模型,StableAnimator 包含精心設計的模塊,用于訓練和推理,力求實現身份一致性。

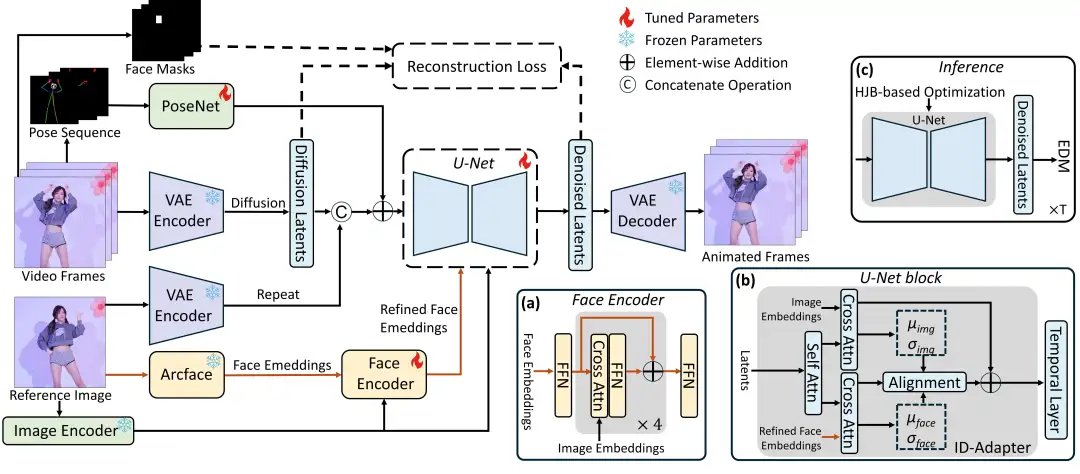

具體而言,StableAnimator 首先分別使用現成的提取器計算圖像和人臉嵌入,然后通過使用全局內容感知人臉編碼器與圖像嵌入交互來進一步細化人臉嵌入。然后,StableAnimator 引入了一種新穎的分布感知 ID 適配器,可防止時間層造成的干擾,同時通過對齊保留 ID。在推理過程中,

論文提出了一種基于 Hamilton-Jacobi-Bellman (HJB) 方程的新型優化,以進一步提高人臉質量。論文證明了求解 HJB 方程可以集成到擴散去噪過程中,并且得到的解可以限制去噪路徑,從而有利于 ID 保存。在多個基準測試上的實驗從定性和定量兩個方面證明了 StableAnimator 的有效性。

方法介紹

StableAnimator 基于先前研究而來的常用 SVD。參考圖像通過擴散模型通過三種途徑進行處理:

StableAnimator 基于先前研究而來的常用 SVD。參考圖像通過擴散模型通過三種途徑進行處理:

- 由凍結的 VAE 編碼器轉換為潛在代碼。潛在代碼被復制以匹配視頻幀,然后與主潛在代碼連接。

- 由 CLIP 圖像編碼器編碼以獲得圖像嵌入,這些嵌入分別被饋送到去噪 U-Net 的每個交叉注意力塊和我們的人臉編碼器,以調節合成的外觀。

- 輸入到 Arcface 以獲得人臉嵌入,隨后通過我們的人臉編碼器對其進行細化以進一步對齊。然后將細化的人臉嵌入輸入到去噪 U-Net。

具有與 AnimateAnyone 類似架構的 PoseNet 提取姿勢序列的特征,然后將其添加到噪聲潛在代碼中。在推理過程中用隨機噪聲替換原始輸入視頻幀,而其他輸入保持不變。論文提出了一種基于 HJB 方程的新型人臉優化方法,以提高 ID 一致性并消除對第三方后處理工具的依賴。它將 HJB 方程的求解過程集成到去噪中,從而實現最佳梯度方向以實現較高的 ID 一致性。

結果展示

與最先進方法的定性比較。

與最先進方法的定性比較。

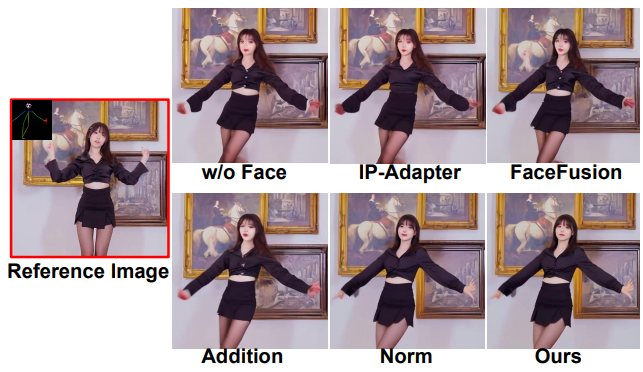

面部增強策略的消融研究。

結論

StableAnimator是一種視頻擴散模型,具有專用的訓練和推理模塊,可生成高質量、保留 ID 的人體圖像動畫。StableAnimator 首先使用現成的模型來獲取圖像和人臉嵌入。為了捕捉參考的全局上下文,StableAnimator 引入了 8 個人臉編碼器來細化人臉嵌入。StableAnimator 進一步設計了一個 ID 適配器,它應用對齊來減輕時間建模的干擾,實現無縫人臉嵌入集成而不會造成視頻保真度損失。在推理過程中,為了進一步提高人臉質量,StableAnimator 將 HJB 方程與擴散去噪結合起來進行人臉優化。它與去噪并行運行,創建了一個端到端管道,從而無需第三方換臉工具。跨各種數據集的實驗結果證明了該模型在生成高質量保留 ID 的人體動畫方面的優勢。