重磅!Meta開源“次世代”大模型 Llama 2,扎克伯格:免費可商用!

今日凌晨,就在我們還在睡夢中時,大洋彼岸的Meta干了一件大事:發布免費可商用版本Llama 2。

圖片

圖片

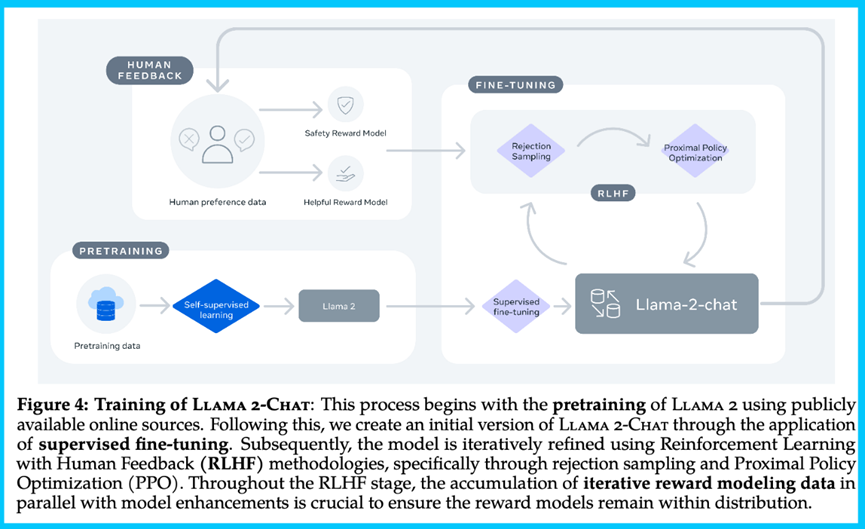

Llama 2 是Llama 1大模型的延續,在數據質量、訓練技術、能力評估、安全訓練和負責任的發布方面有實質性的技術進步。

在研究共享意愿歷史最低,監管困境歷史最高點的當今AI時代,Meta這一步無疑為大模型生態系統帶來了重大進展。

從技術報告上看,Llama 2的基礎模型比GPT3更強,而微調后聊天模型則能ChatGPT匹敵。相信后續Llama 2將幫助企業實現更多的定制化和降低成本的產品。

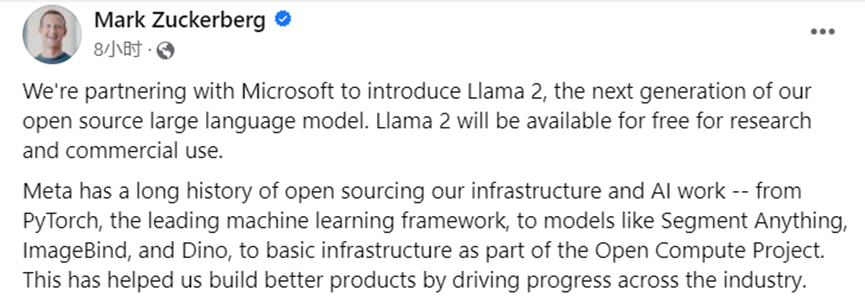

以下是扎克伯格在Facebook上發布的關于Llama 2的“宣言”,更是將其稱之為大模型的次世代的產品:

我們正在與微軟合作,推出Llama 2,這是我們開源大語言模型的下一代產品。Llama 2將免費提供給研究者和商業使用者。

Meta一直投身于開源事業,從領先的機器學習框架PyTorch,到像Segment Anything,ImageBind和Dino這樣的模型,再到作為Open Compute Project部分的AI基礎設施。我們一直在推進整個行業的進步,構建更好的產品。

開源推動了創新,因為它讓更多的開發者能夠使用新技術。同時,軟件開源,意味著更多的人可以審查它,識別并修復可能的問題,從而提高了安全性。我相信如果生態系統更加開放,將會釋放更多的進步,這就是我們為什么要開源Llama 2。

今天,我們發布了預訓練和微調的模型Llama 2,參數分別為70億,130億和700億。Llama 2比Llama 1預訓練的數據多40%,并對其架構進行了改進。對于微調模型,我們收集了超百萬的人類注釋樣本,并應用了有監督的微調和RLHF,在安全性和質量方面是領先的。

你可以直接下載這些模型,或者通過Azure以及微軟的安全和內容工具訪問這些模型。我們還提供一個優化版本,支持Windows本地運行。

我非常期待看到你們的創新成果!

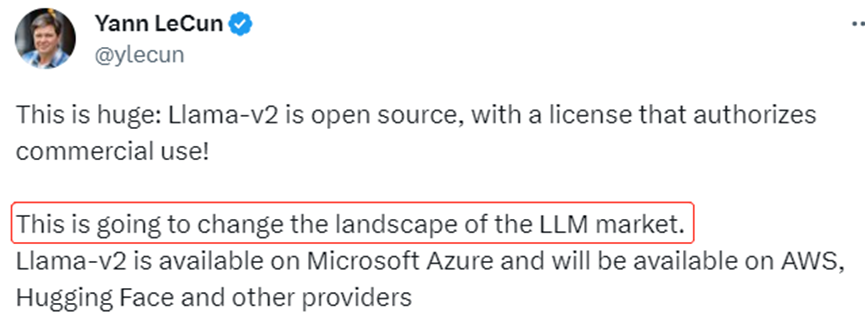

對于Llama 2的出現和發布,深度學習三巨頭之一的Yann LeCun表示,這將改變大模型的市場格局。

圖片

圖片

有網友很快就向Meta發送了申請,并在幾個小時內獲得了許可,已經在應用了:

圖片

圖片

OpenLLM大模型排行榜對Llama 2 進行了關于“Eleuther AI Language Model Evaluation Harness” 中的4個關鍵基準的評估:

圖片

圖片

其中,Llama-2-70b獲得了平均分、科學問題ARC、常識推理HellaSwag等指標的第一名;文本多任務準確性MMLU指標被基于Llama-30B 的微調模型Platypus-30B超過;生成問題答案真實性TruthfulQA (MC)指標位列第8名。

圖片

圖片

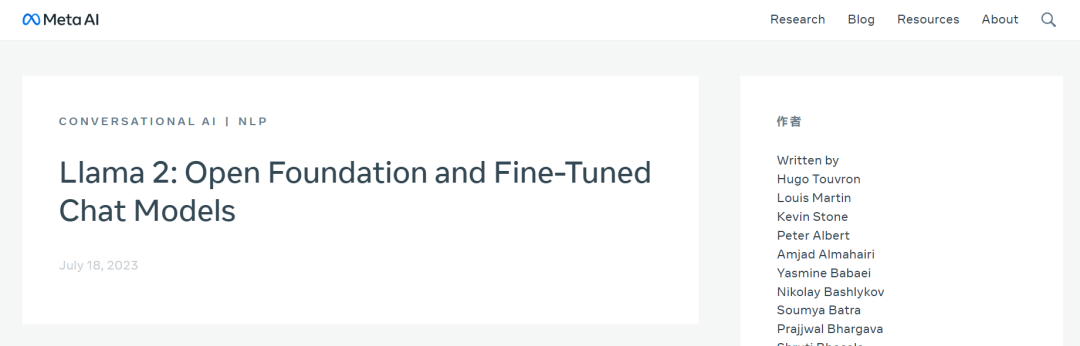

論文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

項目地址:

https://github.com/facebookresearch/llama

Llama 2的一些關鍵點aw的優勢在哪?

Meta發布了多個模型,包括7億,13億,34億,70億參數的Llama基礎模型,以及同等規模的Llama變體。Meta將預訓練語料庫的大小增加了40%,將模型的上下文長度增加了一倍,并采用了分組查詢注意力機制(grouped-query attention)。

具體而言,有以下幾個關鍵點:

能力:廣泛測試后,在非編碼方面,確定這是第一個能達到ChatGPT水平的開源模型。

代碼/數學/推理:論文中關于代碼數據的討論較少,但有一個模型在某些評價中超越了其他模型。

多輪一致性:采用了新的方法,Ghost Attention (GAtt),以改善模型的多輪對話一致性。

獎勵模型:為避免安全性和有用性的權衡,采用了兩個獎勵模型。

RLHF過程:采用了兩階段的RLHF方法,強調了RLHF對模型寫作能力的重要影響。

安全性/傷害評估:進行了詳盡的安全評估,并采用了特定的方法以增強模型的安全性。

許可證:模型可供商業使用,但有一定的用戶數量限制,也即日活大于7億的產品需要單獨申請商用權限。

Llama 2的技術細節

Huggingface科學家Nathan Lambert在一篇博客也對Llama 2的技術報告進行了解析。

圖片

圖片

這個模型(Llama 2)與原始的Llama在結構上相似,主要的改變在于數據和訓練過程,以及增加了上下文長度和分組查詢注意力(GQA),且在聊天功能的應用性和推理速度方面有所提高。

訓練語料庫來自公開資源,不包含Meta的產品或服務的數據。模型在2萬億個數據標記(Token)上訓練,以提高性能并減少錯誤,并盡力刪除含有大量私人信息的數據。

論文大部分關于評估和微調,而非創建基礎模型。

論文接著遵循RLHF流程,訓練一個獎勵模型并使用強化學習(RL)進行優化。

圖片

圖片

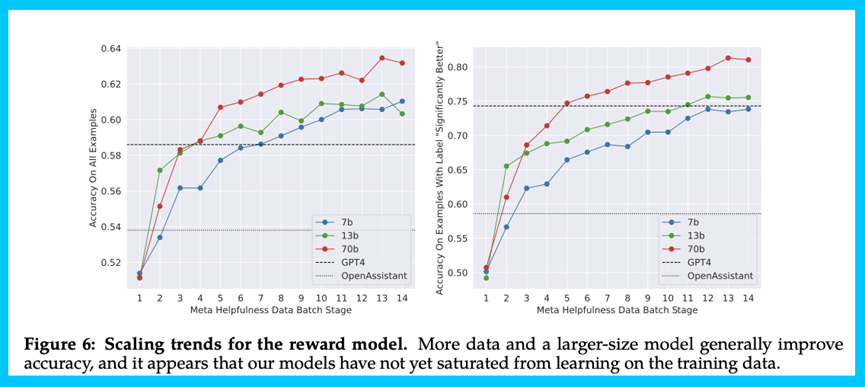

此外,技術報告也證實了一點,獎勵模型是RLHF的關鍵,也是模型的關鍵。為了得到一個好的獎勵模型,Meta收集了大量偏好數據,這些數據遠遠超過了開源社區正在使用的數據。

Meta收集二元對比數據,而非其他更復雜類型的反饋。這類似于1-8的Likert量表,但更側重于質性評價如“顯著優于、優于、稍優于或差不多/不確定”。

他們使用多輪次偏好,模型的響應來自不同的模型訓練階段;Meta的關注點更在于有用性和安全性,而不是誠實度(honesty),在每個數據供應商的數據收集階段使用不同的指令。

此外,在數據收集過程中,團隊添加了額外的安全元數據,顯示每一輪模型的哪些響應是安全的。在建模階段,他們排除了所有“選擇的響應不安全而其他響應安全”的例子,因為他們認為更安全的響應會更受人類喜歡。

獎勵模型

研究人員訓練了兩個獎勵模型,一個專注于有益性,另一個專注于安全性。這些模型基于語言模型構建,用線性回歸層替換了原模型頭部。他們始終使用最新的聊天模型,目的是為了減少在RLHF訓練中的分布不匹配。

一些關鍵的技術細節包括:

- 起始獎勵模型基于開源數據訓練,并用于生成早期供應商數據。

- 他們保留了一些Anthropic的無害數據(占他們自己的90%),但沒有給出具體原因。

- 他們只訓練一個epoch,防止獎勵模型過擬合。

- 獎勵模型的平均準確率在65-70%范圍內,但在"顯著不同"的標簽上,準確率達到80-90%。

其他有趣的發現:

- 在獎勵模型的損失函數中添加了一個margin項(與偏好的置信度成比例),以提高有益性。

- 隨著模型的訓練和改進,數據對模型輸出的一致性評價越來越高

- 訓練的獎勵模型在評估中表現優于使用GPT-4生成的獎勵模型提示。

圖片

圖片

圖表顯示,獎勵模型的準確性隨著時間的推移有所提高。值得注意的是,盡管OpenAssistant獎勵模型可能沒有得到高度認可,但是GPT-4作為獎勵模型的性能表現為其他模型提供了基準。

Meta在討論微調結果時提到,獎勵模型的準確性是Llama 2-Chat性能的關鍵指標。這符合人們對RLHF會充分利用獎勵模型知識的理解。

RLHF和微調

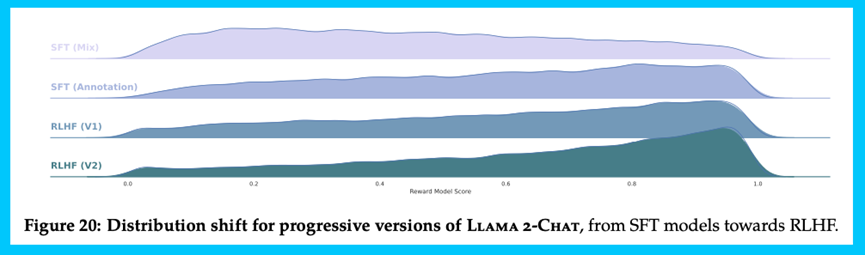

Meta通過使用RLHF方法來提升模型性能,如下圖所示使用最優秀的獎勵模型來評估各種模型,以此展示RLHF如何將生成的文本推向更高的獎勵。Meta迭代訓練了5個RLHF版本,每個版本的數據分布都有所改進。

圖片

圖片

Meta指出,第三方的SFT(有監督微調)數據多樣性和質量往往不足以滿足對話式指令的LLM對齊需求。Meta通過篩選第三方數據集中的高質量示例,顯著提高了結果。他們也強調了注釋數據的數量對于再現性的重要性。

Meta觀察到,不同的注釋平臺和供應商可能會導致模型性能的顯著差異,因此在使用供應商獲取注釋時,數據檢查仍然非常重要。他們的做法是通過對比人類注釋和模型生成的樣本來驗證數據質量。

在數據質量確立之后,Meta開始關注強化學習(RL)部分。他們發現,即使有熟練的注釋員,每個人的寫作風格也會有很大的差異。一個在SFT注釋上進行微調的模型會學習這種多樣性,但同時也會學習到一些糟糕的注釋。他們指出,模型的性能是由技巧最好的注釋者的寫作能力來限制的。

Meta確實承認,這個過程需要大量的計算和注釋資源。在整個RLHF階段,獎勵建模數據對于模型改進至關重要。

結論是,有效的RLHF需要一個中等大小的團隊。雖然一個1-3人的團隊可以發布一個好的指令模型,但實行RLHF可能需要至少6-10人。這個數字會隨著時間的推移而減小,但這種類型的工作需要與外部公司簽訂合同和保持緊密的聯系,這總是會耗費一些時間。

此外,Meta對比了方法間的基本差異以及它們的使用時機:

- 拒絕抽樣(RS)進行更廣泛的搜索(每個提示生成更多的數據),而PPO則對獎勵模型進行更多的更新。

- 最終方法之間的差異并不顯著(與WebGPT的發現相似)。

- 在RLHFV4中,僅使用了拒絕抽樣,然后在最后一步中使用PPO和拒絕抽樣進行微調(在一些評估中,PPO有輕微的優勢)。

評估

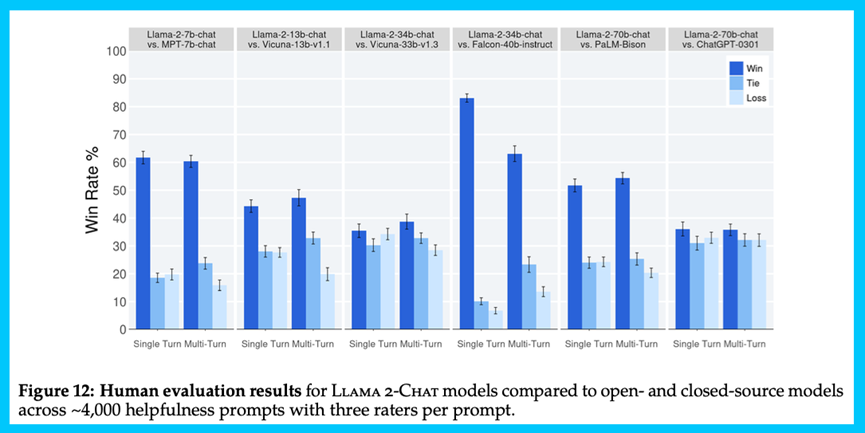

論文以多種方式評估他們的模型。在自動化基準測試中,例如Open LLM Leaderboard(MMLU,ARC等)的首字母縮略詞,Llama 2在所有規模上都比其他任何開源模型要好得多。

模型在諸如MMLU這樣的不那么顯眼的基準測試中也得分更高,這是因為他們的大量數據工作和RLHF的調整。然而,他們的模型在與閉源模型的比較中并未表現出色。

此外,論文還深入研究了當前流行的評估技術,人類注釋者和LLM-as-a-judge由于其普遍性和可用性而受到歡迎。盡管人類評估可能受到一些限制和主觀性的影響,但結果顯示了Meta在開源領域的主導地位。

圖片

圖片

他們采用了模型作為評判的技術,并用Elo圖展示了RLHF這個隨時間變化的概念,這與Anthropic的AI工作類似。在性能上,他們的模型在RLHFv3之后超過了ChatGPT,這可以在圖中看到PPO方法提供了一定的提升:

這篇論文進行了多項評估以展示其一般性能力,包括建立獎勵模型。獎勵模型的測試亮點:

- 調整獎勵模型分數以適應人類評價者的偏好評估,盡管誤差范圍較大。

- 與在開源數據集上訓練的獎勵模型進行比較,以展示開源領域的可能實現。

人類/模型評估的亮點:

- 在ChatGPT和Llama-2-Chat的輸出上評估模型,避免模型因風格偏好而提高自身結果。

- 利用評價者間可靠性度量,如Gwet的AC1/2,這些統計工具為此項工作專門設計。

- 承認人類評估的限制,包括大型評估提示集未覆蓋所有實際應用,缺少對編碼/推理的評估,只評估最后的對話輪次。

最后,附上Llama 2 的在線測試地址:

https://huggingface.co/spaces/ysharma/Explore_llamav2_with_TGI?cnotallow=749dd0fc30bb1d0718aaa9576af51980

參考文獻

https://twitter.com/i/status/1681354211328507917

https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

https://www.interconnects.ai/p/llama-2-from-meta?utm_source=profile&utm_medium=reader2