由點(diǎn)到面:可泛化的流形對(duì)抗攻擊,從個(gè)體對(duì)抗到流形對(duì)抗

聲稱(chēng)準(zhǔn)確率 99% 的人臉識(shí)別系統(tǒng)真的牢不可破嗎?事實(shí)上,在人臉照片上做一些不影響視覺(jué)判斷的改變就可以輕松攻破人臉識(shí)別系統(tǒng),例如讓鄰家女孩和男明星被判斷成同一個(gè)人,這便是對(duì)抗攻擊。對(duì)抗攻擊的目標(biāo)是尋找自然的且能夠讓神經(jīng)網(wǎng)絡(luò)混淆的對(duì)抗樣本,從本質(zhì)上講,找到對(duì)抗樣本也就是找到了神經(jīng)網(wǎng)絡(luò)的脆弱之處。

近日,來(lái)自東方理工的研究團(tuán)隊(duì)提出了一種廣義流形對(duì)抗攻擊的范式(Generalized Manifold Adversarial Attack, GMAA),將傳統(tǒng)的 “點(diǎn)” 攻擊模式推廣為 “面” 攻擊模式,極大提高了對(duì)抗攻擊模型的泛化能力,為對(duì)抗攻擊的工作展開(kāi)了一個(gè)新的思路。

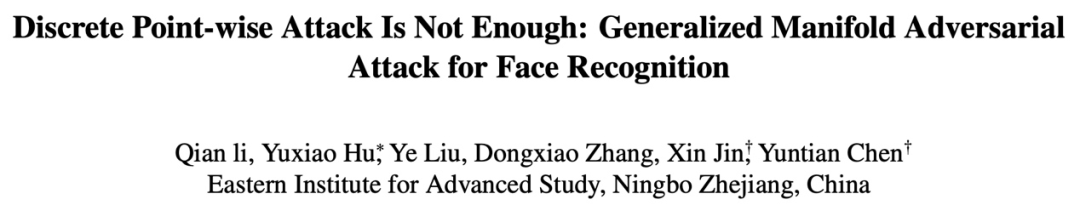

該研究從目標(biāo)域和對(duì)抗域兩個(gè)方面對(duì)先前的工作做了改進(jìn)。在目標(biāo)域上,該研究通過(guò)攻擊目標(biāo)身份的狀態(tài)集合找到高泛化的更強(qiáng)大的對(duì)抗樣本。對(duì)于對(duì)抗域,先前的工作都是在尋找離散的對(duì)抗樣本,即找到了系統(tǒng)的幾個(gè) “漏洞”(點(diǎn)),而該研究則在尋找連續(xù)的對(duì)抗流形,即要找到神經(jīng)網(wǎng)絡(luò)脆弱的整片 “區(qū)域”(面)。此外,該研究引入表情編輯的領(lǐng)域知識(shí),提出了基于表情狀態(tài)空間實(shí)例化的新范式。通過(guò)對(duì)生成的對(duì)抗流形連續(xù)采樣可以獲得表情連續(xù)變化的高泛化性對(duì)抗樣本,相比于化妝、光照、添加擾動(dòng)等手段,表情狀態(tài)空間更加普適自然,不受性別、光照的影響。研究論文已被 CVPR 2023 接收。

論文鏈接:https://arxiv.org/abs/2301.06083

代碼鏈接 https://github.com/tokaka22/GMAA

方法介紹

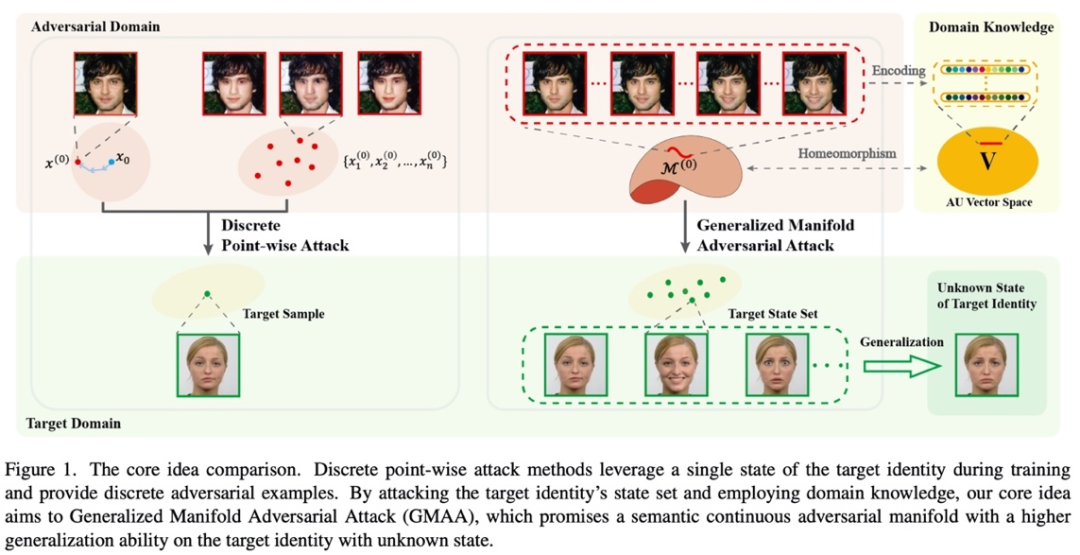

在目標(biāo)域部分,先前的工作都是針對(duì)目標(biāo)身份 A 的某一張?zhí)囟ǖ恼掌ピO(shè)計(jì)對(duì)抗樣本。但是如圖 2 所示,當(dāng)用這種攻擊方式生成的對(duì)抗樣本去攻擊 A 的另一張照片時(shí),攻擊效果會(huì)大幅下降。面對(duì)此類(lèi)攻擊,定期更換人臉識(shí)別庫(kù)中的照片自然是一種有效的防御措施。但是,該研究提出的 GMAA 不僅針對(duì)目標(biāo)身份的單個(gè)樣本進(jìn)行訓(xùn)練,而且尋找能攻擊目標(biāo)身份狀態(tài)集合的對(duì)抗樣本,這樣的高泛化性的對(duì)抗樣本面對(duì)更新后的人臉識(shí)別庫(kù)具備更好的攻擊性能。這些更強(qiáng)大的對(duì)抗樣本也對(duì)應(yīng)著神經(jīng)網(wǎng)絡(luò)更為薄弱之處,值得深入探索。

在對(duì)抗域部分,先前的工作都是尋找離散的一個(gè)或幾個(gè)對(duì)抗樣本,這相當(dāng)于在高維空間中找到了神經(jīng)網(wǎng)絡(luò)脆弱的一個(gè)或幾個(gè) “點(diǎn)”,而該研究認(rèn)為,神經(jīng)網(wǎng)絡(luò)可能在一整個(gè) “面” 上都是脆弱的,應(yīng)該將這個(gè) “面” 上的對(duì)抗樣本 “一網(wǎng)打盡”。因此,該研究致力于尋找高維空間中的對(duì)抗流形。

綜上,GMAA 是一種用對(duì)抗流形去攻擊目標(biāo)身份的狀態(tài)集合的新攻擊范式。

文章的核心思想如圖 1 所示。

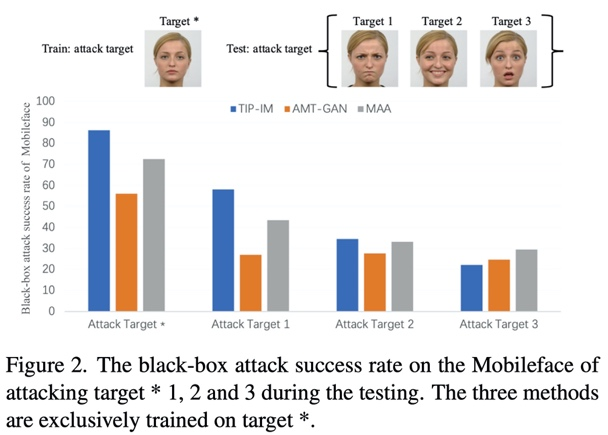

具體來(lái)說(shuō),該研究引入表情編輯的領(lǐng)域知識(shí) Facial Action Coding System (FACS),用表情狀態(tài)空間來(lái)實(shí)例化所提出的新攻擊范式。FACS 是一種面部表情編碼系統(tǒng),它將面部分為不同的肌肉單元,其中 AU 向量中的每個(gè)元素都對(duì)應(yīng)了一個(gè)肌肉單元,向量元素值的大小表示了對(duì)應(yīng)單元的肌肉活躍程度,從而編碼表情狀態(tài)。例如下圖中,AU 向量中的第一個(gè)元素 AU1 表示了提起內(nèi)側(cè)眉毛的程度。

來(lái)自《面部表情解剖學(xué)》

對(duì)于目標(biāo)域,該研究攻擊含有多種表情狀態(tài)的目標(biāo)集合,從而實(shí)現(xiàn)對(duì)未知的目標(biāo)照片也有較好的攻擊性能;對(duì)于對(duì)抗域,該研究建立與 AU 空間一一對(duì)應(yīng)的對(duì)抗流形,可以用改變 AU 值的方式,在對(duì)抗流形上采樣對(duì)抗樣本,連續(xù)地改變 AU 值,就可以生成表情連續(xù)變化的對(duì)抗樣本。?

值得注意的是,該研究采用表情狀態(tài)空間來(lái)實(shí)例化 GMAA 攻擊范式。這是因?yàn)楸砬槭侨嗣娌炕顒?dòng)中最常見(jiàn)的一種狀態(tài),而且表情狀態(tài)空間相對(duì)穩(wěn)定,不會(huì)受到人種、性別的影響(光照可改變膚色、化妝則會(huì)影響性別)。事實(shí)上,只要能找到其他合適的狀態(tài)空間,該攻擊范式就完全可以被推廣應(yīng)用于自然界的其他對(duì)抗攻擊任務(wù)中。

模型結(jié)果

下面的動(dòng)圖展示了該研究的可視化結(jié)果。動(dòng)圖的每一幀都是在對(duì)抗流形上采樣得到的對(duì)抗樣本,連續(xù)地采樣就可以獲得表情連續(xù)改變的一系列對(duì)抗樣本(左側(cè)),紅色的數(shù)值表示當(dāng)前幀的對(duì)抗樣本與目標(biāo)樣本(右側(cè))在 Face++ 人臉識(shí)別系統(tǒng)下的相似度。

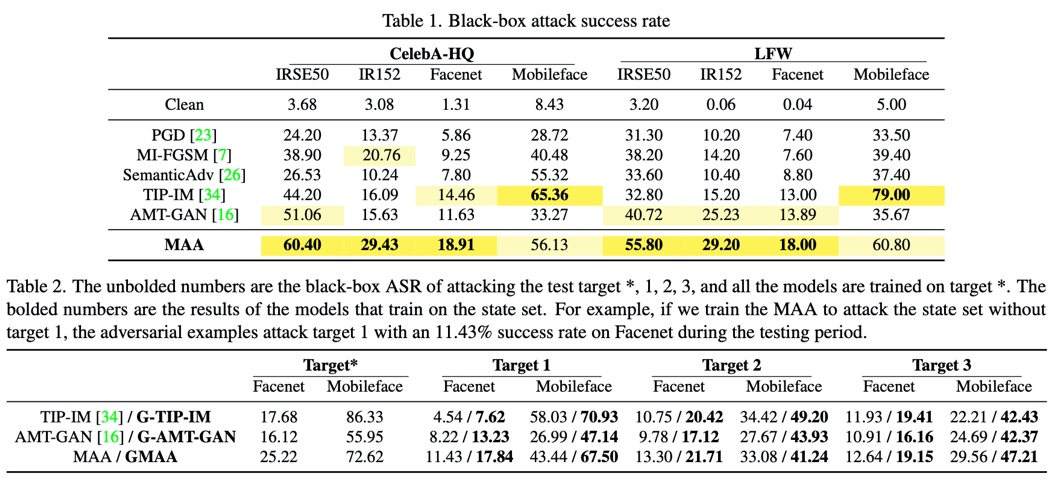

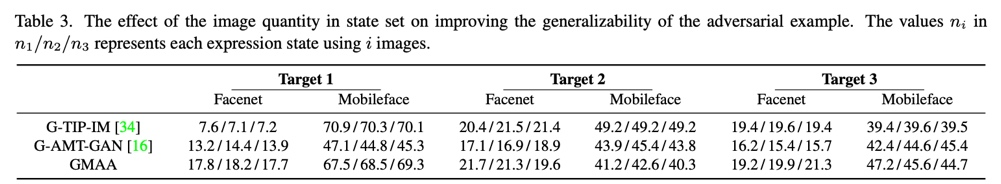

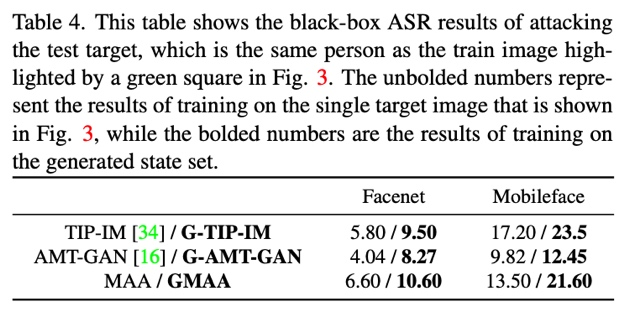

在表 1 中,研究列出了 4 個(gè)人臉識(shí)別模型在兩個(gè)數(shù)據(jù)集上的黑盒攻擊成功率,其中,MAA是GMAA的縮減版,MAA僅在對(duì)抗域上將點(diǎn)攻擊的模式推廣到了流形攻擊,目標(biāo)域上依然是對(duì)單個(gè)目標(biāo)照片進(jìn)行攻擊。攻擊目標(biāo)的狀態(tài)集合是一種通用的實(shí)驗(yàn)設(shè)置,文章在表2中為包括MAA在內(nèi)的三種方法加上了這種設(shè)置(表中加粗的部分是加上這種設(shè)置的結(jié)果,在方法的名稱(chēng)前加上了“G”以示區(qū)分),驗(yàn)證了目標(biāo)域的擴(kuò)充可以提升對(duì)抗樣本的泛化性。

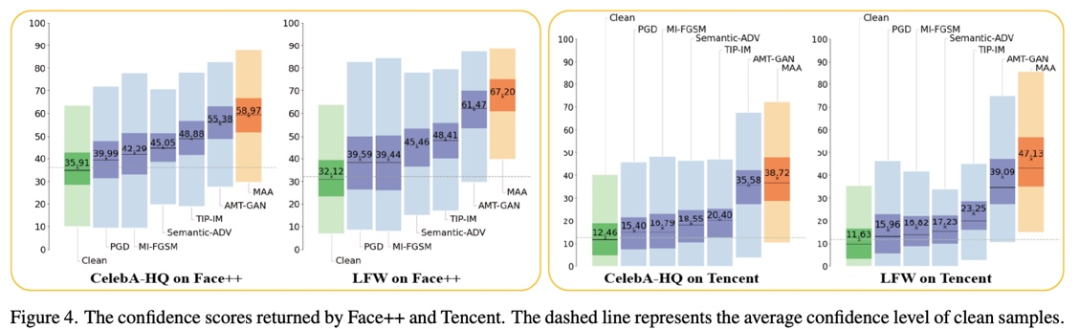

圖 4 展示了攻擊兩個(gè)商業(yè)人臉識(shí)別系統(tǒng) API 的結(jié)果。

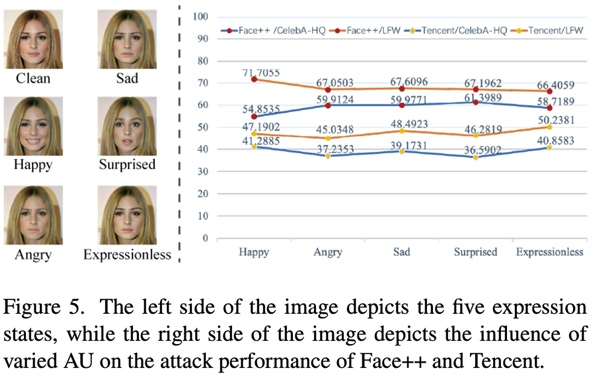

該研究還探討了不同的表情對(duì)攻擊性能的影響,以及狀態(tài)集合中含有樣本的數(shù)量對(duì)攻擊泛化性能的影響。

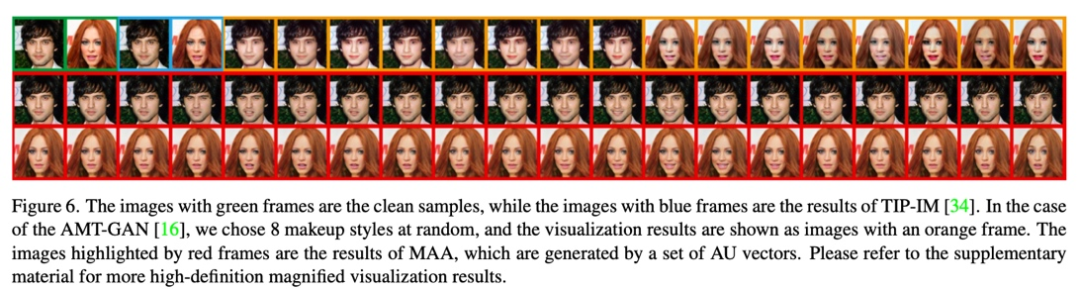

圖 6 展示了不同方法的可視化結(jié)果對(duì)比,MAA 在對(duì)抗流形上采樣了 20 個(gè)對(duì)抗樣本,可以看到可視化效果更加的自然。

當(dāng)然,并不是所有的數(shù)據(jù)集都有一個(gè)身份的不同狀態(tài)的圖片,對(duì)于這種情況怎么做目標(biāo)域的擴(kuò)充呢?該研究也給出了一個(gè)可行的解決方案,即用 AU 向量和表情編輯模型生成目標(biāo)狀態(tài)集合,文章也呈現(xiàn)了攻擊合成的目標(biāo)狀態(tài)集合的結(jié)果,可以發(fā)現(xiàn)泛化性能也有一定提升。

原理方法

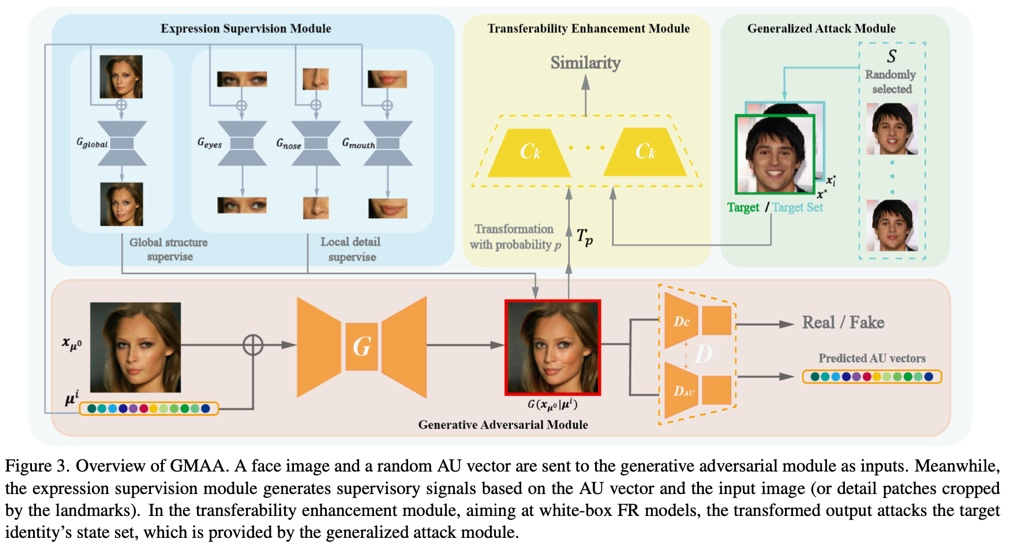

模型的主干包含了基于 WGAN-GP 的生成模塊、表情監(jiān)督模塊、可轉(zhuǎn)移性增強(qiáng)模塊、廣義攻擊模塊。其中,廣義攻擊模塊實(shí)現(xiàn)了攻擊目標(biāo)狀態(tài)集合的功能,可轉(zhuǎn)移性增強(qiáng)模塊來(lái)自于先前的工作,為了公平對(duì)比,所有的 baseline 都加上了這一模塊。表情監(jiān)督模塊由 4 個(gè)訓(xùn)練好的表情編輯器構(gòu)成,通過(guò)全局結(jié)構(gòu)監(jiān)督和局部細(xì)節(jié)監(jiān)督來(lái)實(shí)現(xiàn)對(duì)抗樣本的表情變換。

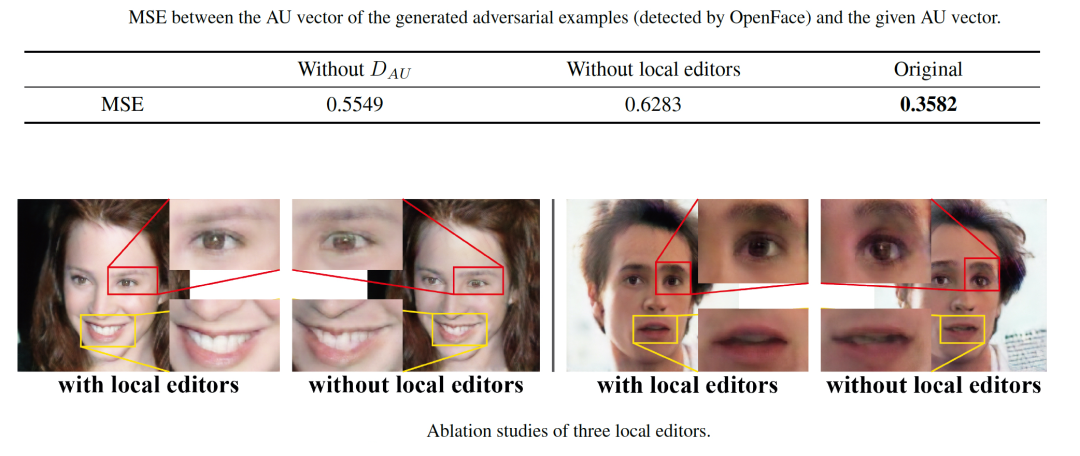

對(duì)于表情監(jiān)督模塊,論文的支持材料中給出了相應(yīng)的消融實(shí)驗(yàn),驗(yàn)證了局部細(xì)節(jié)監(jiān)督可以減少生成圖片的偽影和模糊,有效地提高對(duì)抗樣本的視覺(jué)質(zhì)量,同時(shí)可以提高對(duì)抗樣本的表情合成準(zhǔn)確性。

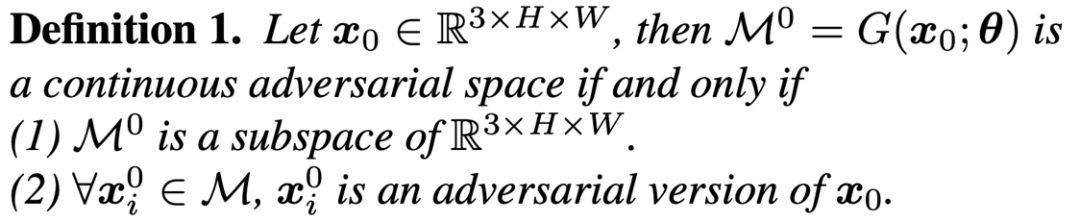

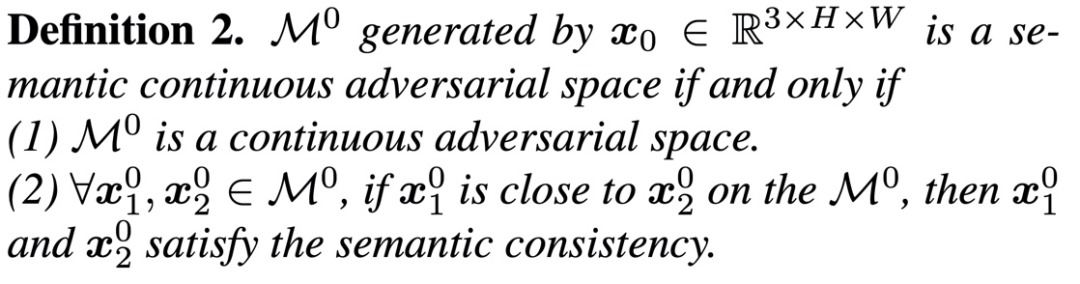

此外,論文定義了連續(xù)對(duì)抗流形和語(yǔ)義連續(xù)對(duì)抗流形的概念,并詳細(xì)證明了生成的對(duì)抗流形與 AU 向量空間同胚。

總結(jié)

綜上所述,該研究提出了一種新的名為 GMAA 的攻擊范式,同時(shí)擴(kuò)展了目標(biāo)域和對(duì)抗域,提高了攻擊的性能。對(duì)于目標(biāo)域,GMAA 通過(guò)攻擊狀態(tài)集合而不是單張圖像來(lái)提升對(duì)目標(biāo)身份的泛化能力。此外,GMAA 將對(duì)抗域從離散點(diǎn)擴(kuò)展到語(yǔ)義連續(xù)的對(duì)抗流形(“由點(diǎn)到面”)。該研究通過(guò)引入表情編輯的領(lǐng)域知識(shí)實(shí)例化了 GMAA 攻擊范式。大量的對(duì)比實(shí)驗(yàn)證明,GMAA 具有比其他競(jìng)爭(zhēng)模型更好的攻擊性能和更自然的視覺(jué)質(zhì)量。