從BERT到ChatGPT,北航等9大頂尖研究機構全面綜述:那些年一起追過的「預訓練基礎模型」

?ChatGPT在few-shot和zero-shot場景下展現出的驚人性能,讓研究人員們更堅定「預訓練」是一條正確的路線。

預訓練基礎模型(Pretrained Foundation Models, PFM)被認為是不同數據模式下各種下游任務的基礎,即基于大規模數據,對 BERT、 GPT-3、 MAE、 DALLE-E 和 ChatGPT 等預訓練基礎模型進行訓練,為下游應用提供了合理的參數初始化。

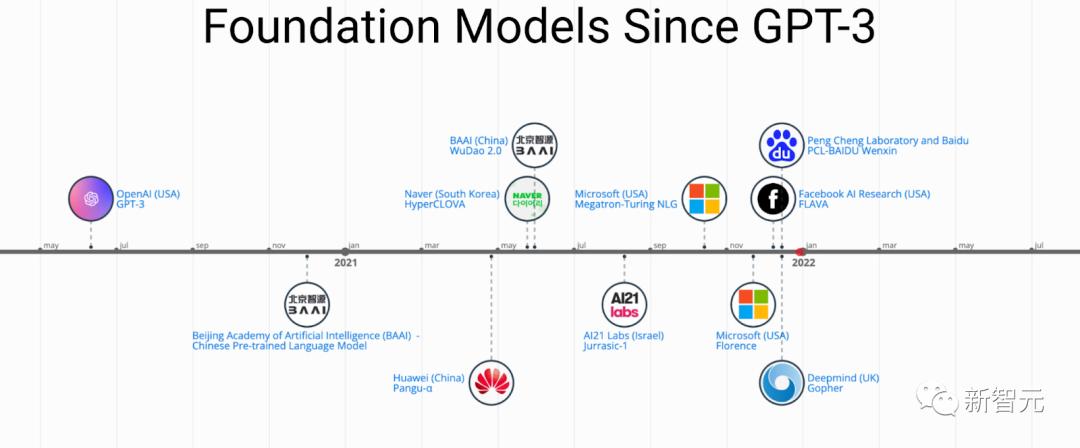

PFM 背后的預訓練思想在大型模型的應用中起著重要作用,與以往采用卷積和遞歸模塊進行特征提取的方法不同,生成預訓練(GPT)方法采用 Transformer 作為特征提取器,在大型數據集上進行自回歸訓練。

隨著 PFM 在各個領域獲得巨大成功,近幾年發表的論文中提出了大量的方法、數據集和評價指標,行業內需要一篇從BERT開始一直追蹤到ChatGPT發展過程的全面綜述。

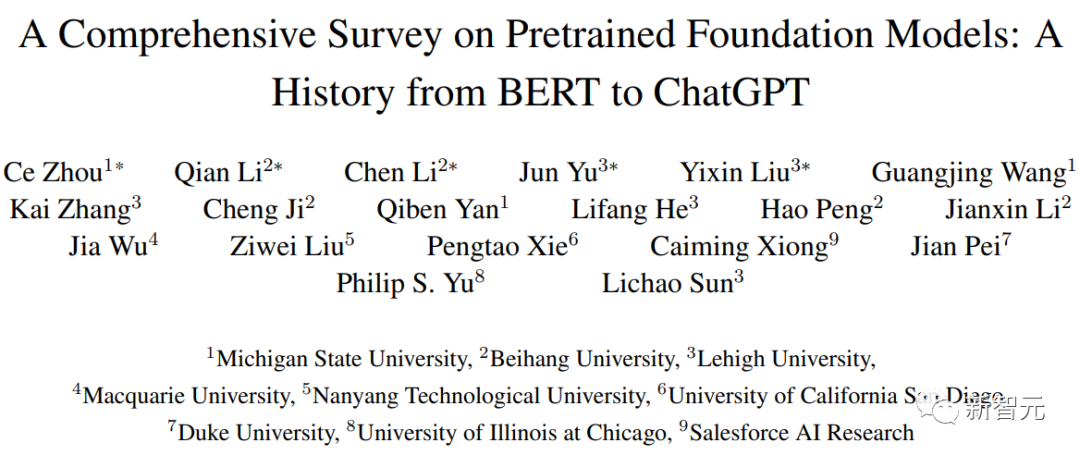

最近,來自北航、密歇根州立大學、理海大學、南洋理工、杜克等國內外多所知名院校、企業的研究人員聯合寫了一篇關于預訓練基礎模型的綜述,提供了在文本、圖像和圖(graph)等領域的最近的研究進展,以及目前和未來的挑戰、機遇。

論文鏈接:https://arxiv.org/pdf/2302.09419.pdf

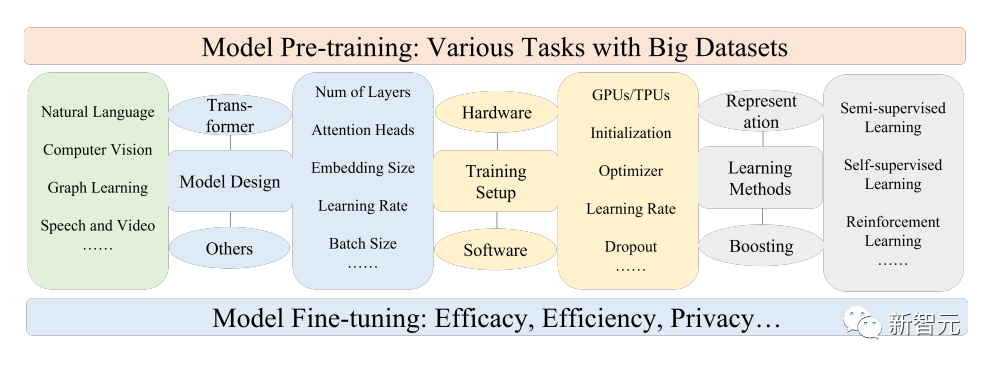

研究人員首先回顧了自然語言處理、計算機視覺和圖形學習的基本組成部分和現有的預訓練;然后討論了其他先進的 PFM 的其他數據模式和統一的 PFM 考慮數據質量和數量;以及PFM 基本原理的相關研究,包括模型效率和壓縮、安全性和隱私性;最后,文中列出了幾個關鍵的結論,包括未來的研究方向、挑戰和開放的問題。

從BERT到ChatGPT

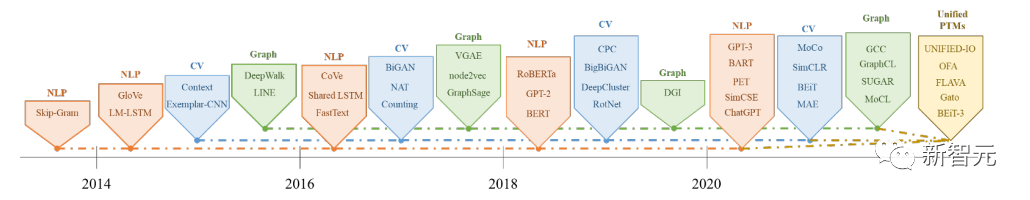

預訓練基礎模型(PFMs)是大數據時代構建人工智能系統的重要組成部分,其在自然語言處理(NLP)、計算機視覺(CV)和圖學習(GL)三大人工智能領域得到廣泛的研究和應用。

PFMs是通用模型,在各個領域內或跨領域任務中都很有效,在各種學習任務中學習特征表示方面表現出巨大的潛力,如文本分類、文本生成、圖像分類、物體檢測和圖分類等。

PFMs在用大規模語料庫訓練多個任務并對類似的小規模任務進行微調方面表現出卓越的性能,使得啟動快速數據處理成為可能。

PFMs和預訓練

PFMs是基于預訓練技術的,其目的是利用大量的數據和任務來訓練一個通用模型,在不同的下游應用中可以很容易地進行微調。

預訓練的想法起源于CV任務中的遷移學習,在認識到預訓練在CV領域的有效性后,人們開始使用預訓練技術來提高其他領域的模型性能。當把預訓練技術應用于NLP領域時,經過良好訓練的語言模型(LMs)可以捕捉到對下游任務有益的豐富知識,如長期依賴關系、層次關系等。

此外,預訓練在NLP領域的顯著優勢是,訓練數據可以來自任何未標記的文本語料庫,也就是說,在預訓練過程中存在著無限量的訓練數據。

早期的預訓練是一種靜態方法,如NNLM和Word2vec,很難適應不同的語義環境;后來有研究人員提出了動態預訓練技術,如BERT、XLNet等。

PFMs在NLP、CV和GL領域的歷史和演變

基于預訓練技術的PFMs使用大型語料庫來學習通用語義表征,隨著這些開創性工作的引入,各種PFMs已經出現,并被應用于下游的任務和應用。

一個顯著的PFM應用案例就是最近爆火的ChatGPT。

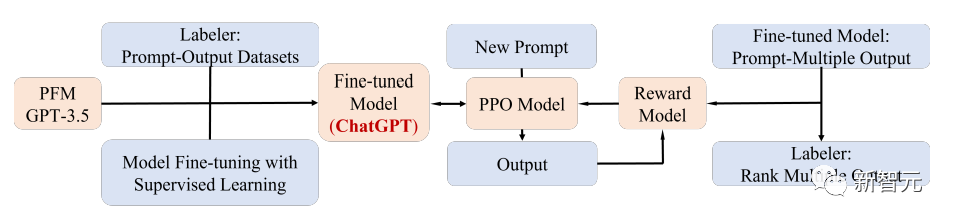

ChatGPT是從生成式預訓練Transformer,即GPT-3.5在文本和代碼的混合語料訓練后,再微調得到的;ChatGPT使用了來自人類反饋的強化學習(RLHF)技術,也是目前將大型LM與人類的意圖相匹配的一種最有前景的方法。

ChatGPT的優越性能可能會導致每一類PFMs的訓練范式轉變的臨界點,即應用指令對齊(instruction aligning)技術,包括強化學習(RL)、prompt tuning和思維鏈(chain-of-thought),并最終走向通用人工智能。

這篇文章中,研究人員主要回顧了文本、圖像和圖(graph)相關的PFM,也是一個相對成熟的研究分類方法。

對于文本來說,語言模型通過預測下一個單詞或字符即可實現多種任務,例如,PFMs可用于機器翻譯、問題回答系統、主題建模、情感分析等。

對于圖像來說,類似于文本中的PFMs,使用大規模的數據集來訓練一個適合多個CV任務的大模型。

對于圖來說,相似的預訓練思路也被用于獲得PFMs,可用于諸多下游任務。

除了針對特定數據域的PFMs,文中還回顧并闡述了其他一些先進的PFMs,如針對語音、視頻和跨域數據的PFMs,以及多模態PFMs。

此外,一個能夠處理多模態的PFMs的大融合趨勢正在出現,也就是所謂的統一(unified)PFMs;研究人員首先定義了統一PFMs的概念,然后回顧了近期研究中最先進的統一PFMs,包括OFA、UNIFIED-IO、FLAVA、BEiT-3等。

根據這三個領域現有的PFMs的特點,研究人員得出結論,PFMs有以下兩大優勢:

1. 只需要進行極少的微調就可以提高模型在下游任務上的表現;

2. PFMs已經在質量方面通過了考驗。

與其從頭開始建立一個模型來解決類似的問題,更好的選擇是將PFMs應用于與任務相關的數據集。

PFMs的巨大前景激發了大量的相關工作來關注模型的效率、安全性和壓縮等問題。

這篇綜述的特點在于:

- 研究人員跟蹤了最新的研究成果,對PFM在NLP、CV和GL中的發展進行了扎實的總結,討論并提供了關于這三個主要應用領域中通用的PFM設計和預訓練方法的思考結果。

- 總結了PFMs在其他多媒體領域的發展,如語音和視頻,還進一步討論了關于PFMs的更深層次的話題,包括統一的PFMs、模型效率和壓縮,以及安全和隱私。

- 通過對各種模態下不同任務的PFMs的回顧,討論了在大數據時代對超大型模型未來研究的主要挑戰和機遇,將引導開發新一代基于PFMs的協作和交互智能。

參考資料:?https://arxiv.org/abs/2302.09419