CLIP不接地氣?你需要一個更懂中文的模型

本文介紹的是達摩院魔搭社區 ModelScope 近期開源的中文 CLIP 大規模預訓練圖文表征模型,更加懂中文和中文互聯網的圖像,在圖文檢索、零樣本圖片分類等多個任務中實現最優效果,同時代碼和模型已經全部開源,用戶能夠使用魔搭快速上手。

- 模型使用入口: https://modelscope.cn/models/damo/multi-modal_clip-vit-base-patch16_zh/summary

- Github: https://github.com/OFA-Sys/Chinese-CLIP

- 論文: https://arxiv.org/pdf/2211.01335.pdf

- 圖文檢索 demo: https://modelscope.cn/studios/damo/chinese_clip_applications/summary

1. 簡介

在當下的互聯網生態中,多模態相關任務和場景簡直數不勝數,如圖文檢索、圖片分類、視頻和圖文內容等場景。近年火爆全網的圖片生成更是熱度躥升,迅速出圈。這些任務的背后,一個強大的圖文理解模型顯然是必須的。OpenAI 在 2021 年推出的 CLIP 模型,相信大家都不會陌生,通過簡單的圖文雙塔對比學習和大量的圖文語料,使模型具有了顯著的圖文特征對齊能力,在零樣本圖像分類、跨模態檢索中效果拔群,也被作為 DALLE2、Stable Diffusion 等圖片生成模型的關鍵模塊。

但很可惜的是,OpenAI CLIP 的預訓練主要使用英文世界的圖文數據,不能天然支持中文。即便是社區有研究者通過翻譯的文本,蒸餾出多語言版本的 Multilingual-CLIP (mCLIP),同樣無法很好滿足中文世界的需求,對于中文領域的文本理解不很到位,比如搜索“春節對聯”,返回的卻是圣誕相關的內容:

mCLIP 檢索 demo 搜索 “春節對聯” 返回結果

這也說明,我們需要一個更懂中文的 CLIP,不僅懂我們的語言,也更懂中文世界的圖像。

2. 方法

達摩院的研究人員收集了大規模的中文圖文對數據(約 2 億規模),其中包括來自 LAION-5B 中文子集、Wukong 的中文數據、以及來自 COCO、Visual Genome 的翻譯圖文數據等。訓練圖文絕大部分來自公開數據集,大大降低了復現難度。而在訓練方法上,為了有效提升模型的訓練效率和模型效果,研究人員則設計了兩階段訓練的流程:

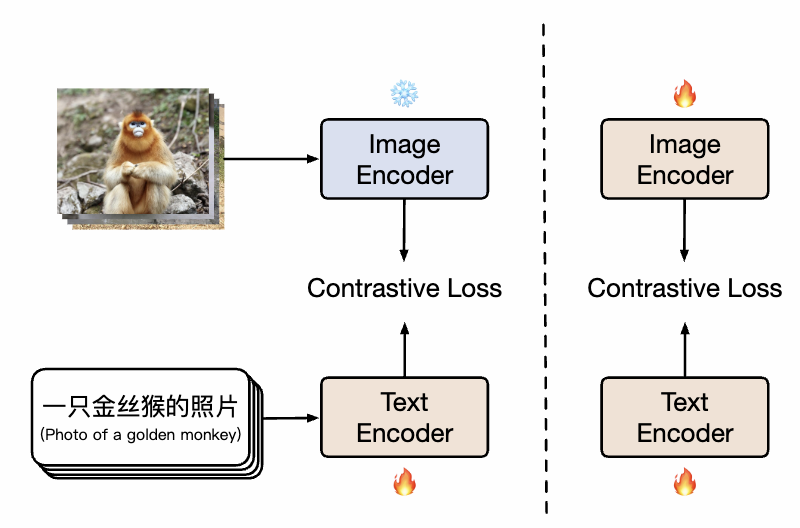

Chinese CLIP 方法示意圖

如圖所示,在第一階段,模型使用已有的圖像預訓練模型和文本預訓練模型分別初始化 Chinese-CLIP 的雙塔,并凍結圖像側參數,讓語言模型關聯上已有的圖像預訓練表示空間,同時減小訓練開銷。隨后,在第二階段解凍圖像側參數,讓圖像模型和語言模型關聯的同時并建模中文特色的數據分布。研究者發現,相比從頭開始做預訓練,該方法在多個下游任務上均展現顯著更優的實驗效果,而其顯著更高的收斂效率也意味著更小的訓練開銷。相比全程只訓練文本側做一階段訓練,加入第二階段訓練能有效在圖文下游任務,尤其是中文原生(而非翻譯自英文數據集)的圖文任務上進一步提升效果。

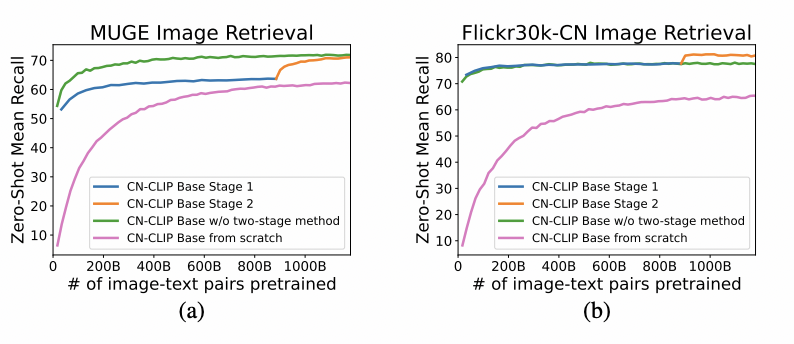

在 MUGE 中文電商圖文檢索、Flickr30K-CN 翻譯版本通用圖文檢索兩個數據集上觀察 zero-shot 隨著預訓練持續進行的效果變化趨勢

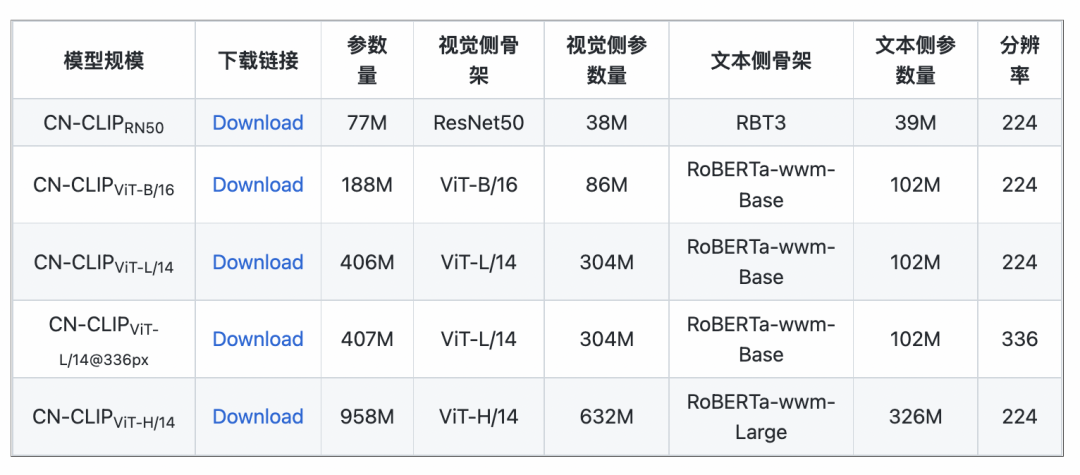

利用這一策略,研究人員訓練了多個規模的模型,從最小的 ResNet-50、ViT-Base 和 Large,直到 ViT-Huge 應有盡有,目前已經全部開放,用戶完全可以按需使用最適合自身場景的模型:

3. 實驗

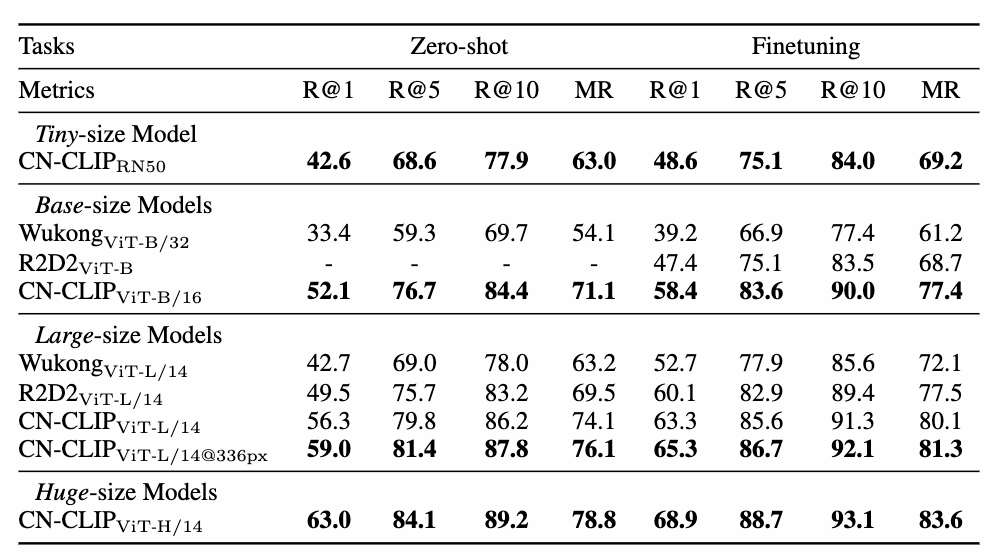

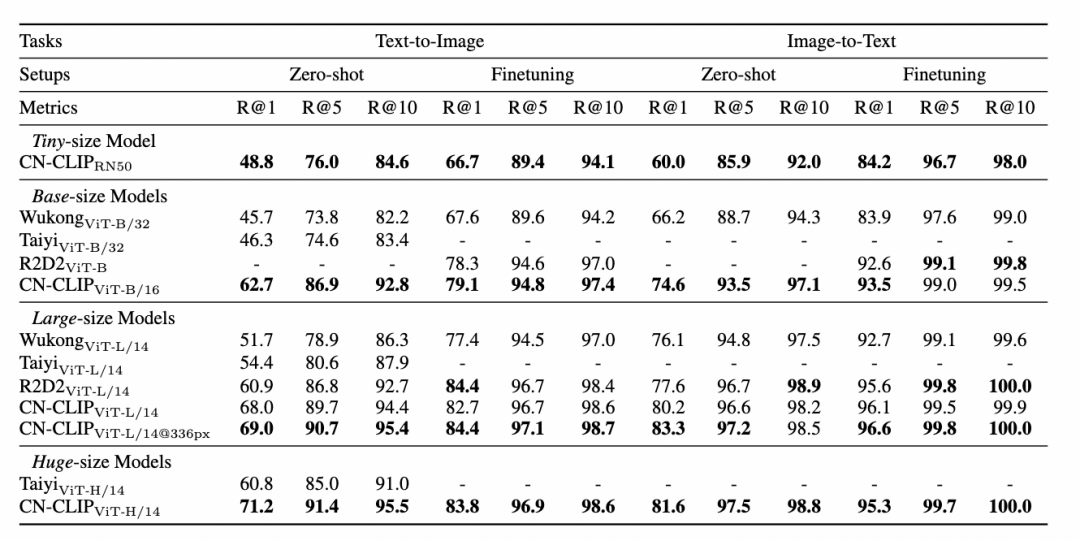

多項實驗數據表明,Chinese-CLIP 可以在中文跨模態檢索取得最優表現,其中在中文原生的電商圖像檢索數據集 MUGE 上,多個規模的 Chinese CLIP 均取得該規模的最優表現。而在英文原生的 Flickr30K-CN 等數據集上,不論是零樣本還是微調的設定下,Chinese CLIP 均能顯著地超出國內 Wukong、Taiyi、R2D2 等基線模型。這在很大程度上歸功于 Chinese-CLIP 更大規模的中文預訓練圖文語料,以及 Chinese-CLIP 不同于國內現有一些圖文表征模型為了最小化訓練成本全程凍結圖像側,而是采用兩階段的訓練策略的做法,以更好適配中文領域:

MUGE 中文電商圖文檢索數據集實驗結果

Flickr30K-CN 中文圖文檢索數據集實驗結果

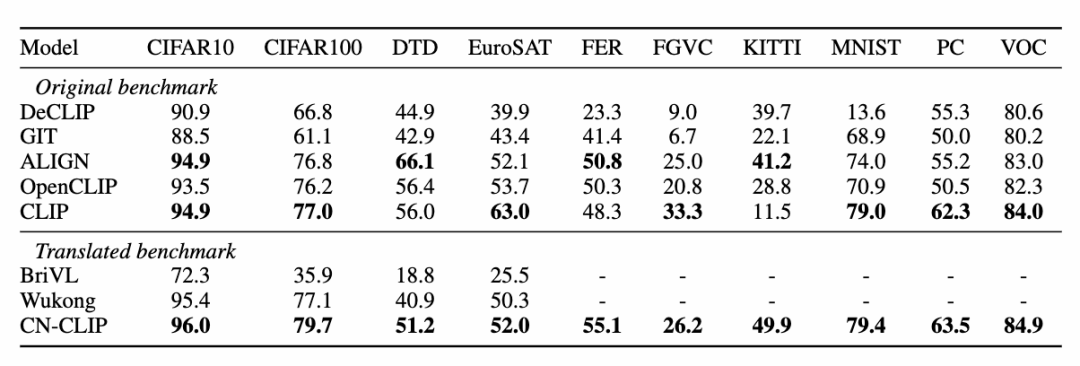

同時,研究人員在零樣本圖像分類數據集上驗證了中文 CLIP 的效果。由于中文領域比較權威的零樣本圖像分類任務并不多,研究人員目前在英文翻譯版本的數據集上進行了測試。Chinese-CLIP 在這些任務上,通過中文的 prompt 和類別標簽,能夠取得和 CLIP 相當的表現:

零樣本分類實驗結果

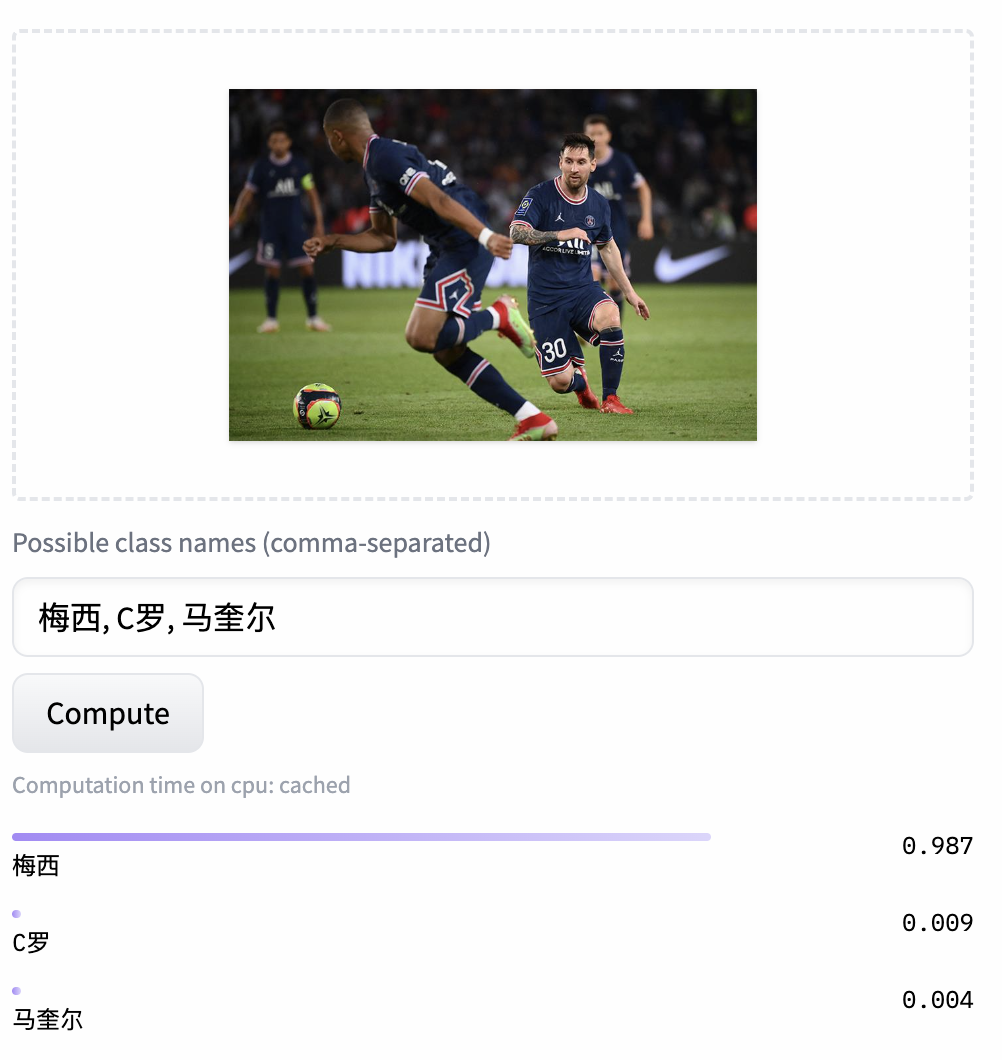

零樣本圖片分類示例

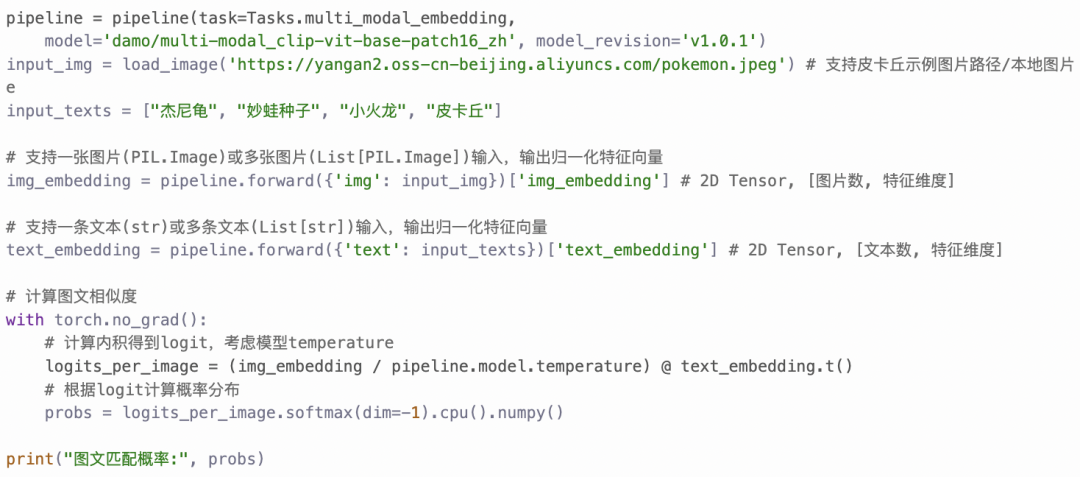

4.快速使用

如何才能用上 Chinese-CLIP ?很簡單,點擊文章開頭的鏈接訪問魔搭社區或使用開源代碼,短短幾行就能完成圖文特征提取和相似度計算了。如需快速使用和體驗,魔搭社區提供了配置好環境的 Notebook,點擊右上方即可使用。

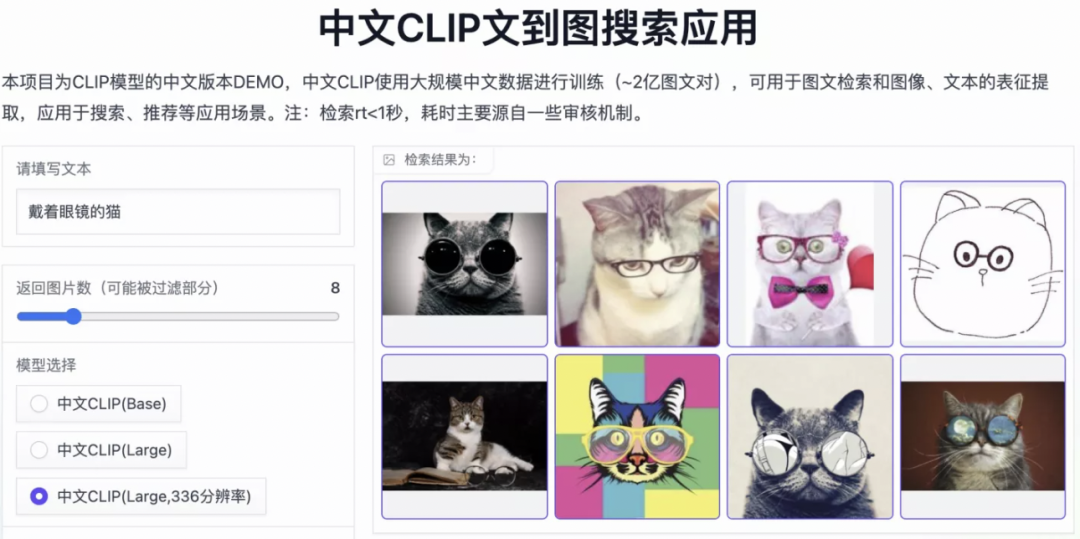

Chinese-CLIP 也支持用戶使用自己的數據進行 finetune,同時還提供了一個圖文檢索的 demo,供大家實際體驗 Chinese-CLIP 各規模模型的效果:

5. 結語

此次達魔搭社區推出 Chinese-CLIP 項目,為廣大中文多模態研究和產業界用戶,提供了一個優秀的預訓練圖文理解模型,幫助大家無門檻快速上手圖文特征 & 相似度計算、圖文檢索以及零樣本分類,并可嘗試用于搭建像是圖像生成這樣更復雜的多模態應用。想要在中文多模態領域一展拳腳的朋友們,請一定不要錯過!而這也僅僅是魔搭社區的一項應用之一,ModelScope 讓眾多 AI 領域的基礎模型扮演應用基座的角色,支持更多創新模型、應用甚至產品的誕生。