大腦里也有個Transformer!和「海馬體」機制相同

我不能創(chuàng)造的,我也不理解 ——費曼

想要創(chuàng)造人工智能,首先要理解人類的大腦因何有智能。

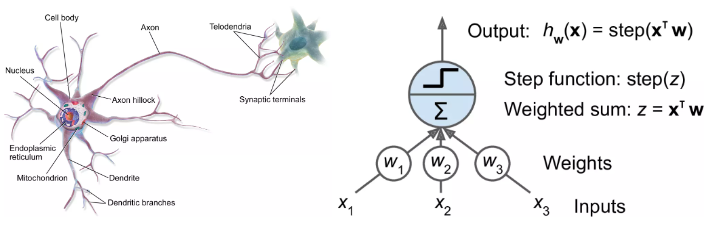

隨著神經(jīng)網(wǎng)絡(luò)的誕生及后續(xù)的輝煌發(fā)展,研究者們一直在為神經(jīng)網(wǎng)絡(luò)尋找生物學(xué)上的解釋,生物學(xué)上的進展也在啟發(fā)AI研究人員開發(fā)新模型。

但人工智能領(lǐng)域的研究人員其實還有一個更遠大的追求:利用AI模型來幫助理解大腦。

最近有研究發(fā)現(xiàn),雖然時下最流行的Transformer模型是在完全沒有生物學(xué)知識輔助的情況下開發(fā)出來的,但其架構(gòu)卻和人腦海馬結(jié)構(gòu)極其相似。

論文鏈接:https://arxiv.org/pdf/2112.04035.pdf

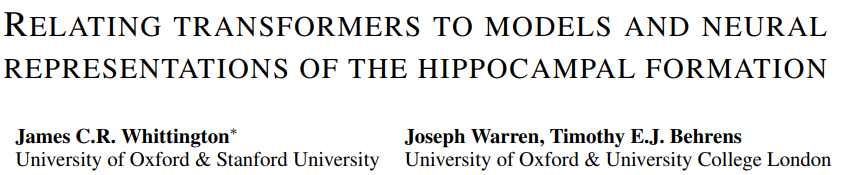

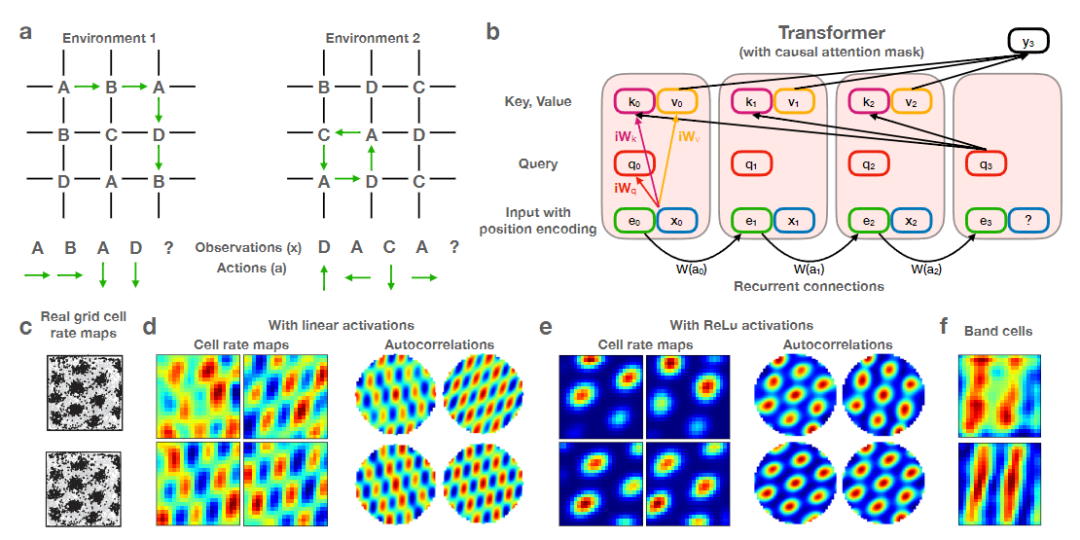

研究人員給Transformer配備了遞歸位置編碼后,發(fā)現(xiàn)模型可以精確復(fù)制海馬結(jié)構(gòu)(hippocampal formation)的空間表征。

不過作者也表示,對于這一結(jié)果并不驚訝,因為Transformer與目前神經(jīng)科學(xué)中的海馬體模型密切相關(guān),最明顯的就是位置細胞(place cell)和網(wǎng)格細胞(grid cell)。

而且通過實驗發(fā)現(xiàn),Transformer模型相比神經(jīng)科學(xué)版本提供的模型來說有巨大的性能提升。

這項工作將人工神經(jīng)網(wǎng)絡(luò)和大腦網(wǎng)絡(luò)的計算結(jié)合起來,對海馬體和大腦皮層之間的相互作用提供了新的理解,并暗示了皮層區(qū)域如何執(zhí)行超出目前神經(jīng)科學(xué)模型的更廣泛的復(fù)雜任務(wù),如語言理解。

Transformer仿真海馬體?

人類想要了解自己的大腦仍然困難重重,比如研究大腦如何組織和訪問空間信息來解決「我們在哪里,拐角處有什么以及如何到達那里」仍然是一項艱巨的挑戰(zhàn)。

整個過程可能涉及到從數(shù)百億個神經(jīng)元中調(diào)用整個記憶網(wǎng)絡(luò)和存儲的空間數(shù)據(jù),每個神經(jīng)元都連接到數(shù)千個其他神經(jīng)元。

雖然神經(jīng)科學(xué)家已經(jīng)確定了幾個關(guān)鍵元素,例如網(wǎng)格細胞、映射位置的神經(jīng)元,但如何進行更深入的研究仍然是未知的:研究人員無法移除和研究人類灰質(zhì)切片來觀察基于位置的圖像、聲音和氣味記憶如何流動并相互連接。

人工智能模型則提供了另一種途徑來理解人腦,多年來,神經(jīng)科學(xué)家已經(jīng)利用多種類型的神經(jīng)網(wǎng)絡(luò)來模擬大腦中神經(jīng)元的發(fā)射。

最近有研究表明,海馬體(一個對記憶至關(guān)重要的大腦結(jié)構(gòu))基本上和Transformer模型差不多。

研究人員用新模型以一種與大腦內(nèi)部運作相似的方式追蹤空間信息,取得了一些顯著的研究成果。

來自牛津大學(xué)和斯坦福大學(xué)的認知神經(jīng)科學(xué)家James Whittington表示,當(dāng)我們知道這些大腦模型等同于Transformer時,也就意味著新模型會表現(xiàn)得更好,也更容易訓(xùn)練。

從Whittington和其他人的研究成果中可以看出,Transformer可以極大地提高神經(jīng)網(wǎng)絡(luò)模型模仿網(wǎng)格細胞和大腦其他部分進行的各種計算的能力。

Whittington表示,這樣的模型可以推動我們對人工神經(jīng)網(wǎng)絡(luò)如何工作的理解,甚至更有可能是對大腦中如何進行計算的理解。

主要從事Transformer模型研究的谷歌大腦計算機科學(xué)家David Ha表示,我們并不是要重新創(chuàng)造一個新的大腦,但我們能不能創(chuàng)造一種機制來做大腦可以做的事情?

Transformer在五年前才首次提出,當(dāng)時是作為人工智能處理自然語言的一種新模型,也是BERT和GPT-3等那些「明星模型」的秘密武器。這些模型可以生成令人信服的歌詞,創(chuàng)作莎士比亞十四行詩,或者做一些人工客服的工作。

Transformer的核心機制就是自注意力,其中每個輸入(例如一個單詞、一個像素、一個序列中的數(shù)字)總是與其他的所有輸入相連,而其他常見的神經(jīng)網(wǎng)絡(luò)只是將輸入與某些輸入相連接。

雖然Transformer是專門為自然語言任務(wù)而設(shè)計的,但后來的研究也證明了Transformer在其他任務(wù)中也同樣表現(xiàn)出色,比如對圖像進行分類,以及現(xiàn)在對大腦進行建模。

2020年,由奧地利約翰開普勒林茨大學(xué)的計算機科學(xué)家Sepp Hochreiter(LSTM論文一作)領(lǐng)導(dǎo)的一個小組,使用一個Transformer來重新調(diào)整一個強大的、長期存在的記憶檢索模型Hopfield網(wǎng)絡(luò)。

這些網(wǎng)絡(luò)在40年前由普林斯頓物理學(xué)家John Hopfield首次提出,遵循一個一般規(guī)則:在同一時間活躍的神經(jīng)元相互之間建立了強有力的聯(lián)系。

Hochreiter和他的合作者注意到,研究人員一直在尋找更好的記憶檢索模型,他們看到了一類新的Hopfield網(wǎng)絡(luò)如何檢索記憶和Transformer如何執(zhí)行注意力之間的聯(lián)系。

這些新的Hopfield網(wǎng)絡(luò)由Hopfield和麻省理工學(xué)院-IBM沃森人工智能實驗室的Dmitry Krotov開發(fā),與標(biāo)準(zhǔn)的Hopfield網(wǎng)絡(luò)相比,具有更有效的連接,可以存儲和檢索更多記憶。

論文鏈接:https://papers.nips.cc/paper/2016/hash/eaae339c4d89fc102edd9dbdb6a28915-Abstract.html

Hochreiter的團隊通過添加一個類似Transformer中的注意力機制的規(guī)則來升級這些網(wǎng)絡(luò)。

2022年,這篇新論文的進一步調(diào)整了Hochreiter的方法,修改了Transformer,使其不再將記憶視為線性序列,而是像句子中的一串單詞,將其編碼為高維空間中的坐標(biāo)。

研究人員稱這種「扭曲」進一步提高了該模型在神經(jīng)科學(xué)任務(wù)中的表現(xiàn)。實驗結(jié)果還表明,該模型在數(shù)學(xué)上等同于神經(jīng)科學(xué)家在fMRI掃描中看到的網(wǎng)格細胞發(fā)射模式的模型。

倫敦大學(xué)學(xué)院的神經(jīng)科學(xué)家Caswell Barry表示,網(wǎng)格細胞具有這種令人興奮的、美麗的、有規(guī)律的結(jié)構(gòu),并且具有引人注目的模式,不太可能隨機出現(xiàn)。

這項新工作顯示了Transformer如何準(zhǔn)確地復(fù)制了在海馬體中觀察到的那些模式。

他們也認識到,Transformer模型可以根據(jù)以前的狀態(tài)和它的移動方式弄清楚它在哪里,而且是以一種關(guān)鍵的方式進入傳統(tǒng)的網(wǎng)格細胞模型。

近期的一些其他工作也表明,Transformer可以促進我們對其他大腦功能的理解。

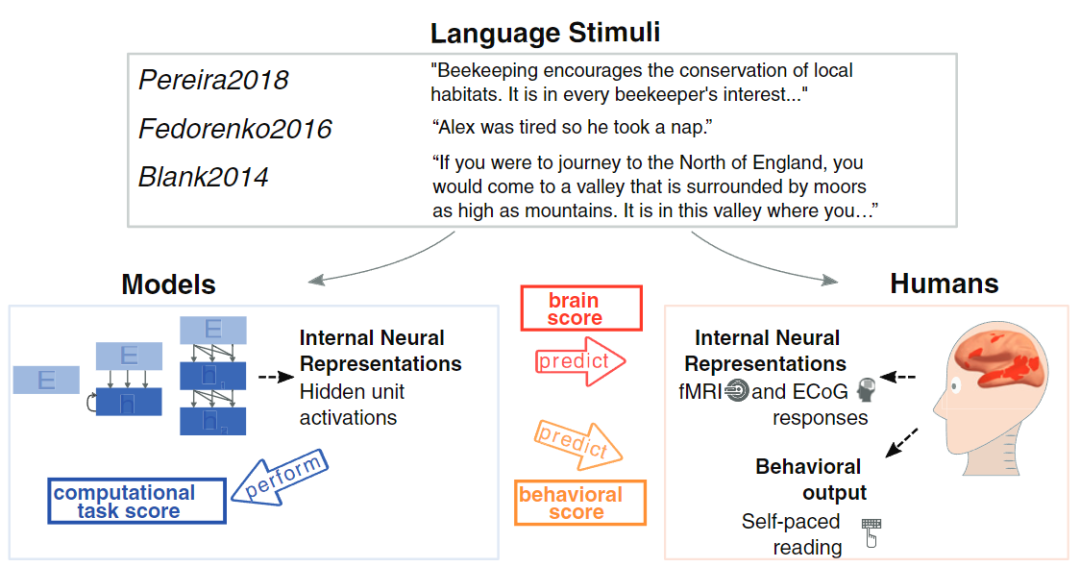

去年,麻省理工學(xué)院的計算神經(jīng)科學(xué)家Martin Schrimpf分析了43種不同的神經(jīng)網(wǎng)絡(luò)模型,以了解它們對由fMRI和皮質(zhì)電圖報告的人類神經(jīng)活動測量結(jié)果的預(yù)測程度。

他發(fā)現(xiàn)Transformer是目前領(lǐng)先的、最先進的神經(jīng)網(wǎng)絡(luò),幾乎可以預(yù)測成像中發(fā)現(xiàn)的所有變化。

而David Ha與同為計算機科學(xué)家的Yujin Tang最近也設(shè)計了一個模型,可以故意給Transformer以隨機、無序的方式輸入大量數(shù)據(jù),模仿人體如何向大腦傳輸感官觀察。結(jié)果發(fā)現(xiàn)Transformer可以像我們的大腦一樣,可以成功地處理無序的信息流。

論文鏈接:https://arxiv.org/abs/2111.14377

Yujin Tang表示,神經(jīng)網(wǎng)絡(luò)是硬接線,只能接收特定的輸入。但在現(xiàn)實生活中,數(shù)據(jù)集經(jīng)常快速變化,而大多數(shù)人工智能沒有任何辦法調(diào)整。未來我們想嘗試一種能夠快速適應(yīng)的架構(gòu)。