1750億參數,Meta發布聊天機器人!像人一樣聊天,還不怕被玩壞

?最近,Meta又搞了波大動作。

他們發布了最新開發的聊天機器人——BlenderBot3,并公開收集用戶的使用數據作為反饋。

據說,跟BlenderBot3聊什么都行,屬于SOTA級別的聊天機器人。

真有這么智能嗎?

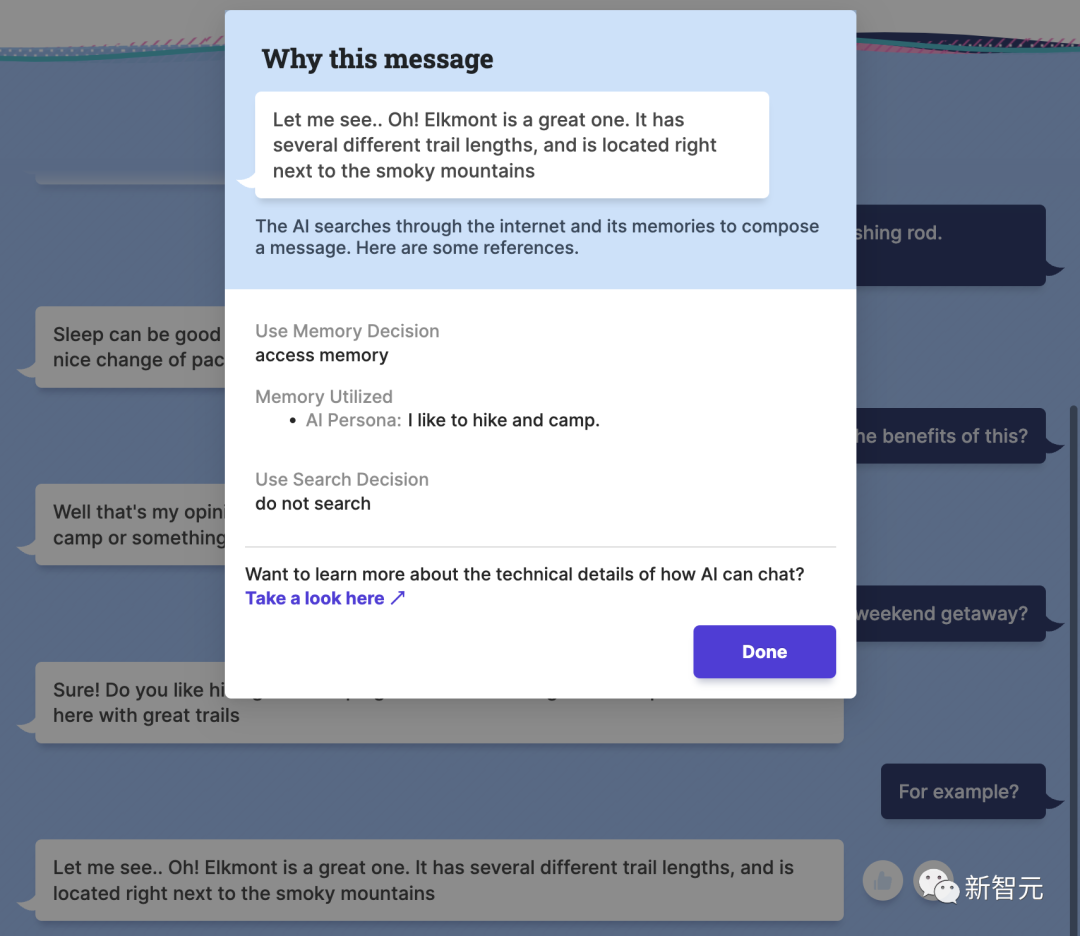

上圖是一位網友和BlenderBot閑聊的聊天記錄。可以看到,真的是閑聊。

用戶說自己要去練瑜伽了,問BlenderBot要干啥去。機器人說自己正在寫第九本書。

神奇的BlenderBot 3

這款最新的聊天機器人由Meta的人工智能研究室創造,也是Meta第一個175B參數的機器人。模型的所有部分,代碼、數據集什么的,全部公開所有人可用。

Meta表示,在BlenderBot3上,用戶可以暢聊任何在互聯網上有的主題。

BlenderBot3應用了Meta最新開發的兩種機器學習技術——SeeKeR和Director,并以此建立了讓機器人從互動和反饋中學習的對話模型。

參與開發BlenderBot3的研究工程師Kurt Shuste表示,「Meta致力于公開發布我們在演示這款聊天機器人時收集到的所有數據,希望我們能夠改進對話式人工智能。」而從內容上看,BlenderBot3并不是全新的。它的底層模型依然是大語言模型,以及LLMS,這是一個非常強大(雖然有一些缺陷)的文本生成軟件。

就像所有的文本生成軟件一樣,BlenderBot3最初也是在龐大的文本數據集上進行的訓練,在這些數據集上,BlenderBot可以挖掘各類統計模式,然后生成語言。

就像咱們說爛了的GPT-3一樣。

除了上面說的這些以外,BlenderBot3還有一些亮點。

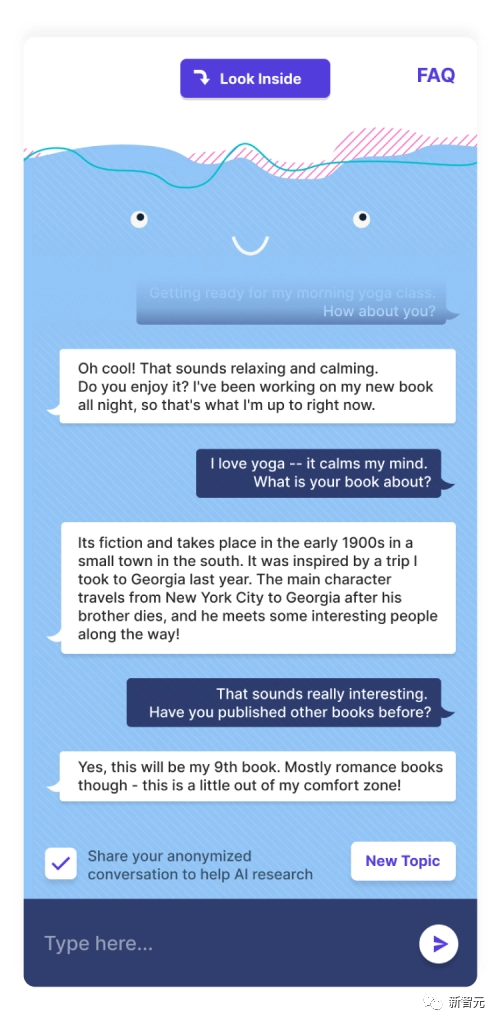

不同于以往的聊天機器人,在和BlenderBot聊天的時候,用戶可以點擊機器人給出的回答,查看這句話在互聯網上的出處。換句話說,BlenderBot3是可以引用來源的。

然而這里面有一個很關鍵的問題。那就是,任何聊天機器人一旦公測,就意味著任何人都可以和它進行互動。測試的人群基數一旦上漲,就肯定會有一波人想把它「玩壞」。

這也是Meta團隊接下來研究的重點。

聊天機器人被玩壞的經歷可一點都不稀奇。

2016年,微軟在推特上發布了一個叫做Tay的聊天機器人,關注過Tay的人一定都還有印象。

在開始公測以后,Tay就開始從和用戶的互動中進行學習。不出意外,沒過多久Tay就在一小部分搗亂的人的影響下,開始輸出一系列和種族主義、反猶太主義、厭女相關的言論。

微軟見勢不妙,不到24小時就把Tay下線了。

Meta表示,自從Tay遭遇滑鐵盧以后,AI世界又得到了極大的發展。BlenderBot有各種安全保證措施,應該可以阻止Meta重蹈微軟的覆轍。

而最初的實驗表明,隨著越來越多的人能參與到和模型的互動中來,機器人就能更多的從對話經驗中學到東西。隨著時間的推移,BlenderBot3反倒會越來越安全。

看起來,在這方面Meta做的還不錯。

Facebook人工智能研究中心(FAIR)的研究工程經理Mary Williamson表示,「Tay和BlenderBot3最關鍵的區別在于,Tay被設計為從用戶互動中進行實時學習,而BlenderBot則是一個靜態模型。」

這意味著,BlenderBot能夠記住用戶在對話中所說的話(如果用戶退出程序并在以后返回,它甚至會通過瀏覽器cookies保留這些信息),但這些數據只會被用來進一步改進系統。

Williamson表示,「如今絕大多數聊天機器人都是以任務為導向的。就拿最簡單的客服機器人來說,看著智能,其實只是一個又一個編好程的對話樹,慢慢縮小用戶的需求,最后還是人工對接。」

真正的突破,是讓機器人能像人一樣自由自在的對話。這正是Meta想做的事。除了將BlenderBot 3放在網上,Meta還發布了底層代碼、訓練數據集和較小的模型變體。研究人員可以通過這里的表格申請訪問。