Transformer又出新變體∞-former:無限長期記憶,任意長度上下文

在過去的幾年里,Transformer 幾乎統(tǒng)治了整個(gè) NLP 領(lǐng)域,還跨界到計(jì)算機(jī)視覺等其他領(lǐng)域。但它也有弱點(diǎn),比如不擅長處理較長上下文,因?yàn)橛?jì)算復(fù)雜度會(huì)隨著上下文長度的增長而增長,這使其難以有效建模長期記憶。為了緩解這一問題,人們提出了多種 Transformer 變體,但它們的記憶容量都是有限的,不得不拋棄較早的信息。

在一篇論文中,來自 DeepMind 等機(jī)構(gòu)的研究者提出了一種名為 ∞-former 的模型,它是一種具備無限長期記憶(LTM)的 Transformer 模型,可以處理任意長度的上下文。

論文鏈接:https://arxiv.org/pdf/2109.00301.pdf

通過利用連續(xù)空間注意力機(jī)制來處理長期記憶,∞-former 的注意力復(fù)雜度可以獨(dú)立于上下文長度。因此,它能夠借助一個(gè)固定的算力開銷建模任意長度的上下文并保持「粘性記憶(sticky memories)」。

在一個(gè)綜合排序任務(wù)上進(jìn)行的實(shí)驗(yàn)證明了∞-former 能夠保留來自長序列的信息。此外,研究者還進(jìn)行了語言建模的實(shí)驗(yàn),包括從頭開始訓(xùn)練一個(gè)模型以及對一個(gè)預(yù)訓(xùn)練的語言模型進(jìn)行微調(diào),這些實(shí)驗(yàn)顯示了無限長期記憶的優(yōu)勢。

不過,和其他很多 Transformer 變體的論文一樣,這篇論文的標(biāo)題也引發(fā)了一些吐槽:

∞-former:一種擁有無限記憶的 Transformer

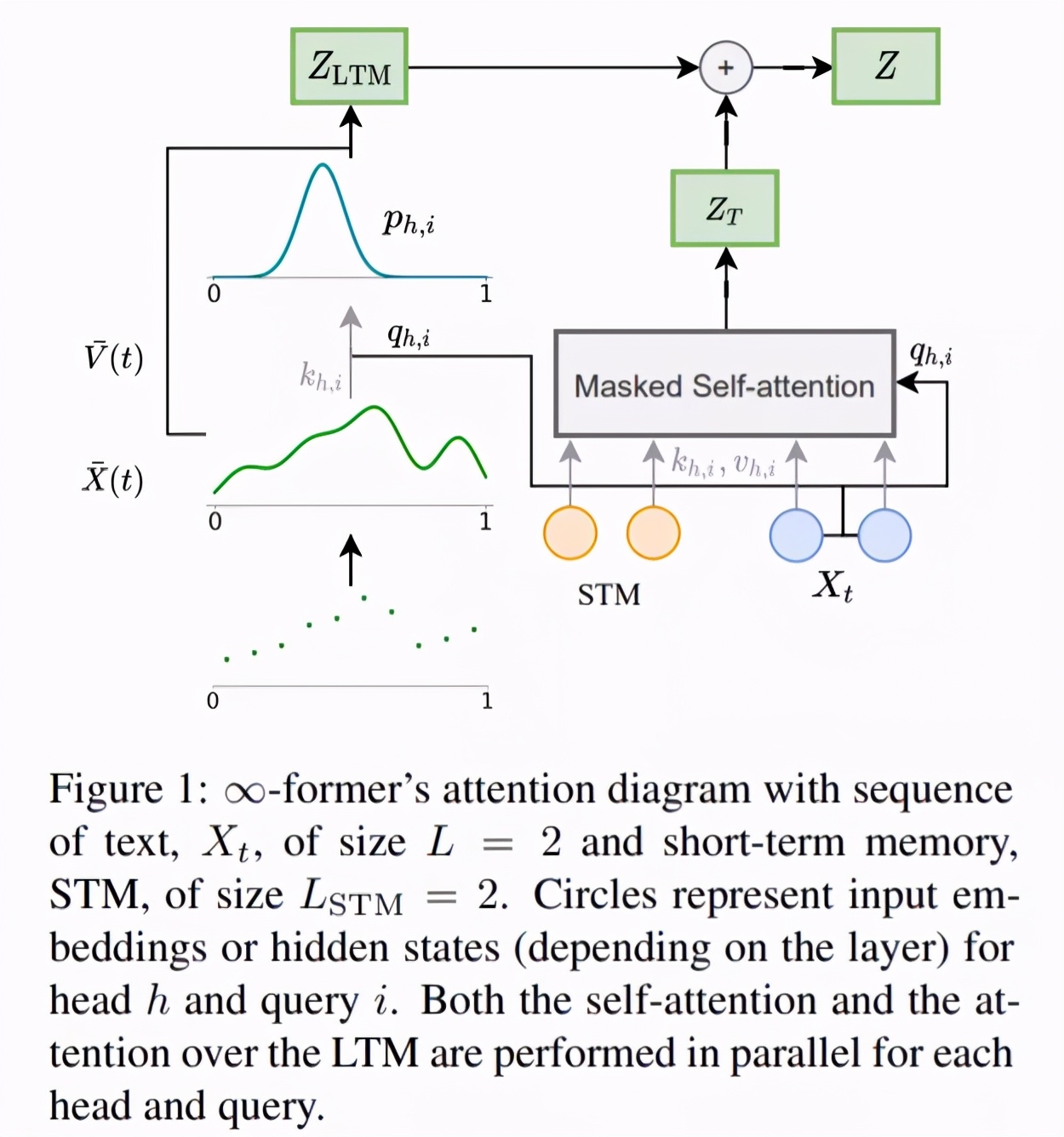

為了使模型能夠處理長程上下文,研究者提出用一個(gè)連續(xù) LTM 來擴(kuò)展原始 transformer,這個(gè) LTM 存儲(chǔ)前面步驟的輸入嵌入和隱藏狀態(tài)。他們還考慮了有兩種記憶的可能性:LTM 和 STM(短期記憶),類似于 transformer-XL 的記憶。∞-former 的整體架構(gòu)如下圖 1 所示。

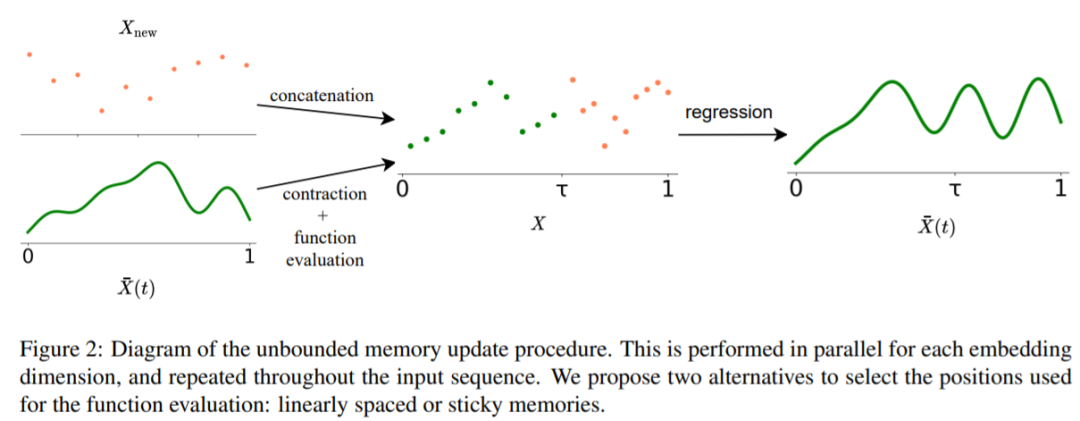

為了讓新模型的 LTM 達(dá)到無限的程度,研究者使用了一個(gè)連續(xù)空間注意力框架(參見《 Sparse and Continuous Attention Mechanisms 》),它在適用于記憶的信息單元數(shù)量(基函數(shù))和這些單元的表示粒度之間進(jìn)行了權(quán)衡。在這一框架中,輸入序列被表征為一個(gè)連續(xù)信號,表示為徑向基函數(shù)的一個(gè)線性組合。這種表征有兩個(gè)顯著的優(yōu)勢:1)上下文可以用 N 個(gè)基函數(shù)來表示,N 小于上下文中 token 的數(shù)量,降低了注意力復(fù)雜度;2)N 可以是固定的,這使得在記憶中表征無限長度的上下文成為可能(如圖 2 所示),代價(jià)是損失 resolution,但不增加其注意力復(fù)雜度,O(L^2 + L × N),其中的 L 對應(yīng) transformer 序列長度。

為了緩解損失較早記憶 resolution 的問題。研究者引入了「粘性記憶」的概念,將 LTM 新信號中的較大空間歸于之前記憶信號的相關(guān)區(qū)域。這是一種強(qiáng)制重要信息在 LTM 中持續(xù)存在的過程,使得模型可以在不損失相關(guān)信息的情況下更好地捕捉長上下文,類似于大腦中的長時(shí)程增強(qiáng)和突觸可塑性。

實(shí)驗(yàn)結(jié)果

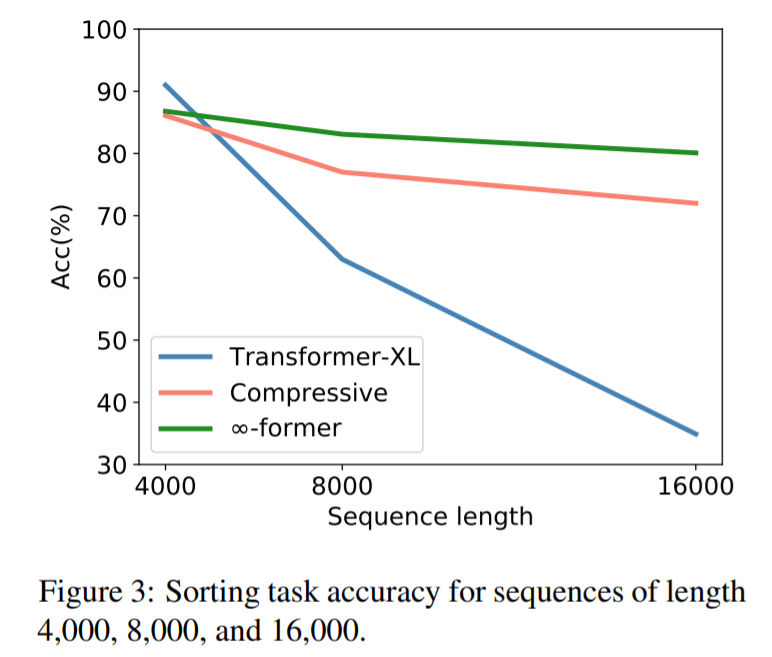

為了檢驗(yàn)∞-former 能否建模長上下文,研究者首先針對一個(gè)綜合任務(wù)進(jìn)行了實(shí)驗(yàn),包括把 token 按其在一個(gè)長序列中的頻率進(jìn)行排序,結(jié)果如下:

從圖中可以看出,在序列長度為 4000 的時(shí)候,transformerXL 的準(zhǔn)確率要略高于 compressive transformer 和 ∞-former。這是因?yàn)?transformerXL 幾乎可以在記憶中保存整個(gè)完整序列。但隨著序列長度的增加,transformerXL 的準(zhǔn)確率迅速下降,compressive transformer 和 ∞-former 變化較小。這表明∞-former 更擅長建模長序列。

接下來,他們又進(jìn)行了語言建模實(shí)驗(yàn),包括:1)從頭訓(xùn)練一個(gè)模型;2)微調(diào)一個(gè)預(yù)訓(xùn)練語言模型。

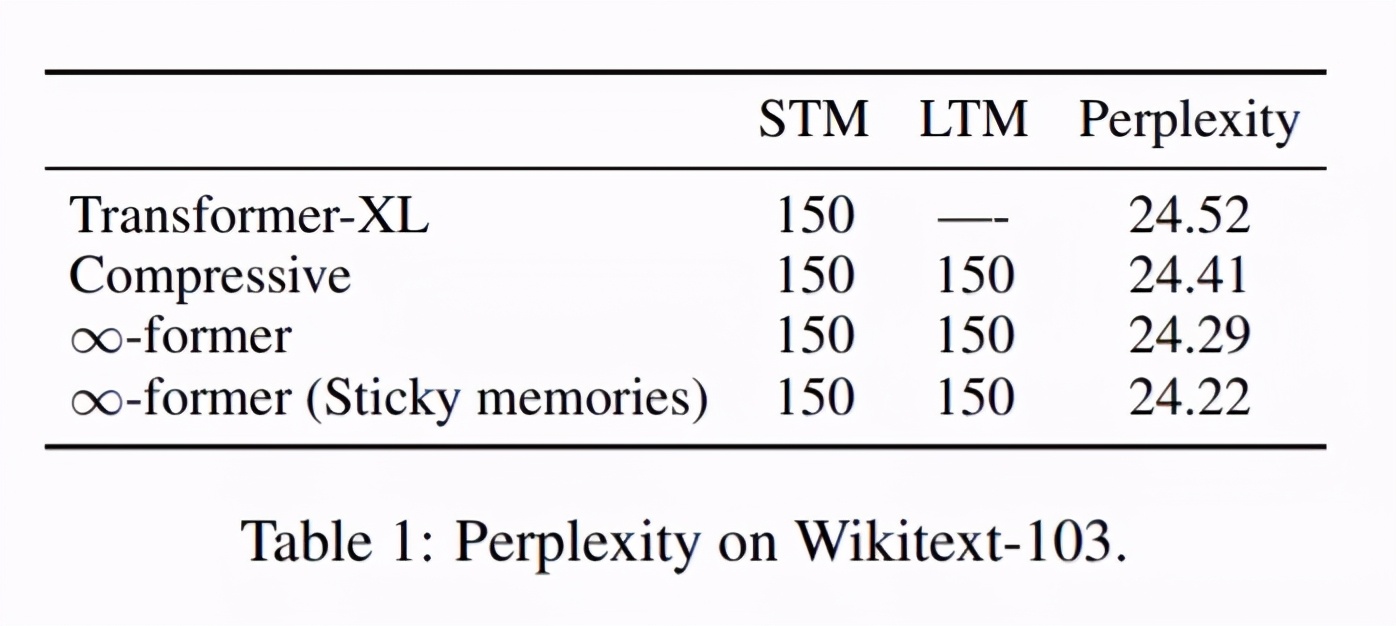

第一個(gè)語言建模實(shí)驗(yàn)的結(jié)果如下表 1 所示。從中可以看出,利用長期記憶擴(kuò)展模型確實(shí)會(huì)帶來更好的困惑度結(jié)果,而且使用粘性記憶也可以在一定程度上降低困惑度。

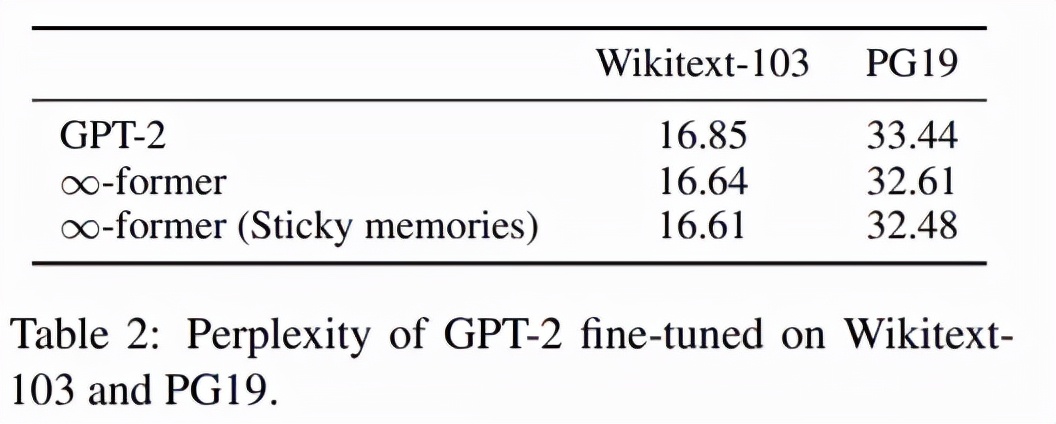

第二個(gè)語言建模實(shí)驗(yàn)的結(jié)果如下表 2 所示。該結(jié)果表明,通過簡單地將長期記憶添加至 GPT-2 并進(jìn)行微調(diào),模型在 Wikitext-103 和 PG19 上的困惑度都會(huì)降低。這表明∞-former 具有多種用途:既可以從頭開始訓(xùn)練模型,也可以用于改進(jìn)預(yù)訓(xùn)練模型。