預訓練、微調和上下文學習

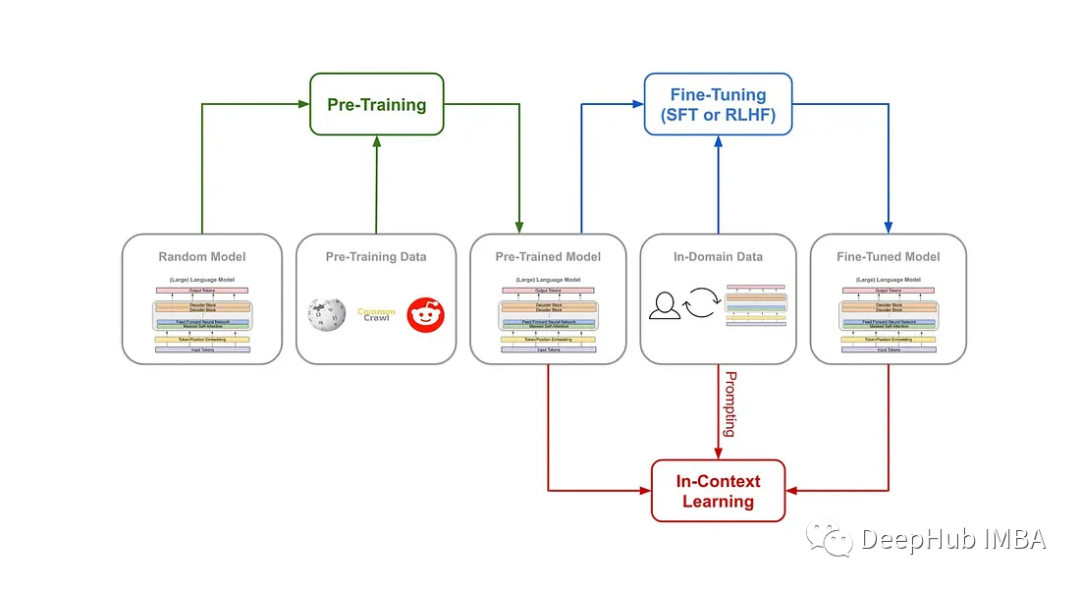

最近語言模型在自然語言理解和生成方面取得了顯著進展。這些模型通過預訓練、微調和上下文學習的組合來學習。在本文中將深入研究這三種主要方法,了解它們之間的差異,并探討它們如何有助于語言模型的學習過程。

預訓練

預訓練(Pre-training)是語言模型學習的初始階段。在預訓練期間,模型會接觸到大量未標記的文本數據,例如書籍、文章和網站。在大量未標記文本數據上訓練語言模型。比如說在包含數百萬本書、文章和網站的數據集上預訓練像 GPT-3 這樣的語言模型。預訓練目標是捕獲文本語料庫中存在的底層模式、結構和語義知識。

主要特點:

- 無監督學習:預訓練通常是一個無監督學習過程,模型在沒有明確指導或標簽的情況下從未標記的文本數據中學習。

- Masked Language Modeling:模型經過訓練以預測句子中缺失或屏蔽的單詞,學習上下文關系并捕獲語言模式。

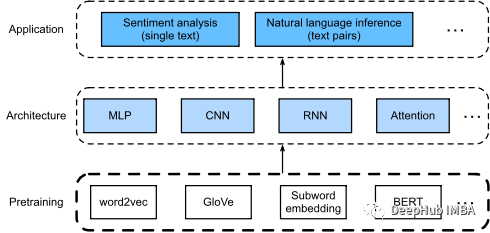

- Transformer 架構:預訓練通常采用基于 Transformer 的架構,因為這種架構擅長捕獲遠程依賴關系和上下文信息。

預訓練模型作為廣泛的自然語言處理任務的基礎,例如文本分類、命名實體識別和情感分析。因為它們提供了對語言的一般理解,并且可以針對特定的下游任務進行微調。

預訓練的主要下游任務如下:

- 文本生成:預訓練模型可以生成連貫且上下文相關的文本,使它們對聊天機器人、虛擬助手和內容生成等應用程序有價值。

- 語言翻譯:預訓練模型可以針對機器翻譯任務進行微調,使它們能夠準確地將文本從一種語言翻譯成另一種語言。

- 情感分析:通過對帶有情感標簽的數據集的預訓練模型進行微調,它們可用于對文本輸入的情感進行分類,協助完成客戶反饋分析和社交媒體監控等任務。

- 命名實體識別:可以對預訓練模型進行微調,以從文本中識別和提取命名實體,從而促進新聞文章或法律文件中的實體識別等任務。

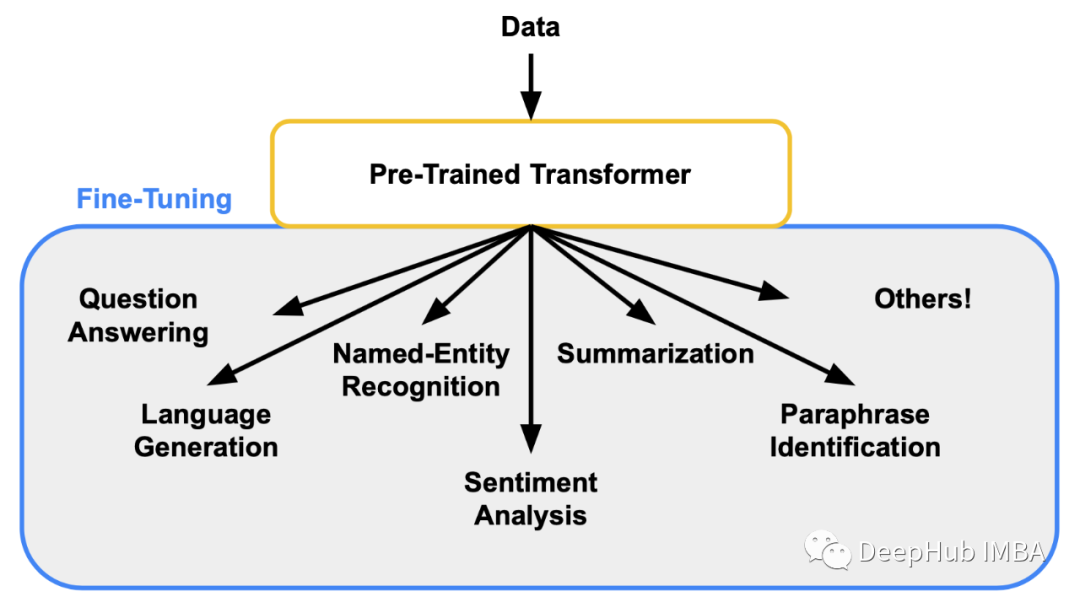

微調

微調(Fine-Tuning)是在特定任務或領域上進一步訓練大型語言模型(LLM)的過程。這可以通過使用預訓練的LLM作為起點,然后在特定任務或領域的標記數據集上訓練它來完成。微調可以通過調整模型的權重來更好地擬合數據,從而提高LLM在特定任務或領域上的性能。

監督微調(Supervised Fine-Tuning)

SFT使用標記數據來訓練LLM。標記的數據由輸入和輸出數據對組成。輸入數據是LLM將得到的數據,輸出數據是LLM期望生成的數據。SFT是一種相對簡單和有效的方法來微調LLM。

基于人類反饋的強化學習(Reinforcement Learning from Human Feedback)

RLHF使用人類反饋來訓練LLM。反饋可以通過多種方式收集,例如調查、訪談或用戶研究。RLHF是一種更復雜、更耗時的方法來微調LLM,但它比SFT更有效。

應該使用哪種方法?

微調 LLM 的最佳方法取決于許多因素,例如標記數據的可用性、可用時間和資源以及所需的性能。如果有很多可用的標記數據,SFT 是一個不錯的選擇。但是如果沒有可用的標記數據,或者如果需要將 LLM 的性能提高到 SFT 無法達到的水平,RLHF 是一個不錯的選擇,但是RLHF 需要更多的事件和后期的人工參與。

微調的好處

微調可以提高 LLM 在特定任務或領域上的性能,可以為自然語言生成、問答和翻譯等任務帶來更好的結果。微調還可以使 LLM 更具可解釋性,這有助于調試和理解模型的行為。

所以Fine-tuning 是語言模型學習過程中的后續步驟。在經過預訓練后,模型根據特定于任務的標記數據進行微調,以使其知識適應特定的下游任務。

- 遷移學習:微調利用遷移學習,其中模型將學習到的表示從預訓練轉移到目標任務。

- 特定于任務的數據:模型在特定于目標任務的標記數據上進行訓練,例如帶有情感標記的句子或問答對。

- 基于梯度的優化:微調通常涉及基于梯度的優化技術,以根據特定于任務的數據更新模型的參數。

微調使模型能夠在各種特定的自然語言處理任務中表現出色,包括情感分析、問題回答、機器翻譯和文本生成。像BERT這樣的預訓練語言模型可以在標有積極或消極情緒的客戶評論數據集上進行微調。一般的微調任務如下:

- 情感分析:微調模型可以用于情感分析任務,例如分析客戶評論、社交媒體情感監控和市場研究。

- 文本分類:微調允許模型將文本分類到預定義的類別中,從而支持主題分類、垃圾郵件檢測和文檔分類等應用程序。

- 問答:通過對問答對進行微調,可以使用模型根據給定的上下文回答特定的問題,幫助完成客戶支持和信息檢索等任務。

上下文學習

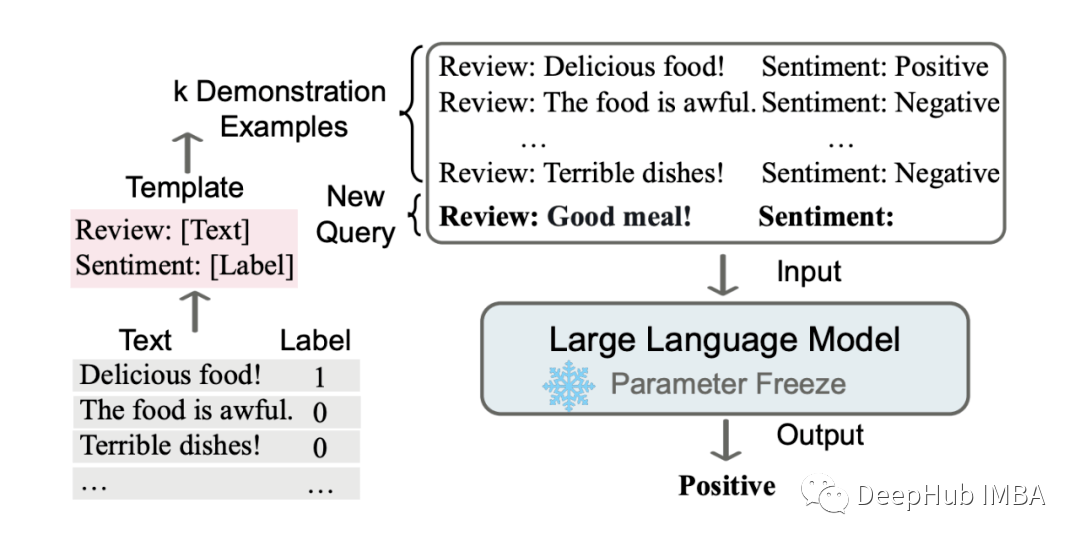

上下文學習(In-Context Learning)也可以翻譯成情境學習:是一種新興的方法,它結合了預訓練和微調,同時在訓練過程中結合特定任務的指令或提示。模型學會根據給定的指令生成與上下文相關的響應或輸出,從而提高它們在特定任務中的表現。

隨著大模型(GPT3,Instruction GPT,ChatGPT)的橫空出世,如何更高效地提示大模型也成了學術界與工業界的關注,因此 In-context learning 的方法在 NLP 領域十分火熱。

ICL的關鍵思想是從類比中學習。上圖給出了一個描述語言模型如何使用 ICL 進行決策的例子。首先,ICL 需要一些示例來形成一個演示上下文。這些示例通常是用自然語言模板編寫的。然后 ICL 將查詢的問題(即你需要預測標簽的 input)和一個上下文提示(一些相關的 cases)連接在一起,形成帶有提示的輸入,并將其輸入到語言模型中進行預測。

上下文提示:上下文學習包括提供明確的指令或提示,以指導模型在生成響應或輸出時的行為。

強化學習或結構化反饋:上下文學習可以結合強化學習技術或結構化反饋來指導模型的響應。

迭代訓練:模型經歷多次迭代訓練,接收反饋并根據提供的提示改進它們的響應。

上下文學習在各種任務中顯示出有希望的結果,包括問題回答,對話系統,文本完成和文本摘要。它允許模型生成上下文一致的和特定于任務的輸出。

上下文學習與預訓練和微調的關系

預訓練側重于從大規模未標記數據中進行無監督學習,獲取一般語言理解。微調建立在預訓練的基礎上,并使用特定于任務的標記數據使模型適應特定的任務,從而實現專門的性能。上下文學習在訓練過程中包含特定于任務的指令或提示,指導模型的行為并提高任務性能。

上下文學習包括訓練語言模型,以根據特定的指令或提示生成與上下文相關的響應。主要訓練語言模型以禮貌和有用的方式生成對客戶查詢的響應

- 聊天機器人和虛擬助手:上下文學習允許聊天機器人和虛擬助手為用戶查詢提供更適合上下文和有用的響應,增強用戶體驗。

- 對話系統:通過結合上下文學習,模型可以產生連貫和引人入勝的對話,改善對話系統中的人機交互。

- 個性化推薦:可以使用上下文學習來訓練模型,根據用戶偏好和歷史數據提供個性化推薦,提高推薦的準確性和相關性。

總結

語言模型通過預訓練、微調和上下文學習的結合來學習。預訓練捕獲一般的語言理解,微調專門針對特定任務的模型,而上下文學習包含特定任務的指令以提高性能。理解這些方法可以深入了解語言模型學習過程中涉及的不同階段和技術,從而使它們能夠有效地應用于各種自然語言處理任務。