擔(dān)心GPT-3被喂假消息?谷歌新研究,將知識(shí)圖譜轉(zhuǎn)“人話”來訓(xùn)練

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

還在擔(dān)心大語(yǔ)言模型“啥都吃”,結(jié)果被用假信息訓(xùn)練了?

放在以前,這確實(shí)是訓(xùn)練NLP模型時(shí)值得擔(dān)心的一個(gè)難題。

現(xiàn)在,谷歌從根本上解決了這個(gè)問題。

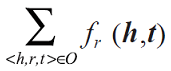

他們做了個(gè)名為TEKGEN的AI模型,直接將知識(shí)圖譜用“人話”再描述一遍,生成語(yǔ)料庫(kù),再喂給NLP模型訓(xùn)練。

這是因?yàn)椋R(shí)圖譜的信息來源往往準(zhǔn)確靠譜,而且還會(huì)經(jīng)過人工篩選、審核,質(zhì)量有保障。

目前,這項(xiàng)研究已經(jīng)被NAACL 2021接收。

如何讓AI用“人話”描述知識(shí)圖譜?

谷歌用來描述知識(shí)圖譜的TEKGEN模型,全名Text from KG Generator(知識(shí)圖譜文本生成器)。

它會(huì)讀取一個(gè)知識(shí)圖譜中的所有詞語(yǔ),捋清它們之間的關(guān)系,再用“人話”說出來。

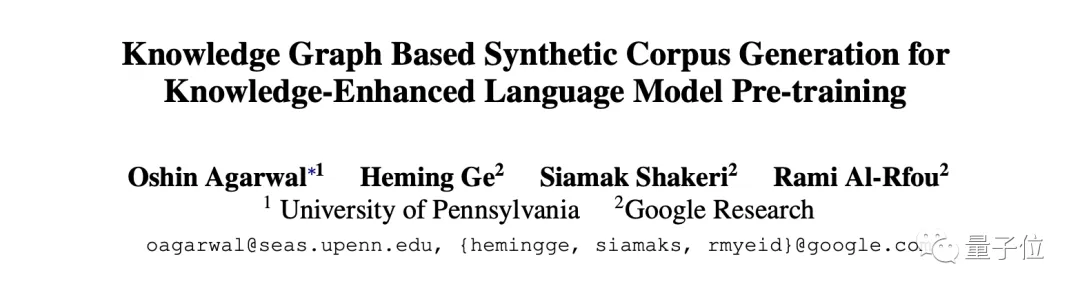

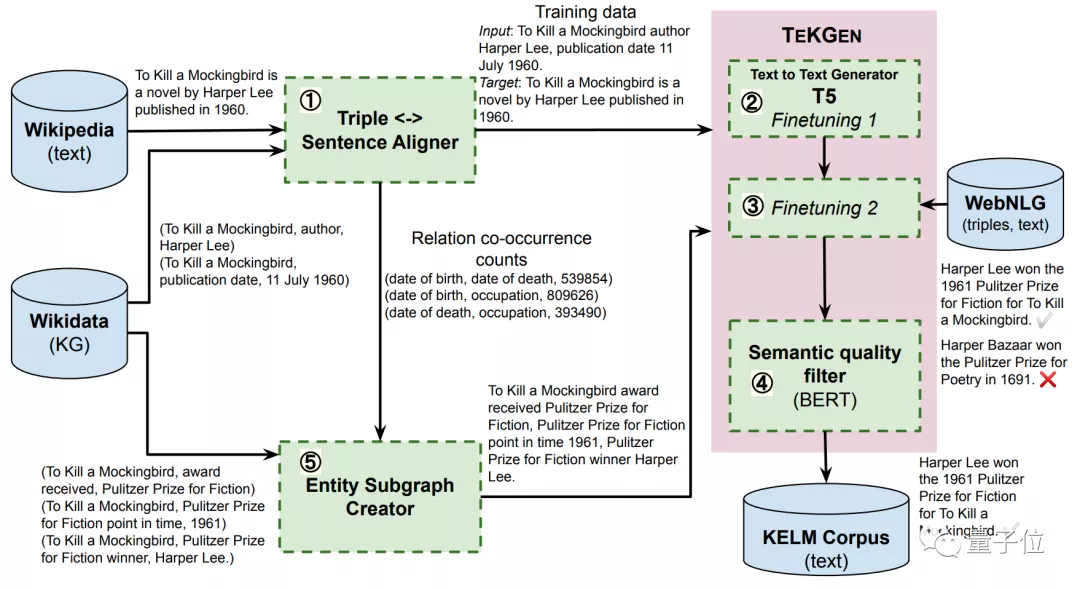

從下圖中來看,轉(zhuǎn)換語(yǔ)句分為2步:

首先,將關(guān)系圖譜中的詞語(yǔ),按邏輯進(jìn)行排列;然后,再添加一些詞語(yǔ)、并調(diào)整語(yǔ)句間的邏輯關(guān)系,將它們變成一段完整的話。

為了實(shí)現(xiàn)這個(gè)功能,TEKGEN包含4個(gè)部分:

- 三元組(包含主語(yǔ)、賓語(yǔ)、關(guān)系詞)生成器。將維基百科的知識(shí)圖譜、和維基百科文本描述進(jìn)行對(duì)應(yīng),生成訓(xùn)練數(shù)據(jù)集。

- T5的文本-文本生成器,用于將三元組轉(zhuǎn)換成文本信息。

- 實(shí)體子圖創(chuàng)建器。用于將三元組中的文本信息轉(zhuǎn)換成語(yǔ)句。

- 語(yǔ)義質(zhì)量濾波器。這部分用來處理低質(zhì)量的輸出,保證生成的語(yǔ)句質(zhì)量。

整體來看,用TEKGEN生成語(yǔ)句的流程是這樣的:

生成后的語(yǔ)句,就能用來放心地訓(xùn)練大語(yǔ)言模型了。

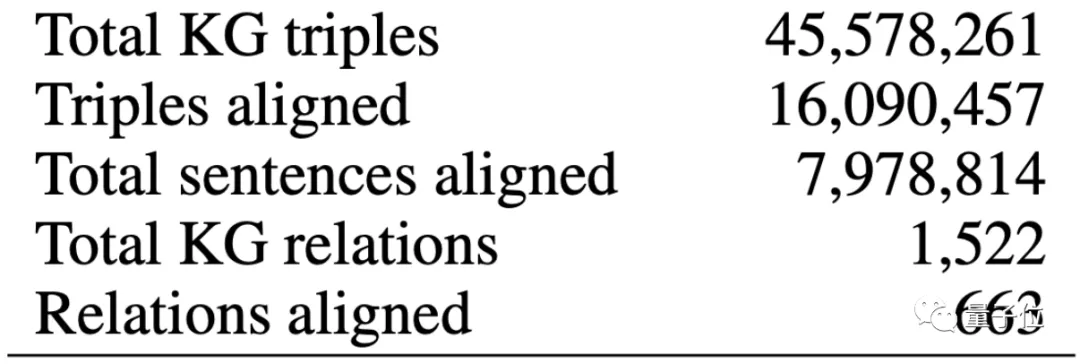

這份生成的語(yǔ)料庫(kù),由4500萬個(gè)三元組生成,組合起來的句子有1600萬句。

那么,用這個(gè)語(yǔ)料庫(kù)訓(xùn)練的NLP模型,是否真能取得更好的效果呢?

“滿分5分,人類給它4.3分”

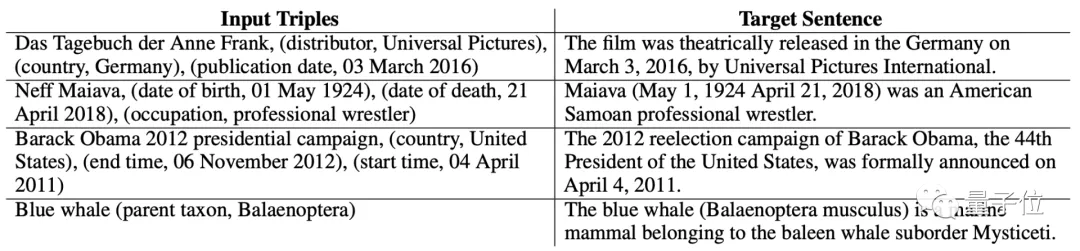

先來看幾個(gè)連詞成句的實(shí)例效果。

從輸入的詞語(yǔ)來看,只有主語(yǔ)、賓語(yǔ),以及這兩個(gè)詞語(yǔ)之間的關(guān)系。

但TEKGEN似乎“悟”出了什么,很快就將這些句子組合成了一段正常的語(yǔ)句。

不僅時(shí)間、地點(diǎn)、從屬關(guān)系等分得非常清楚,邏輯上也符合我們平時(shí)說話的語(yǔ)序。

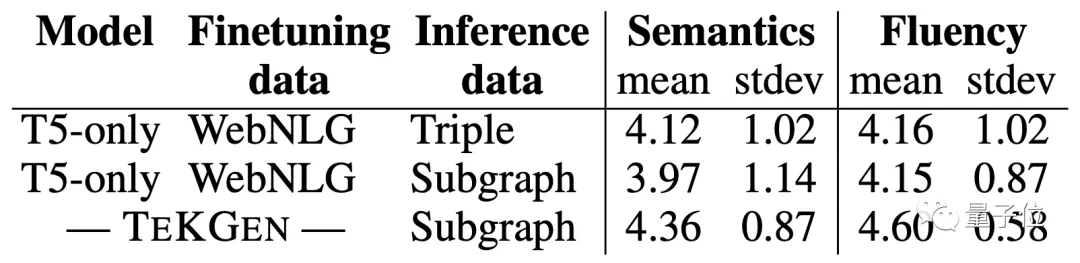

那么,滿分5分的話,人類對(duì)于AI的“圖文轉(zhuǎn)換”能力給出幾分呢?

谷歌找了些志愿者來進(jìn)行測(cè)評(píng),從結(jié)果來看,TEKGEN在“語(yǔ)義”和“流暢度”兩方面,均取得了4.3分以上的好成績(jī)。

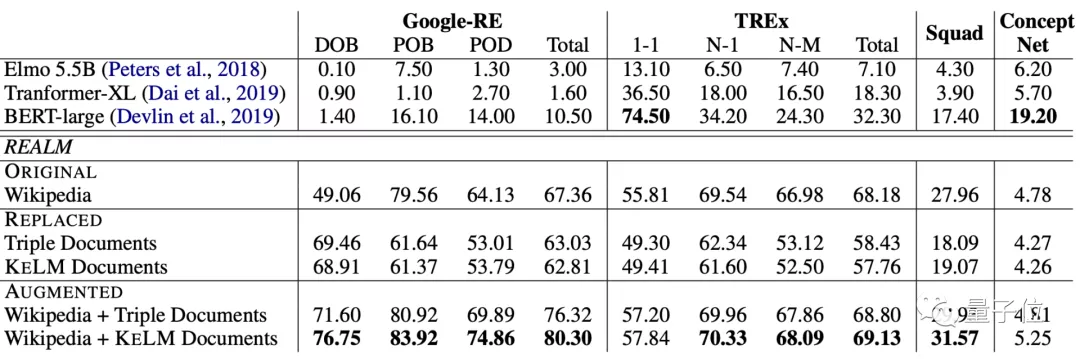

當(dāng)然,這里面也用LAMA(LAnguage Model Analysis) probe,來對(duì)用這個(gè)語(yǔ)料庫(kù)訓(xùn)練的模型進(jìn)行了評(píng)估。

在Google-RE和TREx兩個(gè)數(shù)據(jù)集上,經(jīng)過預(yù)訓(xùn)練的模型,在各項(xiàng)任務(wù)上均取得了非常好的效果。

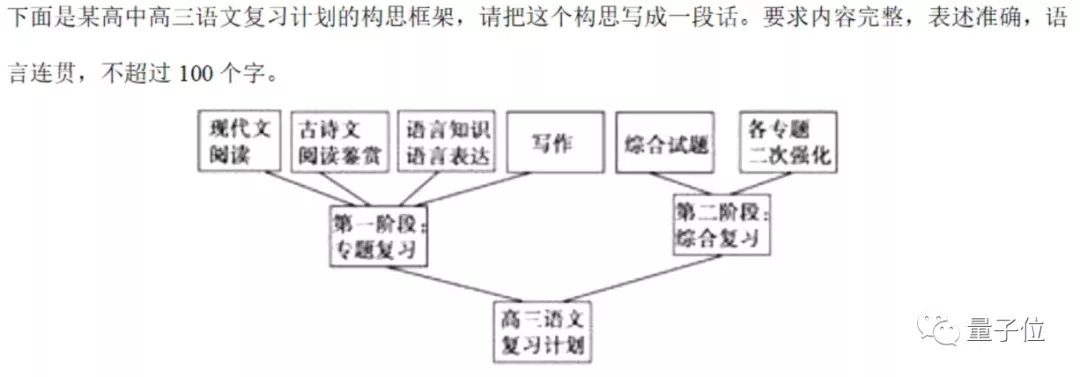

說不定,將來真能讓AI去試試高考語(yǔ)文的“圖文轉(zhuǎn)換”題:

作者介紹

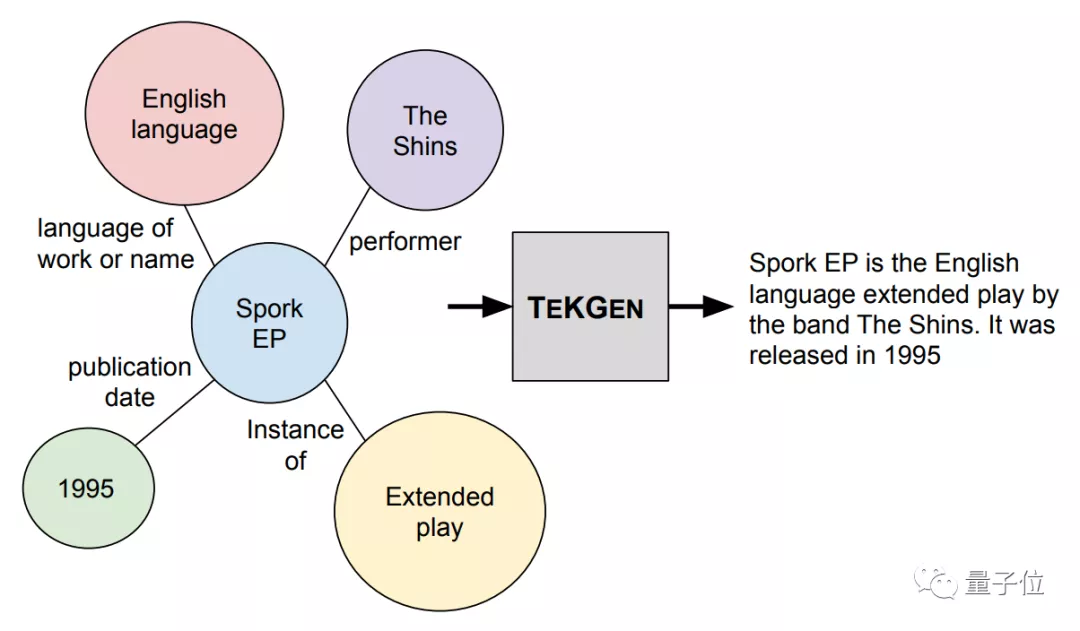

論文一作小姐姐Oshin Agarwal,是賓夕法尼亞大學(xué)的計(jì)算機(jī)系在讀博士生,研究方向是自然語(yǔ)言處理中的信息抽取。

這篇論文,是她在谷歌實(shí)習(xí)期間完成的。

來自谷歌的Heming Ge、Siamak Shakeri和Rami Al-Rfou也參與了這項(xiàng)工作。

目前,作者們已經(jīng)將這個(gè)用知識(shí)圖譜生成的語(yǔ)料庫(kù)放了出來。

想要訓(xùn)練NLP模型的小伙伴,可以用起來了~

論文地址:

https://arxiv.org/abs/2010.12688

用知識(shí)圖譜生成的語(yǔ)料庫(kù):

https://github.com/google-research-datasets/KELM-corpus