2020,算法話題進入主流視野的一年

從困在系統里的外賣騎手到讓人無法自拔的社交媒體,2020年,關于算法的討論終于進入了主流話語當中。

這僅僅是個開始。隨著數據在生活各個角落不斷生根發芽,算法的應用也變得越來越廣泛:小到選擇一個10秒的短視頻,大到審判刑事案件。但算法究竟是怎么成形的、它將如何影響我們行為、社會生活又會相應地產生什么改變……面對這些如同黑箱般的問題,很多人可能都還未意識到,更不要說去理解,甚至是質疑。

大體上來講,算法的形成主要包括兩個部分:訓練數據的收集和算法的設計訓練應用。澎湃新聞總結了關于這兩大部分的2020年大事件,并采訪了三位相關領域的專家和從業者,看看他們是如何理解算法對我們生活產生的影響。

算法離不開數據,但有數據就會有泄

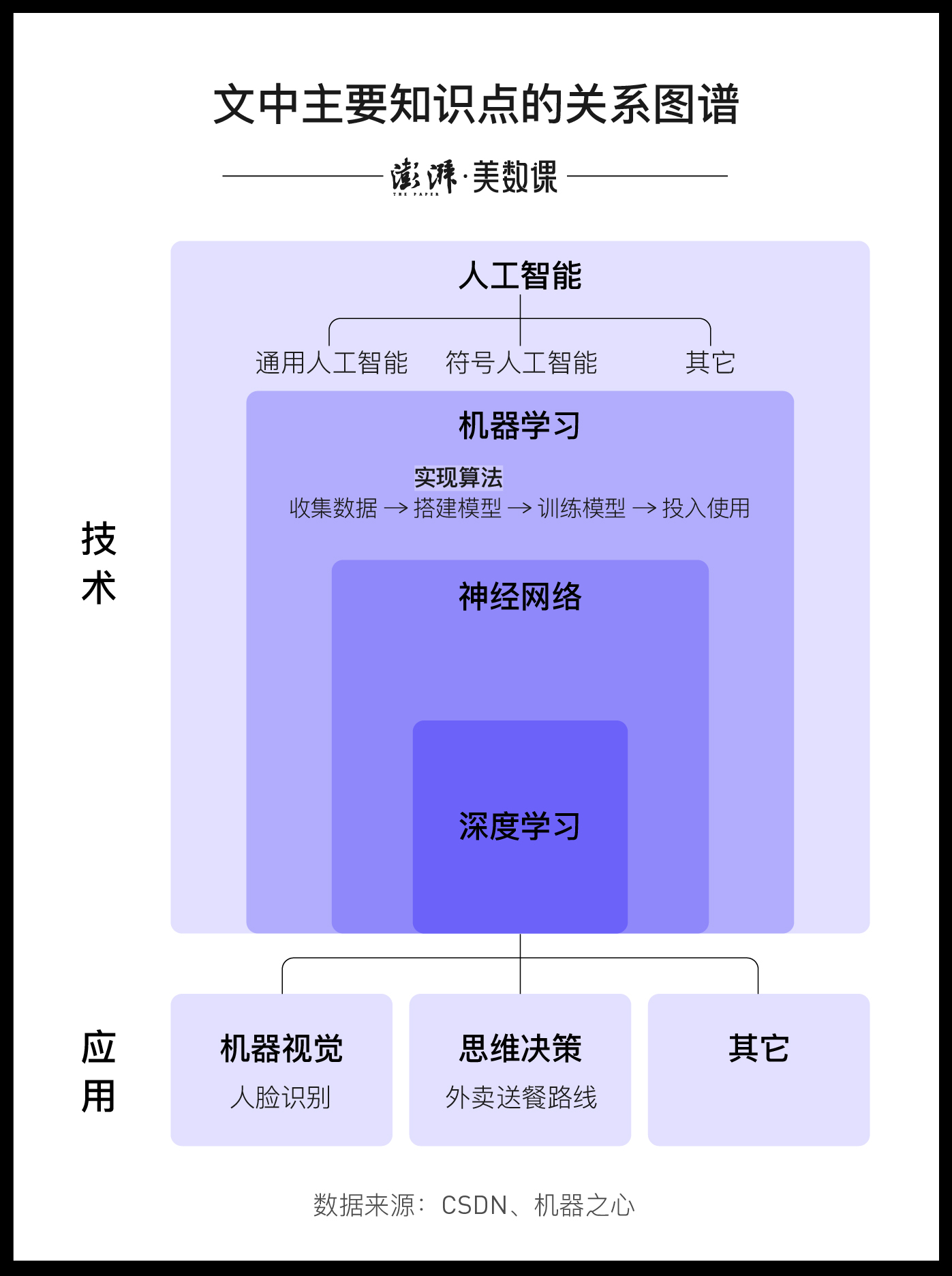

算法的形成離不開訓練數據。如上一張圖所示,在實現算法、搭建模型之前,我們需要收集大量的數據。

這些數據來自我們生活的方方面面,比如授權app收集的身份數據、使用app所產生的行為數據,甚至是寄快遞、住酒店等過程中記錄的數據。

“我們已經進入了隱私的透明人時代”,上海交通大學數據法律研究中心執行主任何淵在接受澎湃新聞采訪時提到。“網絡比你還了解你自己……不管你愿不愿意,這些企業都已經掌握了我們的數據。”

這并不代表用戶就束手無策了,比如可以避免使用來源不明的app、不輕易授權app獲取隱私信息等等。

不過在此之前,還有兩個問題需得弄清楚:

第一,個人信息和個人隱私并不是一個概念。隱私是每個人不能放棄的私密信息。如果這些信息被允許交易,我們將不再是一個完整的人。

而個人信息則更注重身份識別性,這些信息結合在一起后,有助于識別個人的身份。

第二,權利和義務是對等的。用戶免費使用手機應用的同時,就在出讓部分個人信息,接受精準廣告的投放,再由廣告商付錢給手機應用,這就是現在的互聯網免費模式。

“法律不是說絕對地保護你的個人信息權益”,何淵解釋道。

但隨著相關制度的逐步健全,公民將擁有更多保護個人信息安全的途徑,比如集體訴訟、公益訴訟,以及基于《通用數據保護條例》(GDPR)等法規而開出的高額罰單,雖然“對于大企業來說,他們更怕的其實不是賠償,而是一種品牌的損失。”

技術是中立的,嗎?

算法在為我們提供極大生活便利的同時,也引發了不小的爭議。因此公眾又開始討論這個經典的議題:技術是中立的嗎?

“我始終認為技術本身是中立的,它產生的時候就是為了單純地解決一個技術難題”,互聯網資深軟件工程師Justin在接受澎湃新聞采訪時說道:“至于未來會變成什么樣,這并不是技術在發展的過程中會去考慮的。”

但也有不同的觀點。

“任何所謂‘中立’的東西,實際上都是有一些預定的功能指向性,尤其是人工制品”,復旦大學哲學學院徐英瑾教授舉了一個例子:“比如刺刀用來切菜肯定不合適,因為它的功能指向并不是用來切菜的。”

無論中立與否,和算法有關的爭議事件確實越來越多地走進了我們的視野,尤其是在新冠疫情的背景下。

比如,英國政府為了解決疫情無法舉辦高考的問題,決定采用算法對學生成績進行評定,但經過算法評定的學生成績出現了許多爭議。其中,英格蘭地區約40%的考生成績至少被調降了一個級別。2020年8月25日,英國的考試監管機構主任薩莉·科利爾宣布引咎辭職。

還有,2020年3月,一些網友指出,自己的健康碼莫名變成紅色。一名網友在知乎上寫道:全部行程軌跡正常、未與確診或疑似病例接觸、未去過疫區,但因為健康碼莫名變紅,當天沒地方住,在街邊過了夜。

這些算法與我們的日常生活息息相關,但很少人能了解背后的運行邏輯,“造成很強的技術屏障和知識屏障,不利于大眾對這樣的一套系統進行監督……構成某種意義上權力的不對等”,徐英瑾解釋道。

但算法不應該完全為這些爭議背鍋。正如前文所說,算法的形成離不開大量的訓練數據,這些數據就是人們的歷史行為。

2020年2月VOX的一篇文章寫道:“當電腦接觸到大量的數據,它會察覺到數據中反復出現的模式,然后依照這些模式形成自己判斷、評價、預測的邏輯。”換句話說,算法的運用,會放大社會中的歧視和偏見。

比如,墨爾本大學在2020年12月發表的一份研究表明,人工智能招聘軟件存在的性別歧視,可能源自于招聘者本身潛意識的歧視。這些研究人員在完全相同的簡歷上,一些標注性別,一些則抹掉性別,分發給40位招聘者。結果顯示,盡管男女應聘者的能力和經歷完全一致,招聘者還是給了男性更高的評分。甚至在抹掉性別的簡歷中,招聘者也更偏愛男性。

VOX的那篇文章認為,將各種算法背后的黑箱解釋清楚,是擺脫這些偏見爭議的第一步。一些學者認為,算法使用方最起碼應該公開他們的訓練數據、驗證數據和測試數據的人口特征。

徐英瑾的建議是,在訓練算法時,研究人員不應該只重復演算數據,而需要不斷汲取新的知識,然后手動修正相關的理解和預測。“因為沒有任何哲學上的理由告訴我們,未來發生的事情就一定和過去的事情是類似的。”

而且“人”的角色很重要。比如,Justin認為,推薦算法的弱點之一是“機器的目標通常是非常明確的,而我們想學到的東西,常常是不可量化的”,因此現在很多內容平臺會加入除機器推薦之外的策略。

不管怎么說,這條修正算法的道路將會很漫長,畢竟公司的利益往往是驅使算法發展的最大動力,而且我們身上人性的弱點也并非一朝一夕可以改變的。

但算法問題總算是進入了主流議題,這是我們社會邁出的一大步。