數據分析必備的5款Python爬蟲庫

在數據科學或人工智能領域,除了算法之外,最重要的應該是數據了。甚至可以說一個模型到最后決定其準確度的往往不是算法而是數據。在現實中,缺少足夠的數據成了數據分析師獲得優秀模型的主要阻礙。可喜的是,現在網絡爬蟲技術已經相當成熟,一個合格的數據分析師或者人工智能模型設計師應該或多或少熟練掌握幾種網絡爬蟲技術。

Python提供了大量的爬蟲庫,每個庫都有各自不同的特點,而在項目中如何選擇適合你的庫呢?本文主要列舉了5個當前非常流行的Python爬蟲庫,并列出了各自的優勢和劣勢,希望可以在你的工作和學習中有所幫助。

Requests庫

這是Web爬蟲最基本的庫。 “請求”的意思是向網站的服務器發出HTML請求,以檢索其頁面上的內容。獲取網頁的HTML內容是Web爬蟲的首要步驟。Requests用于發出各種類型的HTTP請求,例如GET,POST等。

優點:

- 使用簡單

- 支持基本身份驗證

- 支持國際域名和URL

- 支持分塊請求

- 支持HTTP和HTTPS代理

缺點:

- 只檢索頁面的靜態內容

- 不能用于解析HTML

- 無法處理純JavaScript制作的網站

lxml庫

Ixml是一種性能較高的HTML和XML的解析庫。特別適適合用于大型數據集的爬取解析。通常可以將Requests庫和Ixml庫結合使用。Ixml還允許你使用XPath和CSS選擇器從HTML提取數據。

優點:

- 速度快,效率高

- 比較輕巧

- 使用元素樹

- 支持Pythonic API接口

缺點:

- 不適用于設計不當的HTML

- 官方文檔不夠詳細,不太適合初學者

BeautifulSoup庫

BeautifulSoup庫因為其易用性并且非常適合初學者,所以可以說是當前Web爬取中使用最廣泛的Python庫。BeautifulSoup創建了一個解析樹,用于解析HTML和XML文檔。BeautifulSoup會自動將輸入文檔轉換為Unicode,將輸出文檔轉換為UTF-8。我們可以將BeautifulSoup與其他解析器(如lxml)結合使用。BeautifulSoup庫的一個主要優點是它可以與設計欠佳的HTML一起很好地工作。

優點:

- 簡單,非常簡單

- 功能強大

- 文檔比較全面

- 特別適合初學者

- 自動編碼檢測

缺點:

- 性能比lxml慢

- Selenium庫

前面講到的3種Python庫都有一定的局限性,既無法輕易地從動態填充的網站中抓取數據,這是因為動態網站的許多內容是通過JavaScript加載的。換句話說,如果頁面不是靜態的,那么前面提到的Python庫就很難從中抓取數據。Selenium庫就是用來解決上述問題。Selenium庫最初是用于網絡自動化測試的,在其他庫無法運行JavaScript的地方,Selenium能夠完美的解決。Selenium可以在網頁上實現控件點擊、填寫表格、滾動頁面等操作。

優點:

- 有足夠的學習文檔,適合初學者

- 自動爬取信息

- 可以抓取動態填充的網頁

- 可以在網頁上實現與人工相似的任何操作

缺點:

- 速度非常慢

- 設置比較困難

- CPU和內存使用率較高

- 不適用于大型項目

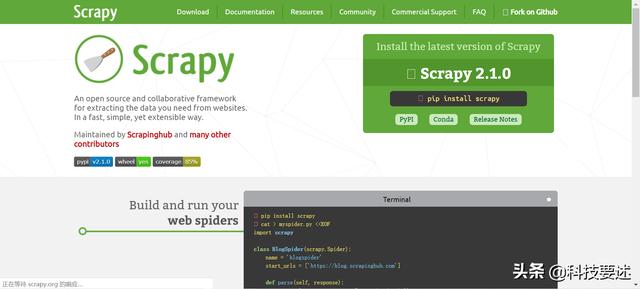

Scrapy庫

Python網絡爬蟲庫里的超級大BOSS。Scrapy提供的蜘蛛機器人(spider bots)可以爬取多個網站并提取數據。Scrapy最大的優點是異步爬取,它可以同時發出多個HTTP請求,所以爬取效率很高。

優點:

- 異步

- 幫助文檔較多

- 支持各種插件

- 創建自定義管道和中間件

- CPU和內存使用率低

- 有大量可用的在線資源

缺點:

- 學習難度比前幾種大

- 不適合初學者

總結

Python網絡爬蟲庫,每個庫都是針對不同的使用場景設計的,沒有哪個最好,只有哪個更適合你,在使用過程中需要你綜合考慮使用場景,畢竟在數據分析的人工智能的世界中往往是性能和計算機資源不可兼得。