Google 開源最新 NLP 模型,能處理整本《罪與罰》

Transformer 可謂是近年 NLP 領域關注度頗高的模型之一。

- 2017 年,Google 發表題為“Attention Is All You Need”的論文,提出了完全基于注意力機制(attention mechanism)的網絡框架 Transformer。

- 2018 年,Google 開源了基于 Transformer 的 BERT 模型,在 NLP 領域大火。

- 2019 年,機器學習領域最大的趨勢之一便是基于 Transformer 的自然語言模型的持續增長和擴散。

- 2020 年,根據自然語言處理領域數據集 GLUE 的排行榜,一些表現最佳的模型——包括 Nvidia 的 Megatron、Google 的 XLNet、微軟的 MT-DNN 和 Facebook 的 Roberta——都基于 Transformer。

近日,Google 又推出了 Transformer 的“升級版”——Reformer。

【 圖片來源:VentureBeat 所有者:VentureBeat 】

比 Transformer 更高效

對人工智能和機器學習模型來說,不管是語言、音樂、語音還是視頻,序列數據都不好理解——尤其是在廣泛的環境中。例如,如果一個人或一個物體從視頻中消失很久后才重新出現,許多算法就會忘記它的樣子。

因此,Google 開發了機器翻譯模型 Transformer,希望解決這一問題。Transformer 是一個擴展到數千個單詞的架構,極大地提升了在完成作曲、圖像合成、逐句文本翻譯和文檔摘要等任務時的性能。

與所有深度神經網絡一樣,Transformer 包含連接層中的神經元(數學函數),可傳輸來自輸入數據的信號,并緩慢調整每個連接的突觸強度(權重),這是所有人工智能模型提取特征和學習預測的方式,但是 Transformer 能獨特地注意到每個輸出元素都與每個輸入元素相關聯,它們之間的權重實際上是動態計算的。

不過,Transformer 并不是完美的——將其擴展到更大的環境中就能明顯看出局限性。大窗口應用程序的內存從千兆字節到兆兆字節不等,也就是說模型只能吸收幾段文本或生成一小段音樂。

基于此,Google 推出 Reformer 作為 Transformer 的演進,Reformer 能夠處理多達 100 萬字的環境,僅用 16GB 的存儲器就能在單個 AI 加速器芯片上運行。

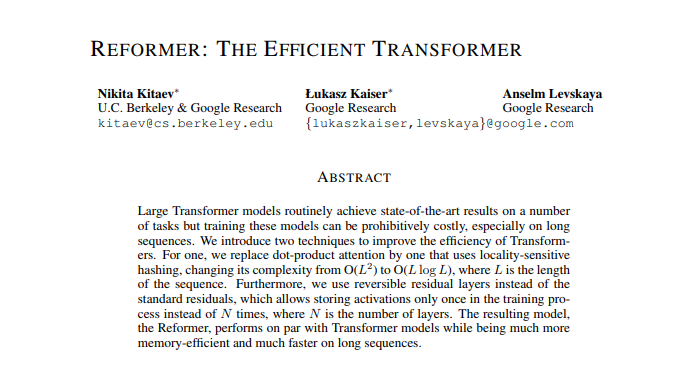

雷鋒網(公眾號:雷鋒網)了解到,相關論文“Reformer:The Efficient Transformer”已被將于 2020 年 4 月在埃塞俄比亞舉行的自然語言處理頂會 ICLR-2020(International Conference on Learning Representations)接收,當前模型也已開源。

根據論文,Reformer 主要包含以下技術:

- 第一,可逆層在整個模型中只存儲激活函數的單個副本,因此 N 因子消失;

- 第二,在前饋層內拆分激活函數,并進行分段處理,消除 dff 因子,節省前饋層內存;

- 第三,利用局部敏感哈希(雷鋒網注: LSH,即一種哈希算法,主要運用到高維海量數據的快速近似查找)。具體來講,哈希函數即一種將任意大小的數據映射到固定大小的值的函數,該函數匹配相似的向量(即表示機器學習中人類可讀數據的代數構造),而不是在所有可能的向量對中搜索。

例如,在翻譯任務中,來自網絡第一層的每個向量表示一個詞,對應于不同語言中相同詞的向量可以獲得相同的哈希值。當分配哈希時,序列會重新排列,接著按元素的哈希值分類,實現并行處理,這樣降低了長序列的復雜度,極大地減少了計算負荷。

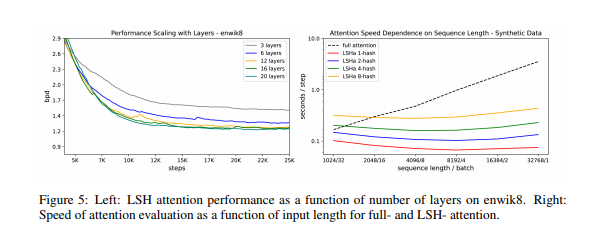

Reformer 可處理整部小說

為驗證 Reformer 確實能夠在單個 GPU 上運行,并可在長序列上快速訓練,研究人員在 enwik8 和 imagenet64 數據集上對 20 層的 Reformer 模型進行了訓練。實驗表明,Reformer 能達到與 Transformer 相同的性能,并且內存效率更高,在長序列任務上訓練更快。

另外,研究小組還對基于 Reformer 的圖像和文本模型進行了實驗,用它們生成圖像中缺失的細節,還處理了小說《罪與罰》(包含約 211591 個單詞)全文。研究表明,Reformer 能夠逐像素地生成全幀圖像,并且能夠在單輪訓練中接收小說長度的文本。

Google 科學家 Łukasz Kaiser 和加州大學伯克利分校學生 Nikita Kitaev 都對這項研究作出了貢獻,他們在一篇博客中寫道:

- 由于 Reformer 效率極高,它可以直接應用于上下文窗口遠大于當前幾乎所有最先進文本域的數據,Reformer 處理如此龐大數據集的能力可能也會刺激社區創建數據集。

據悉,論文作者們還會進一步將該其應用于更廣闊的領域(如時間序列預測及音樂、圖像、視頻生成),并改進對位置編碼的處理。Łukasz Kaiser 和 Nikita Kitaev 補充說:

我們相信 Reformer 為將來使用 Transformer 模型對長文本和自然語言處理以外的應用也打下了基礎。

2019 年年底,外媒 VentureBeat 曾采訪過 Google 高級副總裁 Jeff Dean,他在采訪中表示:

- Google 仍然希望能建立更多的情境模型,就像現在一樣,BERT 等模型可以處理數百個單詞,但不能處理 1 萬個單詞。所以這會是 Google 未來主要關注的方向。

而 Reformer 似乎是朝著這一方向邁出的充滿希望的第一步。

本文轉自雷鋒網,如需轉載請至雷鋒網官網申請授權。