LSTM、GRU與神經(jīng)圖靈機(jī):詳解深度學(xué)習(xí)最熱門的循環(huán)神經(jīng)網(wǎng)絡(luò)

循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN/recurrent neural network)是一類人工神經(jīng)網(wǎng)絡(luò),其可以通過為網(wǎng)絡(luò)添加額外的權(quán)重來在網(wǎng)絡(luò)圖(network graph)中創(chuàng)建循環(huán),以便維持一個(gè)內(nèi)部狀態(tài)。

為神經(jīng)網(wǎng)絡(luò)添加狀態(tài)的好處是它們將能在序列預(yù)測(cè)問題中明確地學(xué)習(xí)和利用背景信息(context),這類問題包括帶有順序或時(shí)間組件的問題。

在這篇文章中,你將踏上了解用于深度學(xué)習(xí)的循環(huán)神經(jīng)網(wǎng)絡(luò)的旅程。

在讀完這篇文章后,你將了解:

- 用于深度學(xué)習(xí)的***循環(huán)神經(jīng)網(wǎng)絡(luò)的工作方式,其中包括 LSTM、GRU 和 NTM。

- *** RNN 與人工神經(jīng)網(wǎng)絡(luò)中更廣泛的循環(huán)(recurrence)研究的相關(guān)性。

- RNN 研究如何在一系列高難度問題上實(shí)現(xiàn)了當(dāng)前***的表現(xiàn)。

注意,我們并不會(huì)覆蓋每一種可能的循環(huán)神經(jīng)網(wǎng)絡(luò),而是會(huì)重點(diǎn)關(guān)注幾種用于深度學(xué)習(xí)的循環(huán)神經(jīng)網(wǎng)絡(luò)(LSTM、GRU 和 NTM)以及用于理解它們的背景。

那就讓我們開始吧!

概述

我們首先會(huì)設(shè)置循環(huán)神經(jīng)網(wǎng)絡(luò)領(lǐng)域的場(chǎng)景;然后,我們將深入了解用于深度學(xué)習(xí)的 LSTM、GRU 和 NTM;之后我們會(huì)花點(diǎn)時(shí)間介紹一些與用于深度學(xué)習(xí)的 RNN 相關(guān)的高級(jí)主題。

- 循環(huán)神經(jīng)網(wǎng)絡(luò)

- 完全循環(huán)網(wǎng)絡(luò)(Fully Recurrent Networks)

- 遞歸神經(jīng)網(wǎng)絡(luò)(Recursive Neural Networks)

- 神經(jīng)歷史壓縮器(Neural History Compressor)

- 長短期記憶網(wǎng)絡(luò)(LSTM)

- 門控循環(huán)單元(GRU)神經(jīng)網(wǎng)絡(luò)

- 神經(jīng)圖靈機(jī)(NTM)

循環(huán)神經(jīng)網(wǎng)絡(luò)

首先讓我們?cè)O(shè)置場(chǎng)景。

人們普遍認(rèn)為循環(huán)(recurrence)是給網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)提供一個(gè)記憶(memory)。

一種更好的看法是訓(xùn)練集包含一種樣本——其帶有一組用于循環(huán)訓(xùn)練樣本的輸入。這是「?jìng)鹘y(tǒng)的慣例」,比如傳統(tǒng)的多層感知器

X(i) -> y(i)

但是該訓(xùn)練樣本得到了來自之前的樣本的一組輸入的補(bǔ)充。這是「非傳統(tǒng)的」,比如循環(huán)神經(jīng)網(wǎng)絡(luò)

[X(i-1), X(i)] -> y(i)

和所有的前饋網(wǎng)絡(luò)范式一樣,問題的關(guān)鍵是如何將輸入層連接到輸出層(包括反饋激活),然后訓(xùn)練該結(jié)構(gòu)使其收斂。

現(xiàn)在,讓我們來看看幾種不同的循環(huán)神經(jīng)網(wǎng)絡(luò),首先從非常簡(jiǎn)單的概念開始

完全循環(huán)網(wǎng)絡(luò)

多層感知器的分類結(jié)構(gòu)得到了保留,但該架構(gòu)中的每個(gè)元素與其它每個(gè)元素之間都有一個(gè)加權(quán)的連接,并且還有一個(gè)與其自身的反饋連接。

并不是所有這些連接都會(huì)被訓(xùn)練,而且其誤差導(dǎo)數(shù)的極端非線性意味著傳統(tǒng)的反向傳播無法起效,因此只能使用通過時(shí)間的反向傳播(Backpropagation Through Time)方法或隨機(jī)梯度下降(SGD)。

- 另外,可參閱 Bill Willson 的張量積網(wǎng)絡(luò)(Tensor Product Networks):http://www.cse.unsw.edu.au/~billw/cs9444/tensor-stuff/tensor-intro-04.html

遞歸神經(jīng)網(wǎng)絡(luò)

循環(huán)神經(jīng)網(wǎng)絡(luò)是遞歸網(wǎng)絡(luò)的線性架構(gòu)變體。

遞歸(recursion)可以促進(jìn)分層特征空間中的分支,而且其所得到的網(wǎng)絡(luò)架構(gòu)可以在訓(xùn)練進(jìn)行中模擬它。

其訓(xùn)練是通過子梯度方法(sub-gradient methods)使用隨機(jī)梯度實(shí)現(xiàn)的。

R. Socher 等人 2011 年的論文《Parsing Natural Scenes and Natural Language with Recursive Neural Networks》中使用 R 語言對(duì)其進(jìn)行了詳細(xì)的描述,參閱:http://machinelearning.wustl.edu/mlpapers/paper_files/ICML2011Socher_125.pdf

神經(jīng)歷史壓縮器

在 1991 年,Schmidhuber 首先報(bào)告了一種非常深度的學(xué)習(xí)器,其可以通過一種 RNN 層次的無監(jiān)督預(yù)訓(xùn)練來在數(shù)百個(gè)神經(jīng)層上執(zhí)行功勞分配(credit assignment)。

每個(gè) RNN 都是無監(jiān)督訓(xùn)練的,可以預(yù)測(cè)下一個(gè)輸入。然后只有產(chǎn)生錯(cuò)誤的輸入會(huì)被前饋,將新信息傳送到該層次結(jié)構(gòu)中的下一個(gè) RNN,然后以更慢的、自組織的時(shí)間尺度進(jìn)行處理。

事實(shí)表明不會(huì)有信息丟失,只是會(huì)有壓縮。該 RNN stack 是數(shù)據(jù)的一個(gè)「深度生成模型(deep generative model)。這些數(shù)據(jù)可以根據(jù)其壓縮形式重建。

- 參閱 J. Schmidhuber 等人 2014 年的論文《Deep Learning in Neural Networks: An Overview》:http://www2.econ.iastate.edu/tesfatsi/DeepLearningInNeuralNetworksOverview.JSchmidhuber2015.pdf

當(dāng)誤差被反向傳播通過大型結(jié)構(gòu)時(shí),非線性導(dǎo)數(shù)的極限(extremity)的計(jì)算會(huì)增長,會(huì)使功勞分配(credit assignment)困難甚至是不可能,使得反向傳播失敗。

長短期記憶網(wǎng)絡(luò)

使用傳統(tǒng)的通過時(shí)間的反向傳播(BPTT)或?qū)崟r(shí)循環(huán)學(xué)習(xí)(RTTL/Real Time Recurrent Learning),在時(shí)間中反向流動(dòng)的誤差信號(hào)往往會(huì)爆炸(explode)或消失(vanish)

反向傳播誤差的時(shí)間演化指數(shù)式地依賴于權(quán)重的大小。權(quán)重爆炸可能會(huì)導(dǎo)致權(quán)重振蕩,而權(quán)重消失則可能導(dǎo)致學(xué)習(xí)彌合時(shí)間滯后并耗費(fèi)過多時(shí)間或根本不工作。

- LSTM 是一種全新的循環(huán)網(wǎng)絡(luò)架構(gòu),可用一種合適的基于梯度的學(xué)習(xí)算法進(jìn)行訓(xùn)練。

- LSTM 是為克服誤差反向流動(dòng)問題(error back-flow problem)而設(shè)計(jì)的。它可以學(xué)習(xí)橋接超過 1000 步的時(shí)間間隔。

- 在有噪聲的、不可壓縮的輸入序列存在,而沒有短時(shí)間滯后能力的損失時(shí),這是真實(shí)的。

通過一種有效的基于梯度的算法,誤差反向流動(dòng)問題可以克服,因?yàn)樵撍惴ㄗ尵W(wǎng)絡(luò)架構(gòu)可以強(qiáng)迫常量(因此不會(huì)有爆炸或消失)誤差流過特殊單元的內(nèi)部狀態(tài)。這些單元可以減少「輸入權(quán)重沖突(Input Weight Conflict)」和「輸出權(quán)重沖突(Output Weight Conflict)」的影響。

輸入權(quán)重沖突:如果輸入是非零的,則同樣的輸入權(quán)重必須被同時(shí)用于存儲(chǔ)特定的輸入并忽略其它輸入,那么這就將會(huì)經(jīng)常收到有沖突的權(quán)重更新信號(hào)。

這些信號(hào)將會(huì)試圖使該權(quán)重參與存儲(chǔ)輸入并保護(hù)該輸入。這種沖突會(huì)使學(xué)習(xí)變得困難,并且需要一個(gè)對(duì)背景更敏感的機(jī)制來通過輸入權(quán)重控制「寫入操作(write operations)」。

輸出權(quán)重沖突:只要一個(gè)單元的輸出是非零的,那么這個(gè)單元的輸出連接的權(quán)重就將吸引在序列處理過程中生成的有沖突的權(quán)重更新信號(hào)。

這些信號(hào)將試圖使正在輸出的權(quán)重參與進(jìn)來,獲取存在在處理單元中信息,并且在不同的時(shí)間保護(hù)后續(xù)的單元免受正被饋送的單元的輸出的干擾。

這些沖突并不特定于長期滯后(long-term lags),并且也可以同樣影響到短期滯后(short-term lags)。值得注意的是,隨著滯后的增長,存儲(chǔ)的信息必須被保護(hù)起來免受干擾,尤其是在學(xué)習(xí)的高級(jí)階段。

網(wǎng)絡(luò)架構(gòu):不同類型的單元都可能傳遞關(guān)于網(wǎng)絡(luò)當(dāng)前狀態(tài)的有用信息。比如說,一個(gè)輸入門(輸出門)可能會(huì)使用來自其它記憶單元(memory cell)的輸入來決定是否存儲(chǔ)(讀取)其記憶單元中的特定信息。

記憶單元包含門(gate)。門特定于它們調(diào)解的連接。輸入門是為了糾正輸入權(quán)重沖突,而輸出門是為了消除輸出權(quán)重沖突。

門:具體來說,為了緩解輸入和輸出權(quán)重沖突以及干擾,我們引入了一個(gè)乘法輸入門單元來保護(hù)存儲(chǔ)的記憶內(nèi)容免受不相關(guān)輸入的干擾,還引入了一個(gè)乘法輸出門單元來保護(hù)其它單元免受存儲(chǔ)中當(dāng)前不相關(guān)記憶內(nèi)容的干擾。

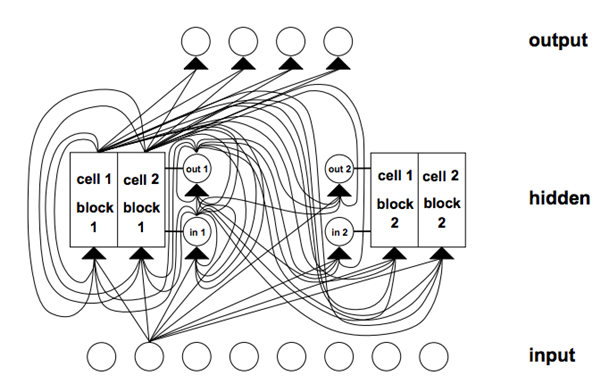

LSTM 架構(gòu)示例。這個(gè) LSTM 網(wǎng)絡(luò)帶有 8 個(gè)輸入單元、4 個(gè)輸出單元和 2 個(gè)大小為 2 的記憶單元模塊。in1 是指輸入門,out1 是指輸出門,cell1 = block1 是指 block 1 的***個(gè)記憶單元。來自 1997 年的《Long Short-Term Memory》

因?yàn)樘幚碓氐亩鄻有院头答佭B接的,LSTM 中的連接比多層感知器的連接復(fù)雜。

記憶單元模塊:記憶單元共享同一個(gè)輸入門和同一個(gè)輸出門,構(gòu)成一種名叫記憶單元模塊(memory cell block)的結(jié)構(gòu)。

記憶單元模塊有利于信息存儲(chǔ);就像傳統(tǒng)的神經(jīng)網(wǎng)絡(luò)一樣,在單個(gè)單元內(nèi)編碼一個(gè)分布式輸入可不是一件容易的事情。一個(gè)大小為 1 的記憶單元模塊就是一個(gè)簡(jiǎn)單的記憶單元。

學(xué)習(xí)(Learning):一種考慮了由輸入和輸出門導(dǎo)致的修改過的、乘法動(dòng)態(tài)的實(shí)時(shí)循環(huán)學(xué)習(xí)(RTRL/Real Time Recurrent Learning)的變體被用于確保通過記憶單元誤差的內(nèi)部狀態(tài)反向傳播到達(dá)「記憶單元網(wǎng)絡(luò)輸入(memory cell net inputs)」的非衰減誤差(non-decaying error)不會(huì)在時(shí)間中被進(jìn)一步反向傳播。

猜測(cè)(Guessing):這種隨機(jī)方法可以超越許多時(shí)間滯后算法。事實(shí)已經(jīng)說明,之前的工作中所使用的許多長時(shí)間滯后任務(wù)可以通過簡(jiǎn)單的隨機(jī)權(quán)重猜測(cè)得到比提出的算法更快的解決。

- 參見 S. Hochreiter 和 J. Schmidhuber《Long-Short Term Memory》:http://dl.acm.org/citation.cfm?id=1246450

LSTM 循環(huán)神經(jīng)網(wǎng)絡(luò)最有意思的應(yīng)用出現(xiàn)在語言處理領(lǐng)域。更全面的描述可參閱 Gers 的論文 :

- F. Gers 和 J. Schmidhuber 2001 年的論文《LSTM Recurrent Networks Learn Simple Context Free and Context Sensitive Languages》:ftp://ftp.idsia.ch/pub/juergen/L-IEEE.pdf

- F. Gers 2001 年的博士論文《Long Short-Term Memory in Recurrent Neural Networks》:http://www.felixgers.de/papers/phd.pdf

LSTM 的局限性

LSTM 有效的截?cái)喟姹緹o法輕松解決類似于「強(qiáng)延遲的異或(strongly delayed XOR)」這樣的問題。

每個(gè)記憶單元模塊都需要一個(gè)輸入門和一個(gè)輸出門。并不一定需要其它循環(huán)方法。

在記憶單元內(nèi)穿過「常量誤差傳送帶(Constant Error Carrousels)」的常量誤差流可以得到與傳統(tǒng)的前饋架構(gòu)(會(huì)一次性獲得整個(gè)輸入串)一樣的效果。

和其它前饋方法一樣,LSTM 也有「regency」概念上的缺陷。如果需要精密的計(jì)數(shù)時(shí)間步驟,那么可能就需要額外的計(jì)數(shù)機(jī)制。

LSTM 的優(yōu)點(diǎn)

該算法橋接長時(shí)間滯后的能力來自其架構(gòu)的記憶單元中的常量誤差反向傳播。

LSTM 可以近似有噪聲的問題域、分布式表征和連續(xù)值。

LSTM 可以很好地泛化其所考慮的問題域。這是很重要的,因?yàn)橛械娜蝿?wù)無法用已有的循環(huán)網(wǎng)絡(luò)解決。

在問題域上對(duì)網(wǎng)絡(luò)參數(shù)進(jìn)行微調(diào)看起來是不必要的。

在每個(gè)權(quán)重和時(shí)間步的更新復(fù)雜度方面,LSTM 基本上就等于 BPTT。

LSTM 很強(qiáng)大,在機(jī)器翻譯等領(lǐng)域?qū)崿F(xiàn)了當(dāng)前***的結(jié)果。

門控循環(huán)單元神經(jīng)網(wǎng)絡(luò)

門控循環(huán)單元神經(jīng)網(wǎng)絡(luò)已經(jīng)在序列和時(shí)間數(shù)據(jù)上得到了成功的應(yīng)用。

最適合語音識(shí)別、自然語言處理和機(jī)器翻譯。與 LSTM 一起,它們?cè)陂L序列問題領(lǐng)域表現(xiàn)優(yōu)良。

門控(gating)被認(rèn)為是在 LSTM 主題中,涉及到一個(gè)門控網(wǎng)絡(luò)生成信號(hào)來控制當(dāng)前輸入和之前記憶發(fā)生作用的方式,以更新當(dāng)前的激活,從而更新當(dāng)前的網(wǎng)絡(luò)狀態(tài)。

門本身是自我加權(quán)的,會(huì)在整個(gè)學(xué)習(xí)階段中根據(jù)一個(gè)算法有選擇性地更新。

門網(wǎng)絡(luò)會(huì)增加計(jì)算復(fù)雜度,從而會(huì)增加參數(shù)化(parameterization),進(jìn)而引入額外的計(jì)算成本。

LSTM RNN 架構(gòu)將簡(jiǎn)單 RNN 的計(jì)算用作內(nèi)部記憶單元(狀態(tài))的中間候選項(xiàng)。門控循環(huán)單元(GRU)RNN 將 LSTM RNN 模型的門控信號(hào)減少到了 2 個(gè)。這兩個(gè)門分別被稱為更新門(update gate)和重置門(reset gate)。

GRU(和 LSTM)RNN 的門控機(jī)制和在參數(shù)化方面的簡(jiǎn)單 RNN 一樣。對(duì)應(yīng)這些門的權(quán)重也使用 BPTT 隨機(jī)梯度下降來更新,因?yàn)槠湟噲D最小化成本函數(shù)。

每個(gè)參數(shù)更新都將涉及到與整體網(wǎng)絡(luò)的狀態(tài)相關(guān)的信息。這可能會(huì)有不利影響。

門控的概念可使用三種新變體的門控機(jī)制來探索和擴(kuò)展。

這三種門控變體為:GRU1(其中僅使用之前的隱藏狀態(tài)和偏置來計(jì)算每個(gè)門——、GRU2(其中僅使用之前的隱藏狀態(tài)來計(jì)算每個(gè)門—)和 GRU3(其中僅使用偏置來計(jì)算每個(gè)門)。我們可以觀察到參數(shù)顯著減少,其中 GRU3 的參數(shù)數(shù)量最小。

這三種變體和 GRU RNN 在手寫數(shù)字的 MNIST 數(shù)據(jù)庫和 IMDB 電影評(píng)論數(shù)據(jù)集上進(jìn)行了基準(zhǔn)測(cè)試。

從 MNIST 數(shù)據(jù)集生成了 2 個(gè)序列長度,而從 IMDB 數(shù)據(jù)集生成了 1 個(gè)序列長度。

這些門的主要驅(qū)動(dòng)信號(hào)似乎是(循環(huán))狀態(tài),因?yàn)槠浒P(guān)于其它信號(hào)的基本信息。

隨機(jī)梯度下降的使用隱含地?cái)y帶了有關(guān)網(wǎng)絡(luò)狀態(tài)的信息。這可以解釋僅在門信號(hào)中使用偏置的相對(duì)成功,因?yàn)槠渥赃m應(yīng)更新攜帶了有關(guān)網(wǎng)絡(luò)狀態(tài)的信息。

門控變體可使用有限的拓?fù)浣Y(jié)構(gòu)評(píng)估來探索門控機(jī)制。

更多信息請(qǐng)參閱:

- R. Dey 和 F. M. Salem 2017 年的論文《Gate-Variants of Gated Recurrent Unit (GRU) Neural Networks》:https://arxiv.org/ftp/arxiv/papers/1701/1701.05923.pdf

- J. Chung 等人 2014 年的論文《Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling》:https://pdfs.semanticscholar.org/2d9e/3f53fcdb548b0b3c4d4efb197f164fe0c381.pdf

神經(jīng)圖靈機(jī)

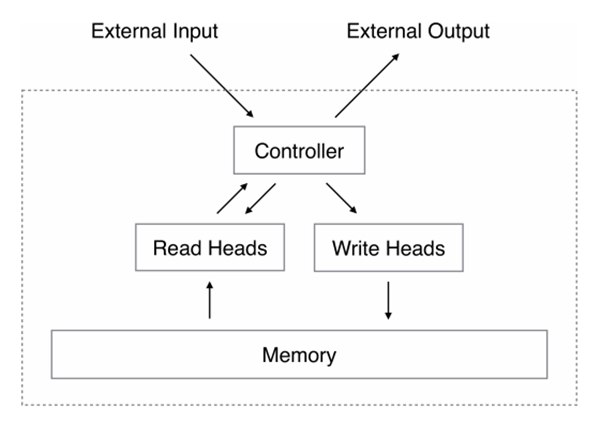

神經(jīng)圖靈機(jī)通過將神經(jīng)網(wǎng)絡(luò)與外部記憶資源耦合而對(duì)該神經(jīng)網(wǎng)絡(luò)的能力進(jìn)行了延展——它們可以通過注意(attention)過程與外部記憶資源交互。參閱機(jī)器之心文章《神經(jīng)圖靈機(jī)深度講解:從圖靈機(jī)基本概念到可微分神經(jīng)計(jì)算機(jī)》。

這種組合的系統(tǒng)類似于圖靈機(jī)或馮·諾依曼結(jié)構(gòu),但它是端到端可微分的,使得其可以有效地使用梯度下降進(jìn)行訓(xùn)練。

初步的結(jié)果表明神經(jīng)圖靈機(jī)可以根據(jù)輸入和輸出樣本推理得到基本的算法,比如復(fù)制、排序和聯(lián)想回憶(associative recall)。

RNN 相比于其它機(jī)器學(xué)習(xí)方法的突出之處在于其在長時(shí)間范圍內(nèi)學(xué)習(xí)和執(zhí)行數(shù)據(jù)的復(fù)雜轉(zhuǎn)換的能力。此外,我們都知道 RNN 是圖靈完備的,因此其有能力模擬任意程序,只要連接方式合適即可。

標(biāo)準(zhǔn) RNN 的能力被擴(kuò)展以簡(jiǎn)化算法任務(wù)的解決方案。這種豐富性主要是通過一個(gè)巨大的可尋址的記憶實(shí)現(xiàn)的,所以通過類比于圖靈的通過有線存儲(chǔ)磁帶實(shí)現(xiàn)的有限狀態(tài)機(jī)(finite-state machine)的豐富性,其被命名為神經(jīng)圖靈機(jī)(NTM)。

和圖靈機(jī)不同,神經(jīng)圖靈機(jī)是一種可微分的計(jì)算機(jī),可以通過梯度下降訓(xùn)練,從而為學(xué)習(xí)程序提供了一種實(shí)用的機(jī)制。

神經(jīng)圖靈機(jī)架構(gòu)。NTM 架構(gòu)大體上如上所示。在每一個(gè)更新循環(huán)中,控制器網(wǎng)絡(luò)接收一個(gè)來自外部環(huán)境的輸入并給出一個(gè)輸出作為響應(yīng)。它也會(huì)通過一系列并行的讀寫頭來讀寫一個(gè)記憶矩陣(memory matrix)。虛線是 NTM 回路與外部世界的分界線。來自 2014 年的《Neural Turing Machines》

關(guān)鍵在于,該架構(gòu)的每個(gè)組件都是可微分的,使其可以直接使用梯度下降進(jìn)行訓(xùn)練。這可以通過定義「模糊(blurry)」的讀寫操作來實(shí)現(xiàn),其可以或多或少地與記憶中的所有元素進(jìn)行交互(而非像普通的圖靈機(jī)或數(shù)字計(jì)算機(jī)那樣處理單個(gè)元素)。

更多信息請(qǐng)參閱:

- A. Graves 等人 2014 年的《Neural Turing Machines》:https://arxiv.org/pdf/1410.5401.pdf

- R. Greve 等人 2016 年的《Evolving Neural Turing Machines for Reward-based Learning》:http://sebastianrisi.com/wp-content/uploads/greve_gecco16.pdf

NTM 實(shí)驗(yàn)

復(fù)制(copy)任務(wù)可以測(cè)試 NTM 是否可以存儲(chǔ)和回調(diào)長序列的任意信息。向該網(wǎng)絡(luò)提供一個(gè)隨機(jī)二進(jìn)制向量的輸入序列,后面跟著一個(gè)分隔符。

該網(wǎng)絡(luò)被訓(xùn)練用來復(fù)制 8 位的隨機(jī)向量序列,其中序列長度是在 1 到 20 之間隨機(jī)的。目標(biāo)序列就僅僅是輸入序列的副本而已(沒有分隔符)。

重復(fù)復(fù)制任務(wù)是復(fù)制任務(wù)的擴(kuò)展,即要求該網(wǎng)絡(luò)輸出被復(fù)制的序列給定的次數(shù),然后給出一個(gè)序列終止標(biāo)志。這個(gè)任務(wù)的主要目的是看 NTM 是否可以學(xué)習(xí)簡(jiǎn)單的嵌套函數(shù)。

該網(wǎng)絡(luò)的輸入是隨機(jī)長度的隨機(jī)二進(jìn)制向量序列,后面跟著一個(gè)標(biāo)量值,表示我們想要的副本的數(shù)量,其出現(xiàn)在一個(gè)單獨(dú)的輸入信道上。

聯(lián)想記憶任務(wù)(associative recall tasks)涉及到組織間接產(chǎn)生的數(shù)據(jù),即當(dāng)一個(gè)數(shù)據(jù)項(xiàng)指向另一個(gè)項(xiàng)的時(shí)候。要?jiǎng)?chuàng)建一個(gè)項(xiàng)列表,使得查詢其中一個(gè)項(xiàng)時(shí)需要該網(wǎng)絡(luò)返回后續(xù)的項(xiàng)。

我們定義了一個(gè)二進(jìn)制向量序列,通過分隔符對(duì)其左右進(jìn)行了限制。在幾個(gè)項(xiàng)被傳播到該網(wǎng)絡(luò)中后,通過展示隨機(jī)項(xiàng)對(duì)該網(wǎng)絡(luò)進(jìn)行查詢,看該網(wǎng)絡(luò)是否可以產(chǎn)生下一個(gè)項(xiàng)。

動(dòng)態(tài) N-gram 任務(wù)測(cè)試的是 NTM 是否可以通過使用記憶作為可覆寫的表格來快速適應(yīng)新的預(yù)測(cè)分布;該網(wǎng)絡(luò)可以使用這個(gè)表格來持續(xù)對(duì)轉(zhuǎn)換統(tǒng)計(jì)保持計(jì)數(shù),從而模擬傳統(tǒng)的 N-gram 模型。

考慮在二進(jìn)制序列上的所有可能的 6-gram 分布的集合。每個(gè) 6-gram 分布都可以被表達(dá)成一個(gè)有 32 個(gè)數(shù)字的表格,其基于所有可能長度的 5 個(gè)二進(jìn)制歷史指定了下一位(bit)為 1 的概率。通過使用當(dāng)前的查找表繪制 200 個(gè)連續(xù)的位,會(huì)生成一個(gè)特定的訓(xùn)練序列。該網(wǎng)絡(luò)對(duì)該序列進(jìn)行觀察,一次一位,然后被要求預(yù)測(cè)出下一位。

優(yōu)先級(jí)排序任務(wù)測(cè)試的是 NTM 的排序能力。該網(wǎng)絡(luò)的輸入是一個(gè)隨機(jī)二進(jìn)制向量的序列,以及每個(gè)向量的一個(gè)標(biāo)量?jī)?yōu)先級(jí)評(píng)分。該優(yōu)先級(jí)是在 [-1, 1] 范圍內(nèi)均勻分布的。目標(biāo)序列是根據(jù)它們的優(yōu)先級(jí)排序后的二進(jìn)制向量序列。

NTM 有 LSTM 的前饋結(jié)構(gòu)作為它們的組件之一。

總結(jié)

你通過這篇文章了解了用于深度學(xué)習(xí)的循環(huán)神經(jīng)網(wǎng)絡(luò)。具體來說,你了解了:

- 用于深度學(xué)習(xí)的***循環(huán)神經(jīng)網(wǎng)絡(luò)的工作方式,其中包括 LSTM、GRU 和 NTM。

- *** RNN 與人工神經(jīng)網(wǎng)絡(luò)中更廣泛的循環(huán)(recurrence)研究的相關(guān)性。

- RNN 研究如何在一系列高難度問題上實(shí)現(xiàn)了當(dāng)前***的表現(xiàn)。

聲明:本文轉(zhuǎn)自機(jī)器之心,原文來自MachineLearningMastery,作者Jason Brownlee,譯者熊貓。