開源大數據平臺實施和使用中的難點

開源大數據技術是一種新一代技術和構架,它以成本較低、以快速的采集、處理和分析技術,從各種超大規模的數據中提取價值。大數據技術不斷涌現和發展,讓我們處理海量數據更加容易、更加便宜和迅速,成為分析和挖掘海量數據價值的一個利器,甚至可以改變許多行業的商業模式。

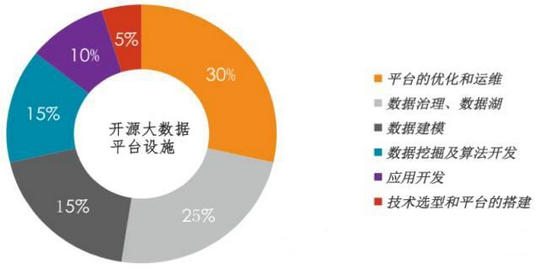

龐大的開源大數據技術體系,使得大數據平臺在實施和使用的過程中遇到很多難點,Think Big團隊總結了在開源大數據平臺設施的整個過程及花費的時間,如下圖所示:

大數據平臺的優化和運維

大數據平臺的優化和運維應該是開源大數據平臺實施的難點、也是構建大數據平臺對人員的技術和經驗要求***的階段,貫穿整個大數據平臺實施過程。

大數據平臺的數據整合、數據治理和數據湖

對于傳統的企業使用大數據平臺,數據整合、數據治理和數據湖也是非常重要和比較困難的階段,全公司不同數據源之間的數據整合面臨:數據的一致性、數據的完整性、數據的準確性、數據的安全等問題如何解決,當然還有不同數據(如:冷數據、溫數據和熱數據)怎么來存放,進而實現高效的數據存儲和分析。這些都是我們在大數據實施過程中需要花很多時間和經驗來實現的,很多的公司基本上都在直接或間接的使用大數據技術,有可能感覺大數據整合、治理、數據湖沒有那么重要,把功能實現了,就覺得把大數據平臺用的非常好了,其實不然,就像我上面提到的那張圖,功能的實現只占大數據平臺實施的一小部分。

大數據平臺上面的數據建模

由于大數據平臺面臨數據的一致性、數據的完整性、數據的準確性等問題所以導致大數據平臺上面的建模變得比較困難,此外還有不同行業面臨的大數據平臺建模問題各不相同。傳統行業在大數據上面的建模面臨的挑戰還是非常多的,有的模型甚至不適合在開源大數據平臺上面建模,不要一味的去和互聯行業大數據平臺上面的應用做比較,因為,互聯網的業務比傳統的業務模型簡單很多。

數據挖掘和算法的實現

大數據平臺的數據挖掘技術有Hadoop的Mahout、Spark的Mllib、SparkR等,這個現有的挖掘庫存在很多問題,如:分布式計算。對整個團隊的人員要求非常的高。

應用開發(類似于傳統EDW的BI功能)

類似于在Hadoop上面實現一個傳統的EDW的功能,常見用的比較多的就是SQL on Hadoop技術,如:Hive、Impala、Tez、Presto、Kylin、SparkSQL等。

大數據平臺的選擇和搭建

主要是Apache Hadoop、Hortonworks HDP和Cloudera CDH的選擇,Apache Hadoop是純開源的,Hortonworks HDP是開源Hadoop生態系統的管理,Cloudera CDH是開源Hadoop生態系統的增強。