基于性能需求看存儲:從調侃OpenStack和Ceph談起

在OpenStack之前,這幾年被人們談論最多的開源項目應該是Linux和Hadoop。

當然Linux時間比較長了,對于它一直的茁壯成長,根據我從外界的了解,可能與Linus本人對內核的控制力度強有關,還有***的商業發行版RedHat(同樣開源,包括對應的CentOS)長期處于穩固地位。

至于Hadoop,最早的3篇論文來自Google,也是核心思想。Hadoop項目初期***的貢獻者是Yahoo,而且至少到成熟的1.0穩定版本都是如此。軟件方面并非我的長項,后來對Hadoop的關注也減少了。

那么OpenStack呢?最初是Rackspace分享出來,然后有一段RedHat的投入較多,最近基金會里和社區里好像HP的力度***。盡管眾人拾柴,但OpenStack在還沒有充分成熟的情況下,主導者就出現了變化。

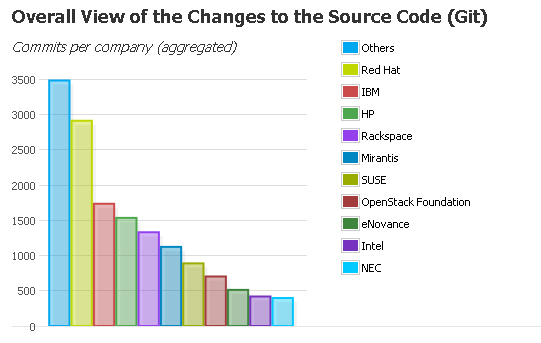

在OpenStack IceHouse版本中貢獻排名前十的公司如上圖所示。紅帽、IBM、HP、Rackspace以及Mirantis繼續領先(引用自:http://www.openstack.cn/p1385.html 2014年4月)

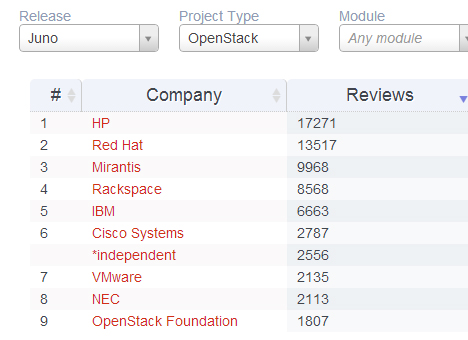

(Juno版本)HP和Redhat是一個級別,Mirantis,Rackspace,IBM是一個級別。后面的差距都已經有點大。(引用自:http://www.chenshake.com/chat-openstack-contribution/ 2014年8月)

而開源組織、行業標準聯盟面臨的一個問題是:各方面利益的制衡。作為一個存儲人,這一點我覺得在SNIA身上就比較明顯,OpenStack也有類似的情況。我已經不止一次聽到UnitedStack的兄弟說,他們想提交一些代碼/patch到主流版本,但阻力較大。

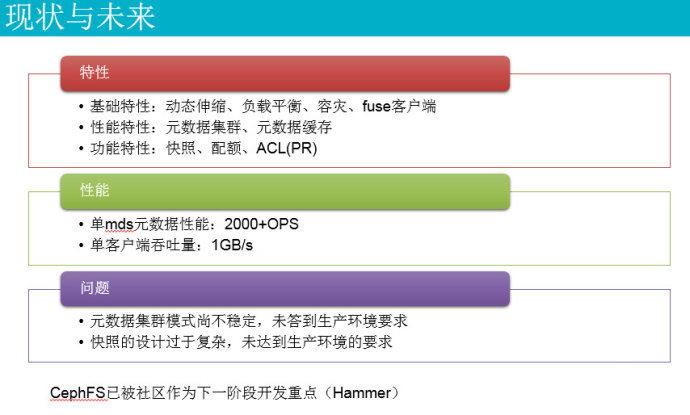

CephFS的現狀與未來

就在上周日舉行的OpenStack存儲技術研討會上,我一方面看到UnitedStack繼續預熱宣講尚未解決元數據集群穩定性(也就是高可用)的CephFS文件系統;另一方面也聽到HP內部測試了Ceph分布式塊存儲之后,認為其尚未達到商業部署要求,而在Helion中推薦自家的軟件定義存儲VSA。

這里應該不難看出背后的商業驅動因素,我也指出HP StorVirtual(LeftHand)VSA目前存在的一些局限或者說不足,在這里就不展開了。

剛才又聽到一位朋友說:“今兒裝Ceph 0.9哎,太坑爹了。比Gluster差至少一個數量級啊。”

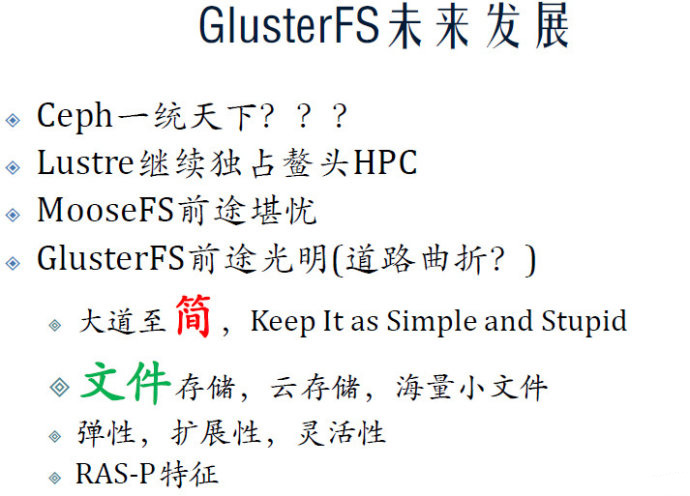

畢竟Gluster已經3.x版本了,其成熟度不容懷疑。國內著名Gluster專家,目前正在做分布式塊存儲(Server SAN)創業的@劉愛貴 表示:“Ceph適合用于塊存儲,文件系統不是它的長項(不如Gluster等),其對象存儲功能還不如直接用Swift。”正如有的朋友所說:(塊、文件和對象)都擅長也可以理解為都不擅長。

引用自劉愛貴的GlusterFS分布式文件系統分享 http://vdisk.weibo.com/s/HPecIjqX8sc

達沃時代CTO雷迎春則表示:“從體系結構的設計上,Ceph是2004年左右設計的,當時的目的是在千兆環境下充分利用硬盤的I/O,每一個硬盤有一個osd進程。而現在,硬件環境發生天翻地覆的變化,應用的workload大都來自虛擬機。Ceph要適應現在的硬、軟環境,需要重新設計。”

“統一存儲在功能上實現比較容易,小規模,如盤陣形式,不會有大的問題。但是,在中大規模,性能上和可靠性上很難做到一致。”

“Ceph的優勢是Crush,劣勢也是Crush。對于同質硬件、單一Workload,Crush會體現它的簡單性,但是,實際情況是,我們的硬件是異質的,不僅CPU和Memory不同,存儲介質也會不同,更重要的不同是workload的不同,特別是在多租戶環境下對不同workload或用戶的服務保證。”

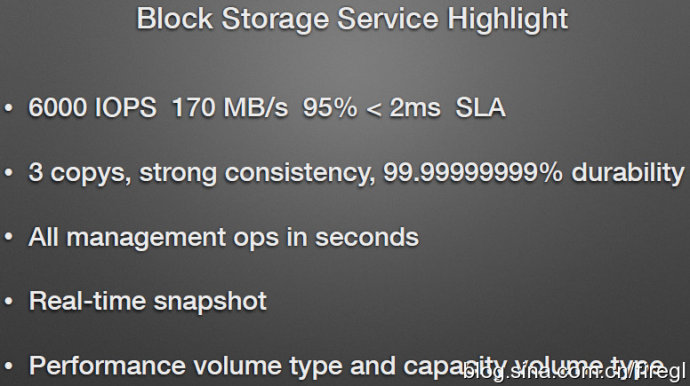

注意:這里的11個9指的是數據可靠性而不是可用性(Availability)

由此來看,UnitedStack用全SSD達到單一客戶端6000 IOPS,小于2ms延時,提供SLA和QoS(性能隔離)可以說做得不錯了。只是還沒看到閃存磁盤混合存儲,以及混合工作負載下的表現。

眾所周知,企業存儲最重要的是穩定性;滿足這個之后,應該是兼容性;性能可能要排在兼容性后面。用戶為虛擬化/云平臺后端維護不同后端的多個存儲集群,來滿足文件/塊等訪問協議需求,確實會增加復雜度。這時,我覺得Ceph倒是挺符合“中庸”的思路。

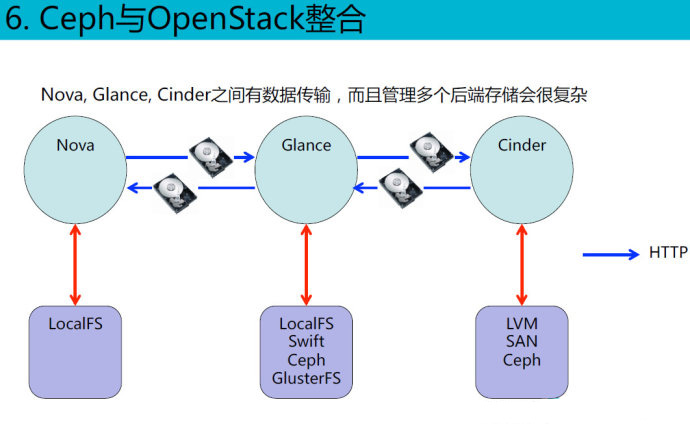

Ceph與OpenStack整合的一個好處是:Nova, Glance, Cinder之間沒有數據傳輸,快速創建虛擬機,只需要管理一個統一存儲。

再來看看Nutanix、ScaleIO、FusionStorage和VSAN,它們要么性能強大,要么功能豐富,要么和HyperVisor結合緊密,不過都只是塊存儲。針對VSAN提供文件服務的NexentaConnect,盡管我還沒對其仔細研究,但大致理解成在VSAN分布式存儲的節點上跑個虛機做ZFS NAS網關,估計差不多吧。

如果說OpenStack還有個CloudStack競爭的話,Ceph的“統一”或者說“通用”目前在流行的競爭產品中是有些獨特性。不過我也了解到國內也有人在做類似通吃塊、文件和對象三種訪問協議的分布式存儲;也有要攻關專門面向特定場景優化的Server SAN(可能就是文中出現過的大牛哦),我想這2個方向都是有市場需求的。

未來這里面會不會出現一家分布式軟件定義存儲(SDS)廠商呢?

2015,新的一年開始了。如果我們在第二季度看到國內廠商(不是熱衷跑分的某司哈)用分布式塊存儲跑出一個理想的SPC-1 BenchMark(延伸閱讀:SPC-1:閃存 vs.磁盤新舊勢力的戰場)成績,會作何感想呢?當然,ScaleIO等已經過云和恩墨的驗證可以勝任OLTP應用了。如果可以的話,下一步就等著軟件定義存儲吹響大規模替代傳統企業級磁盤陣列的號角了。