數據中心基礎架構的挑戰與新發展

【51CTO.com 綜合報道】1 概述

隨著企業數據中心建設的深化進行,企業業務數據集中密度越來越高,服務器存儲數量不斷增長,網絡架構不斷擴展,空間布局、系統布線、電力能耗壓力不斷增加。作為數據中心業務承載的大動脈,基礎網絡架構層面則直接面臨著持續的嚴格挑戰。

網絡基礎技術的快速發展為數據中心變革提供了強大支撐動力,基礎網絡演進加快。

2 數據中心基礎網絡的挑戰與驅動力

2.1 高密服務器、存儲數據中心

數據中心的物理服務器、存儲系統數量快速增長,使得數據中心規模不斷擴大。企業數據集中、業務整合的過程,表現為高密應用系統的集中,同時,服務器與存儲等IT設備計算處理能力遵循摩爾定律的增長,也使得數據中心的業務處理能力持續性增強。

目前1Gbps~8Gbps級別的服務器、存儲系統網絡接口已經是主流,從而使得基礎網絡系統的千兆接入、萬兆互聯成為數據中心建設的基本標準。

下一代計算設備已經開始提供萬兆接口,目前多核服務器已經具備萬兆吞吐能力,多萬兆網絡接口的服務器、存儲系統已經開始在企業數據中心進行部署,計算能力迅速提升的同時也使得面向網絡的接入帶寬需求過渡到萬兆環境。

計算虛擬化的技術革新,使得單一高計算能力物理服務器虛擬化成多個邏輯計算單元,極大提高了系統的計算效能以及對存儲訪問的高速吞吐。同時,因等同于將此前的多個服務器應用系統疊加在一個網絡接口下,網絡流量急速提升,對數據中心基礎網絡提出了相當于傳統環境下數倍乃至數十倍的性能要求。

同時,在高密應用集中環境下,基礎網絡的可靠性要求更為苛刻。局部網絡產生的故障,對數據中心提供服務能力的影響比傳統環境要更為嚴重。傳統數據中心的局部故障可能只對單一應用造成短時影響,而新的數據中心環境下,大量應用密集,故障影響范圍擴大化。因此對于網絡變化的快速收斂、更強的故障自愈能力成為下一代數據中心平臺的重要研究課題。

2.2 數據中心多個獨立網絡

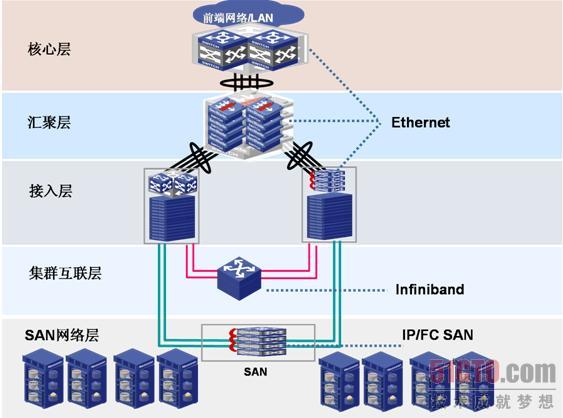

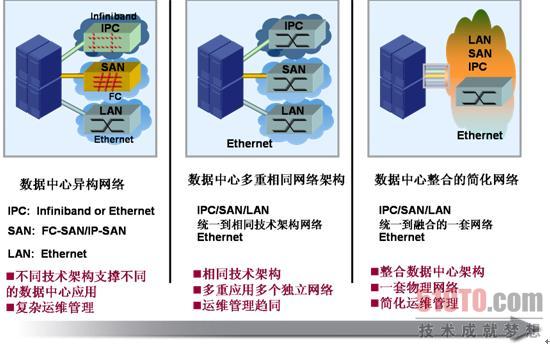

數據中心發展建設過程中,出于不同的應用連接要求,逐步出現了多個獨立網絡系統,如圖1所示。

以太網交換網絡:用于連接承載終端客戶與業務服務器系統的數據訪問,強調高速、可靠、安全、遠端互聯性、開放性,是當前標準化最普遍的基礎網絡形態。

服務器高速互聯網絡:多用于服務器高速集群互聯,在大多數條件下使用以太網進行承載;但在某些特殊要求應用環境下,使用Infiniband(簡稱IB)網絡進行集群互聯,IB的特點主要是時延小,不丟包。IB的低時延在于轉發機制為cut-through模式(傳統以太網交換機為store-forwarding模式),可達200納秒。同時IB通過credit機制進行端到端流控,使得網絡突發大流量得到平緩,數據保持在服務器接口而避免流量丟失。

存儲訪問網絡:用于承載服務器上層應用系統對后端存儲的數據操作,存儲網路主要在于傳送SCSI指令,核心要求是高帶寬、不丟包。目前常見的存儲網絡有FC交換機構建的FC-SAN和以太網交換機構建的IP-SAN。

多套網絡的數據中心(圖1),不僅增加了投資成本,同時由于技術差異大,需要不同的專業人員進行操作,給數據中心的運行管理帶來更多的不便及較高的培訓成本。隨著數據中心規模的不斷增大,龐大的異構網絡也成為影響數據中心TCO的一個重要環節。

|

| 圖1 數據中心異構網絡 |

#p#

2.3 數據中心流量突發

數據中心基礎網絡高性能的特點已經為建設者不容置疑,全線速、高帶寬是設備選型的核心因素。但是,隨著數據中心應用的迅猛增長,網絡承載的業務流也不斷增長。

|

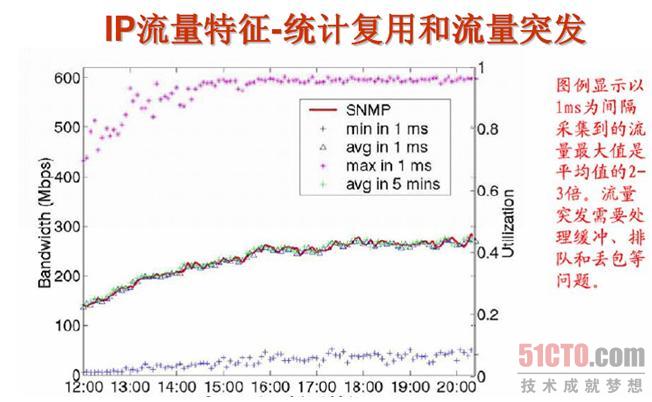

| 圖2 網絡流量突發性 |

根據網絡觀測(圖2),以1毫秒為間隔采集到的流量峰值是平均流量的2-3倍。因此在高密應用環境下的數據中心網絡中,特別是萬兆互聯環境下,業務流量突發異常顯著,而這樣的突發數據流需要網絡交換系統進行緩存和排隊調度。通常的網絡設計雖然是千兆服務器接入、萬兆網絡骨干,然而在網絡的骨干層面是基本存在一定的帶寬收斂設計,如出現多個萬兆端口向較少萬兆端口突發數據,則存在嚴重的突發擁塞瓶頸。

當交換系統對流量突發的緩存調度能力有限時,必然引起在集中業務訪問引起的流量突發情況下的大量丟包,引起傳輸層的窗口滑動、重傳和流量環境進一步惡化,降低服務響應能力。

傳統的交換方式只能進行最多8種流的區分和調度,業務能力有限,難以滿足當前數據中心高密應用需求,特別是浪涌突發環境下,粗粒度調度能力、低容量網絡緩存無法解決眾多關鍵應用的高吞吐量突發訪問業務要求。#p#

3 數據中心基礎架構的新發展

3.1 100G時代來臨

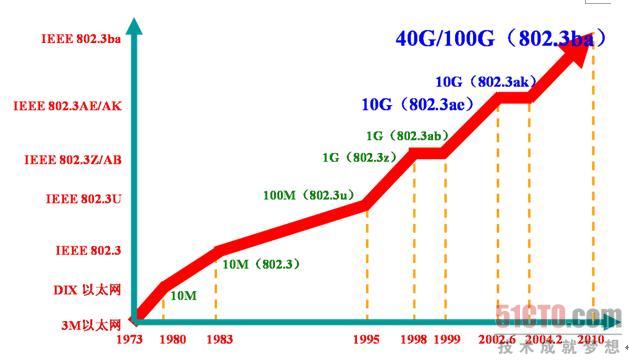

以太網技術發展是以10倍速方式躍階的,如圖3所示。當前的千兆接入、萬兆骨干已經是普遍構建的網絡架構,隨著成本的持續下降,萬兆技術也開始從網絡的核心,推進到網絡邊緣,推進到服務器、存儲設備上。

|

| 圖3 以太網快速發展 |

研究下一代以太網標準的HSSG技術工作組已經結束爭論,制定一個包含40Gbps和100Gbps速度的單一標準,IEEE802.3ba,并將在2010年確定。40Gbps主要面向服務器,而100Gbps則面向網絡匯聚和骨干。每種速度將提供一組物理接口:40Gbps將有1米交換機背板鏈路、10米銅纜鏈路和100米多模光纖鏈路標準;100Gbps將有10米銅纜鏈路、100米多模光纖鏈路和10千米、40公里單模光纖鏈路標準。

基于面向40G/100G下一代超高帶寬的發展理念,H3C推出的下一代數據中心級業務調度統一交換平臺12500在架構設計上考慮了對40G/100G的兼容,架構上設計當前每槽位可達到80G線速帶寬,可支持兩個40G接口,并能通過后端交換矩陣擴展到每槽位1個100G接口。在802.3ba標準發布后,能夠通過技術平滑升級過度到超高速網絡環境,并保持對傳統千兆、萬兆的兼容性。#p#

3.2 數據中心的網絡浪涌容載能力與業務調度

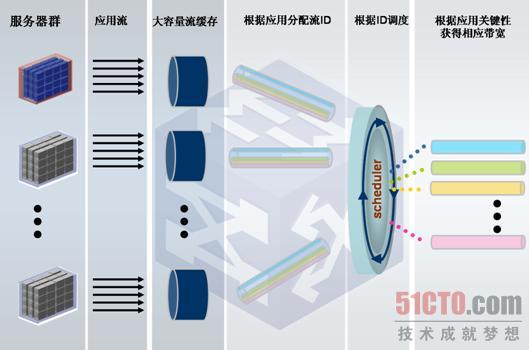

為解決數據中心高密應用的調度、流量的浪涌式突發緩沖等關鍵的性能問題,必然在進行交換平臺的基礎架構設計上進行技術革新。

首先是在交換平臺上提供硬件化的流量管理能力,大容量的緩存匹配密集的硬件調度隊列,將調度能力擴展到上萬個隊列,一旦使上層應用數據流進入相應的硬件隊列,則可實現大范圍(遠超過8個隊列)的數據中心級業務調度能力,如圖4所示。

|

| 圖4 大緩存與整體業務調度 |

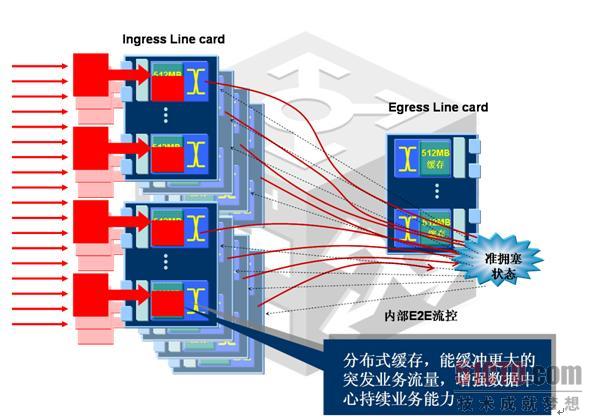

另一個技術變革是改變傳統交換系統的出端口緩存方式,而采用分布式ingress緩存架構。傳統出端口緩存方式,整個系統的業務突發容載能力僅由出端口可分配的緩存大小決定,因此容量是固定的,流量達到一定的突發界限,即瞬時突發數據量超過了出端口緩存大小,便導致整個系統開始出現丟包,而且,經測試觀測,此種緩存能力的實際表現與根據端口緩存大小的理論計算是符合的。

分布式緩存技術則采用了區別于傳統方式的架構,如圖5所示,正常轉發過程中,出端口是以萬兆線速對外轉發數據的,當出現多個萬兆到一個萬兆的突發流量開始超萬兆擁塞時,在出端口的報文標記隊列計數將快速增長,達到一定閾值(進入準擁塞狀態)便產生端到端(E2E)流控信息到各流量來源(ingress)端口,ingress端口緩存即開始將突發流量緩存到本地并停止對出口發送數據,同時出口仍然以萬兆線速發送瞬時的超萬兆突發流量,當出端口解除準擁塞狀態后,E2E流控通知ingress緩存將保留的數據進行正常轉發。

整個分布式緩存機制由流量管理器在硬件層面協調,無需軟件參與,因而工作在系統時鐘級別。而每個ingress緩存大小均要求在萬兆全線速條件下達到200毫秒的突發流量緩存能力,因此,在突發引起的瞬時擁塞時,N個端口向一個端口轉發的緩存能力是N*200毫秒,與傳統出端口緩存固定能力相比有本質的提升。

|

| 圖5 分布式緩存架構 |

#p#

3.3 數據中心級HA進入毫秒計時

高可用是數據中心基礎網絡的永恒話題,據有關機構調查,可用性是各行業數據中心各項業務指標排在首位的關注項。

對于當前數據中心密集應用環境下,核心基礎網絡平臺的應對故障快速恢復能力已經不是秒級指標能夠滿足的,當前的快速收斂目標已經設定在毫秒級,因此,毫秒級恢復能力成為數據中心的故障恢復指標。

H3C數據中心交換平臺12500可提供的已測試部分指標數據為:

雙引擎主備倒換切換時間 0丟包

單電源模塊更換 0丟包

OSPF GR 0丟包

BFD for VRRP 50毫秒

路由學習能力 8000條/秒

3.4 數據中心統一交換架構

隨著以太網技術的進一步發展,新的技術標準不斷推動基礎平臺架構的變化與融合。

萬兆交換系統的時延已經降低到微妙級別,而當前已經有技術使得以太網芯片在cut-through方式下能夠達到200-300納秒級別,已經逼近Infiniban的低時延水平。而對于計算型應用而言,采用以太網互聯的微妙級時延已經能夠滿足大量的計算需求,近幾年高性能計算TOP500排名中基本上超過50%的計算網絡互聯是采用了千兆以太網,隨著萬兆、40/100G技術的深入發展和終端萬兆接口技術成熟,以太網將成為服務器互聯計算承載的主流平臺。

無丟包以太網技術標準族(802.3Qau、802.1Qbb、802.1Qaz、Data Center Bridging Exchange Protocol)和相關技術即將發布。并在此基礎上進一步支持FCOE,使得以太交換網絡能夠承載FC存儲數據流。

數據中心網絡發展趨勢是融合的統一交換架構,在一個交換平臺上有效支撐業務的前端訪問、服務器高速互聯、存儲訪問。

對于H3C數據中心方案架構而言,統一架構的網絡平臺與業內技術發展是同步的,遵循圖6所示的幾個階段。

|

| 圖6 H3C統一交換架構路線 |

與其他解決方案提供商不同,H3C基于IP-SAN的萬兆成熟解決方案廣泛應用,使得H3C數據中心統一交換架構早于FCOE實現存儲的融合。

4結束語

隨著當前數據中心系統架構的不斷發展,密集的業務需求,要求數據中心交換網絡成為高性能、融合業務統一交換的基礎平臺,滿足數據中心規模的不斷發展。12500作為H3C下一代數據中心核心平臺,將不斷熔煉新的技術與標準,持續的可兼容、可擴展能力滿足數據中心的不斷發展要求。