ICML 2024 | 脫離LoRA架構(gòu),訓(xùn)練參數(shù)大幅減少,新型傅立葉微調(diào)來(lái)了

本文介紹了香港科技大學(xué)(廣州)的一篇關(guān)于大模型高效微調(diào)(LLM PEFT Fine-tuning)的文章「Parameter-Efficient Fine-Tuning with Discrete Fourier Transform」,本文被 ICML 2024 接收,代碼已開(kāi)源。

- 論文地址:https://arxiv.org/abs/2405.03003

- 項(xiàng)目地址:https://github.com/Chaos96/fourierft

背景

大型基座模型在自然語(yǔ)言處理(NLP)和計(jì)算機(jī)視覺(jué)(CV)領(lǐng)域都獲得了矚目的成就。微調(diào)(Finetuning)大型基座模型,使其更加適應(yīng)特殊的下游任務(wù),成為了一項(xiàng)熱門(mén)研究課題。然而,在模型越來(lái)越大,下游任務(wù)越來(lái)越多樣的今天,微調(diào)整個(gè)模型帶來(lái)的計(jì)算、存儲(chǔ)消耗已大到不再能被接受。LoRA 采用低秩擬合微調(diào)增量的方案,成功降低了大量的此類消耗,但每個(gè)適應(yīng)器(adapter)的大小仍然是不可忽視的。這激發(fā)了本文的核心問(wèn)題:相比 LoRA,如何進(jìn)一步大幅減少可訓(xùn)練參數(shù)?此外,一個(gè)有趣的附加問(wèn)題是能否采用更少的參數(shù)量得到高秩增量矩陣。

方法

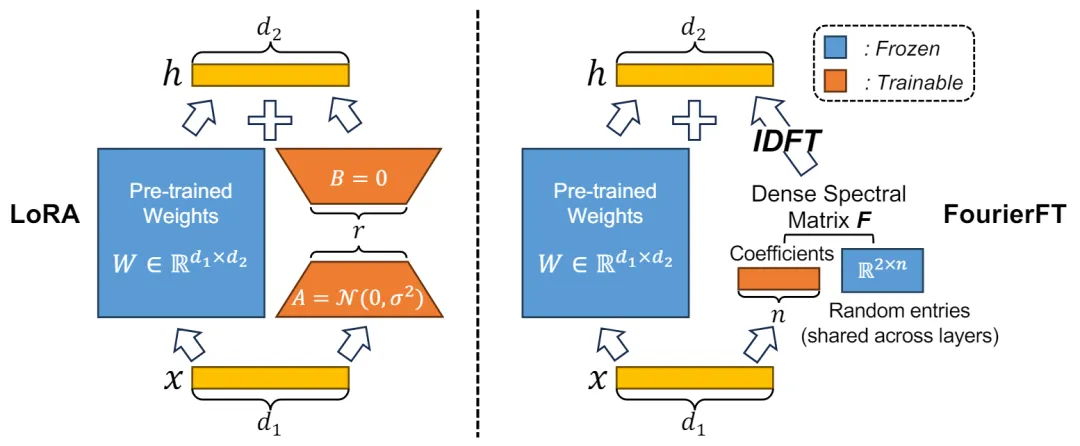

傅立葉基底在各類數(shù)據(jù)壓縮應(yīng)用中廣泛使用,例如一維向量信號(hào)和二維圖像的壓縮。在這些應(yīng)用中,稠密的空域信號(hào)通過(guò)傅立葉變換被轉(zhuǎn)化為稀疏的頻域信號(hào)。基于這一原理,作者推測(cè)模型權(quán)重的增量也可以被視為一種空域信號(hào),其對(duì)應(yīng)的頻域信號(hào)可以通過(guò)稀疏表示來(lái)實(shí)現(xiàn)。

在這一假設(shè)的基礎(chǔ)上,作者提出了一種新的方法,用于在頻域中學(xué)習(xí)增量權(quán)重信號(hào)。具體來(lái)說(shuō),該方法通過(guò)隨機(jī)位置的稀疏頻域信號(hào)來(lái)表示空域權(quán)重增量。在加載預(yù)訓(xùn)練模型時(shí),首先隨機(jī)選擇 n 個(gè)點(diǎn)作為有效的頻域信號(hào),然后將這些信號(hào)拼接成一個(gè)一維向量。在前向傳播過(guò)程中,這個(gè)一維向量被用來(lái)通過(guò)傅立葉變換恢復(fù)空域矩陣;在反向傳播過(guò)程中,由于傅里葉變換的可導(dǎo)性,可以直接對(duì)此可學(xué)習(xí)的向量進(jìn)行更新。這種方法不僅有效減少了模型微調(diào)時(shí)所需的參數(shù)數(shù)量,同時(shí)保證了微調(diào)性能。通過(guò)這種方式,作者不僅實(shí)現(xiàn)了對(duì)大規(guī)模基礎(chǔ)模型的高效微調(diào),還展示了傅立葉變換在機(jī)器學(xué)習(xí)領(lǐng)域中的潛在應(yīng)用價(jià)值。

得益于傅立葉變換基底的高信息量,僅需很小的 n 值即可達(dá)到與 LoRA 相當(dāng)甚至超過(guò) LoRA 的表現(xiàn)。一般來(lái)說(shuō),傅立葉微調(diào)的可訓(xùn)練參數(shù)僅為 LoRA 的千分之一到十分之一。

實(shí)驗(yàn)

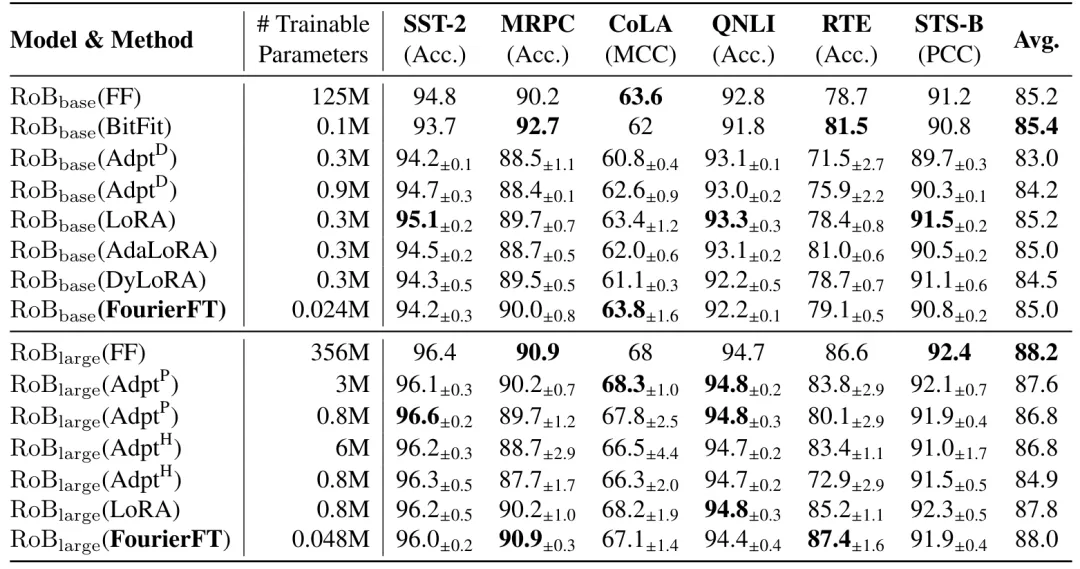

1. 自然語(yǔ)言理解

作者在自然語(yǔ)言理解的 GLUE 基準(zhǔn)測(cè)試上對(duì)傅立葉微調(diào)方法進(jìn)行了評(píng)估。基線對(duì)比方法包括全量微調(diào)(FF,F(xiàn)ull Finetuning)、Bitfit、適應(yīng)器微調(diào)(Adapter Tuning)、LoRA、DyLoRA 和 AdaLoRA。下表展示了各種方法在 GLUE 各個(gè)任務(wù)上的表現(xiàn)及其所需的訓(xùn)練參數(shù)量。結(jié)果表明,傅立葉微調(diào)以最少的參數(shù)量達(dá)到了甚至超越了其他微調(diào)方法的性能。

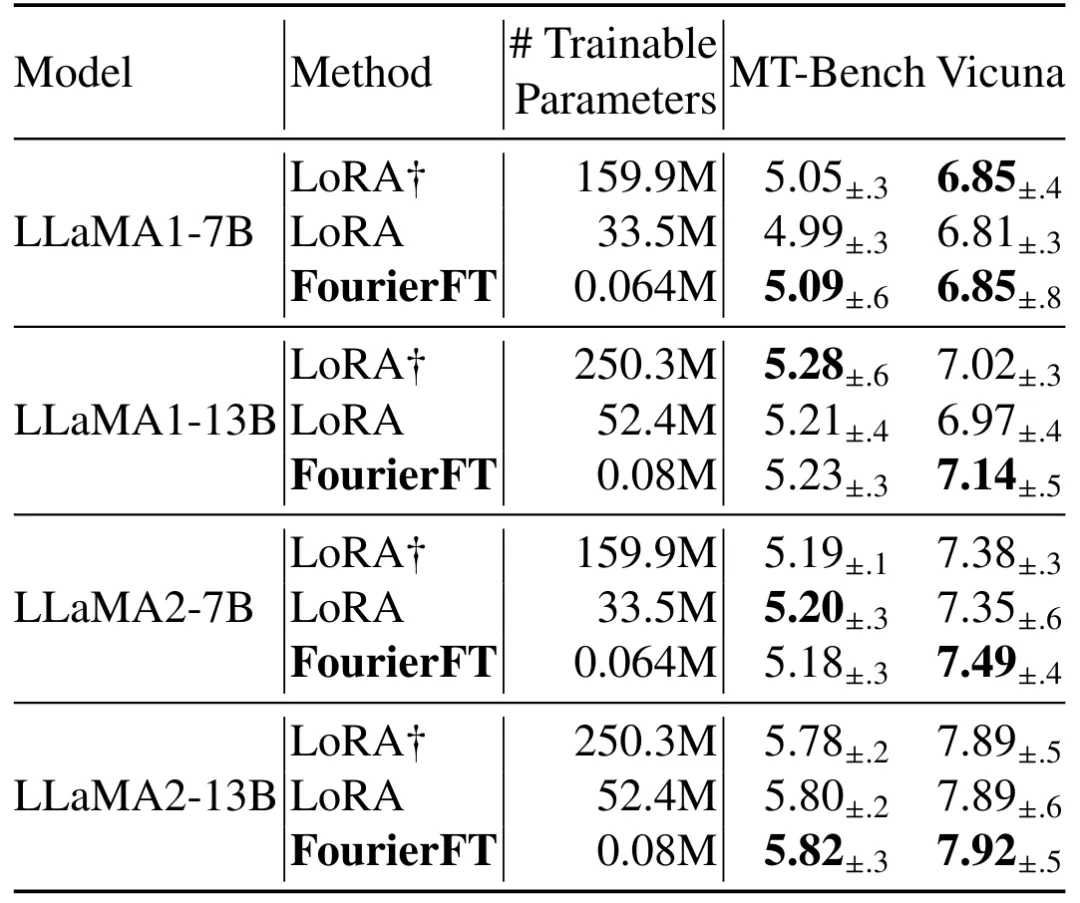

2. 自然語(yǔ)言指令微調(diào)

大模型的自然語(yǔ)言生成是目前模型微調(diào)的重要應(yīng)用領(lǐng)域。作者在 LLaMA 系列模型、MT-Bench 任務(wù)和 Vicuna 任務(wù)上評(píng)估了傅立葉微調(diào)的性能。結(jié)果顯示,傅立葉微調(diào)以極低的訓(xùn)練參數(shù)量達(dá)到了與 LoRA 相似的效果,進(jìn)一步驗(yàn)證了傅里葉微調(diào)方法的通用性和有效性。

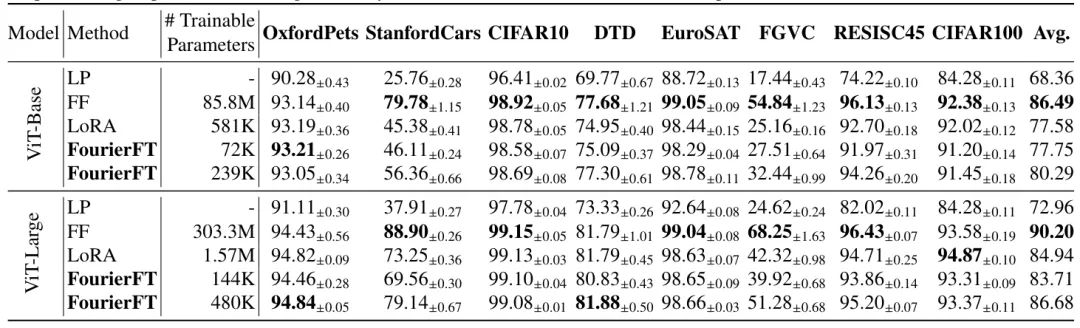

3. 圖像分類

作者在 Vision Transformer 上測(cè)試了傅里葉微調(diào)的性能,涵蓋了 8 個(gè)常見(jiàn)的圖像分類數(shù)據(jù)集。實(shí)驗(yàn)結(jié)果表明,雖然在圖像分類任務(wù)中傅立葉微調(diào)相較LoRA的壓縮率提升并不比自然語(yǔ)言任務(wù)中顯著,但其仍然以遠(yuǎn)小于 LoRA 的參數(shù)量超越了 LoRA 的效果。這進(jìn)一步展示了傅立葉微調(diào)在不同應(yīng)用領(lǐng)域中的有效性和優(yōu)勢(shì)。

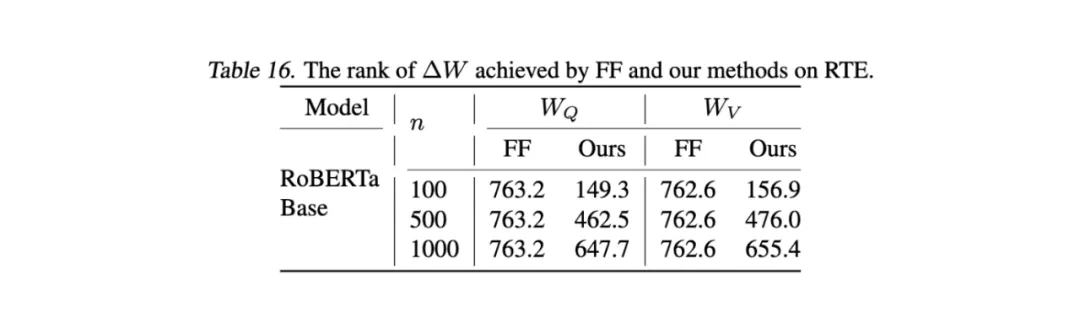

4. 突破低秩

在 GLUE 基準(zhǔn)的 RTE 數(shù)據(jù)集上,F(xiàn)ourierFT 可以實(shí)現(xiàn)明顯高于 LoRA (通常為 4 或 8) 的增量的秩。

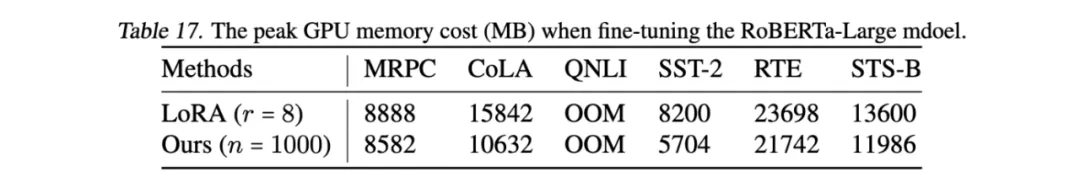

5.GPU 資源消耗

微調(diào)過(guò)程中,F(xiàn)ourierFT 可以實(shí)現(xiàn)比 LoRA 更少的 GPU 消耗。下圖為采用單張 4090 顯卡在 RoBERTa-Large 模型上的巔峰內(nèi)存消耗。

結(jié)論

作者介紹了一種名為傅立葉微調(diào)的高效微調(diào)方法,通過(guò)利用傅里葉變換來(lái)減少大基礎(chǔ)模型微調(diào)時(shí)的可訓(xùn)練參數(shù)數(shù)量。該方法通過(guò)學(xué)習(xí)少量的傅里葉譜系數(shù)來(lái)表示權(quán)重變化,顯著降低了存儲(chǔ)和計(jì)算需求。實(shí)驗(yàn)結(jié)果顯示,傅立葉微調(diào)在自然語(yǔ)言理解、自然語(yǔ)言生成、指令調(diào)優(yōu)和圖像分類等任務(wù)上表現(xiàn)優(yōu)異,與現(xiàn)有的低秩適應(yīng)方法(如 LoRA)相比,傅立葉微調(diào)在保持或超過(guò) LoRA 性能的同時(shí),所需的可訓(xùn)練參數(shù)大幅減少。

本文轉(zhuǎn)自 機(jī)器之心 ,作者:機(jī)器之心