量化大模型退化嚴重?ETH北航字節(jié)推出LoRA新范式 | ICML 2024

大模型應(yīng)用開卷,連一向保守的蘋果,都已釋放出發(fā)展端側(cè)大模型的信號。

問題是,大語言模型(LLM)卓越的表現(xiàn)取決于“力大磚飛”,如何在資源有限的環(huán)境中部署大模型并保障性能,仍然頗具挑戰(zhàn)。

以對大模型進行量化+LoRA的路線為例,有研究表明,現(xiàn)有方法會導(dǎo)致量化的LLM嚴重退化,甚至無法從LoRA微調(diào)中受益。

為了解決這一問題,來自蘇黎世聯(lián)邦理工學(xué)院、北京航空航天大學(xué)和字節(jié)跳動的研究人員,最新提出了一種信息引導(dǎo)的量化后LLM微調(diào)新算法IR-QLoRA。論文已入選ICML 2024 Oral論文。

論文介紹,IR-QLoRA能有效改善量化導(dǎo)致的大模型性能退化。在LLaMA和LLaMA 2系列中,用該方法微調(diào)的2位模型,相比于16位模型僅有0.9%的精度差異。

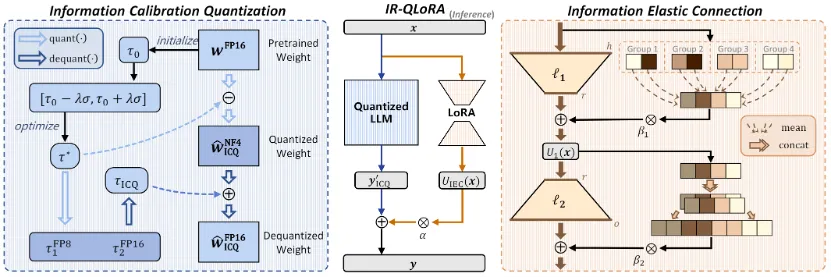

△IR-QLoRA框架圖

該方法的核心思想,是通過信息保留來使LoRA微調(diào)量化的大語言模型實現(xiàn)精度提升。

包含從統(tǒng)一信息角度衍生的兩種技術(shù):信息校準量化和信息彈性連接。

信息校準量化

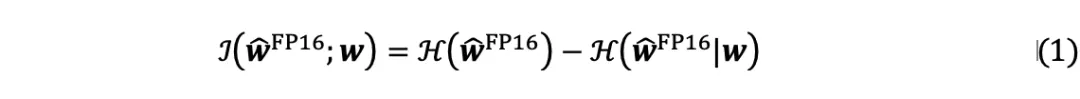

LLM的量化權(quán)重被期望反映原始對應(yīng)方所攜帶的信息,但比特寬度的減小嚴重限制了表示能力。從信息的角度來看,量化LLM和原始LLM的權(quán)重之間的相關(guān)性表示為互信息。

在LLM量化后,由于比特寬度的顯著減小導(dǎo)致表示能力的降低,量化權(quán)重的熵遠小于原始權(quán)重的熵。因此,優(yōu)先考慮低比特權(quán)重內(nèi)的信息恢復(fù)對于增強量化LLM至關(guān)重要。

首先從數(shù)學(xué)上定義信息校準的優(yōu)化目標。校準過程可以看為向量化器引入一個校準常數(shù)

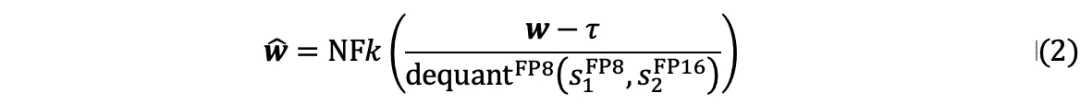

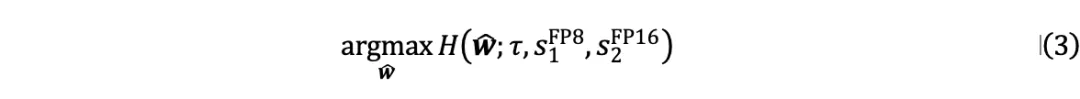

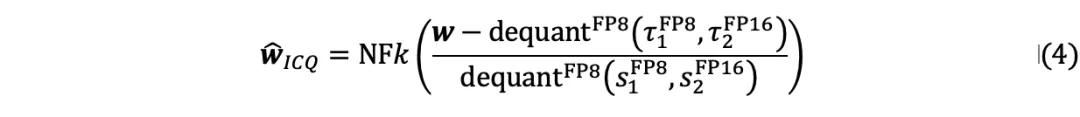

以最大化信息,量化過程可以表述如下:

由于原始權(quán)重  是固定的,公式(1)中的優(yōu)化目標可以表示為:

是固定的,公式(1)中的優(yōu)化目標可以表示為:

由于直接求解公式(3)中的目標非常耗時,作者提出了一種分塊校準量化器信息的兩步策略:

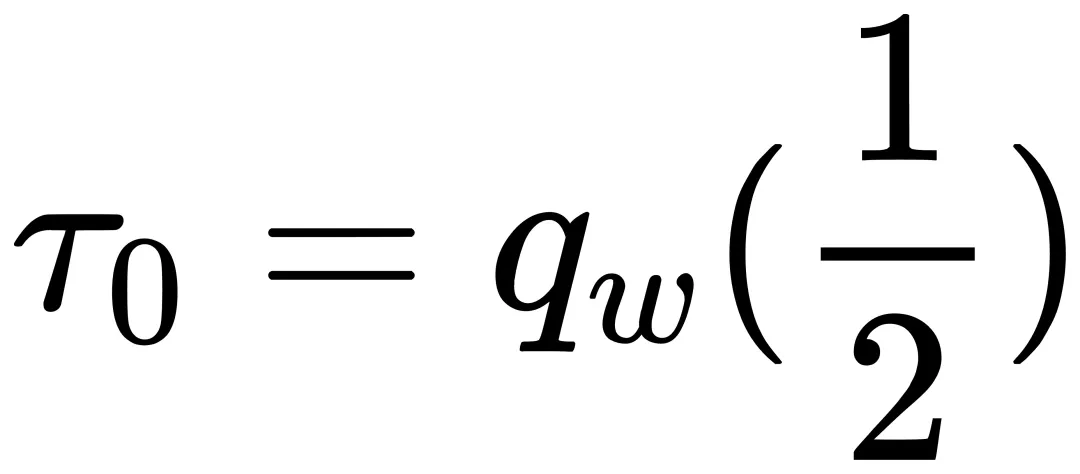

第一步是初始化校準常數(shù)

。基于神經(jīng)網(wǎng)絡(luò)權(quán)重正態(tài)分布的常見假設(shè),將每個權(quán)重量化塊的常數(shù)初始化為中值

。由于正態(tài)分布中靠近對稱軸的區(qū)域的概率密度較高,因此該初始化旨在更大程度地利用量化器的間隔。應(yīng)用位置相關(guān)中值來初始化

,以減輕異常值的影響。

第二步是優(yōu)化校準常數(shù)  、量化尺度

、量化尺度  、雙量化尺度

、雙量化尺度  。使用信息熵作為度量,并進行基于搜索的優(yōu)化以獲得

。使用信息熵作為度量,并進行基于搜索的優(yōu)化以獲得  。通過將

。通過將

線性劃分為n個候選來創(chuàng)建  的搜索空間,其中

的搜索空間,其中  是標準差,

是標準差, 是系數(shù)。使用每個候選

是系數(shù)。使用每個候選  校準權(quán)重后,量化校準的權(quán)重并計算信息熵。獲得的量化尺度與基線一致。通過

校準權(quán)重后,量化校準的權(quán)重并計算信息熵。獲得的量化尺度與基線一致。通過

得到量化尺度

,然后二次量化為

和

。

對于優(yōu)化后的校準常數(shù)  ,執(zhí)行類似于尺度的雙量化以節(jié)省內(nèi)存,信息校準量化的量化過程可以總結(jié)為:

,執(zhí)行類似于尺度的雙量化以節(jié)省內(nèi)存,信息校準量化的量化過程可以總結(jié)為:

信息彈性連接

除了基線中的量化LLM之外,由低秩矩陣組成的LoRA也阻礙了信息的恢復(fù),為了增強LoRA的表示能力,幫助恢復(fù)量化LLM的信息,同時保持其輕量級性質(zhì),作者引入了有效的信息彈性連接。該方法構(gòu)建了一個強大的低秩適配器,有助于利用從量化的LLM單元導(dǎo)出的信息。

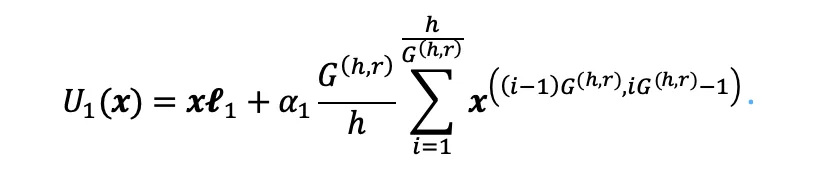

具體來說,首先根據(jù)輸入和中間維度的最大公約數(shù)對原始特征進行分組和平均,并將其添加到由  矩陣計算的輸出中。增加彈性連接的LoRA的第一個子單元

矩陣計算的輸出中。增加彈性連接的LoRA的第一個子單元

可以表示為:

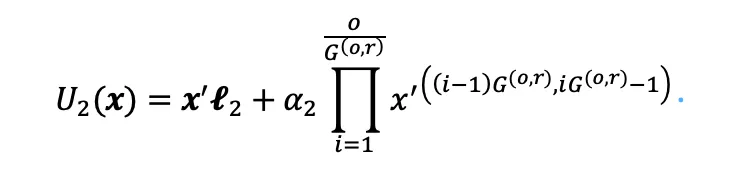

LoRA的后一個矩陣將低秩中間表示變換為輸入維度,因此其伴隨的無參數(shù)變換使用重復(fù)串聯(lián)來增加維度。后一個子單元  的計算過程可以表示為:

的計算過程可以表示為:

與LLM和LoRA單元中的矩陣乘法相比,無參數(shù)變換是一種多樣化的變換形式,進一步增強了量化LLM的信息表示。

實驗驗證

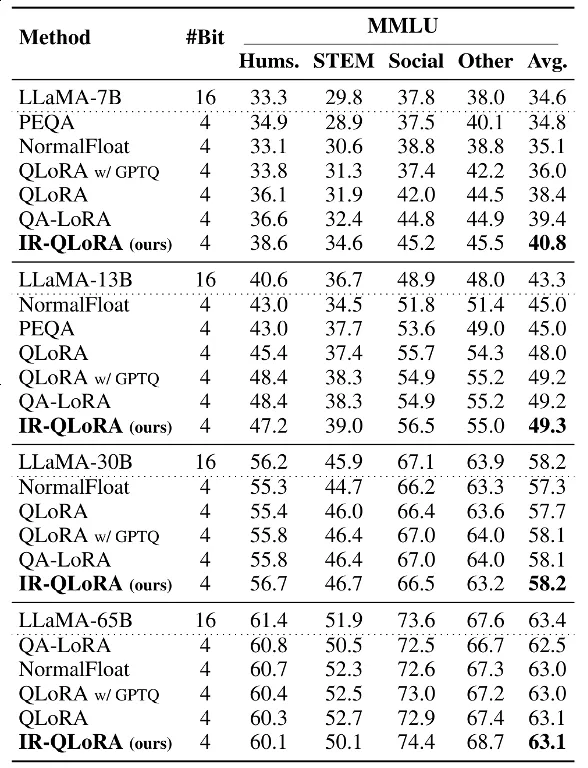

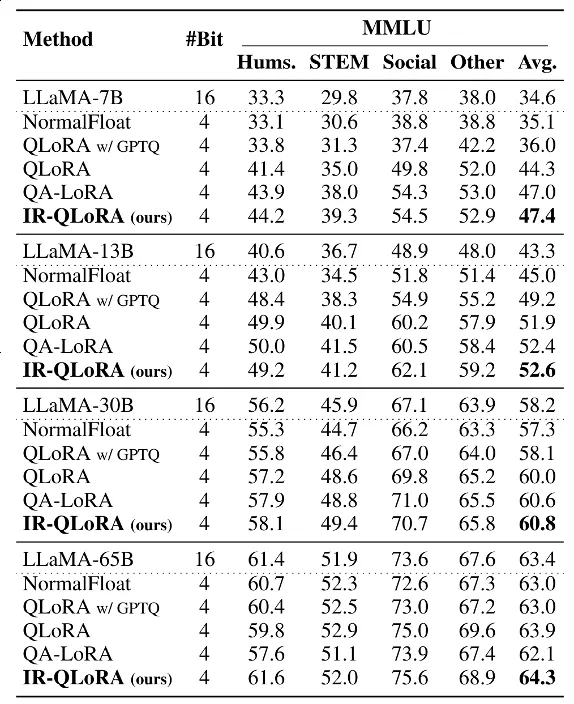

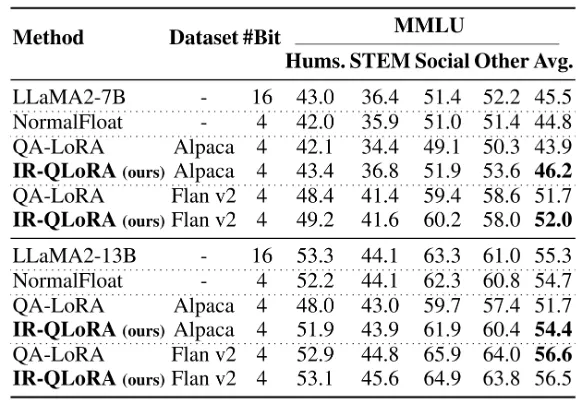

作者廣泛評估了IR-QLoRA的準確性和效率。選擇LLaMA和LLaMA 2系列模型,在Alpaca和Flanv2數(shù)據(jù)集上構(gòu)建參數(shù)高效的微調(diào),使用MMLU和CommonsenseQA基準進行評估微調(diào)后量化模型的效果。

準確率

以下兩張表格分別展示了在Alpaca和Flanv2數(shù)據(jù)集上微調(diào)的MMLU基準的5-shot精度結(jié)果。綜合結(jié)果表明,在各種規(guī)模的LLaMA模型中,IR-QLoRA優(yōu)于所有比較量化方法。

與基線方法QLoRA相比,IR-QLoRA在相同的微調(diào)管道下在MMLU基準上實現(xiàn)了精度的顯著提高。

此外,在LLaMA 2上的準確性比較,證明了IR-QLoRA跨LLM系列的泛化性能。

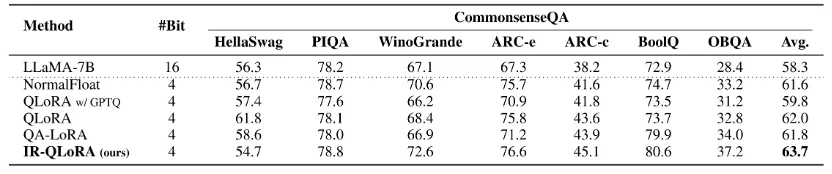

下表中的結(jié)果表明,IR-QLoRA不僅平均實現(xiàn)了至少2.7%的性能改進,而且在幾乎每個單獨的指標上都表現(xiàn)出了優(yōu)勢。這些結(jié)果表明IR-QLoRA在不同的LLM系列中表現(xiàn)出很強的泛化性。

與MMLU基準上的現(xiàn)象類似,在CommonsenseQA基準上,與SOTA方法相比,IR-QLoRA始終保持了LLaMA-7B的最佳平均準確率,而且還顯著提高了大多數(shù)子項的有效性。

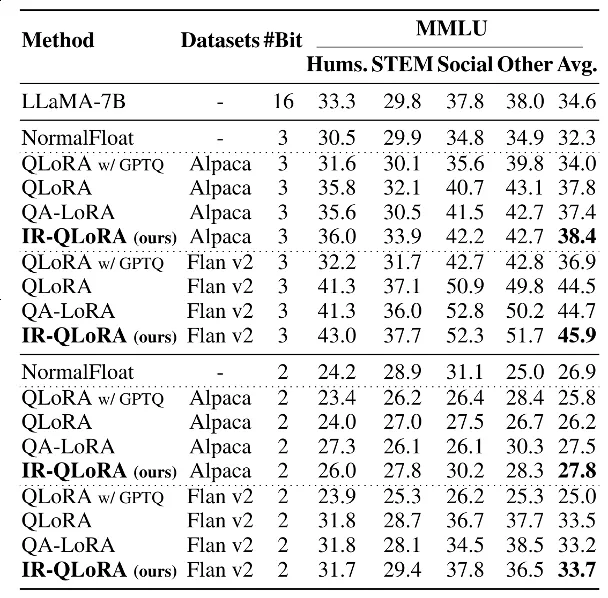

超低位寬

除了4比特以外,作者還評估了超低位寬下的IR-QLoRA建議。

具體來說,作者采用了QLoRA和LoftQ的量化方法,按照百分位量化方法構(gòu)建了NF2和NF3量化。

下表顯示,隨著量化位寬的減小,基線QLoRA的性能急劇下降,以至于其在2位情況下的性能與隨機相差無幾。

相比之下,IR-QLoRA表現(xiàn)出更優(yōu)越的性能,在Flan v2數(shù)據(jù)集上微調(diào)2位模型時,與16位模型相比僅有0.9%的精度差異。

效率

IR-QLoRA的信息校準量化和信息彈性連接并沒有帶來額外的存儲和訓(xùn)練開銷。

如上所示,信息校準量化增加的參數(shù)僅相當于量化的縮放因子,而且采用了雙重量化以進一步減少存儲。因此其帶來的額外存儲空間很小,在4位LLaMA-7B上僅增加了 2.04%。

校準常數(shù)的優(yōu)化過程也只增加了微不足道的訓(xùn)練時間(例如,LLaMA-7B為 0.46%,LLaMA-13B為 0.31%)。此外,增加的時間僅用于訓(xùn)練過程中的初始優(yōu)化,并不會導(dǎo)致推理時間的增加。信息彈性連接也只在每層引入了2個額外參數(shù),在整個模型中可以忽略不計。

結(jié)論

總的來說,基于統(tǒng)計的信息校準量化可確保LLM的量化參數(shù)準確保留原始信息;以及基于微調(diào)的信息彈性連接可以使LoRA利用不同信息進行彈性表示轉(zhuǎn)換。

廣泛的實驗證明,IRQLoRA在LLaMA和LLaMA 2系列中實現(xiàn)了令人信服的精度提升,即使是2-4位寬,耗時也僅增加了0.45%。

IR-QLoRA具有顯著的多功能性,可與各種量化框架無縫集成,并且大大提高了LLM的LoRA-finetuning量化精度,有助于在資源受限的情況下進行實際部署。

論文地址:https://arxiv.org/pdf/2402.05445

代碼地址:https://github.com/htqin/IR-QLoRA

本文轉(zhuǎn)自 量子位 ,作者:量子位

原文鏈接:??https://mp.weixin.qq.com/s/tX6P0U5g9vNDIq2qP7IgCA??