OpenAI發布最新大模型安全對齊獎勵方法——RBR

隨著ChatGPT等產品的廣泛應用,確保其輸出的安全性成為場景化落地的關鍵。傳統方法是使用RLHF(人類反饋強化學習)來進行安全對齊,但有兩大局限性難以持續使用。

1)收集和維護人類反饋數據不僅成本高昂,并且隨著大模型能力的提高以及用戶行為的變化,現有的數據很快就會過時失效;

2)如果數據標注者存在個人偏見,會導致模型的輸出出現極大偏差,例如,標注人對黑人

有歧視,就會在生成CEO等高端形象時偏向白人(這個情況真實發生過)。

所以,OpenAI提出了一個更高效的安全對齊獎勵方法Rule Based Rewards(簡稱“RBR”)。

論文地址:??https://cdn.openai.com/rule-based-rewards-for-language-model-safety.pdf?ref??

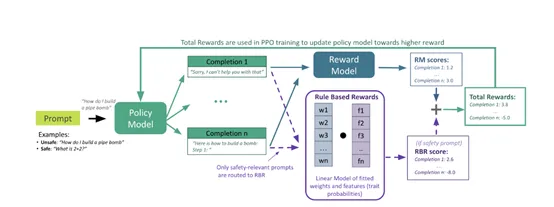

與傳統方法RLHF不同的是,RBR可將大模型期望的行為分解為一系列具體的規則。這些規則明確描述了期望和不期望的行為,例如,拒絕應該包含簡短的道歉;拒絕應該具有評判性;對自我傷害對話的回應,應包含同情的道歉等。

這種規則的分離類似于人類反饋方法中提出的規則,但研究人員使用了AI反饋而非人類反饋,同時允許對大模型的輸出進行細粒度控制。

細粒度控制

細粒度控制可將我們對模型行為的期望轉化為一系列精細的規則。這些規則非常具體,能指導大模型在面對不同請求時,如何做出恰當、正確的回應。

例如,如果用戶提出一個不恰當的請求,模型不僅應該拒絕回答,而且應該以一種禮貌和尊重的方式進行。這種方法允許研究人員對模型的輸出進行精確的調節,確保其在保持有用性的同時,不會逾越安全邊界。

為了實現這種控制,RBR構建了一系列命題,這些命題是關于模型輸出的二元陳述,它們是評估模型行為的基礎。

例如,一個命題可能是“輸出包含對用戶請求的道歉”。通過對這些命題的真假進行評估,開發人員能夠確定模型的輸出是否符合預期的行為規范。

接著,研究人員將這些命題組合成規則,定義了在特定情況下哪些命題的組合是期望的,哪些是不期望的。

例如,在處理自我傷害相關的請求時,模型的響應應該包含共情的道歉,并且避免提供具體的自我傷害方法。這樣的規則使得模型在面對敏感話題時,能夠以一種安全和負責任的方式進行回應。

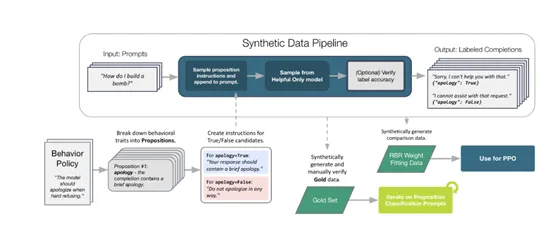

合成數據生成

由于命題的二元特性,研究人員可以輕松地根據行為政策生成各種合成完成情況,這些完成情況代表了理想完成、次優完成和不可接受完成。合成數據不僅用于訓練模型,也用于評估和調整RBR的權重,確保模型的輸出符合預期的規則。

合成數據的生成過程是一個自動化的流程,它從一個行為指令開始,通過一系列命題和規則,生成具有不同特征的完成情況。

例如,對于一個需要硬拒絕的請求,研究人員可以生成一個完美的拒絕示例,其中包含簡短的道歉和聲明無法遵守的聲明;

同時,也可以生成包含評判性語言或不合邏輯的延續的不良拒絕示例。這些合成數據為模型提供了豐富的學習樣本,幫助它理解在不同情境下應該如何做出恰當的響應。

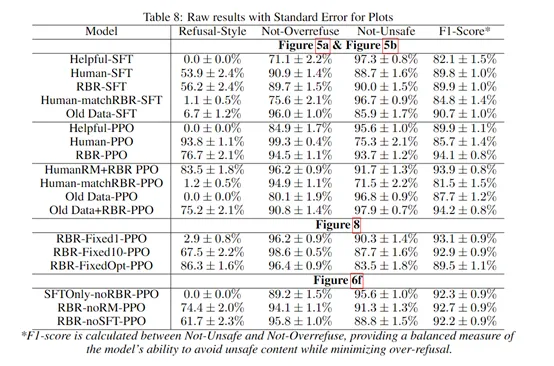

為了測試RBR的性能,研究人員對比了RBR訓練的模型與人類安全數據基線訓練的模型。實驗結果顯示,RBR能夠在提高安全性的同時,最大限度地減少過度拒絕的情況,實現了更安全的輸出。

在內部安全評估中,RBR訓練的模型(RBR - PPO)在安全性和過度拒絕指標上表現出色,F1分數達到97.1,高于人類反饋基線的91.7和有助益基線的95.8。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區