快手開源多模態大模型Kwai Keye-VL,引領視頻理解新紀元 精華

導讀:近日,快手發布并開源其最新自研的多模態大語言模型 Kwai Keye-VL。Kwai Key-VL采用 VisionEncoder-Projector-LLM 架構,集成了文本、圖像、視頻信息的混合輸入處理能力,旨在為用戶帶來更智能、更全面的多模態交互體驗。

如果有人突然問你:「這張圖片中有幾顆草莓」?你會如何快速回復?

面對五彩繽紛的果盤,我們往往需要反復端詳,放大圖片再逐一清點,耗費不少時間才能得到答案。

然而,AI大模型正讓這種復雜視覺識別變得簡單——在快手最新發布的Kwai Keye-VL-8B的試用體驗中,它自動解析圖像細節,執行圖像區域裁剪,放大相關的計算代碼以增強感知效果,在短短幾秒內給出精準答案,一共20顆。

Kwai Keye-VL是快手自主研發的多模態大語言模型。該模型以 Qwen3-8B 語言模型為基礎,引入了基于開源 SigLIP 初始化的 VisionEncoder,Kwai Keye-VL 能夠深度融合并處理文本、圖像、視頻等多模態信息,憑借其創新的自適應交互機制與動態推理能力,旨在為用戶提供更智能、全面的多模態交互體驗。在視覺理解與邏輯推理能力方面,Kwai Keye-VL 的綜合感知能力媲美同規模頂尖模型,并在復雜推理任務中展現出顯著優勢!值得一提的是,其在邏輯推理上的優異表現:在最新的2025年高考全國數學卷中取得了140分的成績。目前,Kwai Keye-VL 已正式開源。

[?? Homepage] : ??https://kwai-keye.github.io/??

[??Github Repo] :???https://github.com/Kwai-Keye/Keye??

[?? Model Weight] :???https://huggingface.co/Kwai-Keye/Keye-VL-8B-Preview??

[??KC-MMBench] :???https://huggingface.co/datasets/Kwai-Keye/KC-MMbench??

「核心技術架構全公開」

?

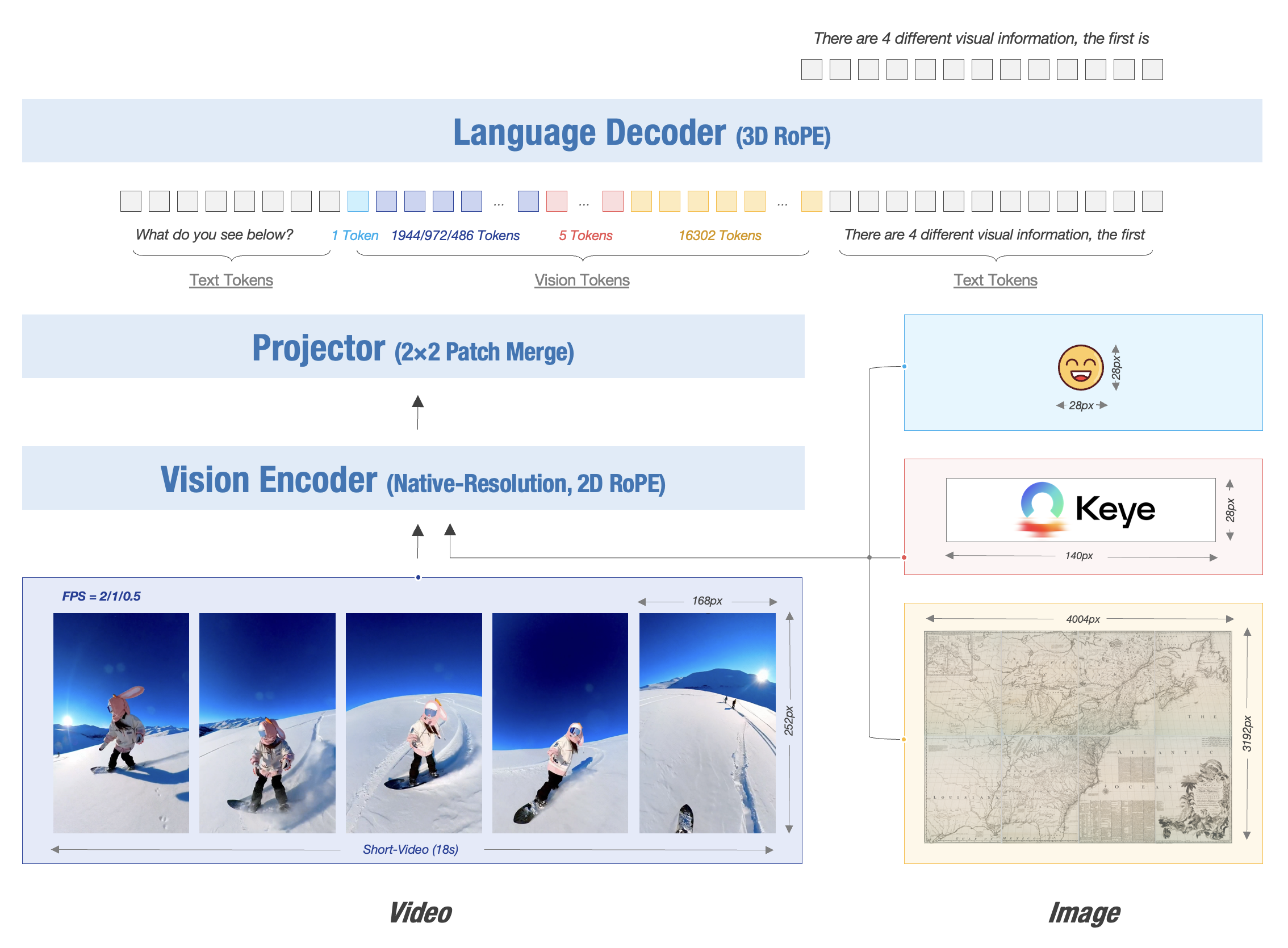

Kwai Keye-VL 基于 Qwen3-8B 語言模型,并整合了 SigLIP 初始化的視覺編碼器。Kwai Keye-VL 支持動態分辨率輸入,按原始比例將圖像切分為 14x14 patch 序列,由一個 MLP 層將視覺 Token 進行映射與合并。模型采用 3D RoPE (旋轉位置編碼)統一處理文本、圖像和視頻,并通過位置編碼與時間戳對齊,精準捕捉視頻時序變化。

一、Pre-Train:構建多模態基座能力

一、Pre-Train:構建多模態基座能力

Kwai Keye-VL 的預訓練階段核心目標是構建強大的圖文和視頻理解能力(即視覺-語言對齊)。為支撐這一目標,模型使用了總量高達 600B 的大規模多模態預訓練數據集,包含圖文、視頻及純文本數據。此外,Kwai Keye-VL 通過自建高質量中文 OCR 系統和精細化描述數據,有效突破了開源數據的局限,專門服務于模型圖文/視頻理解能力的訓練。

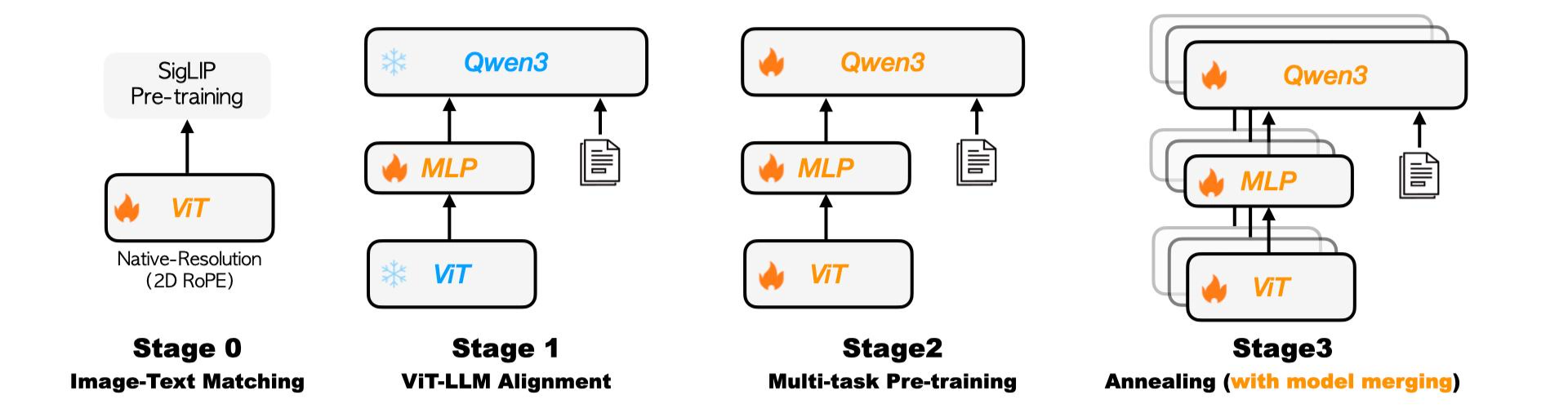

訓練流程采用四階段漸進式優化策略:

?

- 視覺預訓練:持續預訓練視覺編碼器,使其適配內部數據分布并支持動態分辨率輸入。

- 跨模態對齊:凍結主干模型,僅訓練輕量級 MLP 適配器,以極低成本高效建立魯棒的圖文/視頻-文本對齊關系。

- 多任務預訓練:解鎖全部模型參數,進行多任務聯合訓練,全面提升模型的綜合視覺理解能力。

- 退火訓練:使用精選高質量數據進行精調,進一步提升模型的精細理解和判別能力。

最后,Kwai Keye-VL 探索了同構異質融合技術,通過參數平均融合不同數據配比的退火訓練模型,在保留多維度能力的同時,減小模型偏差,增強了模型的魯棒性。

?

二、Post-Train:兩階段精細微調,突破性強化推理能力

?

Kwai Keye-VL 的后訓練階段經過精心設計,旨在全面提升模型的性能,尤其是其在復雜任務中的推理能力,這一部分是模型實現高級認知功能的關鍵突破。

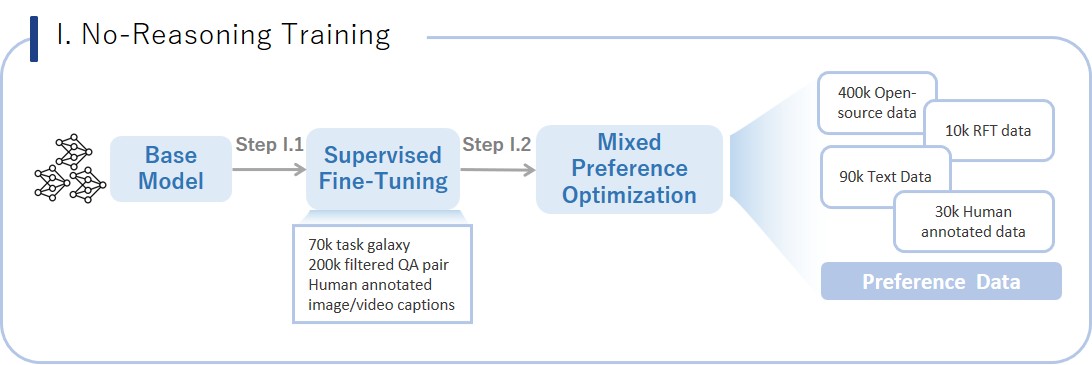

Stage I. 非推理訓練 (No-Reasoning Training):夯實基礎性能

Kwai Keye-VL 首先進行監督精調 (SFT),使用 500 萬條高質量多模態VQA數據,數據多樣性由自研TaskGalaxy方案建立的任務體系(包含7W種任務)保證,數據質量經AI 篩選困難樣本及人工標注保障。

隨后進行混合偏好優化 (MPO),結合開源數據與自建的偏好數據,后者通過收集 SFT 錯誤樣本作提問素材、Qwen2.5VL 72B 與 SFT 模型生成答案對、人工排序獲得。

?

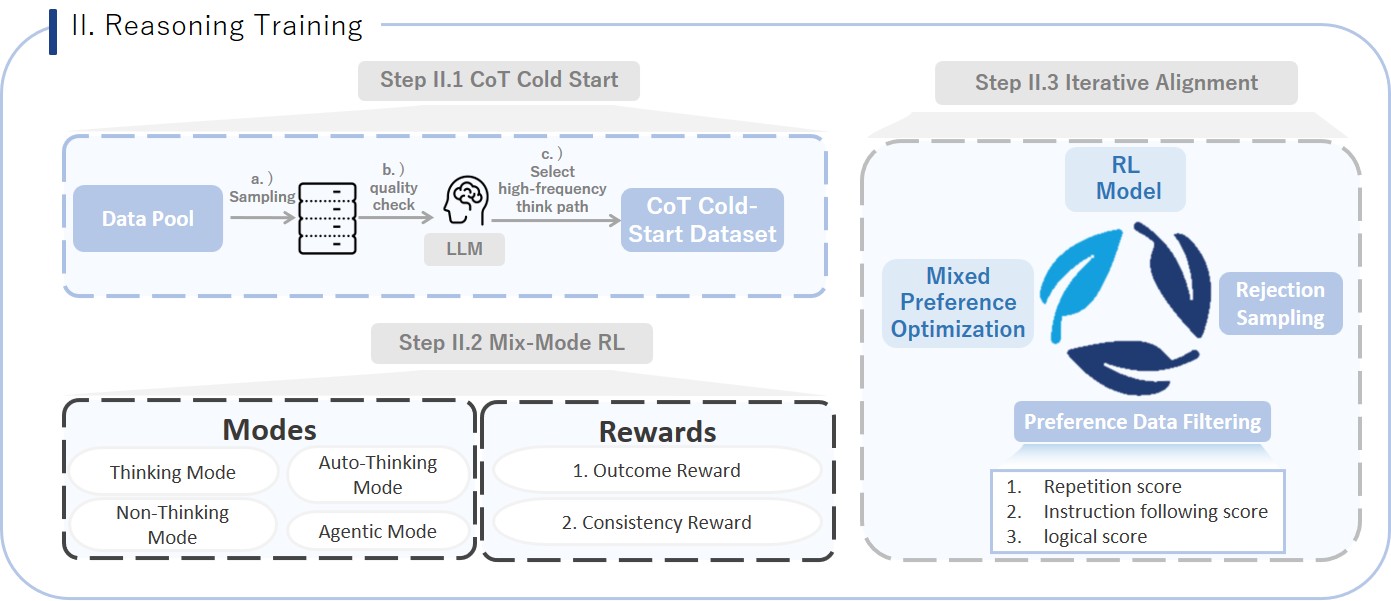

Stage II. 推理訓練 (Reasoning Training):核心突破,賦能復雜認知

此階段是 Kwai Keye-VL 訓練流程的最大亮點與貢獻,通過引入Mix-mode的思維鏈(CoT)和多思考模式強化學習(RL)機制,顯著提升模型的多模態感知、推理和think with image能力,使其能夠處理更復雜、需要多步思考的任務。

具體來說:

Step 1 :思維鏈冷啟動階段(CoT Cold-Start):通過混合四種推理模式的訓練數據(非推理數據、推理數據 、自動推理數據 和智能體 (agentic) 推理數據),實現對模型思維鏈能力的零基礎激活,使其初步掌握人類分步思考的推理范式。

Step 2:混合強化學習階段(CoT-Mix RL):在冷啟動基礎上,采用GRPO算法進行混合模式強化學習,通過創新的雙軌獎勵機制(同步評估結果正確性與過程一致性)深度優化多模態感知、數學推理、短視頻理解及智能體協同等綜合能力,顯著提升模型的推理能力。

Step 3:多輪迭代對齊階段(Iterative Alignment): 利用MPO算法對優/劣數據對進行多輪迭代,根治內容重復崩潰與邏輯斷層問題,最終賦予模型根據問題復雜度智能選擇深度推理模式的自適應能力,實現性能與穩定性的雙重突破。

?

?

Kwai Keye-VL 通過分階段、精細化的預訓練與后訓練策略,特別是對推理能力的深度強化與創新性突破,確保了模型在多種復雜場景下都能提供高質量、邏輯嚴謹且穩定的輸出。

三、訓練架構優化:高效穩定的千億參數模型訓練

為實現百億參數模型的高效穩定訓練,Kwai Keye-VL 通過混合并行策略(整合數據并行/序列并行/ZeRO技術)顯著提升訓練吞吐量,既利用顯存分片降低壓力,又通過計算通信重疊隱藏延遲。

不同于純文本模型訓練,多模態輸入分辨率差異很大,不同顯卡計算負載不均會導致整體利用率降低,Kwai Keye-VL在訓練框架中實現了全局負載均衡策略,依據樣本FLOPS動態分發樣本,盡可能消除硬件閑置,顯著提高了多模態訓練的MFU。同時構建了樣本級自動容錯機制,依托聯合檢查點技術使訓練意外中斷后可自動精準續訓,保證了模型迭代的穩定性。

后訓練階段則通過升級vLLM框架加速采樣,并部署多獎勵模型隨機分發策略,大幅壓縮強化學習的計算耗時,系統性保障了大規模訓練的穩定性與效率。

?

四、模型評估

視覺理解/邏輯推理benchmark

Kwai Keye-VL 在綜合感知能力比肩同規模頂尖模型的同時,在復雜推理任務中展現出顯著領先優勢。

評測數據顯示:其基礎感知達行業一流水準;而在MMMU、MMStar等通用Benchmark及MathVista、OlympiadBench等推理Benchmark上,該模型性能曲線大幅領跑業界,尤其在需要高階邏輯推理與數學解題的挑戰性任務中,凸顯出卓越的復雜問題解決能力。

視頻理解benchmar

Kwai Keye-VL 通過公開與自建評測雙驗證,在學術標準與真實短視頻場景中均展現出全面領先優勢。

為突破公開數據集的數據污染、語言覆蓋局限及任務單一性等問題,快手構建了內部評測集KC-MMBench。

結果顯示:該模型在VideoMME等權威公開Benchmark中以67.4分超越Qwen2.5-VL-7B(62.7)與InternVL-3-8B(65.5);在內部短視頻場景評測中優勢進一步擴大,綜合得分領先SOTA模型超10%,尤其在熱點聚合、內容合集、廣告價值等核心場景表現卓越,實證其學術與產業雙維競爭力。

五、應用案例

實際測試中,Kwai Keye在多種模態下均表現出驚艷的內容理解與創作能力。

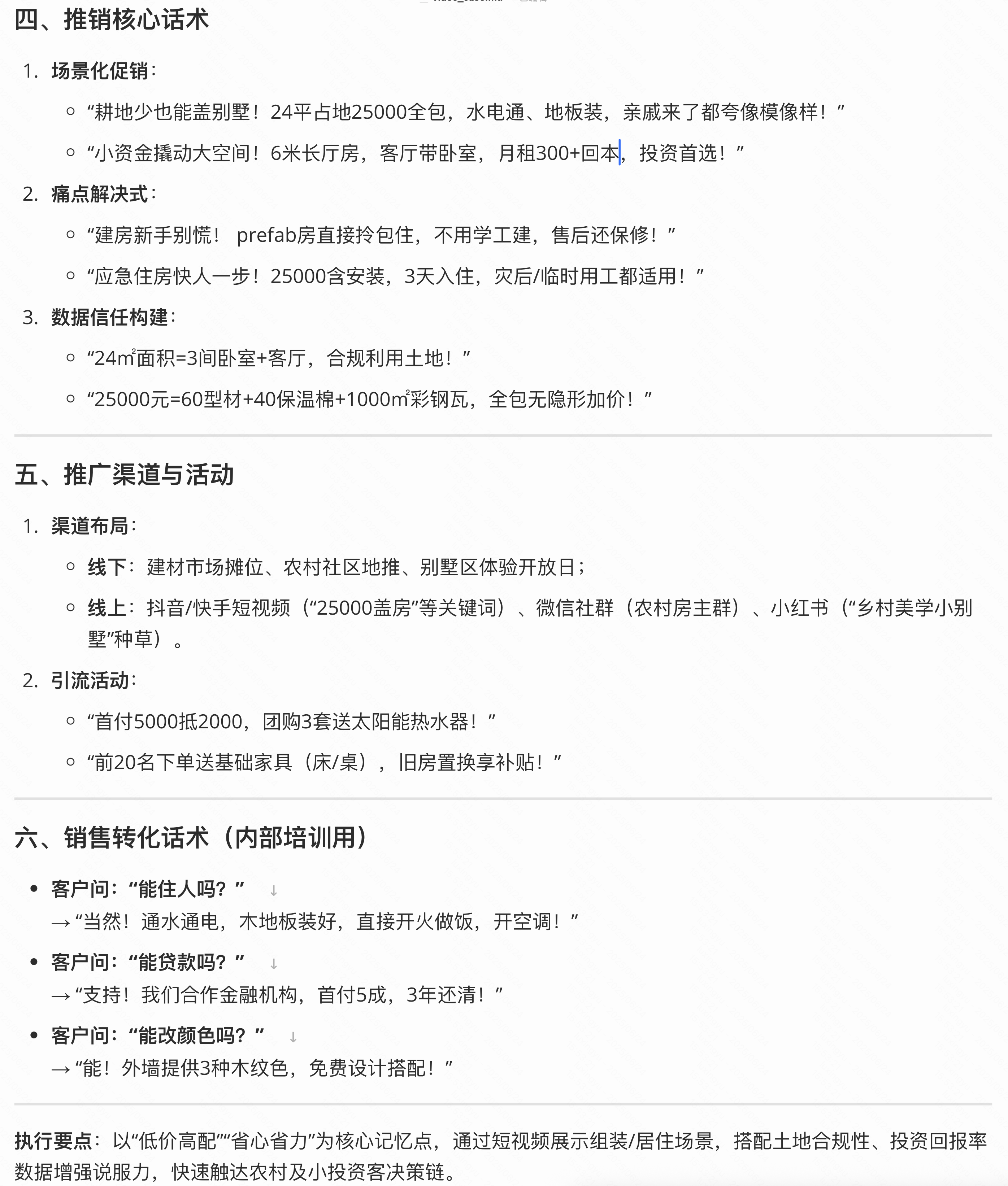

問題:請你為視頻中的商品寫一份推銷方案。

??視頻??

00:11

Kwai Keye-VL給出了一份推銷方案:

?

問題:結合如下這張圖片,寫一首詩

?

Kwai Keye-VL給出的詩詞:

六、未來展

六、未來展望

展望未來,依托快手在短視頻領域深厚的技術積累,Kwai Keye-VL 在視頻理解方面具備獨特優勢。該模型的發布與開源,標志著多模態大語言模型在視頻理解新紀元的探索邁出了堅實一步。