Google推出開源代碼大模型CodeGemma:AI編程新紀元,代碼自動完成和生成技術再升級 精華

- 論文標題: CodeGemma: Open Code Models Based on Gemma

- 機構: Google LLC

- 論文鏈接: https://arxiv.org/pdf/2406.11409.pdf

CodeGemma模型概述

CodeGemma是基于Google DeepMind的Gemma模型系列(Gemma Team et al., 2024)開發的一系列開放代碼模型。這些模型繼承了Gemma預訓練模型的基礎,并在此基礎上進一步訓練,使用的數據主要是代碼,訓練數據量在5000億到1000億token之間。CodeGemma模型在代碼完成和生成任務中達到了最先進的性能,同時在大規模情況下仍保持強大的理解和推理能力。

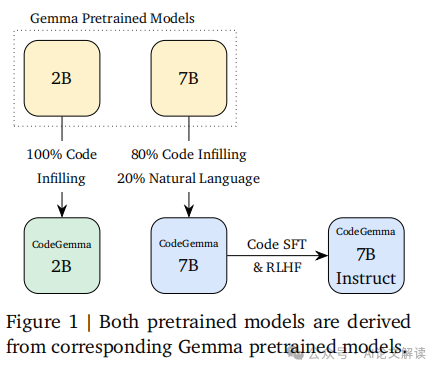

CodeGemma發布了三種模型:一個7B的代碼預訓練模型,一個7B的指令調優代碼模型,以及一個專門為代碼填充和開放式生成訓練的2B模型。這些模型的系譜在文中的圖1中有所展示。

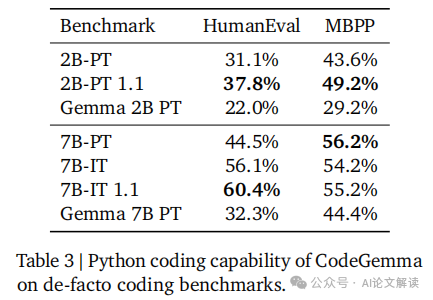

在發布的第一個版本(v1.0)中,包括了所有三種模型,隨后在一個月后的第二個版本(v1.1)中,對預訓練的2B模型和指令調優的7B模型進行了更新。如果速度不是關鍵考慮因素,建議使用v1.1版本,因為它在質量上有較好的平衡提升。

模型訓練和數據處理

1. 數據處理和預訓練

所有CodeGemma v1.0模型都是在主要由英語網頁文檔、數學和代碼組成的5000億token數據上進一步訓練的。2B v1.1模型則在1萬億token上訓練。所有2B模型都是100%使用代碼訓練的,而7B模型則是80%代碼和20%自然語言的混合。我們的代碼語料庫來源于公開可用的代碼倉庫。數據集經過去重和過濾,以移除評估代碼中的污染以及某些個人和敏感數據。除了Gemma的處理步驟外,我們還為代碼數據執行了額外的預訓練步驟。

2. 指令調優

指令調優的7B v1.1模型與其1.0版本不同之處在于使用的強化學習算法(基于Gemma 1.1)和合成數據生成的具體細節。這些模型都遵循以下的一般方向。

為了提高模型與現實世界應用的一致性,我們通過將代碼倉庫中最相關的源文件共同定位,并盡最大努力將它們分組到相同的訓練示例中來創建訓練示例。具體來說,我們采用了兩種啟發式方法:基于依賴圖的打包和基于單元測試的詞匯打包。

為了構建依賴圖,我們首先按倉庫對文件進行分組。對于每個源文件,我們從頂部N行中提取導入,并執行后綴匹配以確定在倉庫結構中最長的匹配路徑。我們確定文件之間的邊緣重要性(一種啟發式測量),并移除不重要的邊緣以打破循環依賴(在Python中常見)。然后,我們計算圖中所有對的最短路徑,其中較短的距離表示文件關系更強。最后,我們使用拓撲排序對文件圖進行線性化,選擇基于到已排序節點的最小距離的下一個無父節點,并使用字典順序來打破平局。

模型性能評估

1. 代碼完成和生成任務的性能

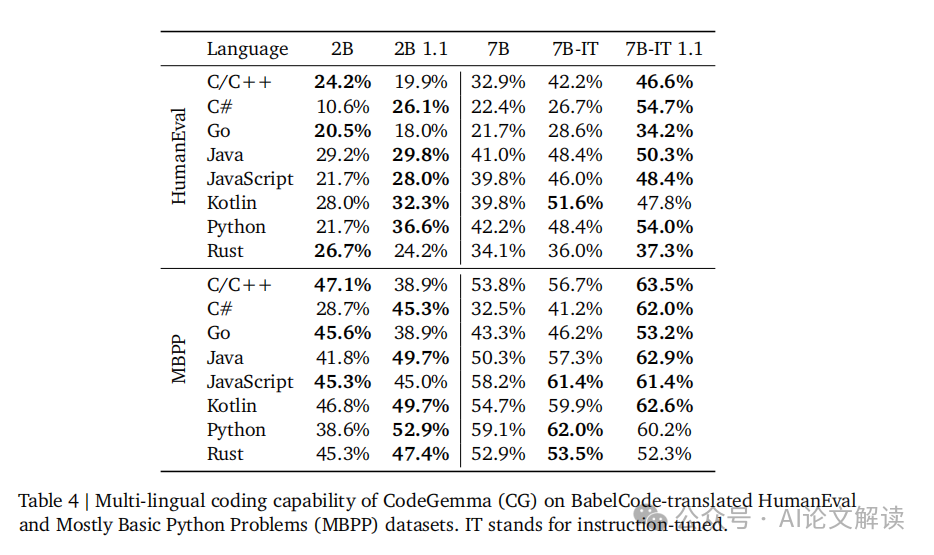

CodeGemma模型在代碼完成和生成任務中表現出色。特別是,2B預訓練模型在代碼完成任務中表現突出,其低延遲特性對于需要快速響應的用例非常關鍵。此外,7B模型在代碼生成任務中也顯示了強大的性能,尤其是在多語言代碼生成方面,如BabelCode測試所示(表4)。這些模型在HumanEval和Mostly Basic Python Problems基準測試中的表現(表3)進一步驗證了其優越性。

2. 自然語言理解能力

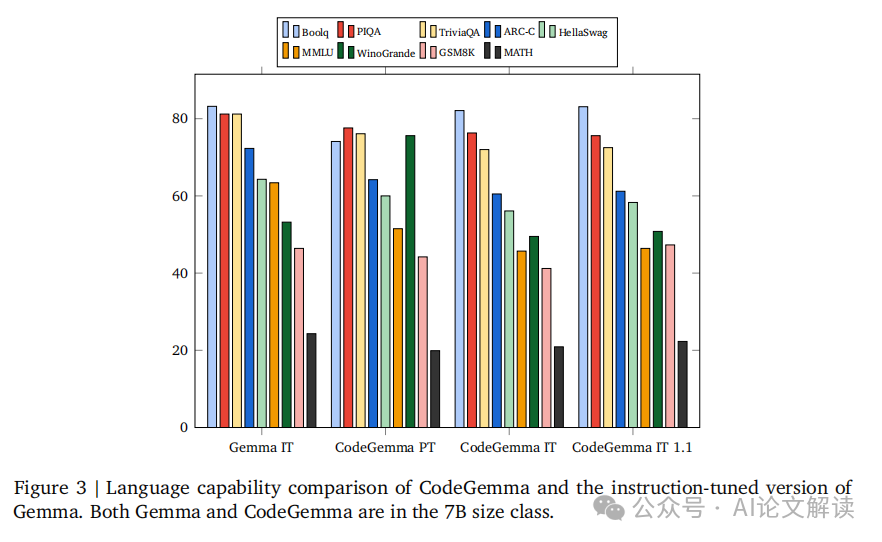

CodeGemma模型保留了基礎Gemma模型的自然語言處理能力。在自然語言理解方面,CodeGemma的表現優于多個同類模型,例如Mistral 7B和Llama-2 13B模型。這一優勢體現在多個自然語言處理基準測試中,如BoolQ和PIQA(Clark et al., 2019; Bisk et al., 2019)。這些能力使得CodeGemma模型不僅在代碼相關任務,也在需要理解和生成自然語言的任務中表現出色。

3. 數學推理能力

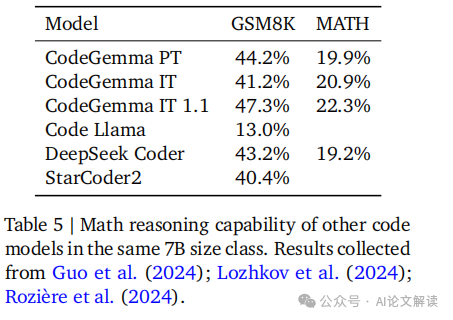

CodeGemma模型在數學推理能力方面也顯示出卓越的性能。通過在多個數學數據集上進行訓練,如Math Dataset和MathQA,模型的數學問題解決能力得到了顯著提升。這些數據集包括從數學競賽中收集的問題以及基于程序生成的代數問題,這些訓練幫助模型在復雜的數學推理任務中表現優異(表5)。

實際應用和部署

CodeGemma模型的設計使其非常適合在實際應用和部署中使用。2B模型由于其快速的代碼填充能力,特別適合集成到集成開發環境(IDE)和本地環境中。這一模型在內存和響應速度方面的優化,使其成為開發者的有力工具。

7B模型則因其在代碼任務和自然語言理解任務中的強大表現,更適合部署在托管環境中,如云計算平臺。這些模型在處理大規模和復雜的代碼生成和理解任務時,能夠提供高質量的輸出。

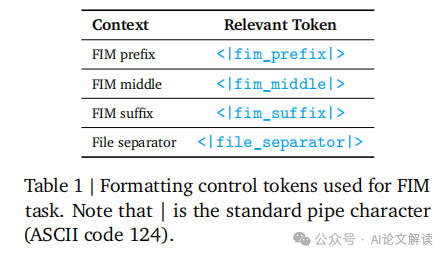

在部署這些模型時,需要注意的是,應選擇合適的輸出停止策略以適應部署環境。例如,可以使用生成FIM哨兵令牌的方法來截斷輸出,以確保生成的代碼質量和一致性。

總之,CodeGemma模型系列通過在代碼生成、自然語言理解和數學推理等多個方面的出色表現,為各種實際應用場景提供了強大的支持。

模型的優勢和局限性

1. 模型的優勢

CodeGemma模型在代碼生成和理解方面展現出了顯著的優勢。這些模型不僅在自然語言處理任務中保持了強大的性能,而且在數學推理方面也顯示出了卓越的能力。例如,CodeGemma 7B模型在多種編程語言的代碼生成任務中表現優異,這一點在BabelCode的評估中得到了驗證(見表4)。此外,這些模型在處理大規模代碼數據集時,能夠有效地進行代碼補全和生成,特別是2B預訓練模型在低延遲場景下表現出了極高的效率,這對于集成開發環境(IDEs)等應用場景非常關鍵。

2. 模型的局限性

盡管CodeGemma模型在多個方面表現出色,但它們也存在一些局限性。首先,盡管7B模型在代碼任務中表現優異,但其在推理時需要較大的內存,這可能限制了它們在資源受限的環境中的應用。此外,根據Gemma團隊的報告,所有模型都在處理某些特定類型的代碼或語言結構時存在一定的局限性,尤其是在跨文件代碼依賴關系的自動補全方面。此外,雖然模型在數學問題解決方面表現良好,但在一些高難度的數學問題上,模型的解決能力仍有待提高。

本文轉載自 ??AI論文解讀??,作者: 柏企科技圈