終結(jié)評測割裂!MMIG-Bench發(fā)布:首創(chuàng)三層評測框架,多模態(tài)圖像生成統(tǒng)一標(biāo)尺

文章地址:https://arxiv.org/pdf/2505.19415

開源地址:https://hanghuacs.github.io/MMIG-Bench/

亮點直擊

- 統(tǒng)一的任務(wù)覆蓋與多模態(tài)輸入:收集了超過 380 組(涵蓋動物、物體、人類和風(fēng)格等類別),共計1,750張以物體為中心的多視圖圖像,支持嚴(yán)格的基于參考圖像的生成任務(wù)。

- 構(gòu)建了4,850條富含標(biāo)注的提示語,涵蓋組合性(屬性、關(guān)系、物體、數(shù)量)、風(fēng)格(固定模式、專業(yè)風(fēng)格、自然風(fēng)格、人類書寫)、寫實性(想象類)以及常識性(比較、否定)等方面。為未來圖像生成研究提供了靈活性,支持任意圖像生成任務(wù)。

- 三層次評估體系:提出了一個多層次的評分框架,以實現(xiàn)全面評估。

- 通過 3.2 萬條人類評分驗證了上述評估指標(biāo)的有效性,并對 17 個當(dāng)前最先進的模型進行了基準(zhǔn)測試,提供了關(guān)于架構(gòu)選擇和數(shù)據(jù)構(gòu)建的設(shè)計洞見。

MMIG工作臺概述

MMIG Bench中標(biāo)簽的統(tǒng)計。左上角:T2I任務(wù)中文本的組成類別和高級類別的數(shù)據(jù)分布。左下:自定義任務(wù)中文本提示的數(shù)據(jù)分布。右:參考圖像的類別統(tǒng)計

更多結(jié)果

總結(jié)速覽

解決的問題

- 當(dāng)前多模態(tài)圖像生成模型(如 GPT-4o、Gemini 2.5 Pro 等)雖在理解復(fù)雜指令、圖像編輯和概念一致性方面表現(xiàn)優(yōu)異,但評估體系仍存在顯著不足:

- 文本生成圖像(T2I)基準(zhǔn)缺乏多模態(tài)條件輸入;

- 定制圖像生成基準(zhǔn)忽視組合語義和常識性理解;

- 評估工具分散:缺乏統(tǒng)一的評估基準(zhǔn);

- 現(xiàn)有基準(zhǔn)局限性:

- 缺乏細(xì)粒度的語義對齊評估方法。

提出的方案

- 構(gòu)建了第一個面向圖像生成的綜合多模態(tài)基準(zhǔn)測試集——MMIG-Bench,統(tǒng)一多模態(tài)圖像生成任務(wù)的評估。

- 核心設(shè)計包括:

- 收集 380+ 個主體(人類、動物、物體、風(fēng)格等);

- 提供 1,750 張多視角參考圖像;

- 構(gòu)建 4,850 條富含標(biāo)注的文本提示,涵蓋組合性、風(fēng)格性、寫實性和常識性。

- 任務(wù)統(tǒng)一與多模態(tài)輸入支持:

- 三層次評估體系:

- 低層級:評估視覺偽影與物體身份保持;

- 中層級:提出新指標(biāo)AMS(Aspect Matching Score),基于 VQA,衡量語義對齊;

- 高層級:評估圖像美學(xué)質(zhì)量與人類偏好。

應(yīng)用的技術(shù)

- 數(shù)據(jù)構(gòu)建:

- 多視角圖像采集與標(biāo)注;

- 富語義提示語設(shè)計,涵蓋組合性、風(fēng)格、否定、比較等多種語言現(xiàn)象。

- 評估方法:

- 基于圖像分析的低層級指標(biāo);

- 基于視覺問答(VQA)的中層級指標(biāo)(AMS);

- 基于人類評分的高層級審美與偏好評估。

- 大規(guī)模人類評估驗證:

- 收集32,000 條人類評分,用于驗證指標(biāo)有效性。

達到的效果

- 統(tǒng)一評估框架:將 T2I 與定制生成任務(wù)統(tǒng)一于一個基準(zhǔn)中,實現(xiàn)靈活、全面的評估。

- 指標(biāo)有效性驗證:AMS 等指標(biāo)與人類主觀判斷高度相關(guān)。

- 模型對比分析:

- 對 17 個最先進的圖像生成模型(如 Gemini 2.5 Pro、FLUX、DreamBooth、IP-Adapter 等)進行系統(tǒng)評估;

- 提供關(guān)于模型架構(gòu)與訓(xùn)練數(shù)據(jù)設(shè)計的深入洞見。

- 推動研究發(fā)展:

- 計劃公開數(shù)據(jù)集與評估代碼,促進多模態(tài)圖像生成領(lǐng)域的標(biāo)準(zhǔn)化評估與創(chuàng)新。

數(shù)據(jù)整理

概述

多模態(tài)圖像生成通常涉及參考圖像和文本提示作為輸入。因此,基準(zhǔn)測試的數(shù)據(jù)收集分為兩個部分:分組圖像收集和文本提示生成(如下圖 3 所示)。首先從現(xiàn)有的文本生成圖像(T2I)基準(zhǔn)中提取實體(如[28, 27, 57])。在收集了超過 2,000 個不同實體后,我們保留了使用頻率最高的 207 個實體以供后續(xù)使用。

使用 GPT 生成文本提示

為了實現(xiàn)可擴展且多樣化的提示生成,我們使用 GPT-4o 和若干預(yù)定義的指令模板(如圖 3 所示)。通過將實體和指令模板作為輸入,我們總共生成了 4,350 條合成提示,涵蓋兩個任務(wù)。此外,我們從已有工作中手動篩選了 500 條人工書寫的提示。為確保語義方面的廣泛覆蓋,我們將提示分為兩個主要類別:組合類和高層類。

組合類包括五個子類:物體、計數(shù)、屬性、空間關(guān)系(如 next to、atop、behind)和復(fù)雜關(guān)系(如 pour into、toss、chase)。高層類包括七個子類,包括風(fēng)格(固定模式、自然、專業(yè)、人類書寫)、寫實性(想象類)以及常識(否定、比較)。

為了更好地控制提示的要素、風(fēng)格和結(jié)構(gòu),我們設(shè)計了八種指令模板,以 T2I 任務(wù)為例。當(dāng)提示需要組合性和特定結(jié)構(gòu)時,我們使用以下格式:"[scene description (optional)] + [number][attribute][entity1] + [interaction (spatial or action)] + [number (optional)][attribute][entity2]"。

當(dāng)提示需要更接近自然語言、人工書寫風(fēng)格時,使用更靈活的指令:"Please generate prompts in a NATURAL format. It should contain one or more "entities / nouns", (optional) "attributes / adjective" that describes the entities, (optional) "spatial or action interactions" between entities, and (optional) "background description"."

為確保生成提示的質(zhì)量和安全性,我們進一步過濾有毒或低質(zhì)量內(nèi)容,并使用 FineMatch 生成密集標(biāo)簽,使數(shù)據(jù)集更加靈活且適用于研究用途。

分組主體圖像收集

以物體為中心且寫實的分組參考圖像在以往基準(zhǔn)中通常缺失。然而,多張參考圖像在多個任務(wù)中已被證明是有效的,包括圖像定制、視頻生成和三維重建。為填補這一空白,我們收集了大量分組參考圖像。

目標(biāo)物體選自我們之前識別出的 207 個常見實體。聘請標(biāo)注員從 Pexels中整理分組物體圖像,遵循以下準(zhǔn)則:

- 每組包含 3–5 張同一物體的圖像;

- 每組中物體呈現(xiàn)不同的姿勢或視角;

- 優(yōu)先選擇具有復(fù)雜標(biāo)志或紋理的物體。

此外,還收集了 12 種風(fēng)格的藝術(shù)圖像(如素描、低多邊形、油畫)以支持風(fēng)格遷移任務(wù)。

總計收集了來自 386 個組的 1,750 張圖像,涵蓋四個主要類別——動物、人類、物體和風(fēng)格 —— 如下圖 2(右)所示。為確保圖像質(zhì)量,進行了過濾和裁剪以去除無關(guān)內(nèi)容。基于所收集圖像中的實體,我們使用上述方法生成相應(yīng)的文本提示。

用于中層級評估的數(shù)據(jù)整理

中層級評估的目標(biāo)是從細(xì)粒度維度分析文本與圖像的對齊情況,使得生成細(xì)節(jié)的評估更具可解釋性。為此,借鑒 FineMatch,從“物體、關(guān)系、屬性、計數(shù)”四個方面分析細(xì)粒度的文本-圖像對齊。首先使用 GPT-4o 從輸入提示中提取所有相關(guān)方面的短語,然后利用上下文學(xué)習(xí)提示 GPT-4o 生成相應(yīng)的問答對。

提示解析

遵循 FineMatch的方法,從文本提示中整理方面短語,并使用 GPT-4o 進行方面圖解析,因為其具備優(yōu)越的組合解析能力。具體而言,GPT-4o 在顯式指令和上下文示例的指導(dǎo)下,準(zhǔn)確提取并分類短語為四類:物體、關(guān)系、屬性和計數(shù)查詢。

問答對生成

參考以往基于 VQA 的評估框架,如[59, 15, 4, 16, 49, 14, 32, 18],繼續(xù)為每個方面短語生成高質(zhì)量的問答(QA)對。首先,領(lǐng)域?qū)<覟槊恳活悇e(物體、關(guān)系、屬性、計數(shù))人工整理了一組示例問答對。這些人工整理的問答對在隨后的上下文學(xué)習(xí)階段作為上下文示例。

隨后,使用這些示例提示 GPT-4o 為所提取的方面短語生成全面的問答對,確保其與細(xì)粒度評估維度的一致性。該自動生成過程通過調(diào)整指令和示例進行迭代優(yōu)化,以提升覆蓋率、清晰度和一致性。

人工驗證

為了保證數(shù)據(jù)集的質(zhì)量、可解釋性和可靠性,引入經(jīng)過訓(xùn)練的人工標(biāo)注員,執(zhí)行結(jié)構(gòu)化的驗證流程。標(biāo)注員執(zhí)行多個質(zhì)量保障任務(wù),包括:

- 毒性與適宜性過濾:標(biāo)注員篩查生成的問答對中是否存在有害、冒犯或不當(dāng)內(nèi)容,以確保在研究環(huán)境中的倫理合規(guī)性和可用性。

- 問答對校正與驗證:每一個由 GPT-4o 生成的問答對都經(jīng)過嚴(yán)格的人工驗證,以確認(rèn)其邏輯一致性、準(zhǔn)確性以及與原始方面短語的相關(guān)性。標(biāo)注員會優(yōu)化含糊的問題、修正事實錯誤,并確保問題與答案之間的精確對應(yīng)關(guān)系。

- 方面短語優(yōu)化:提取的方面短語會被仔細(xì)檢查并優(yōu)化語言清晰度和語義準(zhǔn)確性。標(biāo)注員審查每一個短語,以確保其正確且全面地代表預(yù)期的組合性方面(物體、關(guān)系、屬性、計數(shù))。

經(jīng)過這些嚴(yán)格的人工驗證步驟后,我們獲得了一個高質(zhì)量的數(shù)據(jù)集,共包含 28,668 條驗證后的問答對(其中 T2I 任務(wù)為 16,819 條,自定義任務(wù)為 11,849 條),專為支持細(xì)粒度文本-圖像對齊的詳細(xì)分析而設(shè)計。

提出指標(biāo) - MMIG-Bench

低層級評估指標(biāo)

低層級評估的目標(biāo)是評估生成圖像中的偽影,并評估生成圖像與提示之間,以及生成圖像與參考圖像之間的低層特征相似性。為此,我們借助已有的評估指標(biāo):

- CLIP-Text:衡量生成圖像與輸入提示之間的語義對齊;

- CLIP-Image、DINOv2和CUTE:衡量身份保持程度;

- PAL4VST:通過分割模型評估生成偽影的數(shù)量。

這些指標(biāo)共同提供了對視覺質(zhì)量和一致性的全面評估。

中層級評估指標(biāo)

中層級評估的目標(biāo)是評估生成圖像與文本提示之間的細(xì)粒度語義對齊。我們使用與四個方面對應(yīng)的收集問答對,設(shè)計了一個新的可解釋評估框架 —— Aspect Matching Score(AMS)。

Aspect Matching Score

我們將 Aspect Matching Score 定義為答對的 VQA 問題所占的比例:

其中1(.) 是一個指示函數(shù),當(dāng)預(yù)測答案與真實答案完全匹配時返回 1,否則返回 0。

AMS 提供了一個直接且可解釋的度量,用于衡量生成圖像與提示中每個語義組成部分的對齊程度。更高的 AMS 表示更好的細(xì)粒度對齊,能夠捕捉到粗粒度指標(biāo)常常忽略的失敗情況。

高層級評估指標(biāo)

高層級評估的目標(biāo)是評估生成圖像的美學(xué)質(zhì)量和人類偏好。為此借助已有的評估指標(biāo),如 Aesthetic、HPSv2 和 PickScore。這些指標(biāo)為生成結(jié)果的視覺吸引力和與人類偏好的對齊程度提供了全面評估。

實驗

人類評估

為了評估最先進生成模型的語義保持能力,并比較基于 VQA 的指標(biāo)與人類之間的相關(guān)性,進行了五項用戶研究。我們在五個方面評估了 12 個文本到圖像(T2I)模型:屬性、關(guān)系、計數(shù)、物體和一般提示遵循性。對于前四個方面,隨機選擇了 150 個提示;對于最后一個方面,使用了 300 個提示。

在每項研究中,用戶會看到一個提示和一張生成圖像,并被要求根據(jù)目標(biāo)方面在 1–5 分的尺度上對語義對齊程度進行評分(詳見附錄)。總共從超過 8,000 名 Amazon Mechanical Turk 用戶處收集了 32,400 條評分。結(jié)果見下表 3。

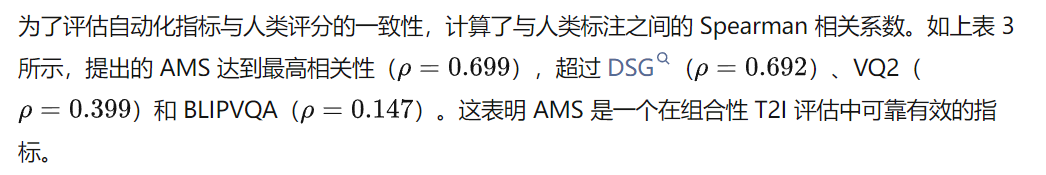

自動化指標(biāo)與人類標(biāo)注的相關(guān)性

排行榜

使用多層級評估框架,比較了最先進模型在 T2I 任務(wù)(下表 1)和自定義任務(wù)(下表 2)中的表現(xiàn)。

根據(jù)得分,可以得出以下結(jié)論:

在 T2I 任務(wù)中:

- 與擴散模型相比,自回歸模型(JanusFlow 和 Janus-Pro7B)在視覺質(zhì)量方面表現(xiàn)明顯較差,更容易生成偽影,并且在美學(xué)和人類偏好評分中得分最低;

- HiDream-I1 是參數(shù)量最大的模型(17B),在所有生成器中表現(xiàn)最優(yōu);它利用了修正流和來自 FLUX.1-schnell 的 VAE;

- FLUX.1-dev(第二大模型,參數(shù)為 12B)在大多數(shù)指標(biāo)中排名第二;

- HiDream-I1 和 FLUX.1-dev 的表現(xiàn)表明擴展生成模型規(guī)模的重要性;

- 雖然 GPT-4o 并非在所有指標(biāo)中都是最優(yōu),但其生成能力非常穩(wěn)健,在各項指標(biāo)中均具競爭力。

在自定義任務(wù)中,得出以下結(jié)論:

- 在大多數(shù)評估身份保持的低層級指標(biāo)中,DreamBooth 是表現(xiàn)最強的模型;其多視角輸入和測試時微調(diào)極大提升了身份學(xué)習(xí)能力;

- GPT-4o 的身份保持能力較弱,甚至低于一些早期模型,如 Emu2 和兩個基于編碼器的模型(BLIP Diffusion 和 IP-Adapter);

- GPT-4o 在視覺質(zhì)量和語義對齊方面排名第一;

- MS Diffusion 通常在生成質(zhì)量方面排名第二,驗證了其 grounding resampler 和 MS cross-attention 的有效性。然而,它在身份保持方面表現(xiàn)不佳。

質(zhì)性分析

在下圖 4 中展示了多模態(tài)圖像生成的質(zhì)性結(jié)果。前六行展示了僅以文本為條件的生成;后三行展示了以圖像和文本為條件的生成。

主要觀察如下:

在 T2I 任務(wù)中:

- Hunyuan-DiT-V1.2 在實體生成方面表現(xiàn)不佳,常常遺漏物體、重復(fù)生成或生成錯誤的對象;

- Pixart-Sigma-XL2 顯示出更明顯的視覺偽影(如在長椅、椅子和電腦周圍),這與其在表 1 中較低的 PAL4VST 得分一致。

在自定義任務(wù)中:

- 非剛性物體(例如狗)往往會呈現(xiàn)出更為多樣的姿態(tài);

- MS-Diffusion 在保持物體身份方面表現(xiàn)最差,而 DreamBooth 表現(xiàn)最好;這一點與表 2 中的 CLIP-I 和 DINOv2 得分高度一致;

- 盡管 DreamBooth 在身份保持方面表現(xiàn)強勁,但它常常無法生成正確的場景、動作或附加實體,表明其組合性對齊能力較差。

討論與結(jié)論

MMIG-Bench,這是第一個將多模態(tài)圖像生成視為單一任務(wù)而非兩個分離任務(wù)的基準(zhǔn)測試集。展示了通過將 1,750 張多視角參考圖像與 4,850 條密集標(biāo)注的提示配對,MMIG-Bench 能夠?qū)兾谋镜綀D像、圖像條件自定義以及二者之間的所有混合形式進行并列評估。

所提出的三層級評估框架提供了全面、可解釋的評估方式,彌補了 T2I 和自定義任務(wù)中評估的空白。通過與 17 個最先進模型的 32,000 條人類評分對比,評估指標(biāo)被證明與人類偏好高度一致。

對圖像生成器在本基準(zhǔn)上的深入評估提供了關(guān)于模型容量、模型架構(gòu)及其他因素如何影響圖像質(zhì)量的見解。一個限制是人類評分尚未涵蓋視覺質(zhì)量;計劃在未來的研究中擴展至這一維度。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來