GPT-4o 到底有多強?模型圖文多模態能力評測結果全公開

5 月 14 日, OpenAI 發布了 GPT-4o ,支持文本、圖像、語音、視頻等多種形式的輸入,大幅提升了推理響應的速度,在非英文任務上具有較大提升,并擁有比現有模型更強的視覺理解能力。我們第一時間對 GPT-4o 模型的圖像-文本多模態能力進行了評測。

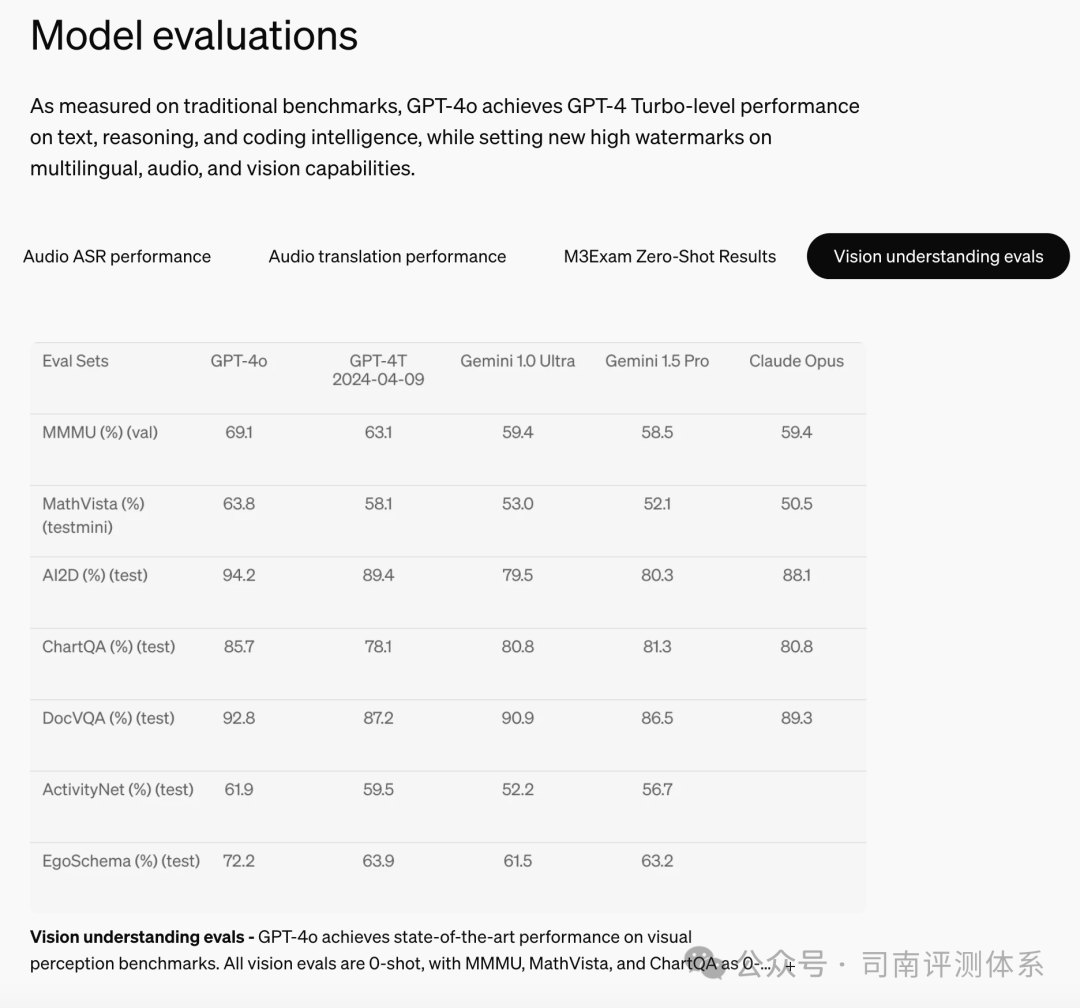

OpenAI 官方公布的視覺理解性能

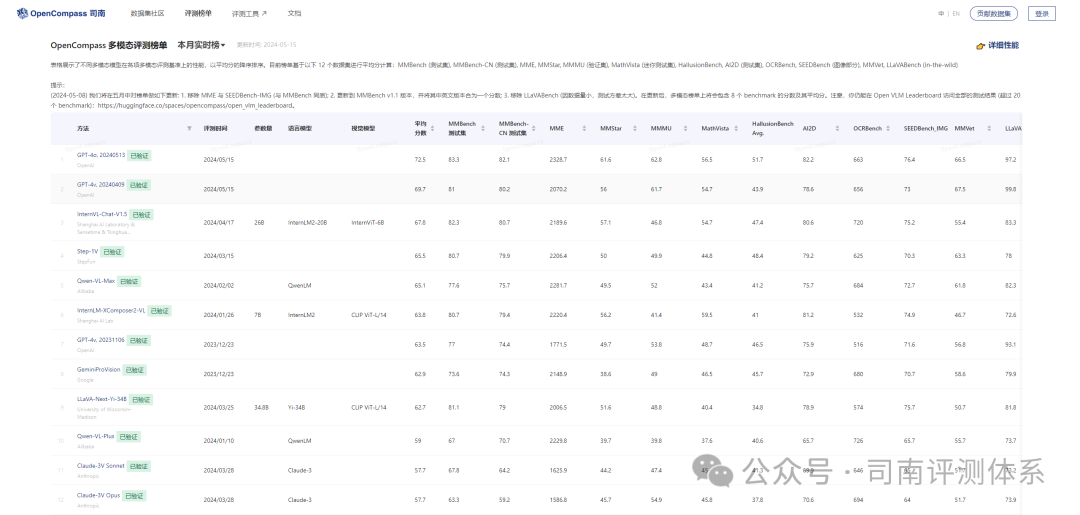

基于多模態大模型開源評測工具 VLMEvalKit,我們在 Open VLM Leaderboard 中的十二個圖文多模態評測集上測試了 GPT-4o 的視覺能力。

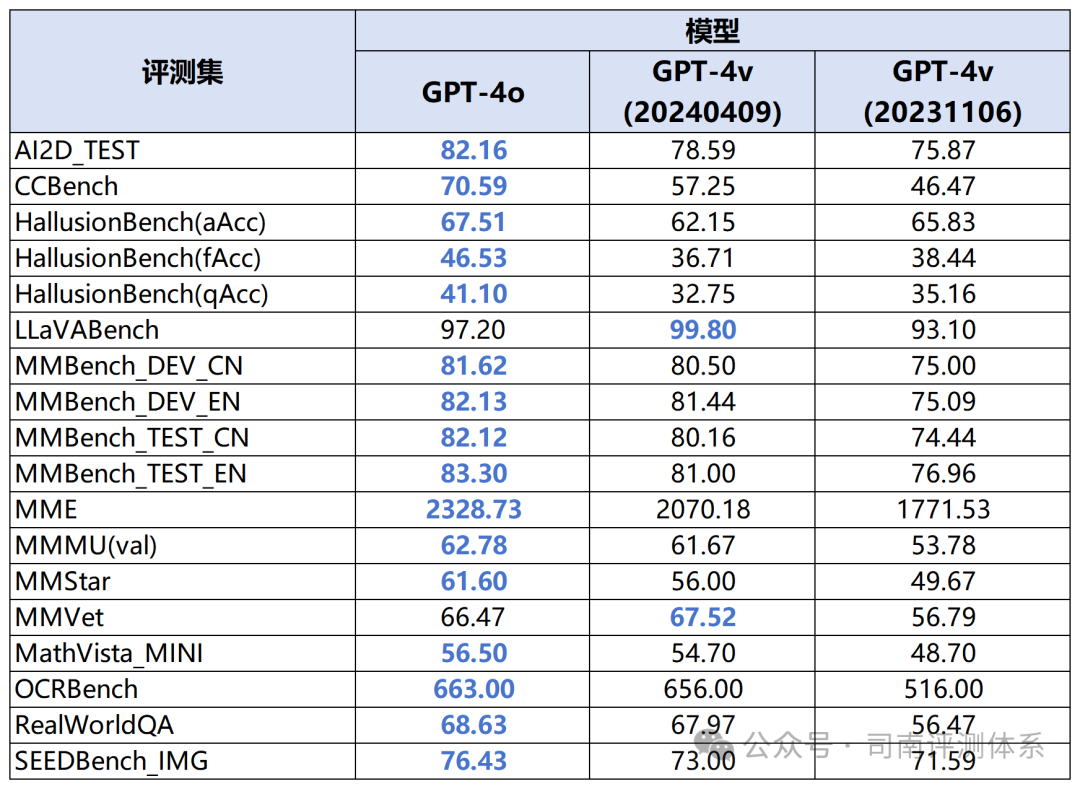

GPT-4o (20240513) 與此前的 GPT-4v 版本在各個多模態測試集上的性能對比

在各個通用圖文多模態評測數據集 (MMBench, MME, SEEDBench, MMStar 等) 上,GPT-4o 相比上一版本的 GPT-4v 均有不同程度的提升。其中在更具挑戰性的 MMStar,中文測試集 CCBench,MMBench_CN 等上面的提升尤其顯著。

在基于GPT-4主觀打分的MMVet與LLaVABench上,GPT-4o 相比上一版本的 GPT-4v 有微小下降,目前猜測是由于 GPT-4 打分的隨機性所致。

在強推理的多模測試集 (MMMU, MathVista 等) 上,GPT-4o 相比上一版本的 GPT-4v 有一定提升,但比較微小。

在幻覺多模測試集 HallusionBench 上,GPT-4o 相比上一版本的 GPT-4v 有顯著提升。

總 結

- GPT-4o 的客觀性能相比 GPT-4v (0409) 有了更進一步的提升,在所有測試集上的平均分提升約 3 分;

- GPT-4o 顯示了更強的感知能力與更少的幻覺;

- GPT-4o 的中文能力得到了較大的提高。

需要注意的是,由于 OpenAI 設置的規則,GPT-4o 在解答部分評測集中問題的時候,會出現拒答的現象。這一點導致 GPT-4o 的真實性能可能較我們報告的性能更強。

GPT-4o 的詳細評測結果已上線至Opencompass官網及Open-VLM-Leaderboard,歡迎大家訪問查看更詳細的評測數據!

Opencompass官網:

???https://opencompass.org.cn/??

Open-VLM-Leaderboard:

??https://huggingface.co/spaces/opencompass/open_vlm_leaderboard??