QuantAgent:通過自我改進的大語言模型尋找交易中的圣杯

?摘要

基于大型語言模型的自主代理在量化投資等專業領域的應用面臨挑戰,尤其是構建和整合領域特定知識庫。本文提出一個兩層循環的框架:內層循環通過知識庫優化響應,外層循環在真實場景中測試響應并自動增強知識庫。該方法使代理能夠逐步接近最優行為,并具備可證明的效率。通過名為QuantAgent的自主代理實例化該框架,展示其在挖掘交易信號和提高金融預測準確性方面的能力。

簡介

大型語言模型(LLMs)推動了自主智能體的發展,提升其在復雜任務中的能力,尤其在量化投資領域面臨知識整合挑戰。傳統方法依賴于人力構建知識庫或通過檢索增強生成技術,但在某些領域(如金融alpha數據庫)難以實現。

本文提出一個兩層框架,旨在以最小人力開發領域特定知識庫,采用內外循環系統進行自我改進。內循環通過與模擬環境互動優化響應,外循環通過真實環境反饋豐富知識庫,促進性能提升。理論分析表明,該框架在某些假設下高效收斂,結合強化學習的分析技術。實際應用通過QuantAgent實現,專注于金融信號挖掘,構建包含信號、實施細節和績效指標的知識庫。實證結果驗證了QuantAgent的自我改進能力,生成了更準確的金融預測信號。

整體框架

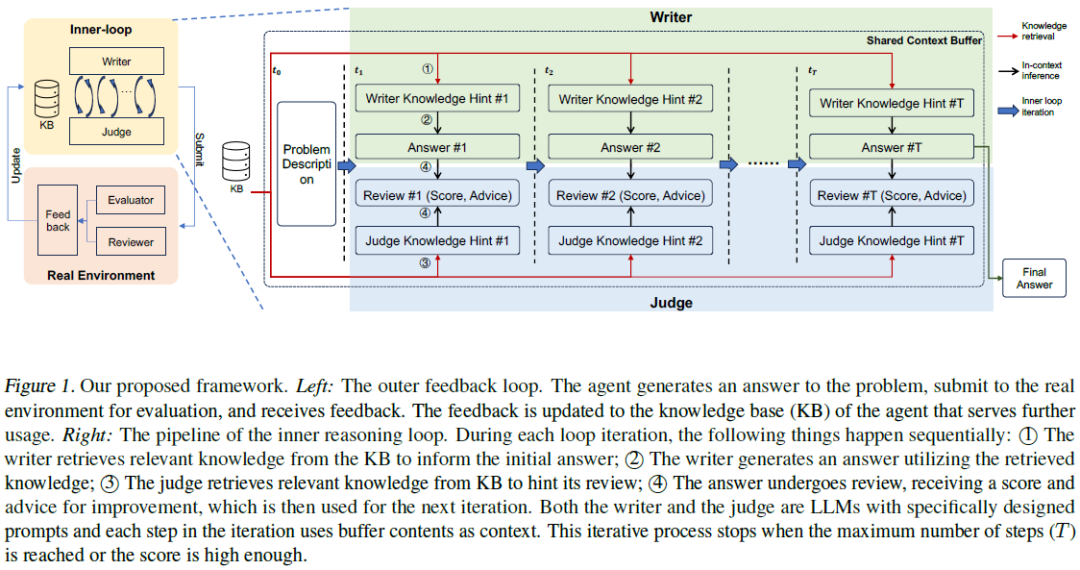

本文提出的框架采用兩層架構:外層與真實環境互動,生成的輸出經過評估并反饋至知識庫,影響后續迭代。內層為推理循環,作家與評審組件進行對話,利用內部知識庫進行推理和優化,直到產生滿意的解決方案或達到預設閾值。

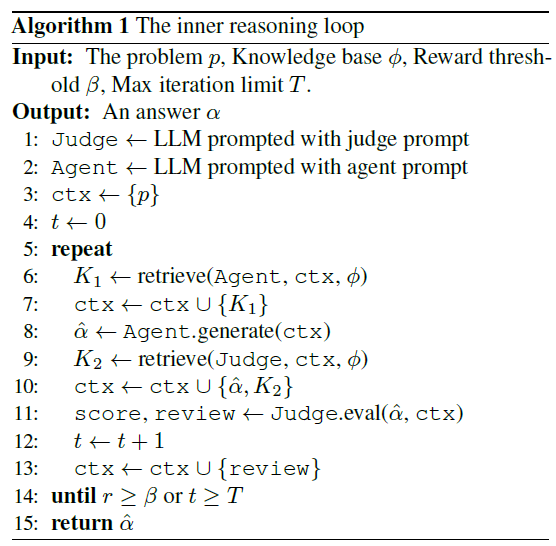

內在推理循環

內循環模擬推理環境,LLM或規則系統與知識庫互動。使用內存緩沖區,初始包含用戶查詢,逐步豐富數據。代理向知識庫提問,獲取相關信息。評估者(規則集或LLM)檢查信息是否滿足用戶查詢。循環在形成響應或滿足預設條件時結束。

組件

- 知識庫:存儲代理的輸出記錄、性能評分和反饋,通過查詢提取信息,優化性能準確性與響應多樣性。

- 上下文緩沖區:記錄互動過程中的所有交流,確保一致性和連貫性,利用過去知識指導未來回應。

- 寫作器:基于知識庫數據構建響應,逐步改進輸出,整合評估反饋以提升質量。

- 評估者:對寫作器輸出進行評分,評估效果依賴于知識庫質量,關鍵在于提高輸出準確性。

過程

單次迭代中,作者從知識庫獲取信息,形成回應。評審者對回應進行評分和反饋,反饋被納入上下文以改進下一次回應。迭代過程依賴信息積累,逐步提升回應質量,直到達到預定性能閾值或確定最佳回應。內部循環的原則是通過有效的回應生成機制,作者在多次迭代中積累足夠信息以滿足評審標準,最終產生最佳答案。

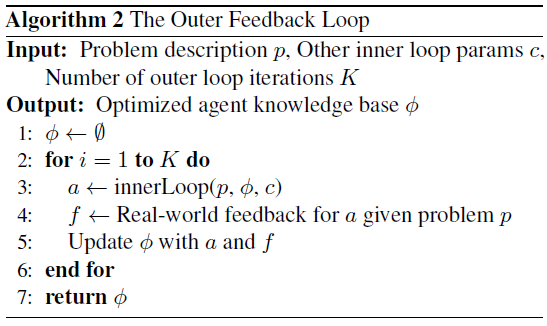

外部反饋循環

- 外循環:代理與真實環境的迭代交互,生成輸出并進行評估與改進。

- 環境反饋:提供性能評分和定性評審,注入新見解以提升決策過程。

- 知識更新:反饋后更新知識庫,進行完整性檢查,確保信息的相關性和多樣性。

- 內外循環對比:內循環評估快速且成本低,但精度較低;外循環反饋更為精準但資源消耗大。

隨著外循環迭代增加,內循環評估者積累經驗,逐步提高評估和反饋的精度。

與現有方法的比較

現有方法可視為我們框架的具體實現。去掉外循環后,自我精煉方法可視為兩個LLM作為演員和評論者的形式,可能有或沒有知識庫。若將內循環簡化為基礎的檢索增強生成過程,則可實現許多自我改進方法,如Voyager和FunSearch。

分析

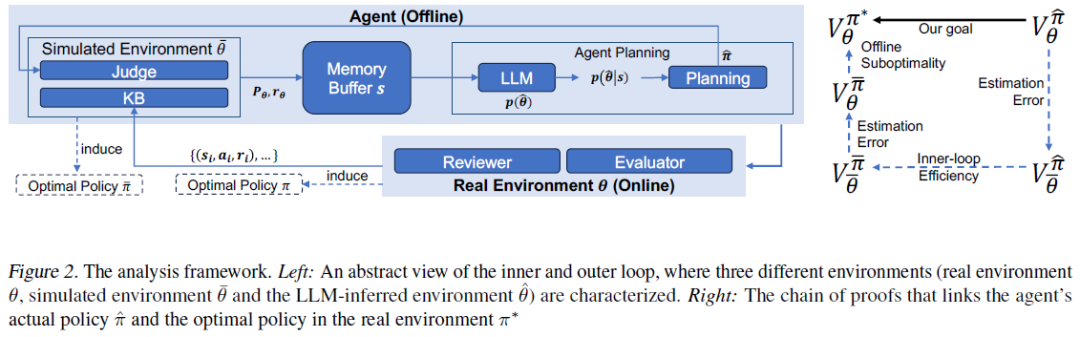

本節分析算法的效率,確保其能漸進收斂到最優解。評估成本,包括代幣成本和推理時間成本。目的是理解系統設計組件的影響,分析其在現實世界中的可部署性。

效率

代理算法的效率分為內循環和外循環兩個層面。

- 內循環效率:代理在當前知識庫下能找到最佳答案。

- 外循環效率:模擬環境中的最優策略與現實世界的性能差距隨著迭代增加而收斂。

兩者結合保證策略收斂到全局最優,證明代理算法的效率。接下來將介紹問題的具體表述。

建模

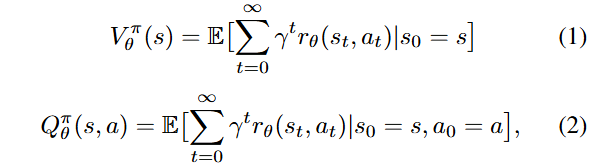

生成答案的過程被建模為馬爾可夫決策過程(MDP),由狀態空間S、動作空間A、轉移函數T、獎勵函數r和折扣因子γ組成。

- 狀態s_t包含原始問題p和共享上下文信息,初始狀態為空集,稱為信息狀態。

- 動作A與作者相關,包括生成答案和知識庫查詢,影響信息狀態。

- 轉移函數T描述在當前狀態下執行動作后信息狀態的變化,涉及知識庫響應和評審過程。

- 獎勵函數r為信息狀態分配值,可能是連續值或0/1值,表示答案的有效性。

- 折扣因子γ影響未來獎勵的權重,確保值函數V_θ^π(s)有界。

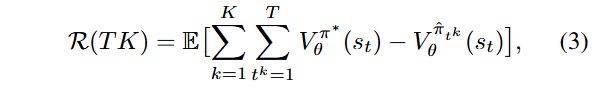

目標是學習一個策略,最大化所有狀態的值函數,以獲取足夠的信息回答用戶問題。證明代理在內外循環中高效,貝葉斯遺憾R(K)在KT中是次線性的。

內循環

假設4.1。LLM在上下文推理步驟中隱式執行環境參數θ的貝葉斯推斷,基于信息狀態s和預訓練知識p(θ)。

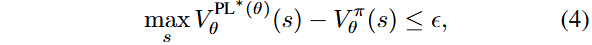

定義4.2。在參數化為θ的環境中,策略π滿足?-最優性的條件是最大值與策略π的價值差異小于6。

引理4.3。?內循環中規劃代理的貝葉斯遺憾在內循環迭代次數T上是次線性的。

證明直覺。?LLM推斷作為隱式貝葉斯推斷,隨著信息的增加,參數估計越來越準確,最終收斂到最優策略。

一次性方法缺乏效率的理論保證,因其信息不隨迭代累積,但在實踐中效果良好,表明一次性信息差距可能不大。

外循環

外部循環的效率源于悲觀假設,認為可以通過悲觀主義訓練知識庫上的最優策略。離線學習的最佳策略與在線最佳策略之間的性能差距可以通過信息差界定,前提是離線策略是通過悲觀學習獲得的。

假設4.4。在由離線知識庫表征的模擬環境中,可以通過悲觀值迭代(PEVI)獲得最優策略π ˉ。

引理4.5。在假設4.4下,π ˉ與真實環境中的最優策略π ?之間的性能差距受限于知識庫覆蓋不足引起的內在不確定性。

隨著知識庫積累更多關于真實環境的信息,模擬環境將更接近真實環境,使用悲觀方法訓練的最優策略的性能差距也會收斂。

總體結果

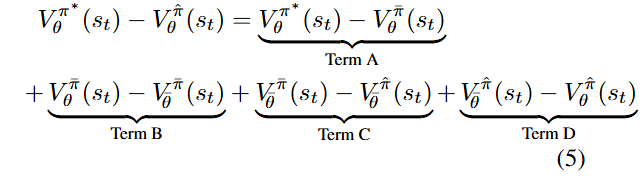

定理4.6。LLM代理在真實環境中的貝葉斯遺憾R(TK)是KT的次線性。

證明概要。性能差距可分解為多個項,具體包括V_0^*、V_0^f、v_0^π等。

假設4.4下,項A和B受離線數據集內在不確定性的限制,次線性于K(在簡單假設下)。項D受信息差距限制,次線性于K。項C根據引理4.3,次線性于T。整體左側和在公式3中求和后,次線性于KT。

成本分析

自我改進階段的內循環令牌成本為O(T2H),外循環迭代K次的累積成本為O(KT2H)。推理階段的令牌成本為O(T2H),假設生成響應的復雜度與訓練相似。外循環每次迭代的時間成本為O(T(H + Const)),K次迭代的總時間為O(KTH)。推理階段的時間復雜度降低為O(HT)。

實驗

背景

任務是金融信號挖掘,旨在從金融市場數據中計算出可用于預測的信號。設計金融信號需要市場理解、編碼能力和數學技能(如數值分析)。目標是獲得高預測能力的金融信號。希望獲得多樣化的信號,以便構建機器學習模型進行更好的預測。

問題

目標。生成反映交易理念且表現良好的金融信號。

交易理念。從分布中采樣,由另一個LLM生成。

實現。金融信號為代碼(函數),遵循預定義模板。

數據集。500只中國A股,2023年市場數據(每日收盤價和成交量)。

基礎LLM。選擇gpt-4-0125-preview版本。

評估指標

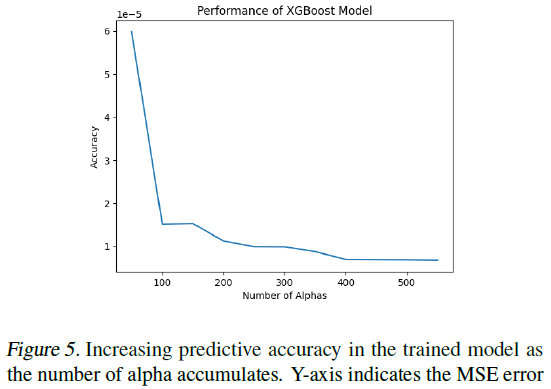

通過計算信息系數(IC)評估金融信號的預測能力,IC為皮爾遜相關系數,跨時間點平均。使用XGBoost回歸樹模型生成信號,檢驗知識庫(KB)作為信號生成基礎數據集的有效性。

分析信號的夏普比率,以評估其投資回報能力。評估信號的數值質量,包括有效和獨特實體的數量,確保信號能區分股票。通過LLM進行信號的對比評估,構建勝率矩陣,排名不同代理在信號生成中的表現,反映其對交易理念的捕捉能力。

結果

自我提升的證據

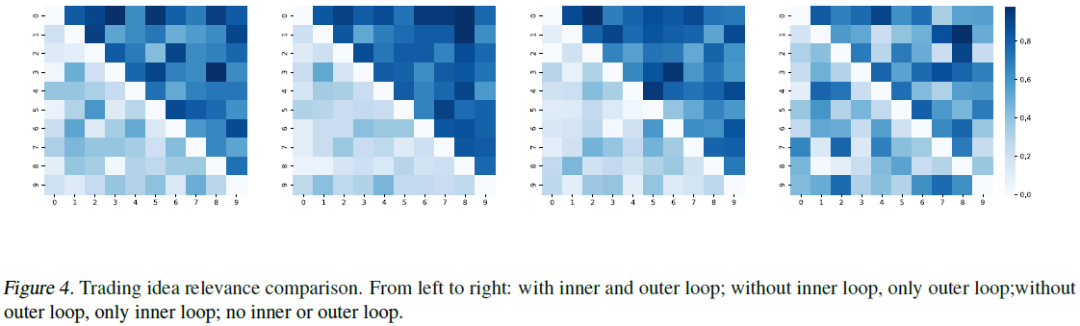

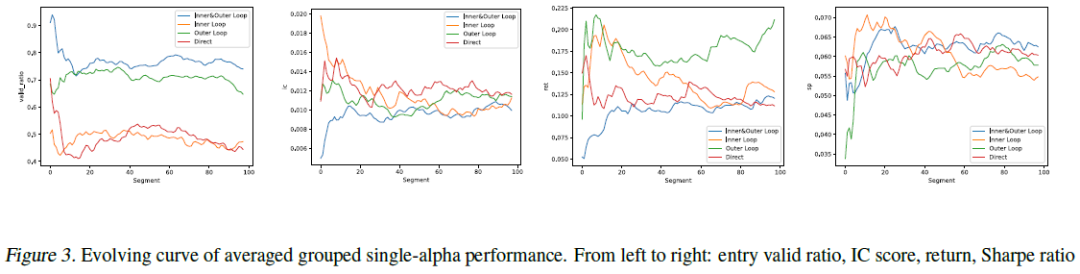

訓練累積信號和單獨段落的alpha表現出一致的性能提升,預測準確性提高。隨著模型自我改進,代理生成更強信號,增強預測能力。信號質量通過生成迭代排序和分組比較,評估其傳達交易理念的準確性。勝率分布圖顯示,模型進化過程中,代理在生成高質量信號方面技能提升。右側矩陣的遞減模式表明自我提升的有效性。

提高Alpha相關性

為了衡量信號質量,我們根據生成的迭代對整個過程中產生的信號進行分類,并根據GPT-4判斷,將它們劃分為數量相等的組,以便在準確傳達潛在交易思想方面進行比較。圖4顯示了勝率的分布。勝率累積到右上角的模式表明,隨著模型的發展,智能體在編寫高質量信號方面獲得了更好的技能,驗證了內循環和外循環的有效性。

內循環和外循環的影響

圖3展示了單一α屬性在整個過程中的演變。盡管性能差異不明顯,藍色曲線的趨勢顯示了自我改進在各項指標上的有效性。

總結

自主代理在量化投資中表現出自我改進和適應能力,展示了其在金融分析和風險管理中的潛力。這些技術可擴展至醫療和物流等復雜領域,通過定制知識庫和反饋機制。面臨的挑戰包括對知識庫質量的依賴和計算優化需求。未來將致力于提高學習效率、拓展應用場景及實時適應動態環境。LLM基礎的代理有望革新各行業的決策過程,推動智能自動化時代的到來。

本文轉載自??靈度智能??,作者:靈度智能