太慘,一個月僅23個下載!盤點2024“理想豐滿現(xiàn)實骨感”的大模型們! 原創(chuàng) 精華

整理 | 言征

出品 | 51CTO技術(shù)棧(微信號:blog51cto)

大型語言模型的競爭似乎正在結(jié)束,只有少數(shù)幾個明顯的贏家。其中,DeepSeek V3 已成為 2024 年的焦點,引領(lǐng)中國開源模型的發(fā)展。據(jù) Hugging Face 稱,DeepSeek V3 與 GPT-4 和 Claude 3.5 等閉源巨頭正面交鋒,上個月的下載量為 45,499 次,與Meta 的 Llama 3.1(491,629 次下載)和谷歌的 Gemma 2(377,651 次下載)并駕齊驅(qū)。但并非今年推出的所有 LLM 都能乘風(fēng)破浪——有些失敗了,盡管前景光明,但未能引起人們的興趣。以下是 2024 年未能取得成功的模型。

1.Databricks:DBRX

2024 年 3 月, Databricks推出了 DBRX,這是一款擁有 1320 億個參數(shù)的開源 LLM。它采用細(xì)粒度的 MoE 架構(gòu),每個輸入激活 16 位專家中的 4 位,擁有 360 億個活動參數(shù)。該公司聲稱,該模型的表現(xiàn)優(yōu)于 GPT-3.5 和 Gemini 1.5 Pro 等閉源模型。

然而,自推出以來,很少有人討論它的采用情況,或者企業(yè)是否認(rèn)為它適合構(gòu)建應(yīng)用程序。Mosaic 團隊于 2023 年被 Databricks 以 13 億美元收購,該團隊領(lǐng)導(dǎo)了其開發(fā),該公司花費 1000 萬美元打造了 DBRX。但遺憾的是,該模型上個月在 Hugging Face 上的下載量慘不忍睹,只有 23 次。

2.TII:Falcon 2

5 月,阿布扎比技術(shù)創(chuàng)新研究所 (TII) 發(fā)布了其下一代 Falcon 語言模型,包括兩個版本:Falcon-2-11B 和 Falcon-2-11B-VLM。Falcon 2 模型的基準(zhǔn)性能令人印象深刻,F(xiàn)alcon-2-11B 的表現(xiàn)優(yōu)于Meta 的 Llama 3 8B,并與Google 的 Gemma 7B 相當(dāng),這已由 Hugging Face 排行榜獨立驗證。

然而,Meta 在今年晚些時候發(fā)布了 Llama 3.2 和 Llama 3.3,將 Falcon 2 拋在身后。據(jù) Hugging Face 稱,F(xiàn)alcon-2-11B-VLM上個月的下載量僅為 1,000 次左右。

3.Snowflake:Arctic

今年 4 月,Snowflake 推出了Arctic LLM,這是一個擁有 480B 參數(shù)的模型,使用 128 位專家構(gòu)建了一個密集的 MoE 混合 Transformer 架構(gòu)。該公司自豪地表示,它只花了 200 萬美元來訓(xùn)練該模型,在 SQL 生成等任務(wù)上的表現(xiàn)優(yōu)于 DBRX。

該公司對 DBRX 的關(guān)注表明其試圖挑戰(zhàn) Databricks。同時,Snowflake 承認(rèn) Llama 3 等模型在某些基準(zhǔn)測試中表現(xiàn)優(yōu)于它。

4.Stable:LM 2

Stability AI 于去年 1 月推出了Stable LM 2 系列,包含兩個版本:Stable LM 2 1.6B 和 Stable LM 2 12B。1.6B 模型經(jīng)過 2 萬億個 token 的訓(xùn)練,支持西班牙語、德語、意大利語、法語和葡萄牙語等七種語言,在大多數(shù)任務(wù)中的表現(xiàn)都優(yōu)于微軟的 Phi-1.5 和 TinyLlama 1.1B 等模型。

5 月份推出的穩(wěn)定版 LM 2 12B 提供 120 億個參數(shù),并使用 7 種語言的 2 萬億個詞條進(jìn)行訓(xùn)練。該公司聲稱,該模型可與 Mixtral、Llama 2 和 Qwen 1.5 等大型模型相媲美,在 RAG 系統(tǒng)的工具使用方面表現(xiàn)出色。然而,最新的用戶統(tǒng)計數(shù)據(jù)卻講述了一個不同的故事,12月的下載量僅為 444 次。

5.Nemotron-4 340B

Nemotron-4-340B-Instruct是 NVIDIA 為合成數(shù)據(jù)生成和聊天應(yīng)用程序開發(fā)的 LLM。它于 2024 年 6 月發(fā)布,是 Nemotron-4 340B 系列的一部分,該系列還包括 Base 和 Reward 版本。盡管該模型功能強大,但其普及率卻很低,2024 年 12 月在 Hugging Face 上的下載量僅為 101 次左右。

6.Jamba

AI21 Labs于 2024 年 3 月推出了 Jamba,這是一款將基于 Mamba 的結(jié)構(gòu)化狀態(tài)空間模型 (SSM) 與傳統(tǒng) Transformer 層相結(jié)合的 LLM。Jamba 系列包括多個版本,例如 Jamba-v0.1、Jamba 1.5 Mini 和 Jamba 1.5 Large。

Jamba 擁有 256K 的 token 上下文窗口,能夠處理比許多競爭模型大得多的文本塊,這最初引起了人們的興奮。然而,該模型未能引起太多關(guān)注,上個月在 Hugging Face 上的下載量僅為 7K左右。

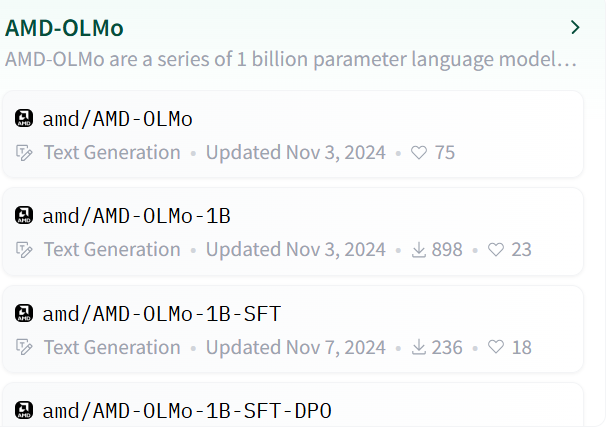

7.AMD OLMo

2024 年底,AMD 憑借其基于 Transformer 的解碼器專用語言模型 OLMo 系列進(jìn)入開源 AI 領(lǐng)域。OLMo 系列包括基礎(chǔ) OLMo 1B、OLMo 1B SFT(監(jiān)督微調(diào))和 OLMo 1B SFT DPO(通過直接偏好優(yōu)化與人類偏好保持一致)。

該模型在 16 個 AMD Instinct MI250 GPU 驅(qū)動的節(jié)點上進(jìn)行訓(xùn)練,實現(xiàn)了 12,200 個令牌/秒/gpu 的吞吐量。

旗艦?zāi)P?OLMo 1B 擁有 12 億個參數(shù)、16 個層、16 個 head、隱藏層大小為 2048、上下文長度為 2048 個 token、詞匯量為 50,280,面向開發(fā)者、數(shù)據(jù)科學(xué)家和企業(yè)。盡管如此,該模型在社區(qū)中僅收獲了1k左右的下載。

圖片

圖片

本文轉(zhuǎn)載自??51CTO技術(shù)棧??,作者:言征