什么是序列到序列(Seq2Seq)模型?以及為什么圖像理解領域主要使用的是CNN網絡而不是Transformer網絡? 原創

“ 大模型的核心點就在于特征的提取和重建,大模型技術的所有一切都是為了這個核心點服務 ”

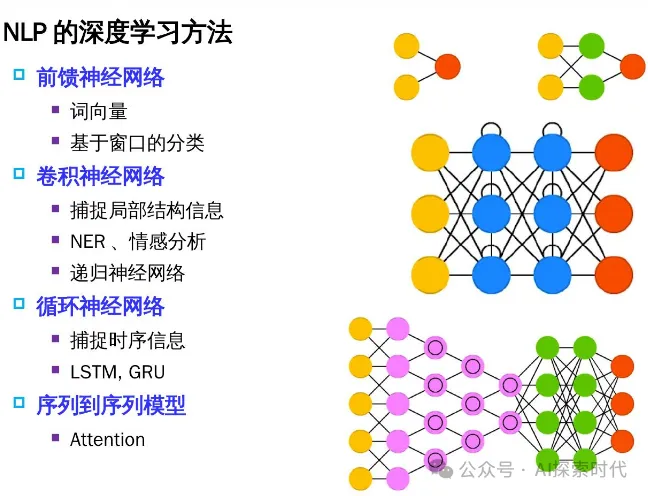

對大模型有過了解的人應該都知道Transformer架構,而且也知道這個架構在NLP(自然語言處理)領域大放異彩;但是為什么Transformer架構能在NLP領域大放異彩,以及為什么圖像理解領域使用的是CNN網絡,而不是Transformer網絡?

當然,這句話有點片面,目前基于Transformer架構在圖像處理領域也逐漸變得越來越重要。

序列到序列——Seq2Seq

先來回答一個問題,什么是序列到序列——Seq2Seq? 什么又是序列到序列模型?

就拿自然語言處理來說吧,什么是自然語言?自然語言就是隨著文化自然演化的語言,比如我們漢語,現代的漢語與古代的漢語就不完全一樣;現代漢語雖然脫胎于古漢語,但又在進化的過程中,融入了新的元素;古英語也是類似情況。

語言的主要特點是什么?

語言主要特點就是其表達方式,比如說英語是表音型語言,而漢語是表意型語言;其語言結構和特點是不一樣的。

但從語言的本質上來說,不論是表音語言或者表意語言;語言的目的是為了表達人類的思想和行為。因此,表音語言也好,表意語言也罷,最重要的是表達語義,也就是我們說話的意思、含義。

當然,這時你可能會有疑問,這個和序列到序列有什么關系?

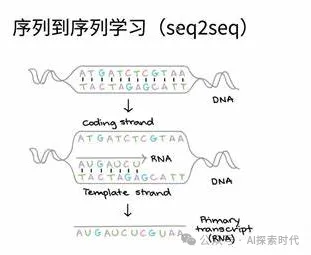

語言就是一個序列性的內容,因為它是連續的,在不同的上下文中,同一句話具有不同的含義;而在自然語言處理領域,大模型即需要去理解語言,也需要去生成新的語言(這就是之前文章中講的編碼器和解碼器的作用,編碼器通過模態提取來理解語言,通過解碼器來生成語言)。

而類似于這種具有關聯關系的內容領域,就屬于序列到序列處理;因為它需要理解一個序列,又需要生成一個新的序列。而序列到序列這個名詞的來源是因為在英文中這個叫做Sequence to Sequence,而直譯過來就成了序列到序列。

因此,序列到序列的本質是描述一種具有連續性關系的生成模型;除了自然語言處理之外,還廣泛應用于機器翻譯,語音識別,視頻處理等領域;簡單來說,凡是具有連續關系的領域,都可以使用Seq2Seq的處理方式。

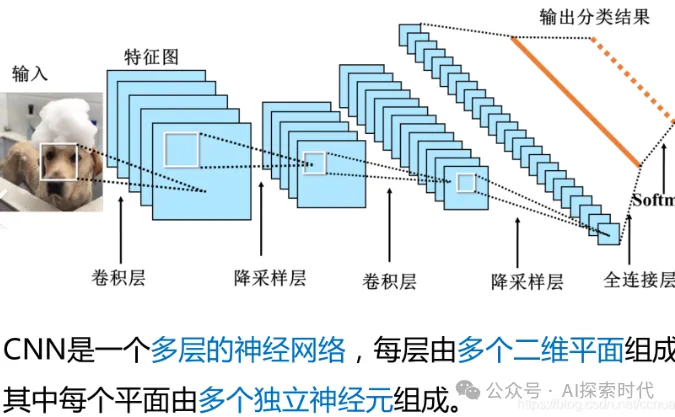

說到這里,可能很多人已經想明白了為什么在圖像處理領域使用的是CNN(卷積神經網絡),原因就在于圖像是一個不連續的過程;因為每張圖片都是一個獨立的個體,它和別的圖片沒有直接連續關系。如果圖片有了連續的關系,那么它就不再是圖片,而是變成了視頻。

當然,自然語言出來遠沒有想象中的那么簡單,即使編碼器和解碼器也是有復雜的神經網絡層構成。而且,隨著技術的發展Transformer架構也在不斷地進化,其在處理圖像這種非序列化數據時,能力也得到了巨大的增強。

為什么CNN擅長處理圖像數據?

在大模型技術中,不論什么模型最重要的兩個功能點就是特征提取和特征重建;簡單來說就是先理解(學習),再生成。

而圖像的本質就是一堆像素點,其特征提取本質上來說就是獲取這些像素點之間的關系;因此,卷積就成了圖像理解的最佳實踐方案之一,原因就在于卷積能夠很好的描述像素之間的關系;通過卷積能夠對圖像進行多重變換,以此來獲取到足夠的特征數據。

本文轉載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/kxrRIgDRekjzGMrBB9EZeQ??