52個(gè)AIGC視頻生成算法模型介紹

基于Diffusion模型的AIGC生成算法日益火熱,其中文生圖,圖生圖等圖像生成技術(shù)普遍成熟,很多算法從業(yè)者開始從事視頻生成算法的研究和開發(fā),原因是視頻生成領(lǐng)域相對(duì)空白。

一、AIGC視頻算法發(fā)展現(xiàn)狀

從2023年開始,AIGC+視頻的新算法層出不窮,其中最直接的是把圖像方面的成果引入視頻領(lǐng)域,并結(jié)合時(shí)序信息去生成具有連續(xù)性的視頻。隨著Sora的出現(xiàn),視頻生成的效果又再次上升了一個(gè)臺(tái)階,因此有必要將去年一年到現(xiàn)在的視頻領(lǐng)域進(jìn)展梳理一下,為以后的視頻方向的研究提供一點(diǎn)思路。

二、AIGC視頻算法分類

AIGC視頻算法,經(jīng)過梳理發(fā)現(xiàn),可以大體分為:文生視頻,圖生視頻,視頻編輯,視頻風(fēng)格化,人物動(dòng)態(tài)化,長(zhǎng)視頻生成等方向。具體的輸入和輸出形式如下:

- 文生視頻:輸入文本,輸出視頻

- 圖生視頻:輸入圖片(+控制條件),輸出視頻

- 視頻編輯:輸入視頻(+控制條件),輸出視頻

- 視頻風(fēng)格化:輸入視頻,輸出視頻

- 人物動(dòng)態(tài)化:輸入圖片+姿態(tài)條件,輸出視頻

- 長(zhǎng)視頻生成:輸入文本,輸出長(zhǎng)視頻

三、具體算法梳理

文生視頻

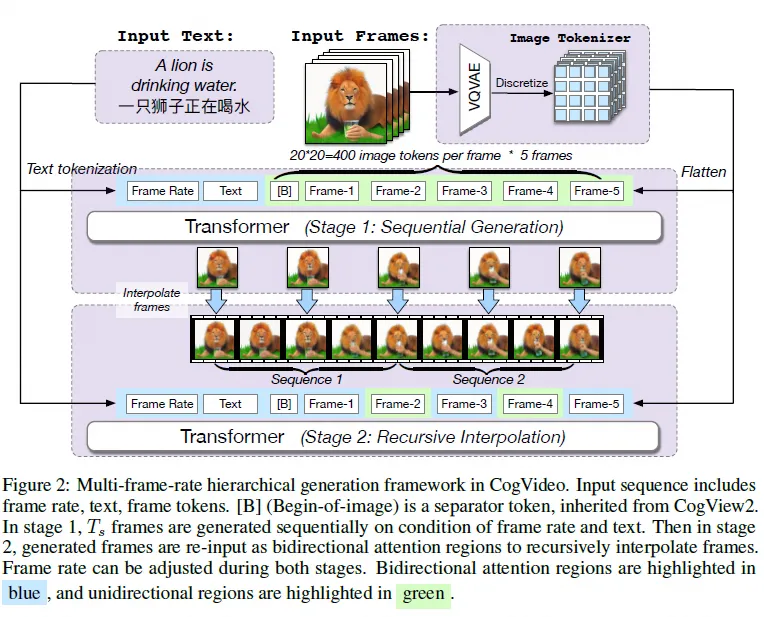

CogVideo: Large-scale Pretraining for Text-to-Video Generation via Transformers

機(jī)構(gòu):清華

時(shí)間:2022.5.29

???https://github.com/THUDM/CogVideo.??

簡(jiǎn)單介紹:基于兩階段的transformer(生成+幀間插值)來做文生視頻

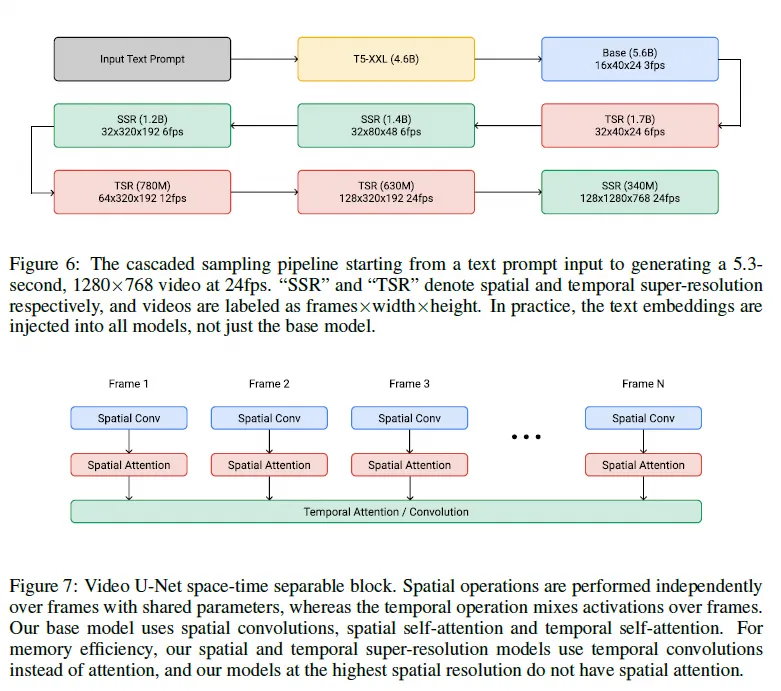

IMAGEN VIDEO

機(jī)構(gòu):Google

時(shí)間:2022.10.5

簡(jiǎn)單介紹:基于google的Imagen來做的時(shí)序擴(kuò)展,而Imagen和Imagen video都沒有開源

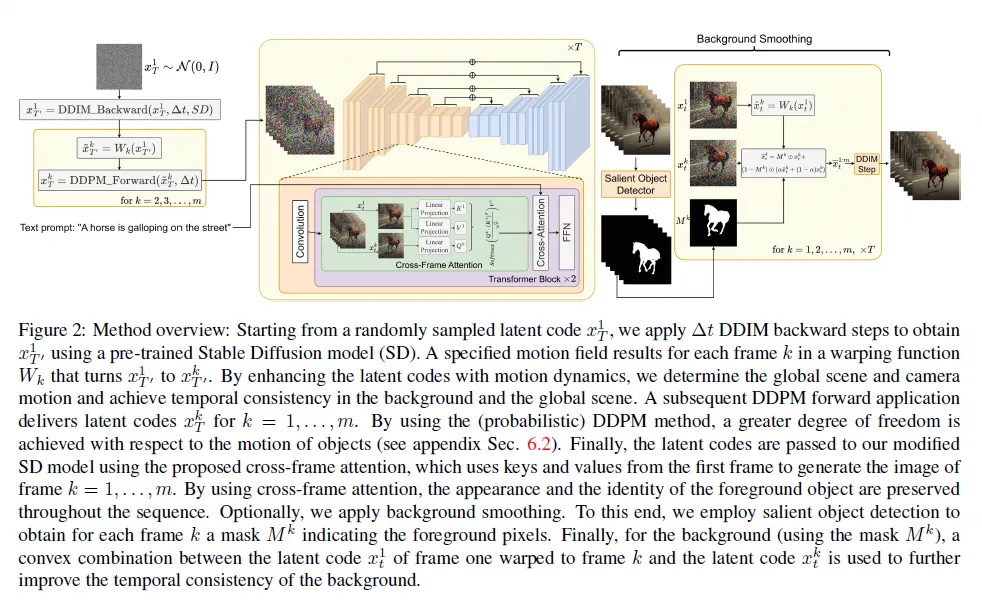

Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators

機(jī)構(gòu):Picsart AI Resarch

時(shí)間:2023.3.23

???https://github.com/Picsart-AI-Research/Text2Video-Zero???

簡(jiǎn)單介紹:基于圖像diffusion model引入corss-frame attention來做時(shí)序建模,其次通過顯著性檢測(cè)來實(shí)現(xiàn)背景平滑。

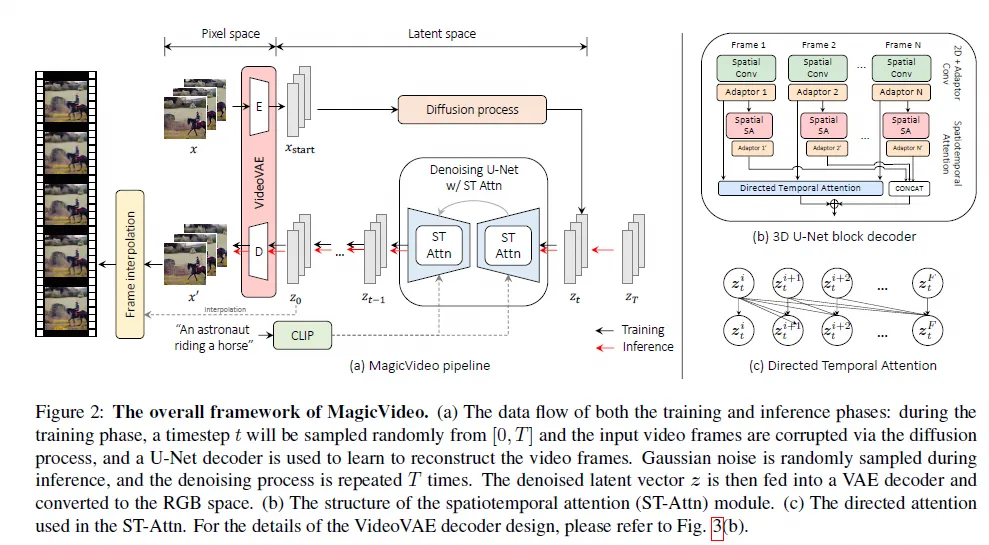

MagicVideo: Efficient Video GenerationWith Latent Diffusion Models

機(jī)構(gòu):字節(jié)

時(shí)間:2023.5.11

簡(jiǎn)單介紹:直接將圖像SD架構(gòu)擴(kuò)展成視頻,增加了時(shí)序信息

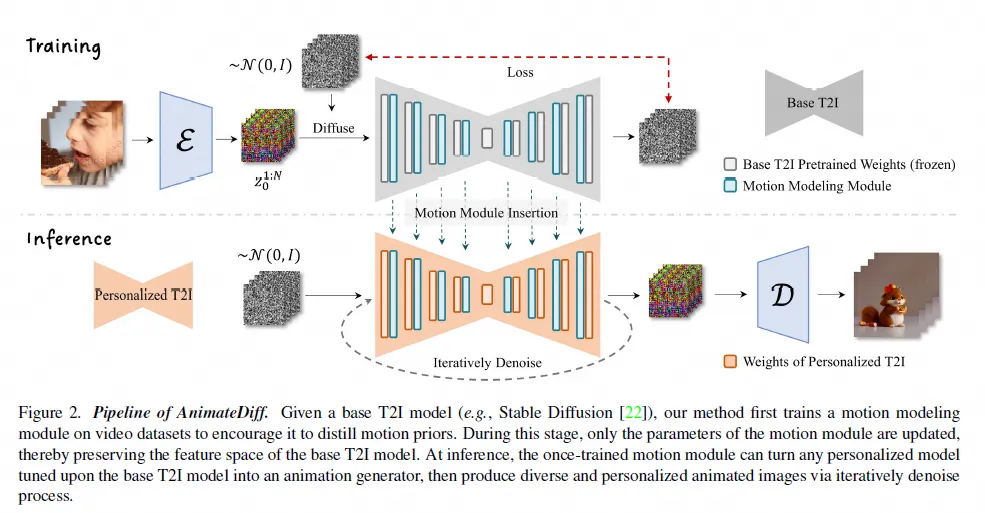

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning

機(jī)構(gòu):上海 AI Lab

時(shí)間:2023.7.11

???https://animatediff.github.io/???

簡(jiǎn)單介紹:基于圖像diffusion model,訓(xùn)練一個(gè)運(yùn)動(dòng)建模模塊,來學(xué)習(xí)運(yùn)動(dòng)信息

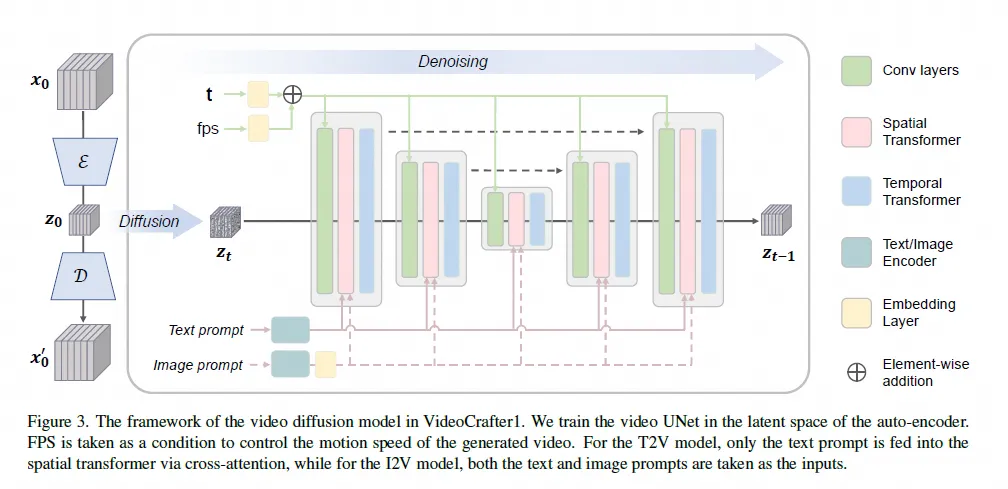

VideoCrafter1: Open Diffusion Models for High-Quality Video Generation

機(jī)構(gòu):騰訊 AI Lab

時(shí)間:2023.10.30

???https://ailab-cvc.github.io/videocrafter???

簡(jiǎn)單介紹:基于diffusion模型,網(wǎng)絡(luò)架構(gòu)采用空間和時(shí)序attention操作來實(shí)現(xiàn)視頻生成

圖生視頻

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning

機(jī)構(gòu):上海 AI Lab

時(shí)間:2023.7.11

???https://animatediff.github.io/??

VideoCrafter1: Open Diffusion Models for High-Quality Video Generation

機(jī)構(gòu):騰訊 AI Lab

時(shí)間:2023.10.30

???https://ailab-cvc.github.io/videocrafter??

stable video diffusion

機(jī)構(gòu):Stability AI

時(shí)間:2023.11.21

???https://stability.ai/news/stable-video-diffusion-open-ai-video-model???

簡(jiǎn)單介紹:基于SD2.1增加時(shí)序?qū)樱瑏磉M(jìn)行視頻生成

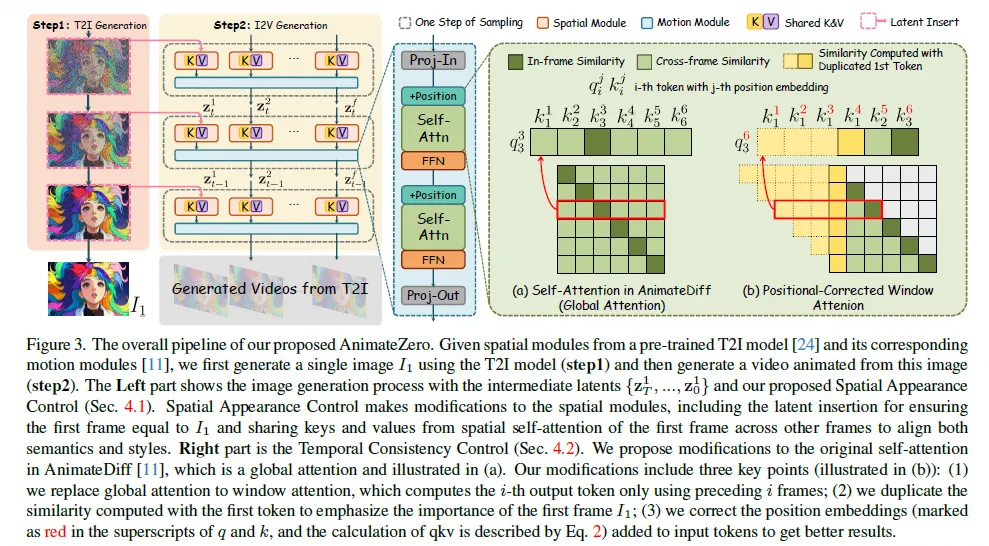

AnimateZero: Video Diffusion Models are Zero-Shot Image Animators

機(jī)構(gòu):騰訊 AI Lab

時(shí)間:2023.12.6

???https://github.com/vvictoryuki/AnimateZero(未開源)??

簡(jiǎn)單介紹:基于Animate Diff增加了位置相關(guān)的attention

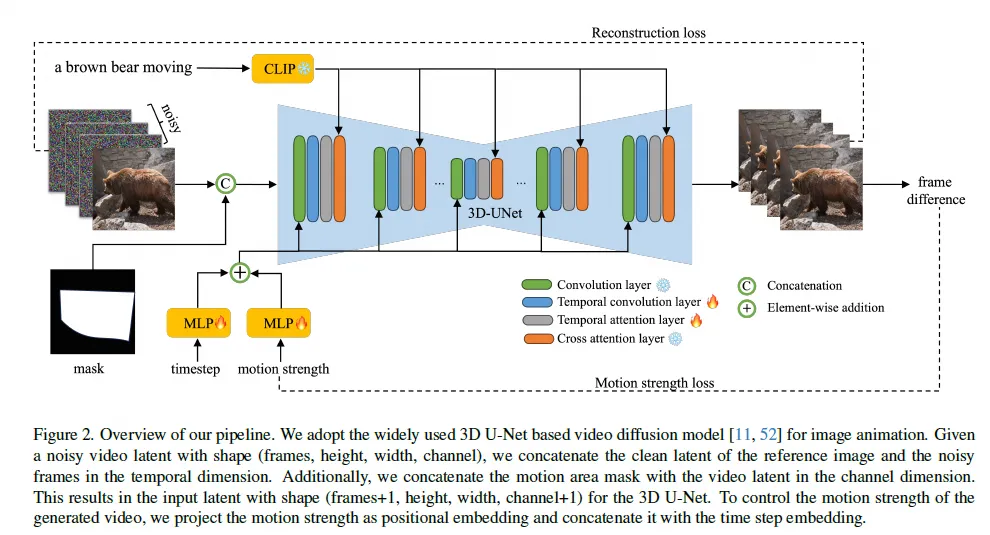

AnimateAnything: Fine-Grained Open Domain Image Animation with Motion Guidance

機(jī)構(gòu):阿里

時(shí)間:2023.12.4

???https://animationai.github.io/AnimateAnything/???

簡(jiǎn)單介紹:可以針對(duì)特定位置進(jìn)行動(dòng)態(tài)化,通過學(xué)習(xí)運(yùn)動(dòng)信息實(shí)現(xiàn)時(shí)序信息生成

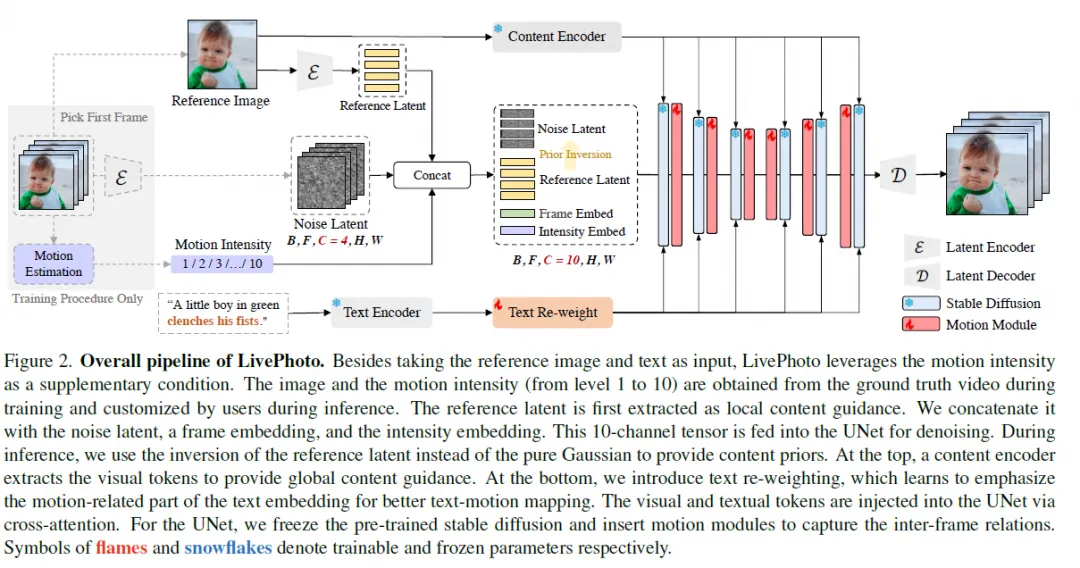

LivePhoto: Real Image Animation with Text-guided Motion Control

機(jī)構(gòu):阿里

時(shí)間:2023.12.5

???https://xavierchen34.github.io/LivePhoto-Page/(未開源)??

簡(jiǎn)單介紹:將參考圖,運(yùn)動(dòng)信息拼接作為輸入,來進(jìn)行圖像的動(dòng)態(tài)化

視頻風(fēng)格化

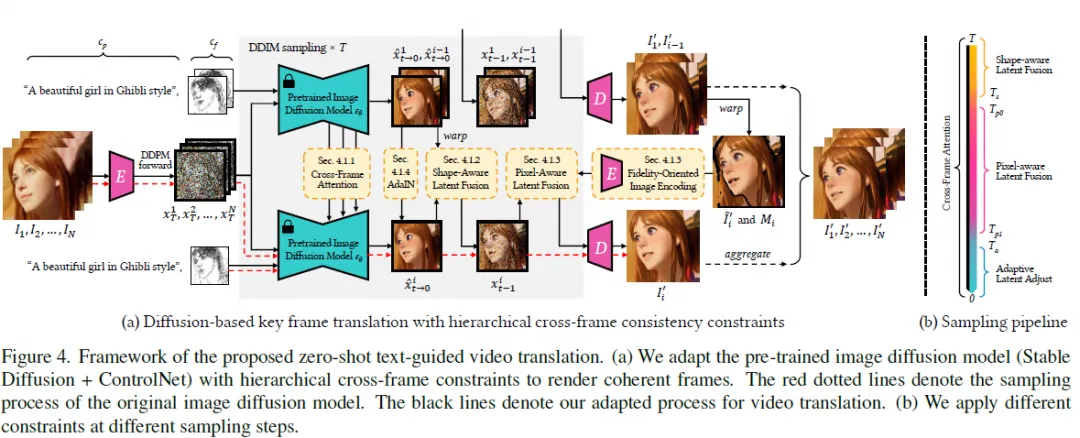

Rerender A Video: Zero-Shot Text-Guided Video-to-Video Translation

機(jī)構(gòu):南洋理工

時(shí)間:2023.12.17

??https://www.mmlab-ntu.com/project/rerender/???

簡(jiǎn)單介紹:基于SD+controlnet,結(jié)合cros-frame attention來風(fēng)格化視頻序列

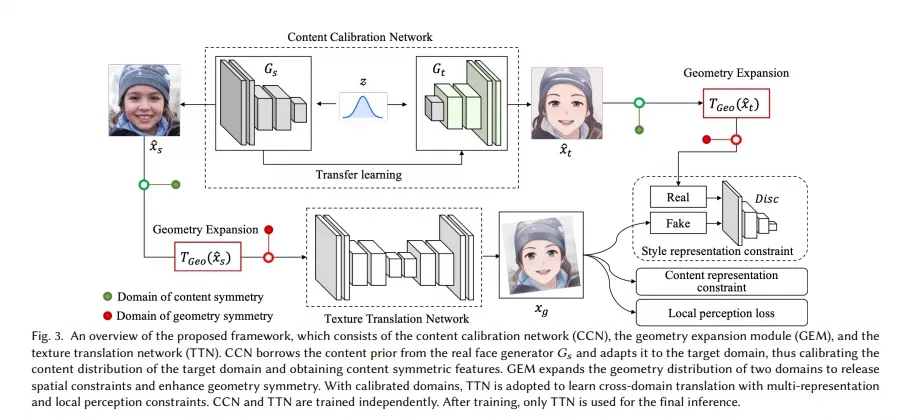

DCTNet

機(jī)構(gòu):阿里達(dá)摩院

時(shí)間:2022.7.6

???https://github.com/menyifang/DCT-Net/???

簡(jiǎn)單介紹:基于GAN的框架做的視頻風(fēng)格化,目前支持7種不同的風(fēng)格

視頻編輯

主要是將深度圖或者其他條件圖(canny/hed),通過網(wǎng)絡(luò)注入Diffusion model中,控制整體場(chǎng)景生成,并通過prompt設(shè)計(jì)來控制主體目標(biāo)的外觀。其中controlnet被遷移進(jìn)入視頻編輯領(lǐng)域,出現(xiàn)了一系列controlnetvideo的工作。

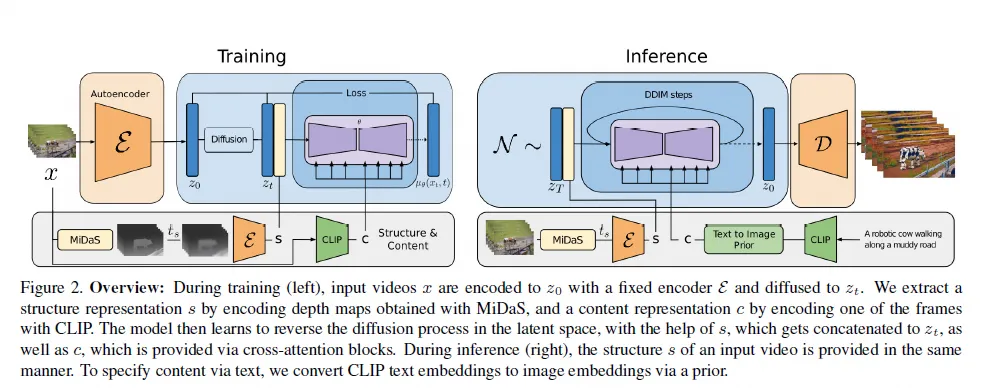

Structure and Content-Guided Video Synthesis with Diffusion Models

機(jī)構(gòu):Runway

時(shí)間:2023.2.6

???https://research.runwayml.com/gen1??

Animate diff+ControlNet(基于WebUI API)

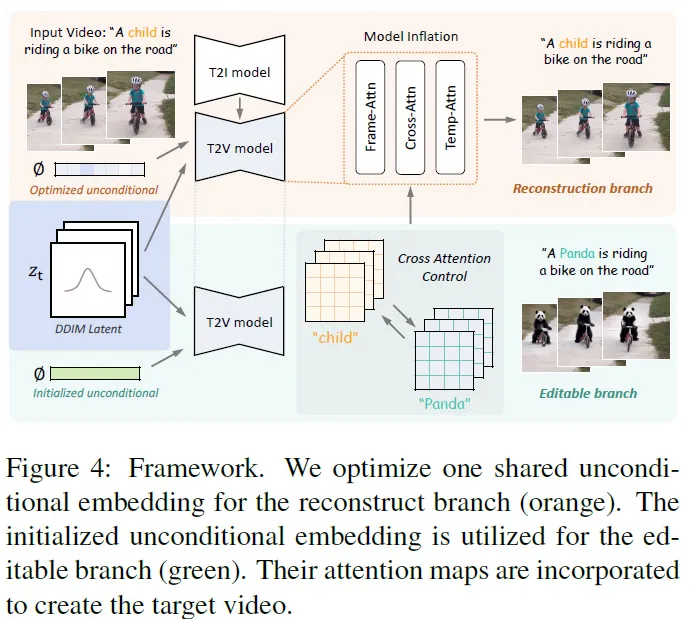

Video-P2P: Video Editing with Cross-attention Control

機(jī)構(gòu):港中文,adobe

時(shí)間:2023.3.8

???https://video-p2p.github.io/??

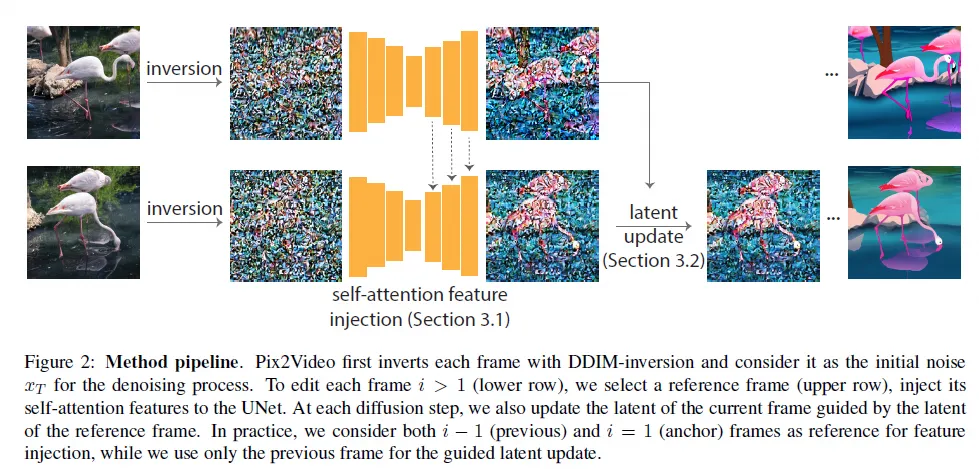

Pix2Video: Video Editing using Image Diffusion

機(jī)構(gòu):Abode

時(shí)間:2023.3.22

???https://duyguceylan.github.io/pix2video.github.io/??

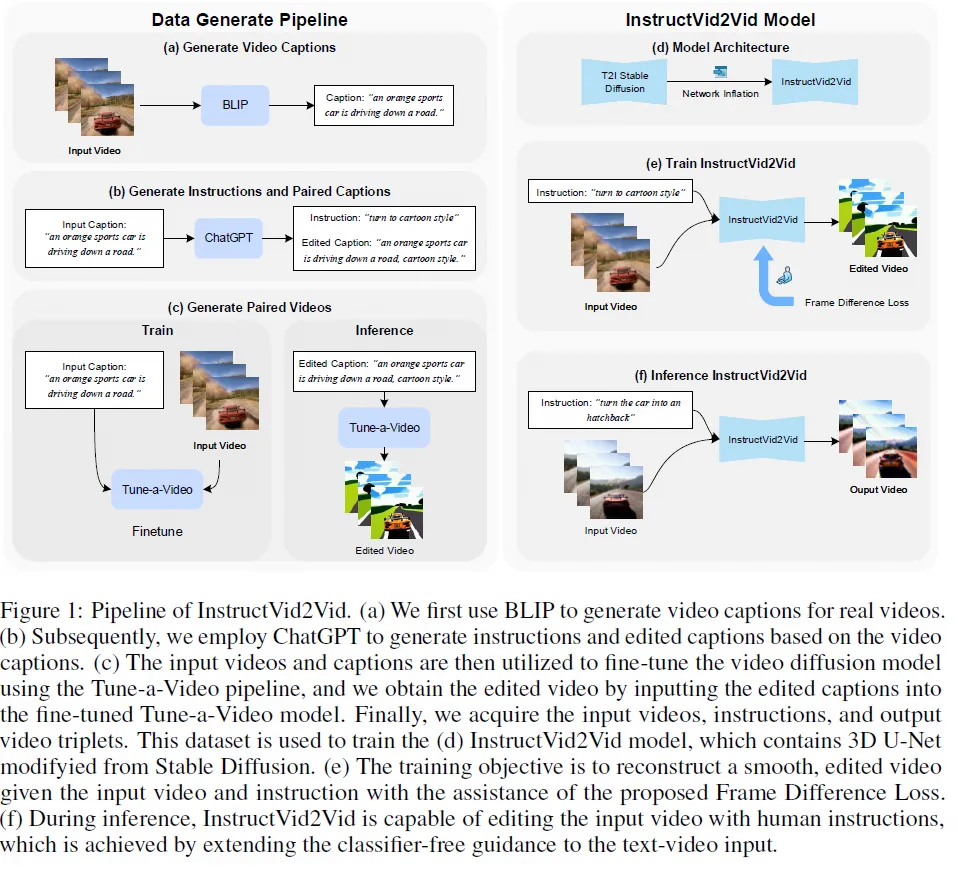

InstructVid2Vid: Controllable Video Editing with Natural Language Instructions

機(jī)構(gòu):浙大

時(shí)間:2023.5.21

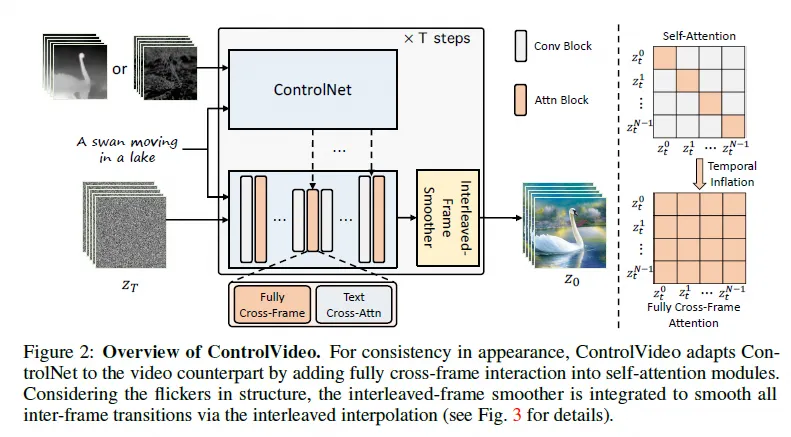

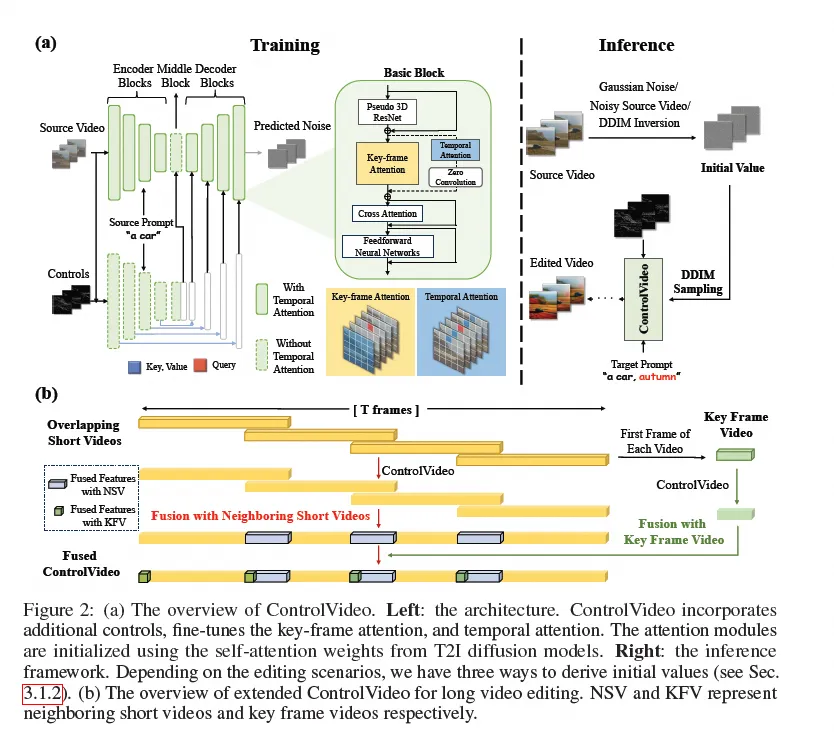

ControlVideo: Training-free Controllable Text-to-Video Generation

機(jī)構(gòu):華為

時(shí)間:2023.5.22

???https://github.com/YBYBZhang/ControlVideo??

ControlVideo: Conditional Control for One-shot Text-driven Video Editing and Beyond

機(jī)構(gòu):清華

時(shí)間:2023.11.28

???https://github.com/thu-ml/controlvideo??

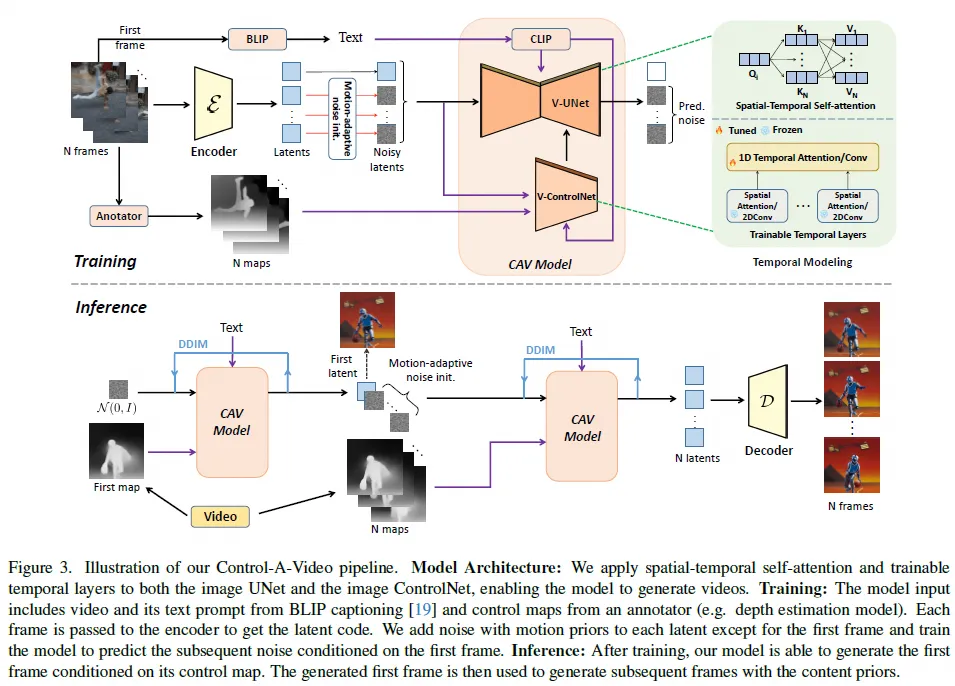

Control-A-Video: Controllable Text-to-Video Generation with Diffusion Models

時(shí)間:2023.12.6

???https://controlavideo.github.io/??

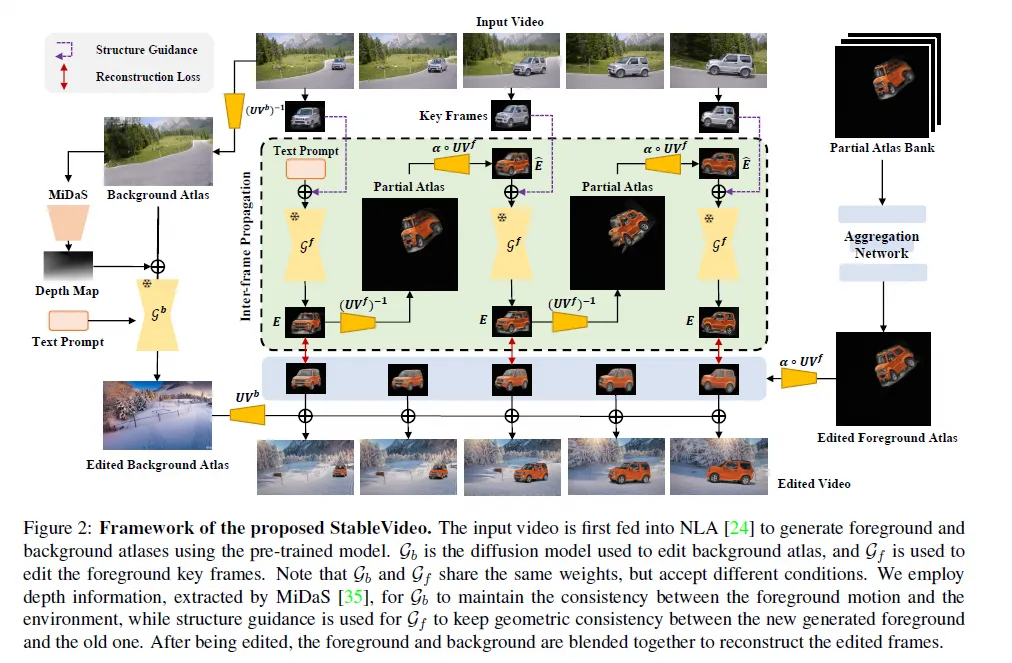

StableVideo: Text-driven Consistency-aware Diffusion Video Editing

機(jī)構(gòu):MSRA

時(shí)間:2023.8.18

???https://github.com/rese1f/StableVideo??

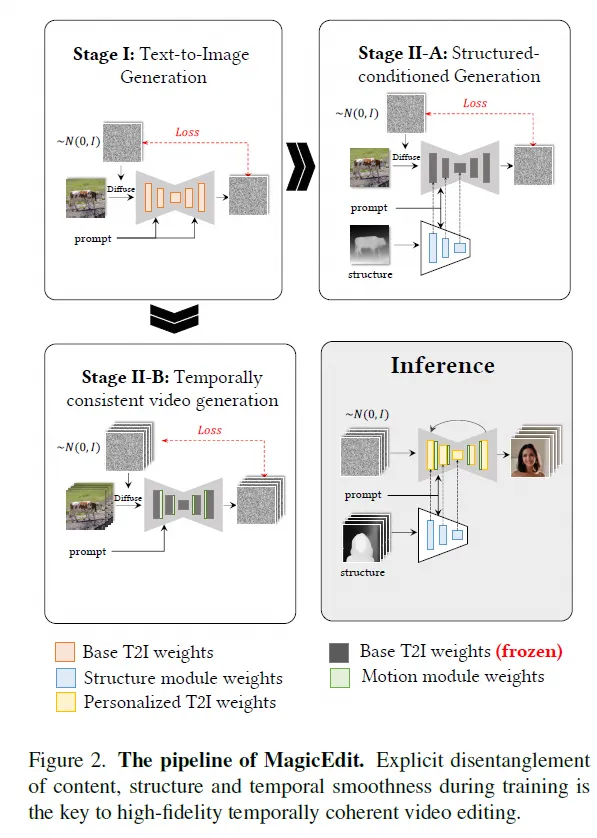

MagicEdit: High-Fidelity and Temporally Coherent Video Editing

機(jī)構(gòu):字節(jié)

時(shí)間:2023.8.28

???https://magic-edit.github.io/(未開源)??

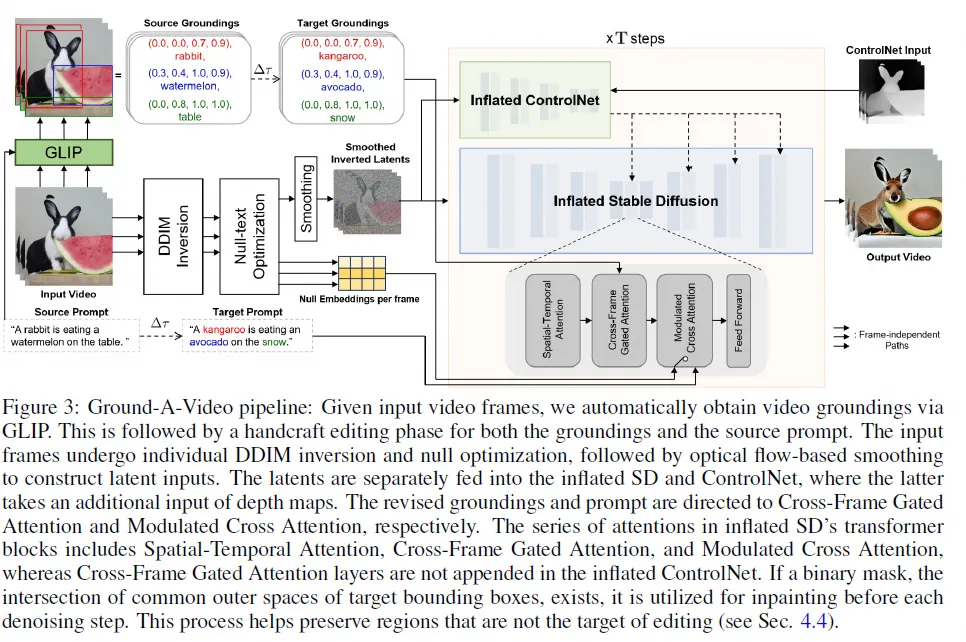

GROUND-A-VIDEO: ZERO-SHOT GROUNDED VIDEO EDITING USING TEXT-TO-IMAGE DIFFUSION MODELS

機(jī)構(gòu):KAIST

時(shí)間:2023.10.2

???https://ground-a-video.github.io/??

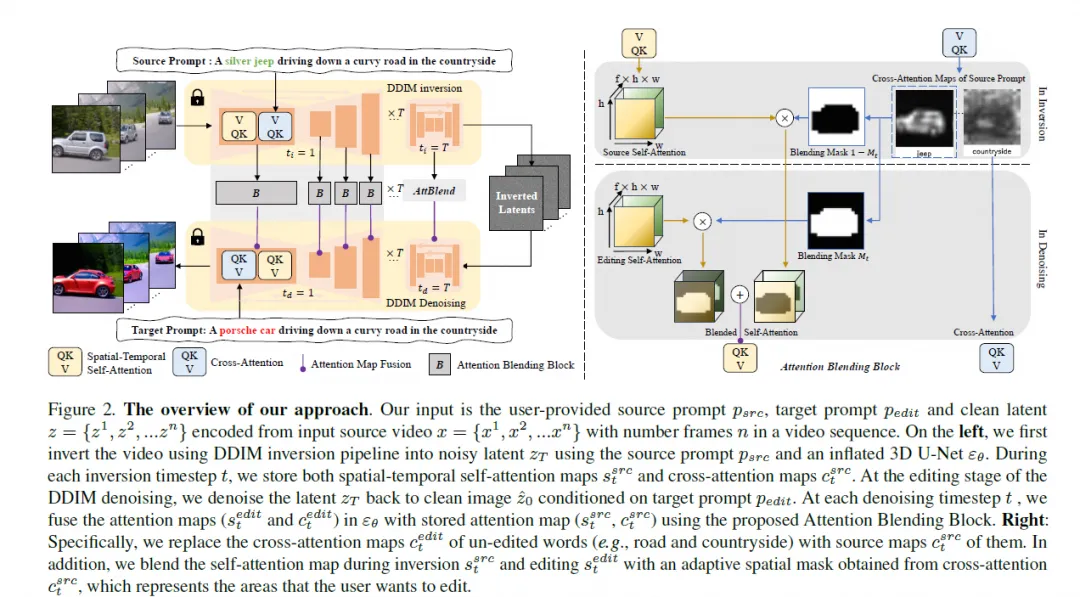

FateZero: Fusing Attentions for Zero-shot Text-based Video Editing

機(jī)構(gòu):騰訊AI Lab

時(shí)間:2023.10.11

???https://fate-zero-edit.github.io??

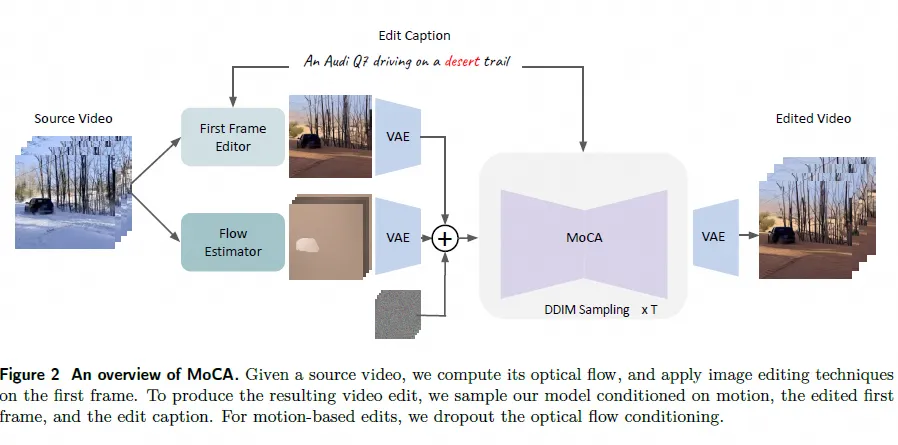

Motion-Conditioned Image Animation for Video Editing

機(jī)構(gòu):Meta

時(shí)間:2023.11.30

facebookresearch.github.io/MoCA(未開源)

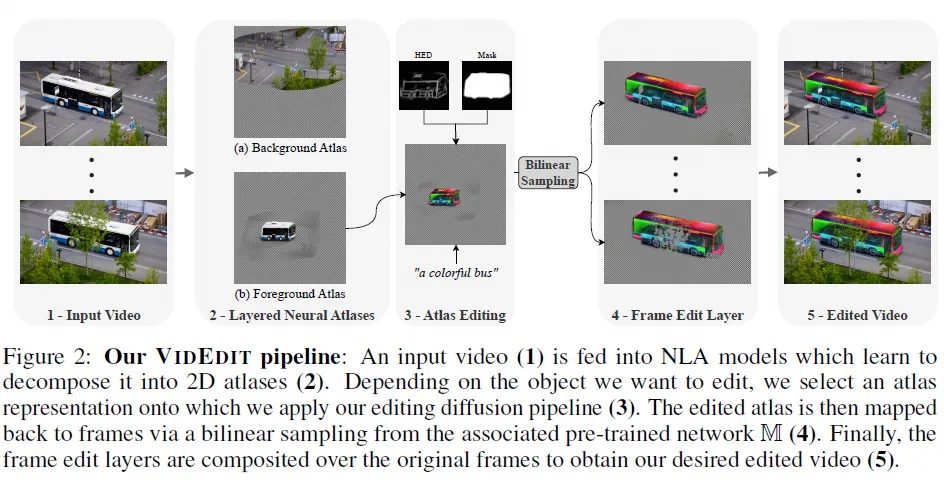

VidEdit: Zero-shot and Spatially Aware Text-driven Video Editing

機(jī)構(gòu):Sorbonne Université, Paris, France

時(shí)間:2023.12.15

???https://videdit.github.io??

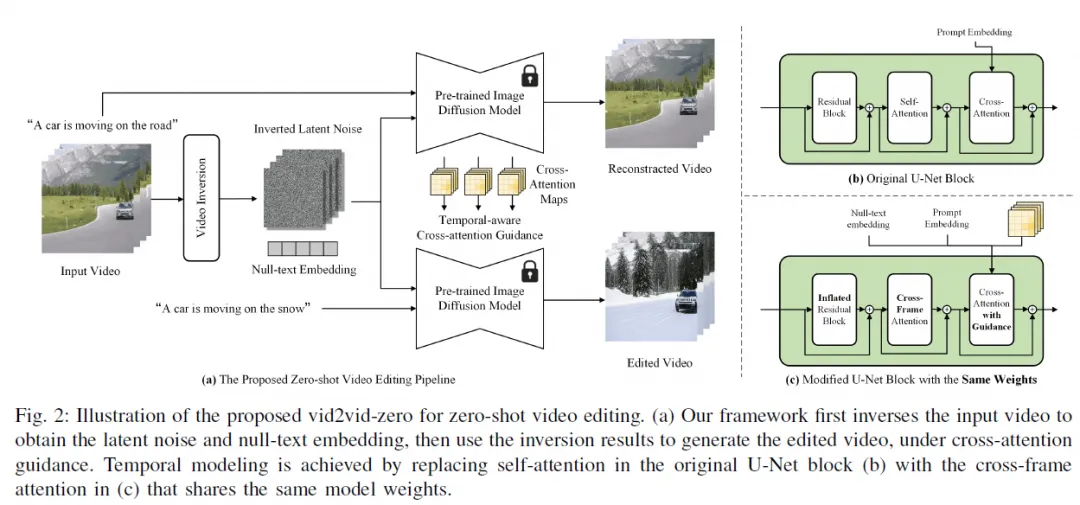

Zero-Shot Video Editing Using Off-The-Shelf Image Diffusion Models

時(shí)間:2024.1.4

???https://github.com/baaivision/vid2vid-zero??

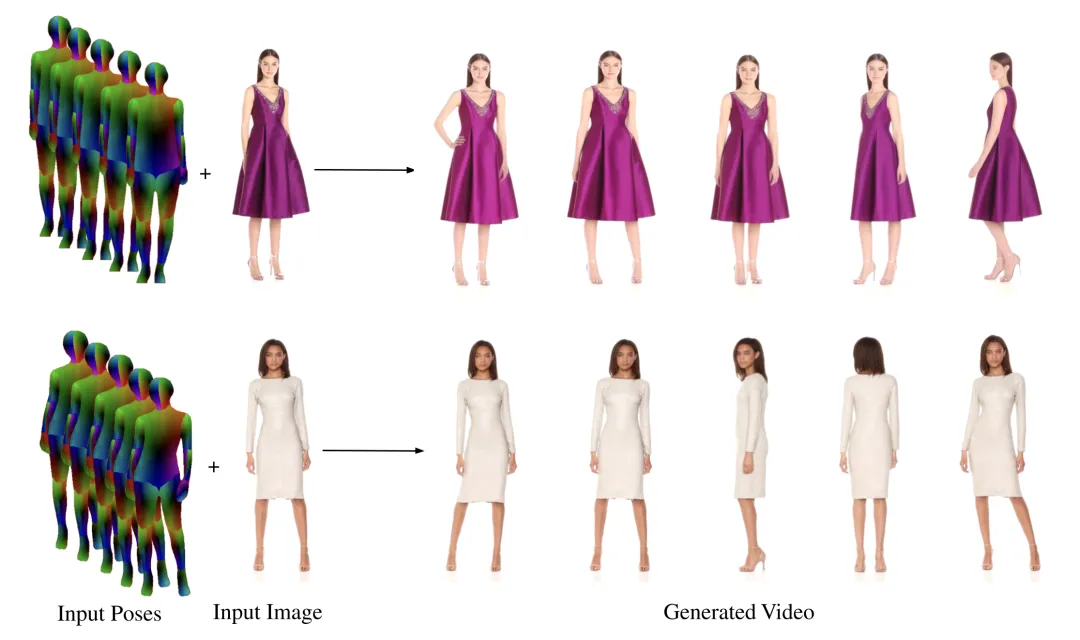

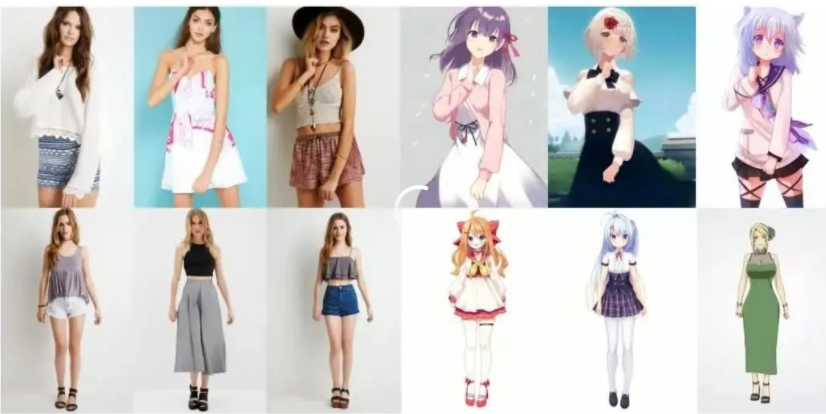

人物動(dòng)態(tài)化

主要是通過人體姿態(tài)作為條件性輸入(結(jié)合controlnet等),將一張圖作為前置參考圖,或者直接使用文本描述生成圖片。其中阿里和字節(jié)分別有幾篇代表性論文,其中字節(jié)的代碼有兩篇已經(jīng)開源,阿里的代碼還在等待階段。

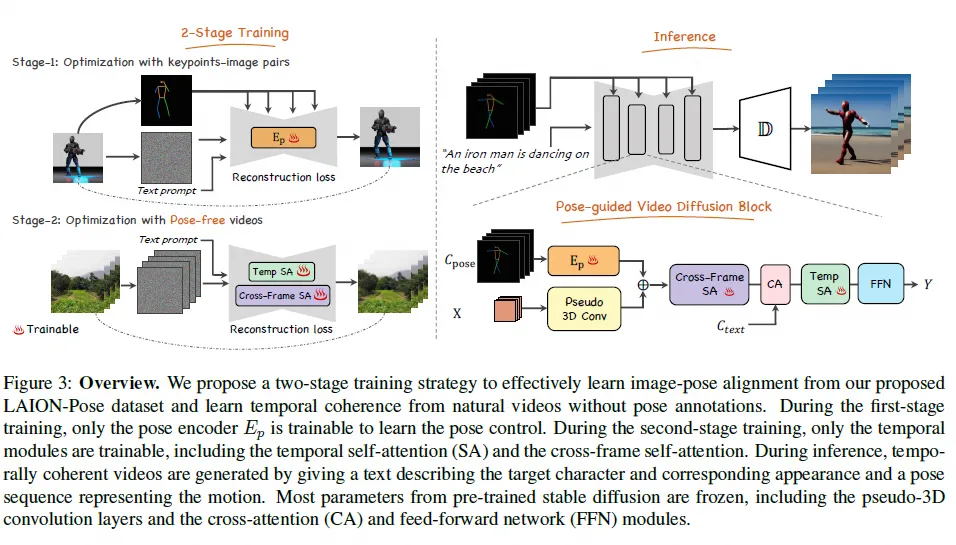

- Follow Your Pose

機(jī)構(gòu):騰訊AI Lab

時(shí)間:2023.4.3

???https://follow-your-pose.github.io/??

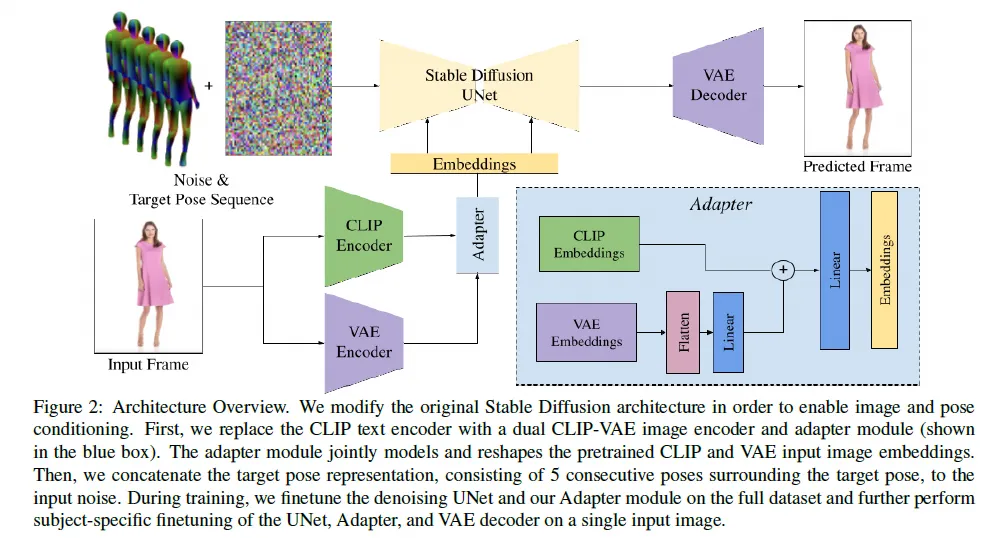

DreamPose: Fashion Image-to-Video Synthesis via Stable Diffusion

機(jī)構(gòu):google,nvidia

時(shí)間:2023.5.4

???https://grail.cs.washington.edu/projects/dreampose/??

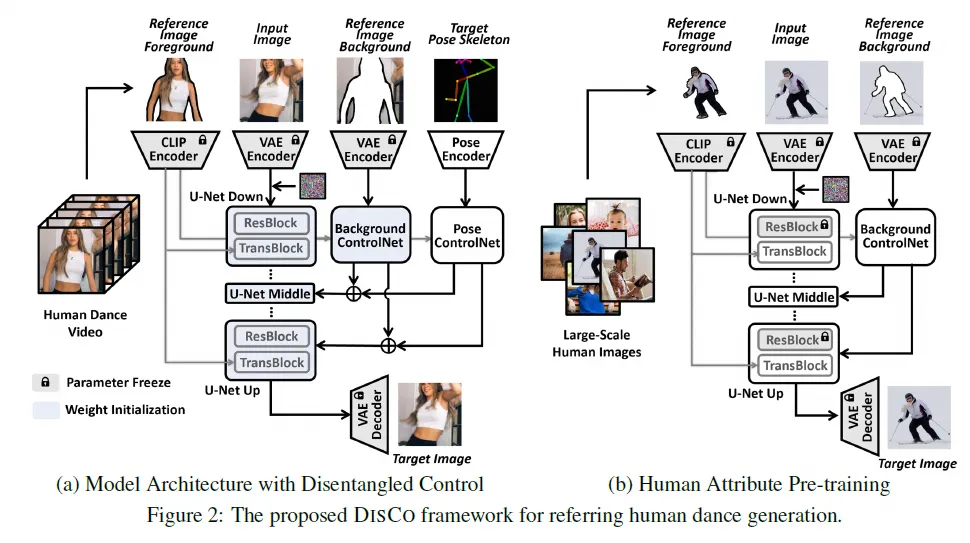

DISCO: Disentangled Control for Realistic Human Dance Generation

機(jī)構(gòu):微軟

時(shí)間:2023.10.11

???https://disco-dance.github.io??

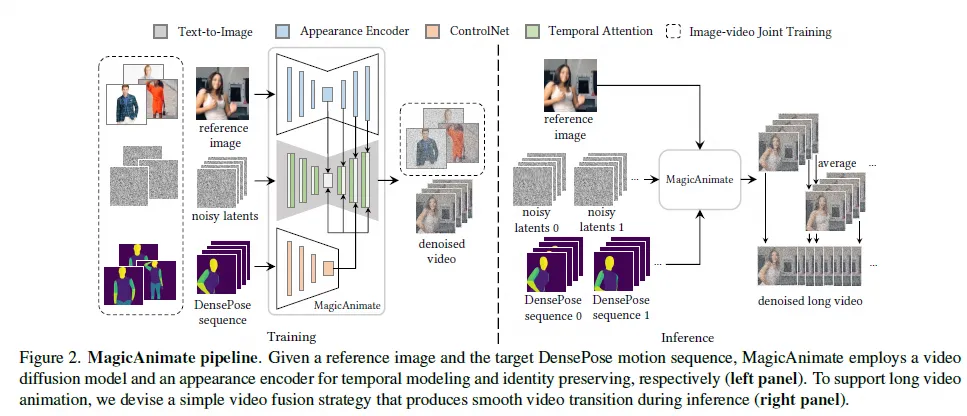

MagicAnimate: Temporally Consistent Human Image Animation using Diffusion Model

機(jī)構(gòu):字節(jié)

時(shí)間:2023.11.27

???https://showlab.github.io/magicanimate/??

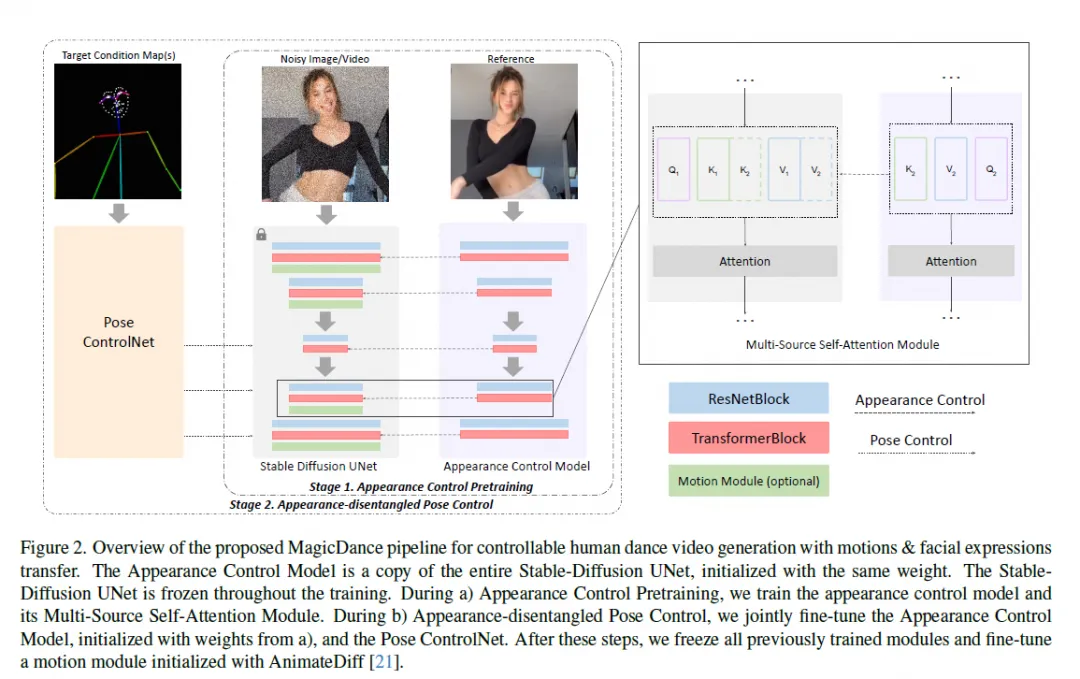

MaigcDance

機(jī)構(gòu):字節(jié)

時(shí)間:2023.11.18

???https://boese0601.github.io/magicdance/??

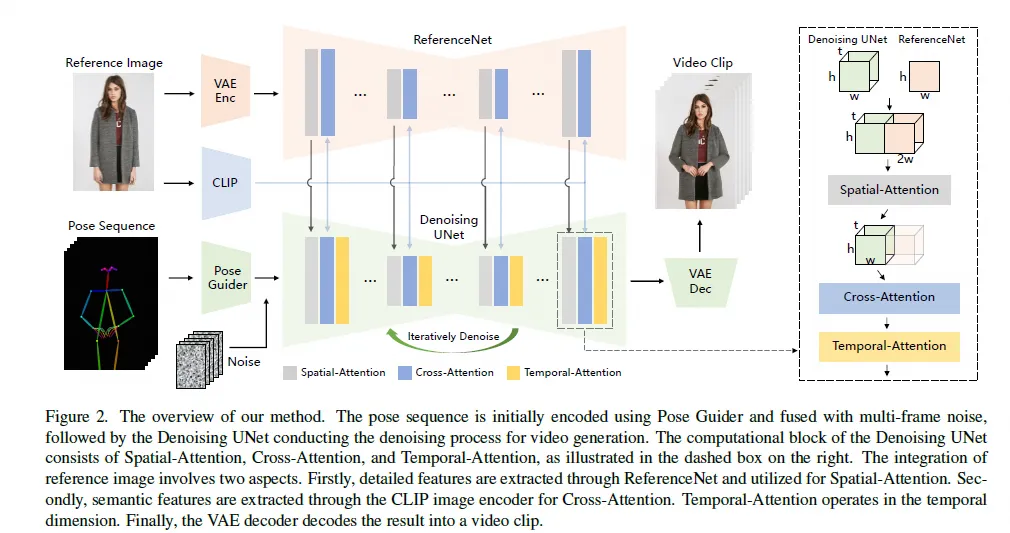

Animate Anyone: Consistent and Controllable Image-to-Video Synthesis for Character Animation

機(jī)構(gòu):阿里

時(shí)間:2023.12.7

???https://humanaigc.github.io/animate-anyone/(未開源)??

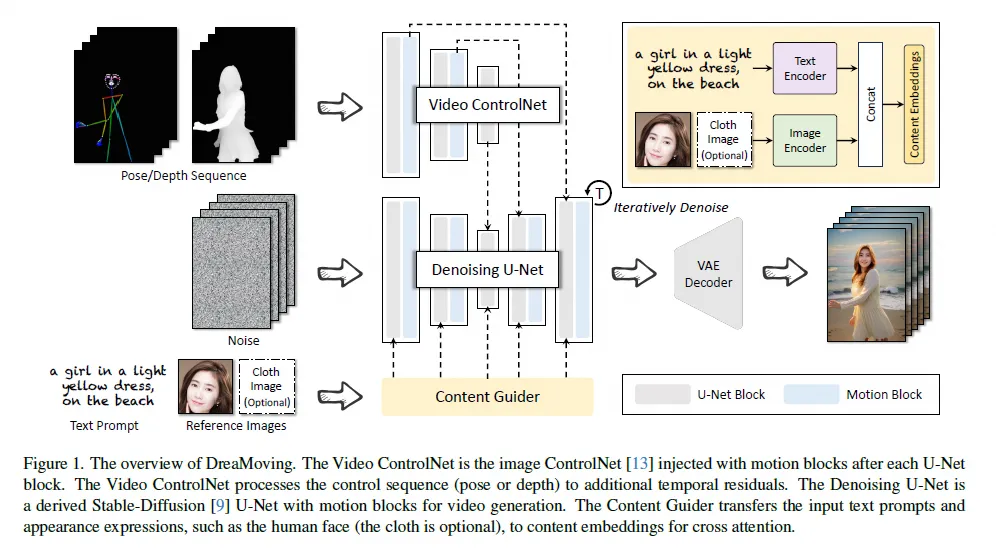

DreaMoving: A Human Video Generation Framework based on Diffusion Model

機(jī)構(gòu):阿里

時(shí)間:2023.12.11

???https://dreamoving.github.io/dreamoving(未開源)??

長(zhǎng)視頻生成

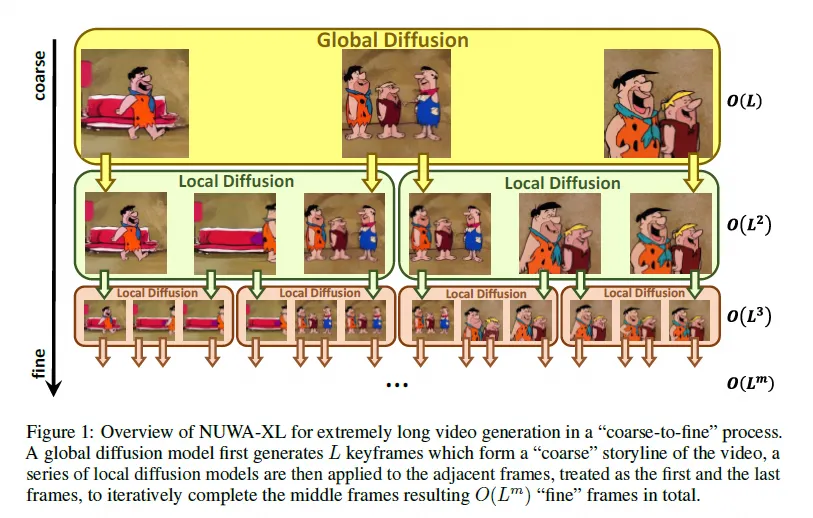

NUWA-XL: Diffusion over Diffusion for eXtremely Long Video Generation

機(jī)構(gòu):微軟亞研院

時(shí)間:2023.3.22

???https://msra-nuwa.azurewebsites.net/??

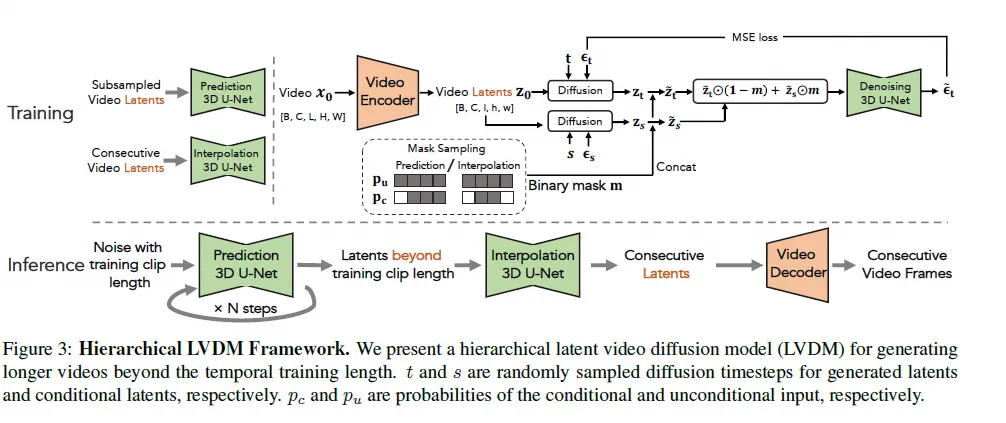

Latent Video Diffusion Models for High-Fidelity Long Video Generation

機(jī)構(gòu):騰訊AI Lab

時(shí)間:2023.3.20

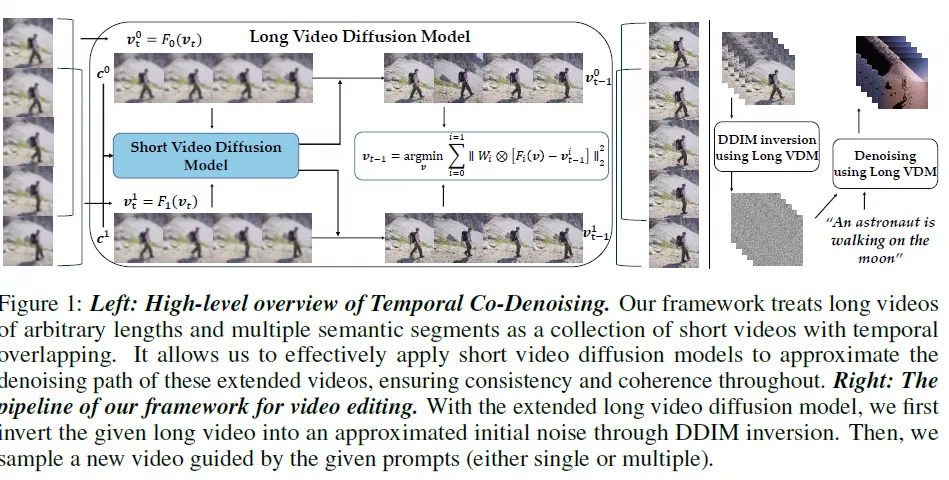

Gen-L-Video: Multi-Text to Long Video Generation via Temporal Co-Denoising

機(jī)構(gòu):上海AI Lab

時(shí)間:2023.3.29

??https://github.com/G-U-N/Gen-L-Video??

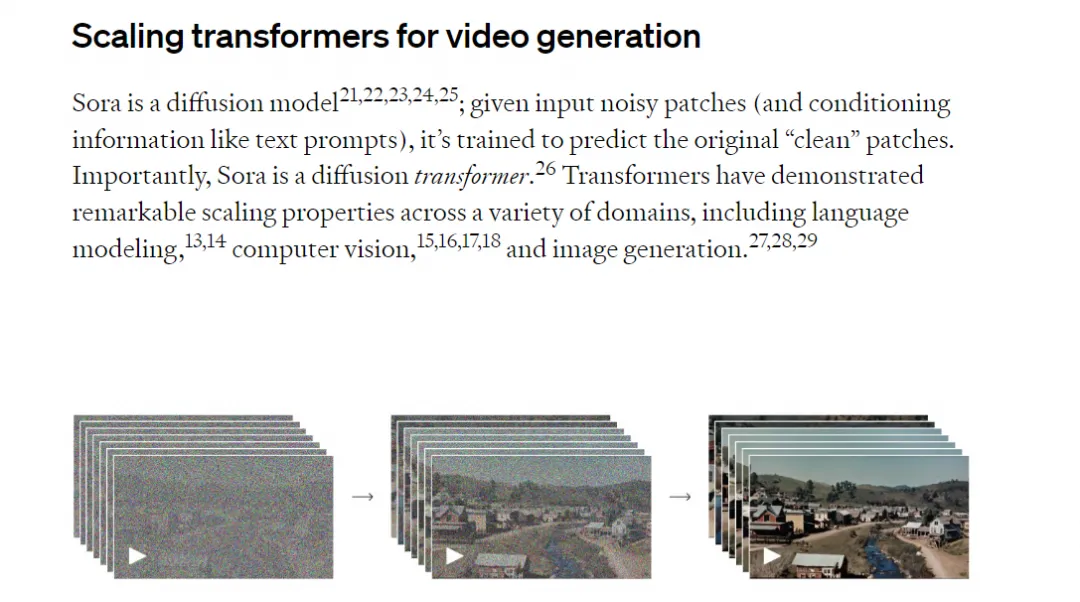

Sora(OpenAI)

時(shí)間:2024.2

???https://openai.com/sora(未開源)??

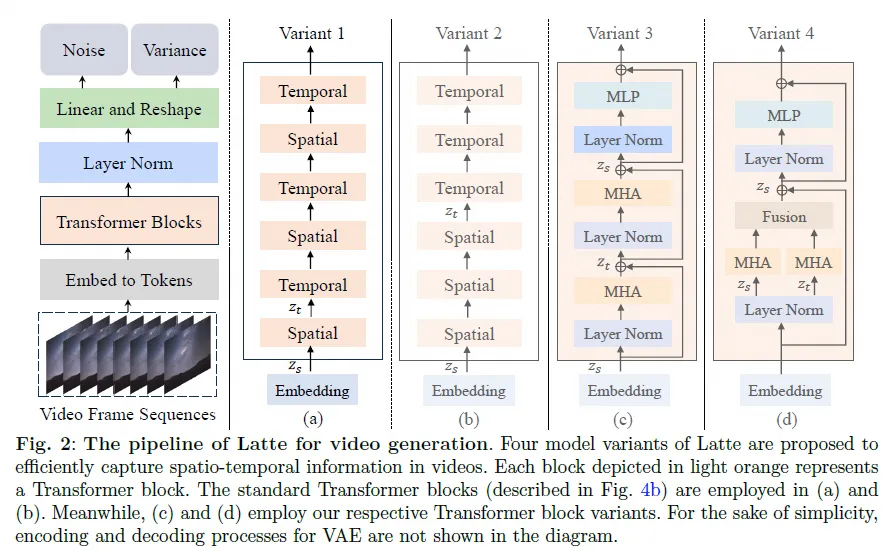

Latte: Latent Diffusion Transformer for Video Generation

機(jī)構(gòu):上海AI Lab

時(shí)間:2024.1.5

???https://maxin-cn.github.io/latte_project??

四、算法效果分析

本章節(jié)選擇了一些代表性的方法進(jìn)行效果分析

Animate Diff

效果:??https://animatediff.github.io/??,支持文生視頻,圖生視頻,以及和controlnet結(jié)合做視頻編輯

Animate Diff+ControlNet

輸入視頻:moonwalk.mp4?

輸出樣例

注意:要輸入主語保證主體一致性

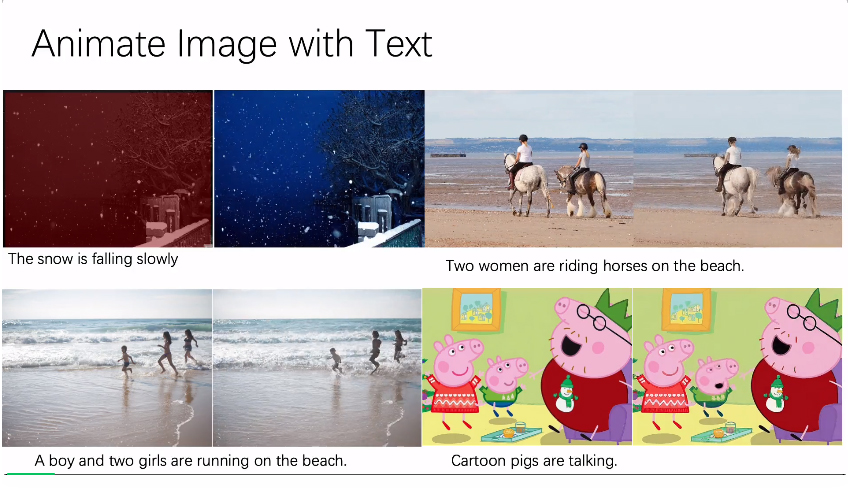

AnimateAnything

能夠指定圖片的運(yùn)動(dòng)區(qū)域,根據(jù)文本進(jìn)行圖片的動(dòng)態(tài)化

效果:

Stable Video Diffusion

能夠基于靜止圖片生成25幀的序列(576x1024)

效果:

圖片

圖片

ControlVideo

輸入+輸出樣例:500.mp4,300.mp4,整體效果不錯(cuò)

問題:因?yàn)橥评磉^程需要額外的訓(xùn)練,消耗時(shí)間久,第一個(gè)視頻需要50min(32幀),第二個(gè)視頻需要14min(8幀)

Rerender A Video

整體效果還可以,運(yùn)行速度和視頻幀數(shù)有關(guān),10s視頻大約在20min左右。

DCTNet

效果:整體畫面穩(wěn)定,支持7種風(fēng)格,顯存要求低(6-7G),上面視頻40s左右就可以處理完

DreamPose

Animate Anyone

MagicDance

輸入圖片:

輸出:

Sora

效果:https://openai.com/sora?

能夠生成長(zhǎng)視頻,質(zhì)量很好,但是尚未開源

五、總結(jié)和展望

- 文生視頻和圖生視頻算法:其中Animate Diff,VideoCrafter等已經(jīng)開源,支持文/圖生成視頻,并且經(jīng)過測(cè)試效果還不錯(cuò),同時(shí)圖生視頻還支持通過結(jié)合不同的base模型實(shí)現(xiàn)視頻的風(fēng)格化。不過生成的視頻幀數(shù)基本都在2s以內(nèi),可以作為動(dòng)圖的形式進(jìn)行展示。其中Stable Video Diffusion是stability ai開源的一個(gè)圖生視頻的算法,效果相對(duì)更加逼真,視頻質(zhì)量更高,但是視頻長(zhǎng)度依舊很短。

- 視頻編輯算法:比如基于controlnet的可控生成視頻可以初步達(dá)到預(yù)期的效果,支持實(shí)現(xiàn)特定目標(biāo)或者屬性(顏色等)的更換,也支持人物的換裝(比如顏色描述)等等,其中生成的視頻長(zhǎng)度和GPU顯存相關(guān)。

- 視頻風(fēng)格化:基于diffusion 模型的視頻風(fēng)格化效果最好的是rerender a video,可以支持prompt描述來進(jìn)行視頻的風(fēng)格化,整體來講這個(gè)方法對(duì)人臉和自然環(huán)境有比較好的效果,運(yùn)行成本也相對(duì)較低(相較于視頻編輯算法)

- 特定的人物動(dòng)態(tài)化算法:目前demo效果最好的animate anyone和dream moving都還沒有開源。不過這兩個(gè)算法都對(duì)外開放了使用接口,比如通義千問app以及modelscope平臺(tái)。重點(diǎn)介紹一下通義實(shí)驗(yàn)室的Dream moving,??https://www.modelscope.cn/studios/vigen/video_generation/summary??是其開放的使用平臺(tái),里面支持同款的動(dòng)作生成,圖生視頻,視頻的風(fēng)格化以及視頻賀卡等功能,整體來講效果很好。而目前開源的方法中,測(cè)試的效果最好的是MagicDance,但是人臉有一定的模糊,距離animate anyone和dream moving展示的效果還有差距。

- 長(zhǎng)視頻算法:隨著Sora的出現(xiàn),Diffusion Transformer的架構(gòu)后續(xù)會(huì)備受關(guān)注,目前大部分算法都局限于2s左右的短視頻生成,而且質(zhì)量上不如Sora。后續(xù)會(huì)有更多的算法將Sora的思路融入現(xiàn)有的方法中,不斷提升視頻質(zhì)量和視頻長(zhǎng)度。不過目前sora的模型和實(shí)現(xiàn)細(xì)節(jié)并沒有在技術(shù)報(bào)告中公開,因此在未來還會(huì)有一段的摸索路要走。

- 整體總結(jié):

是否可用 | 優(yōu)勢(shì) | 劣勢(shì) | 適用場(chǎng)景 | 代表性方法 | |

文/圖生視頻 | 是 | 視頻質(zhì)量高 | 視頻長(zhǎng)度短 | 短視頻動(dòng)態(tài)封面 | Animate Diff(可擴(kuò)展性強(qiáng)) VideoCrafter(質(zhì)量較好) Stable Video Diffusion(質(zhì)量更好) |

視頻編輯算法 | 待定 | 算法種類多,可實(shí)現(xiàn)的功能多(修改任意目標(biāo)的屬性) | 推理速度較慢,顯存要求高,視頻長(zhǎng)度短 | 人物換裝(最簡(jiǎn)單的改變衣服顏色),目標(biāo)編輯,用戶體驗(yàn) | ControlVideo(效果好但運(yùn)行時(shí)間久) |

視頻風(fēng)格化 | 是 | 顯存要求相對(duì)視頻編輯更低,推理速度更快。 | 畫面存在一定的不穩(wěn)定問題。但是基于GAN的DCTNet相對(duì)更穩(wěn)定 | 用戶體驗(yàn) | Rerender-A-Video(更靈活) DCTNet(效果更穩(wěn)定) |

人物動(dòng)態(tài)化 | 待定 | 用戶可玩性高 | 效果最好的代碼暫時(shí)沒有開源,開源的代碼生成的人臉會(huì)有一定的模糊 | 用戶體驗(yàn) | Animate Anyone(待開源) DreamMoving(待開源) MagicDance(已開源) |

長(zhǎng)視頻生成 | 否 | 視頻長(zhǎng)度遠(yuǎn)超2s | 整體質(zhì)量偏差 (Sora還沒開源) | 影視制作 | Sora |

本文轉(zhuǎn)載自大淘寶技術(shù),作者:壹水