大模型超強內存優化:成本削減高達75%,性能不減弱!成果出自日本一初創AI公司之手;網友:電力可能夠用了 原創

出品 | 51CTO技術棧(微信號:blog51cto)

一項逆天的大模型優化技術來了!

東京初創公司Sakana AI的研究人員開發了一種新技術,讓大模型能夠更有效地使用內存,不僅最多節省75%的內存占用,還甚至性能也有所提升!

這種名為“通用Transformer內存”的技術使用特殊的神經網絡優化LLM,保留重要的信息并丟棄冗余的細節。

這項技術旨在幫助企業降低基于大模型和其他基于Transformer的模型構建應用程序的成本。

這項技術在Hacker News上也被廣泛討論,一位網友說:會不會在經過三四年的性能優化,我們會發現根本不需要建核電站?

圖片

圖片

1.Transformer內存技術:神經網絡決定是否記憶存儲的Tokens

目前的模型支持非常長的上下文窗口,可以容納數十萬甚至數百萬個Tokens。

這使得用戶能夠在提示中塞入更多信息。然而,較長的提示可能導致更高的計算成本和較慢的性能。

當前的提示優化技術需要大量資源,或者要求用戶手動測試不同配置以減少提示的大小。

Sakana AI的研究人員,所開發的通用Transformer內存技術,通過神經注意力記憶模型(NAMMs)優化提示。NAMMs是簡單的神經網絡,決定是否“記住”或“忘記”LLM內存中存儲的每個Token。

“這一新功能使Transformer能夠丟棄不重要或冗余的細節,專注于最關鍵的信息,我們認為這對于需要長上下文推理的任務至關重要,”研究人員寫道。

圖片

圖片

NAMMs與LLM是分開訓練的,并在推理時與預訓練模型結合,這使得它們具有靈活性,易于部署。然而,它們需要訪問模型的內部激活,因此只能應用于開源模型。

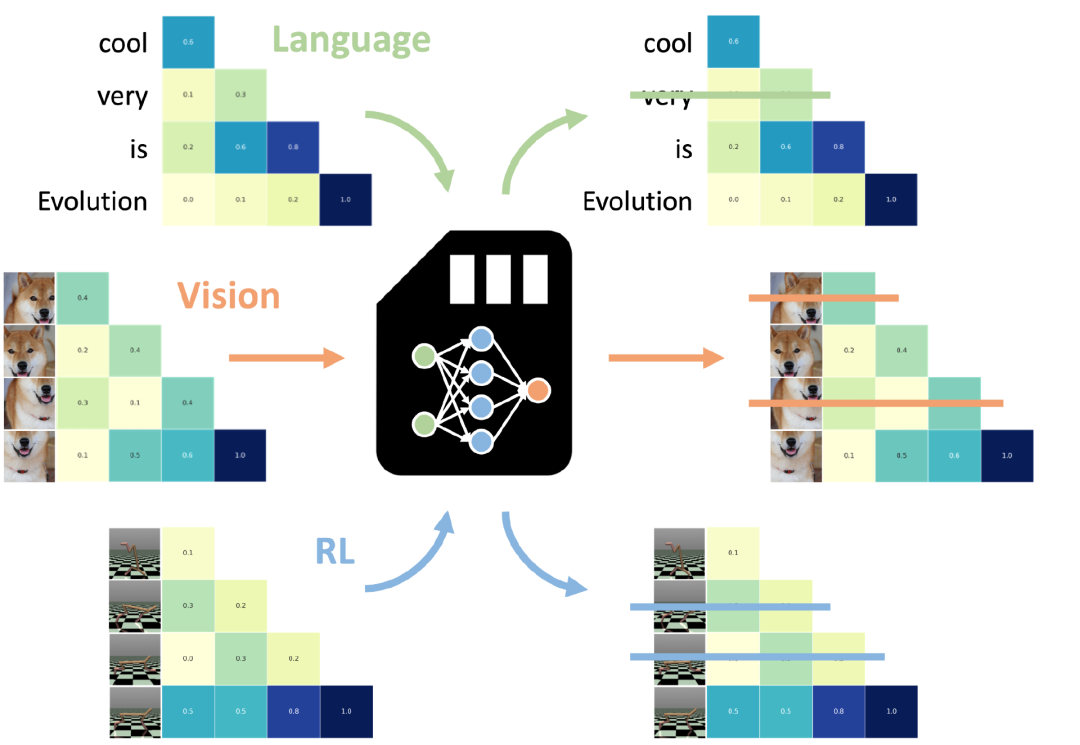

與Sakana AI開發的其他技術一樣,NAMMs是通過進化算法而非基于梯度的優化方法進行訓練的。通過反復變異和選擇表現最佳的模型,進化算法優化NAMMs的效率和性能。這尤其重要,因為NAMMs試圖實現一個不可微分的目標:保留或丟棄標記。

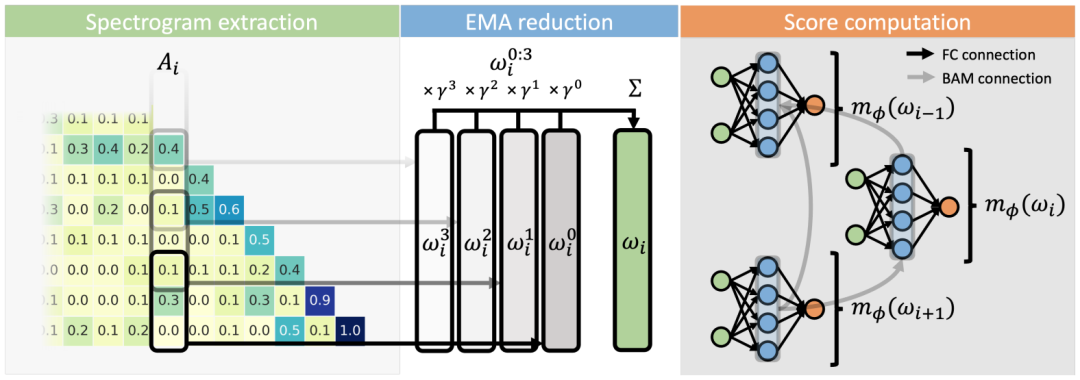

NAMMs作用于LLM的注意力層,這是Transformer架構的關鍵組件,決定了模型上下文窗口中每個標記的關系和重要性。基于注意力值,NAMMs決定應保留哪些標記,哪些可以從LLM的上下文窗口中丟棄。這種基于注意力的機制使得訓練好的NAMM可以在不同模型上使用而無需進一步修改。例如,訓練在文本數據上的NAMM可以應用于視覺或多模態模型,而無需額外訓練。

2.通用內存技術的應用:最高節省75%內存

為了測試通用Transformer內存的實際效果,研究人員在開源的Meta Llama 3-8B模型上訓練了一個NAMM。他們的實驗顯示,使用NAMMs后,基于Transformer的模型在非常長的序列上處理自然語言和編碼問題時表現更好。同時,通過丟棄不必要的標記,NAMM使LLM模型在執行任務時節省了高達75%的緩存內存。

“在我們的基準測試中,NAMMs顯著提高了Llama 3-8B Transformer的性能,”研究人員寫道。“此外,我們的內存系統還帶來了顯著的附加好處,減少了每層的上下文大小,同時從未專門優化過內存效率。”

他們還在70B版本的Llama模型以及針對其他模態和任務設計的Transformer模型上進行了測試,如Llava(計算機視覺)和Decision Transformer(強化學習)。

“即使在這些分布外的設置中,NAMMs通過丟棄冗余的視頻幀和不理想的行動,仍然保持其優勢,使其新的基礎模型能夠專注于最相關的信息,從而提高性能,”研究人員寫道。

圖片

圖片

上圖:神經注意力記憶模型 (NAMM) 會檢查注意力層,以確定哪些標記應從上下文窗口中保留或丟棄

3.新發現:神經網絡能根據任務調整其行為

另一個有趣的發現是,NAMMs會根據任務自動調整其行為。

例如,在編碼任務中,模型丟棄與代碼執行無關的連續標記塊,如注釋和空白字符。

另一方面,在自然語言任務中,模型丟棄表示語法冗余且不影響序列意義的標記。

研究人員發布了創建自己NAMM的代碼。像通用Transformer內存這樣的技術對于處理數百萬個標記的企業應用程序非常有用,能夠提升速度并降低成本。經過訓練的NAMM的可重用性也使其成為跨不同應用程序使用的多功能工具。

未來,研究人員建議采用更先進的技術,例如在訓練LLM時使用NAMMs,以進一步擴展其內存能力。

“這項工作僅僅開始挖掘我們這一新型內存模型的潛力,我們預期它可能為推動未來幾代Transformer的發展提供許多新機會,”研究人員寫道。

參考鏈接:??https://venturebeat.com/ai/new-llm-optimization-technique-slashes-memory-costs-up-to-75/??

本文轉載自??51CTO技術棧??