MobileLLM:“苗條”的模型比較好! 原創(chuàng) 精華

?1.MobileLLM

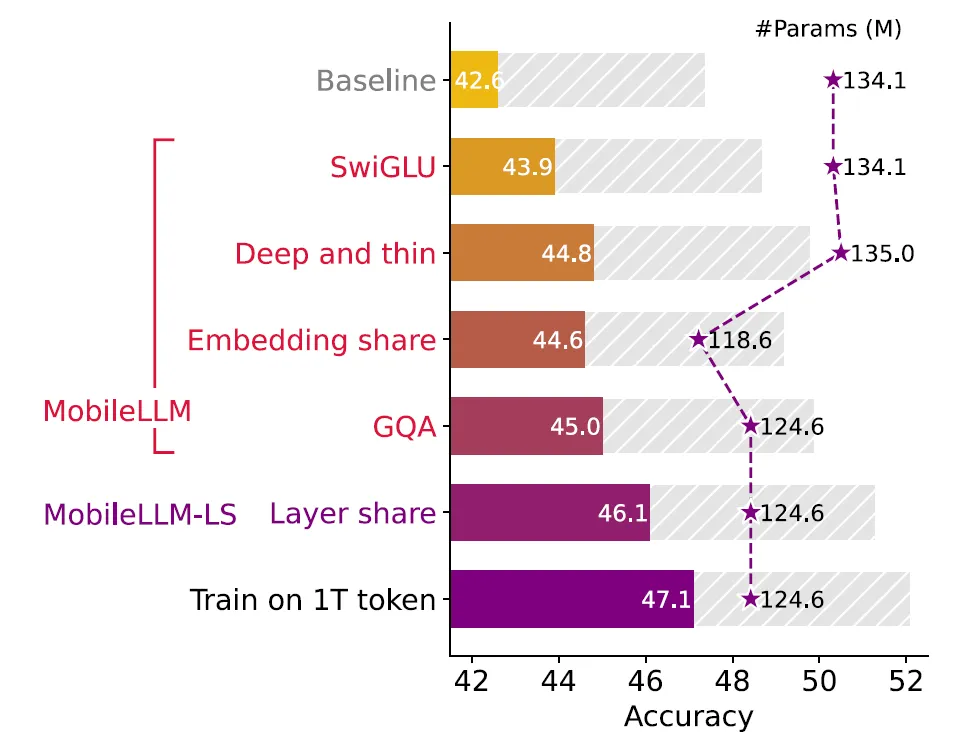

Meta AI研究人員推出了MobileLLM,從arXiv論文時間上看2月份發(fā)布的,但是在六月底又更新了一版。MobileLLM利用四種先進技術(shù),包括帶有SwiGLU的FFN、深度和薄架構(gòu)、嵌入共享和GQA,構(gòu)建了一個強大的基線小型LLM,MobileLLM。它是專為智能手機和其他資源受限的設(shè)備而設(shè)計。

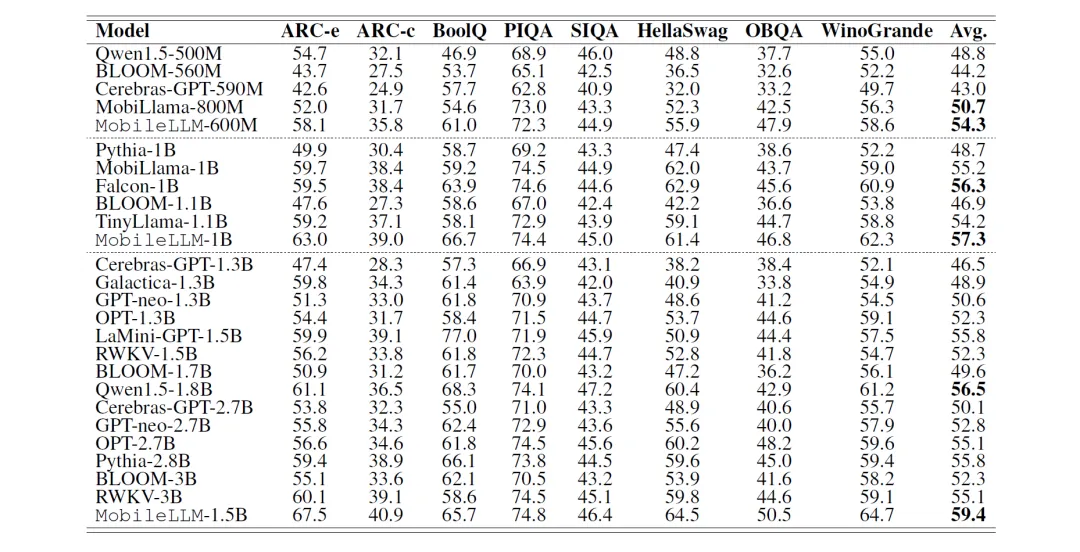

研究人員將其訓(xùn)練出的MobileLLM 125M/350M和參數(shù)量相當?shù)腟tate of the Art(SOTA)模型如Cerebras、OPT、BLOOM等進行對話標桿測試。

在零樣本(zero-shot)測試中MobileLLM 125M/350M比SOTA模型的平均準確率高出2.7%/4.3%。使用權(quán)重共享方法訓(xùn)練出的MobileLLM 125M/350M版本,名為MobileLLM LS,還可以將準確率分別再向上提升0.7%及0.8%。

模型具體的特點在于:

- 采取「深而精簡」(deep- and-thin)的模型架構(gòu)更能以極高效能萃取抽象知識

- 利用先進的權(quán)重共享技術(shù),包括嵌入共享、分組查詢注意力和塊權(quán)重共享,在存儲受限的場景中實現(xiàn)了權(quán)重利用率的顯著的提高。

2.苗條架構(gòu)

大模型領(lǐng)域有一種普遍觀點,Transformer模型的性能主要取決于參數(shù)數(shù)量、訓(xùn)練數(shù)據(jù)集的大小和訓(xùn)練迭代次數(shù)。這種觀點認為,架構(gòu)設(shè)計對Transformer模型的性能影響微乎其微。

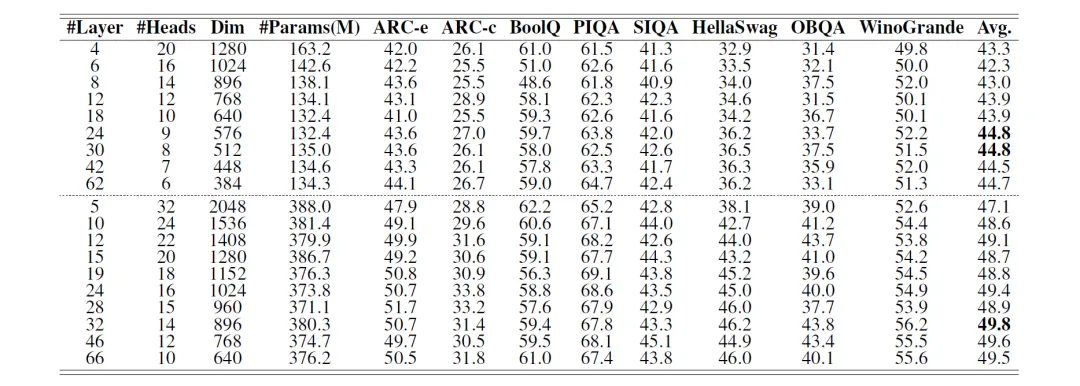

但是本次實驗研究表明,對于較小的模型,為了提高性能,更深比廣泛更為重要。下面的研究涉及 19 個模型的訓(xùn)練,其中包括 9個具有~125M個參數(shù)的模型和10個具有~350M個參數(shù)的模型。每個模型的設(shè)計大小相似,但深度和寬度有所不同。

上圖對八個零樣本常識推理任務(wù)以及問答和閱讀理解基準進行了實驗。研究結(jié)果一致表明,更深更薄的模型優(yōu)于更淺更寬的模型。

黑色部分是最佳表現(xiàn),可以看到基本上層數(shù)都較深。同時可以觀察到更深的網(wǎng)絡(luò)在大多數(shù)零樣本推理任務(wù)中的卓越性能,包括 ARC-easy、ARC-challenge、PIQA、HellaSwag、OBQA、WinoGrande,尤其是在TQA和RACE數(shù)據(jù)集上更加明顯。

<劃重點!>對于大小約為 125M的transformer 模型,具有30層甚至42層的模型的性能明顯優(yōu)于具有12層的模型。要知道之前大多數(shù)的125M模型的層數(shù)都限制為12!!

此時細心的讀者會發(fā)現(xiàn)第一行是升序,第二行是降序,第二行就是每個Transormer塊中的頭數(shù)<溫習(xí)點>。當模型的層數(shù)增加的時候,頭數(shù)一直在降低,也就是所謂的深而精簡!

研究人員最初設(shè)計用于減少LLM中的鍵值緩存大小的GQA,也可以有效減少小型LM中鍵值頭的冗余。GQA可以看作是權(quán)重重用的另一種權(quán)重共享形式,其中鍵值頭的數(shù)量是查詢頭的1/n,并且kv頭在計算注意分數(shù)和與查詢一起輸出時重復(fù)n次。

上表的結(jié)果表明,使用16個查詢頭可產(chǎn)生最佳結(jié)果。將kv-heads的數(shù)量從16個減少到4個,可使125M模型的準確率相當,而350M模型的準確率僅下降0.2個百分點,模型大小減少了近10%。通過采用分組查詢注意機制 (GQA),同時增加嵌入維度以保持模型大小,125M的準確率進一步提高了0.4個百分點,表明GQA是進一步挖掘小模型潛力的有利方法。

3.共享技術(shù)

Topic1 嵌入共享:

在1B以下的自然語言模型中,嵌入層構(gòu)成了參數(shù)數(shù)量的很大一部分。例如,Embedding<溫習(xí)點>的維度為 512,詞匯量為32k,輸入和輸出嵌入層就需要16M參數(shù)。這些嵌入層合在一起占125M參數(shù)模型總參數(shù)的20%以上。在大語言模型中,這一比例被稀釋了,例如輸入和輸出嵌入僅占LLaMA-7B模型總參數(shù)數(shù)量3.7%,在 LLaMA-70B模型中僅占0.7%。

LLM 模型中的輸入嵌入將詞匯表中的token ID映射到相應(yīng)的token嵌入,維度為 (vocab_size, embedding_dim)。相反,輸出全連接層?<溫習(xí)點>將嵌入維度映射回詞匯表中的logits預(yù)測<溫習(xí)點>,權(quán)重大小為 (vocab_size, embedding_dim)。通過共享嵌入,將“輸入-中間-輸出”的兩個轉(zhuǎn)化矩陣參數(shù)共用,從而產(chǎn)生更高效、更緊湊的模型架構(gòu)。

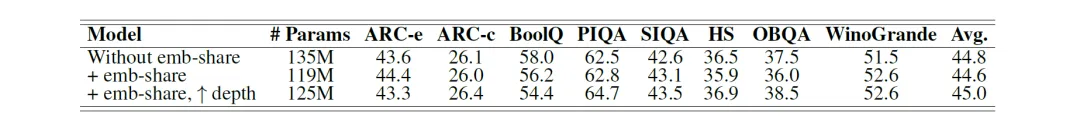

本次研究在30層125M模型上進行了實驗。上面的統(tǒng)計證明共享輸入和輸出嵌入可將參數(shù)數(shù)量減少16M,約占總參數(shù)的11.8%,平均準確率下降0.2個百分點。這時候通過重新分配已保存的參數(shù)以添加更多層,可以輕松恢復(fù)邊際準確率下降。與原始 135M模型相比,將深度增加到32層可使準確率提高 0.4 個百分點,同時仍保持 10M更少的參數(shù)。在有限的資源預(yù)算下,嵌入共享是一種有價值的技術(shù),可以最大限度地提高權(quán)重利用率并優(yōu)化模型性能。

Topic 2 層共享:

關(guān)于層深度與寬度影響的發(fā)現(xiàn)表明,對于小型 Transformer 模型來說,更深的層是有利的。這促使我們研究層共享作為一種增加隱藏層數(shù)量而無需額外模型存儲成本的策略。這種方法在模型大小是主要制約因素的設(shè)備上場景中特別有用。

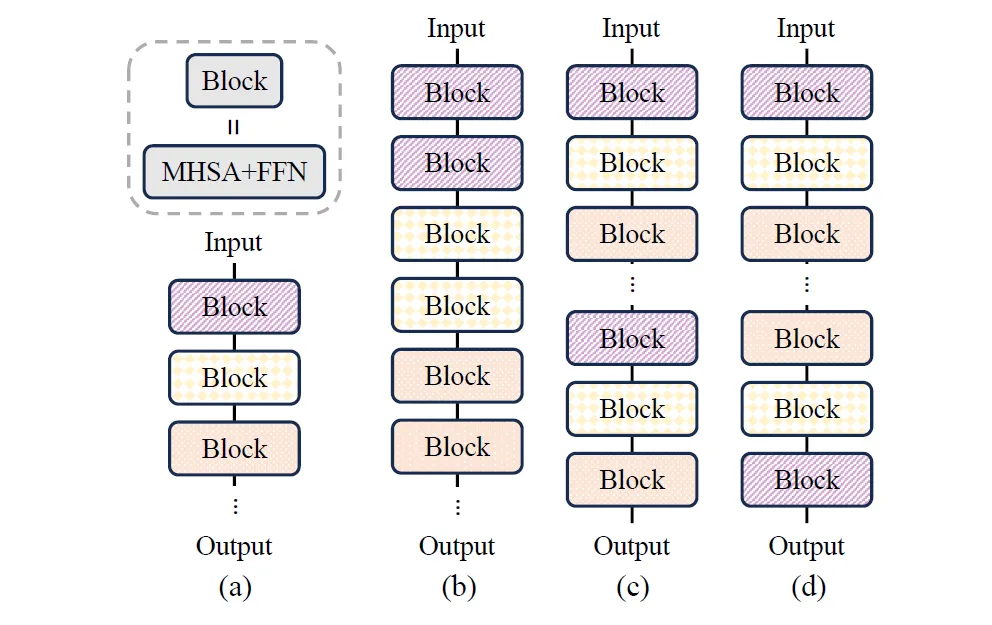

上圖(a)代表沒有層共享的基線模型;(b)相鄰塊之間的共享;(c) 重復(fù)全部共享;(d) 反向共享。這里每個塊就是Transformer塊,包含多頭自注意力 (MHSA) 和前饋網(wǎng)絡(luò) (FFN)。

bcd說白了就是按照特殊規(guī)律,相同顏色的塊共同擁有相同的參數(shù)。雖然c策略的共享性能略高,但b策略可以最好地利用緩存,因為共享權(quán)重可以保留在緩存中并立即計算兩次。

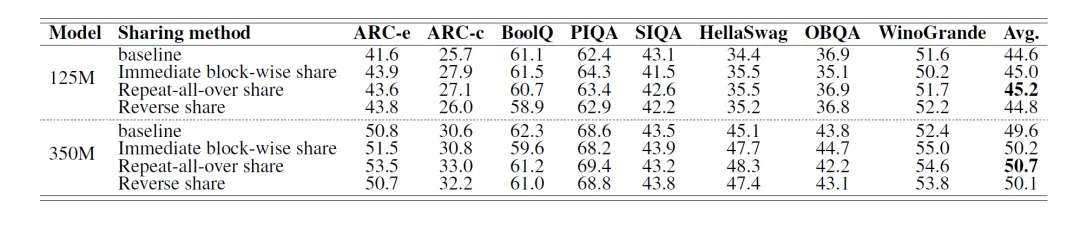

實驗結(jié)果表明,只需復(fù)制Transformer塊即可提高準確度,而無需進行架構(gòu)修改或擴大模型大小。通過實驗研究了三種不同的權(quán)重共享策略的效果如下表:<從上往下分別為abcd四種策略!>

結(jié)果表明,重復(fù)層共享策略C產(chǎn)生最佳性能。但是考慮到硬件內(nèi)存層次結(jié)構(gòu)<溫習(xí)點>,用于計算的SRAM通常限制在20MB左右。這個容量通常只足以容納一個 Transformer 塊。因此,b策略可以避免在SRAM和DRAM之間反復(fù)傳輸權(quán)重,從而提高自回歸推理的整體執(zhí)行速度。因此在模型設(shè)計中選擇了B策略,并將采用這個策略的模型稱呼為MobileLLM-LS。

4.消融和性能

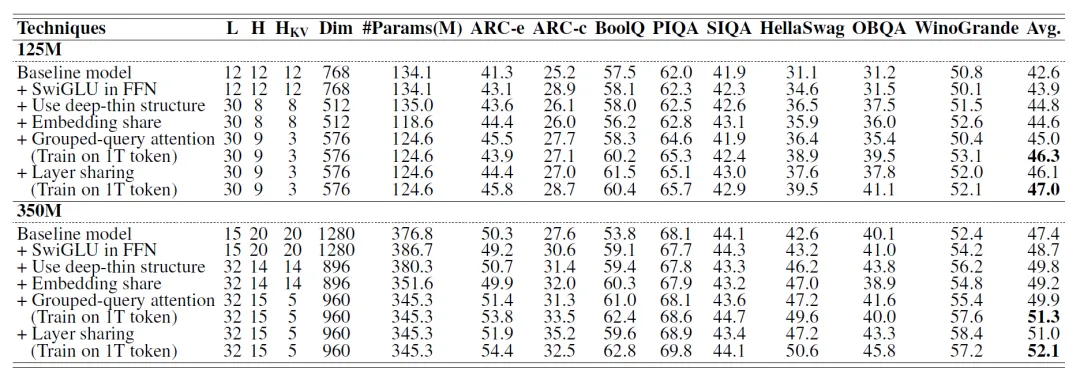

本次也進行了消融研究,消融(Ablataion)就是,一個全新模型M引入N種優(yōu)化的方法。為了搞清楚哪種方法對于M的提升最大,于是就在基礎(chǔ)模型上面單獨添加這項技能進行對比測試,也就是下圖的+號的由來)。會發(fā)現(xiàn)layer-share和GQA的影響力還是挺大的。

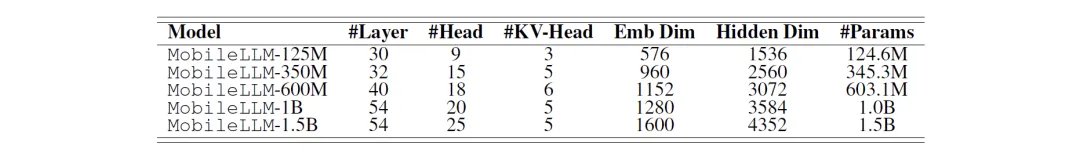

按照上面的優(yōu)化策略進行模型層數(shù)的堆疊,繼續(xù)將小的模型擴大到1.5B然后,在各項基準的評測下,性能還是不輸給同量級的競爭對手。

MobileLLM家族

MobileLLM到目前為止還沒公開使用,但Meta已經(jīng)開源了預(yù)訓(xùn)練代碼,允許其他研究人員在他們的工作基礎(chǔ)上進行開發(fā)。小模型技術(shù)(尤其是移動手機小模型)的發(fā)展會打開個人設(shè)備人工智能服務(wù)的便利性。

本文轉(zhuǎn)載自??魯班模錘??,作者: 龐德公 ????