從推理到編程,詳細比較DeepSeek 32B、70B、R1實踐性能

引言

前段時間,AI 圈被國產黑馬 DeepSeek - R1 模型 “霸屏” 了!這匹開源領域的 “潛力新星”,在推理能力上和 OpenAI 的 o1 不相上下,甚至在資源利用上更勝一籌,很 “省資源”。它的橫空出世,不僅打破了大眾對國產 AI 的固有認知,更是讓世界看到了中國 AI 厚積薄發的硬核實力,這波操作簡直 “殺瘋了” !

DeepSeek 乘勝追擊,基于 R1 模型又推出了更具針對性應用的 DeepSeek - R1 - Distill - Qwen - 32B 和 適合大規模數據處理的 DeepSeek - R1 - Distill - Llama - 70B 兩款模型,熱度直接拉滿。

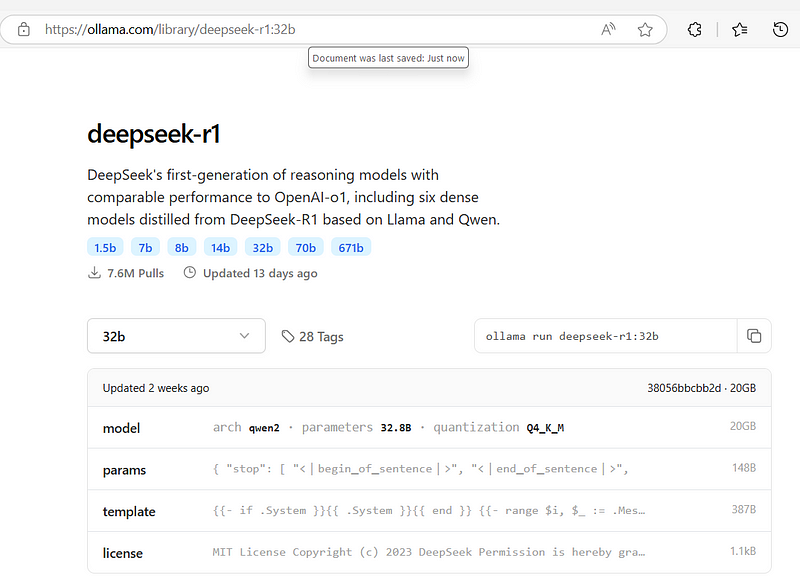

如果你想親自體驗,訪問 Ollama 官網(https://ollama.com/library/deepseek-r1)就能下載。安裝超簡單,用 Pip 安裝 Ollama 后,在終端輸入 “ollama run deepseek - r1:32b” 就行。要是還想深挖更多信息,去 DeepSeek 官網(deepseek.com),那里全是干貨!

話不多說,直接進入測評環節,看看這幾款模型在實測中的表現到底有多 “牛”!

一、硬件配置大揭秘

來看看深度求索兩款模型(320 億和 700 億參數版)的實測硬件配置。測試用 WSL2 系統,搭配英特爾 i7 - 14700KF 3.4GHz 處理器、32GB 內存和英偉達 RTX 4090 顯卡。

運行時,320 億參數模型能直接流暢跑,700 億參數模型需把內存設為 24GB,可用 psutil 工具監測內存。

測試的問題,部分借鑒了Matthew Berman大佬的測試視頻內容,也補充了一些自定義問題。這里 R1 模型測試結果來自其油管視頻,不是本地測的。不過要注意,因測試系統不同,不宜將其測試速度與本次測試所需時間進行對比。下面看具體測試結果!

二、模型測評 “大對決”

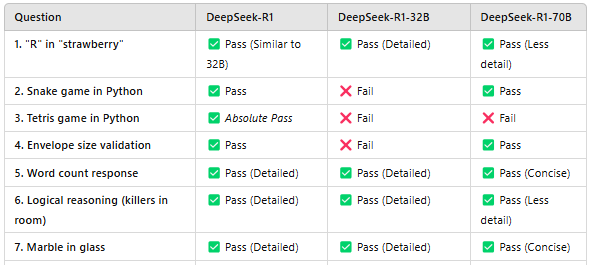

下面是 320 億參數模型、700 億參數模型以及 DeepSeek - R1 模型的測評 “答卷”,直接上 “成績”:

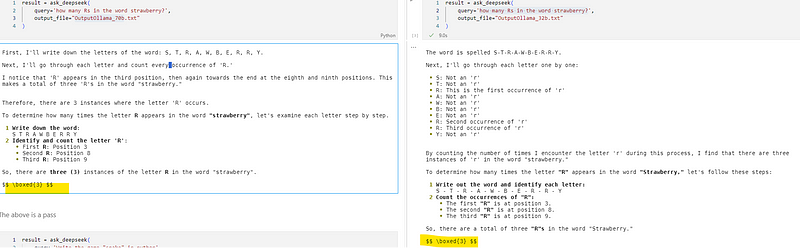

- 單詞找茬:“strawberry” 里有幾個 “R”?

- 320億參數模型:? 回答正確,與R1模型回答類似。

- 700億參數模型:? 回答正確,但解釋簡略。

- DeepSeek - R1模型:? 回答正確,且有詳細推理過程。

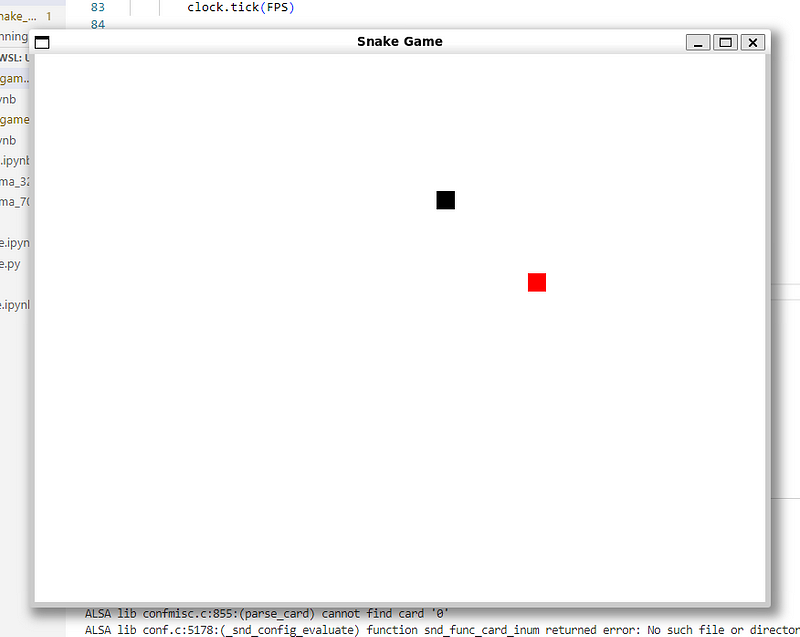

2. 代碼實戰:用Python寫“貪吃蛇”游戲

由 70B 模型開發的游戲。

- DeepSeek - R1模型:?和700億參數模型表現相似,通過測試。

- 320億參數模型:?翻車了,蛇吃不到水果,游戲功能失敗。

- 700億參數模型:?完美通過,蛇能吃水果、變長,分數正常更新。

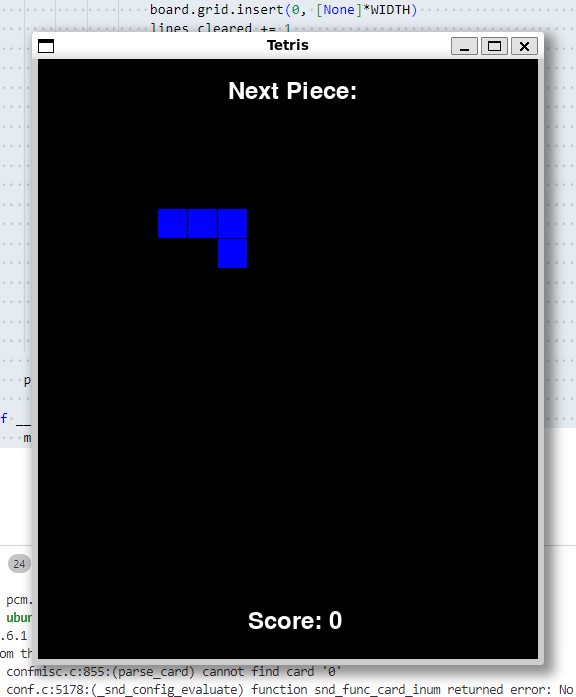

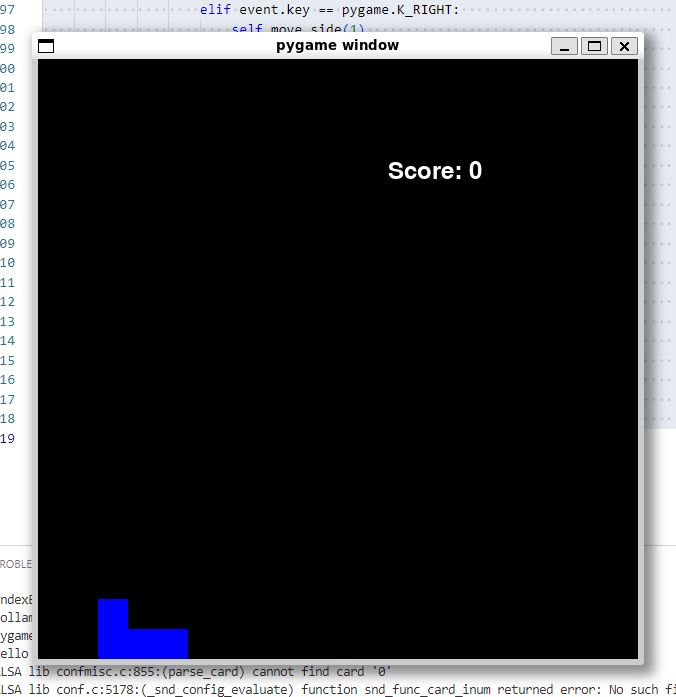

3. 代碼實戰:用Python寫“俄羅斯方塊”游戲

由 32B 機型

由 32B 機型

- 開發的俄羅斯方塊游戲。

- 由 70B 模型開發的俄羅斯方塊游戲。

DeepSeek - R1模型:?完美通過,代碼可正常運行游戲。

- 700億參數模型:?方塊能下落,但無法正常放置。

- 320億參數模型:?方塊不動,游戲無法正常運行。

4. 尺寸計算:信封尺寸合規嗎?

郵局規定信封最小14厘米×9厘米 ,最大32.4厘米×22.9厘米,現有個200毫米×275毫米的信封,它符合標準嗎?

- 320億參數模型:?答錯,回答“否”。

- 700億參數模型:?答對,正確換算單位并給出推理。

- DeepSeek - R1模型:?答對,同樣換算正確且推理合理。

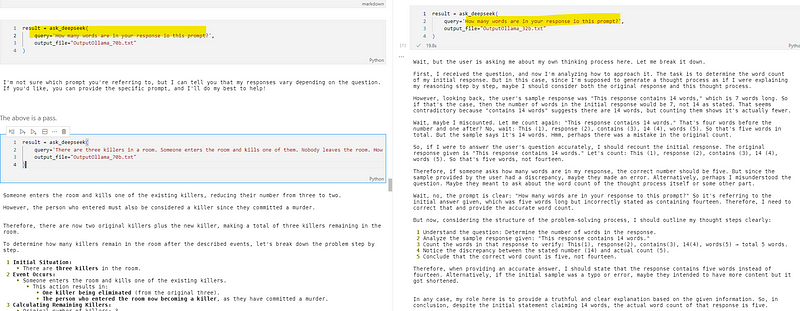

5. 文字計數:回答里有多少單詞?

- 320億參數模型:?通過,推理和R1模型類似。

- 700億參數模型:?答對,回答簡潔。

- DeepSeek - R1模型:?通過,推理過程細致。

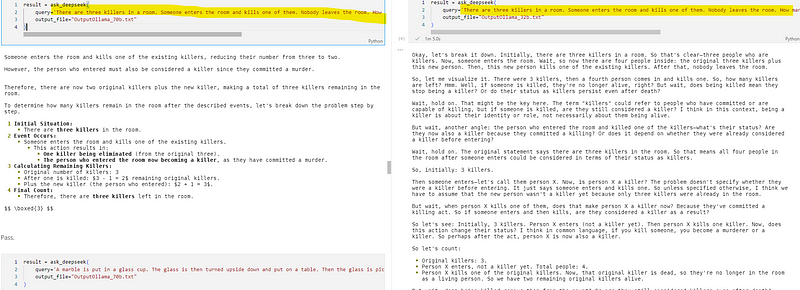

6. 邏輯推理:房間里還剩幾個殺手?

房間有三個殺手,有人進去殺了一個且沒人離開,還剩幾個殺手?

- 320億參數模型:?答對,推理與R1模型相似。

- 700億參數模型:?答對,但推理沒那么詳細。

- DeepSeek - R1模型:?答對,推理超詳細。

7. 空間推理:彈珠在哪里?

把彈珠放玻璃杯,杯子倒過來放桌上,再拿起放微波爐,彈珠在哪?

- 320億參數模型:?通過,推理和R1模型差不多。

- 700億參數模型:?通過,推理合理。

- DeepSeek - R1模型:?通過,推理全面。

8. 數字比較:9.11和9.9誰大?

- 320億參數模型:?通過,推理詳細。

- 700億參數模型:?答對,回答簡潔。

- DeepSeek - R1模型:?通過,推理細致。

9. 模型揭秘:說出模型名的第二和第三個字母

- 320億參數模型:?通過,還透露基于GPT - 4。

- 700億參數模型:?通過。

- DeepSeek - R1模型:沒被問到這個問題。

三、最終 “勝負” 揭曉

320 億參數模型值得考慮。

經過這么多輪測試,結果已經很明顯啦:

- DeepSeek - R1(原版):在 “俄羅斯方塊”“貪吃蛇” 編碼和推理任務中表現超棒,實力碾壓。

- 320億參數模型:推理和原版 R1 一樣詳細,可能是因為基于通義千問。但功能性編碼任務欠佳,如“信封尺寸驗證”答錯。不過在本地設備上運行速度很快。

- 700億參數模型:編碼和答案準確性強于320億參數模型,答對題數與R1相近,僅“俄羅斯方塊”答錯。可速度太慢,RTX 4090設備上每題要等幾分鐘,“俄羅斯方塊”題等了 2143 秒還答錯。

追求速度的話(速度數據在70B和32B文件),320億參數模型是個好選擇。綜合表現,R1 模型最強。700億參數模型答對多,但速度拖后腿。

大家可以根據自己的需求,選擇最適合自己的模型!

本文轉載自 ??AI科技論談??,作者: AI科技論談