一文讀懂OpenGVLab帶來的最新視覺預訓練框架

大模型技術論文不斷,每個月總會新增上千篇。本專欄精選論文?重點解讀,主題還是圍繞著行業實踐和工程量產。若在某個環節出現卡點,可以回到大模型必備腔調?或者LLM背后的基礎模型?重新閱讀。而最新科技(Mamba,xLSTM,KAN)?則提供了大模型領域最新技術跟蹤。若對于具身智能感興趣的請移步具身智能專欄?。技術宅麻煩死磕AI架構設計。當然最重要的是訂閱“魯班模錘”。

在過去的十年中,ImageNet預訓練的視覺模型顯著提高了計算機視覺水平,在各種視覺任務中不斷取得突破。ImageNet的成功激發了人們進一步探索從頭開始預訓練視覺模型的更好方法。最近,預訓練的重點已從手動注釋數據轉移到大規模的網絡爬蟲圖像文本數據。這一轉變的一個關鍵里程碑是CLIP,它利用的圖像-文本對的數據比ImageNet大數百倍,在各種任務中提供卓越的性能,并逐漸成為視覺模型預訓練的主流方法。

基于這一趨勢,人們對探索圖像-文本交錯的數據的興趣越來越大,這在互聯網上更為普遍。與CLIP中使用的結構化圖像-文本對不同,這種交錯數據是自由格式和非配對的,規模更大,文本信息更豐富。充分利用這些圖像-文本交錯的數據對于進一步大規模改進視覺模型預訓練是必要的。

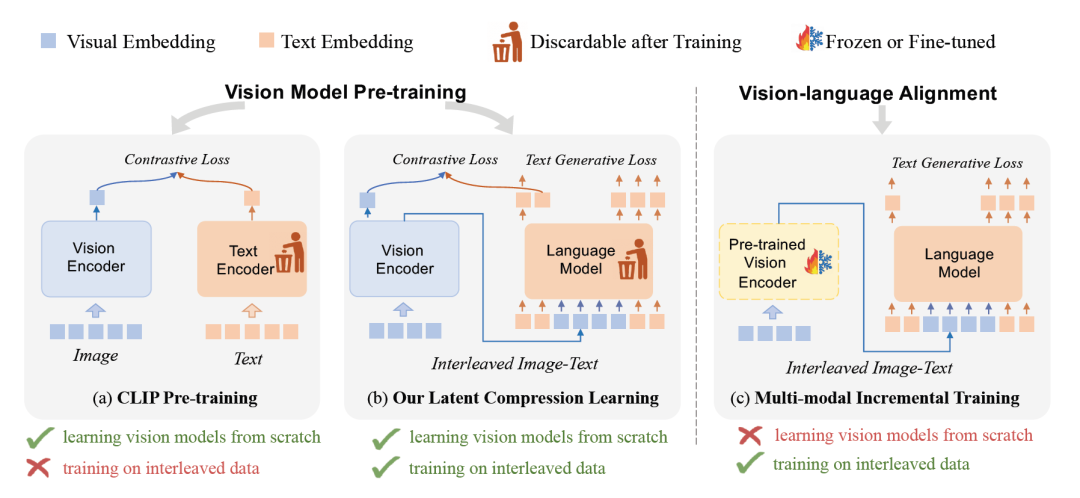

1.一圖讀懂

這張圖片完整的對比了新模型與CLIP的差異。(a)展示了來自CLIP的對比學習框架,而(b)展示了新穎的LCL預訓練框架。整體而言,與CLIP相比,LCL可以在訓練視覺編碼器的時候使用圖像和文本交叉的訓練數據。值得注意的是這兩個框架在訓練完畢的時候,可以將其中的text-encoder或者使用的大模型丟棄。

(c)則是展示了多模態的增量訓練過程,將訓練好的視覺編碼器有選擇地凍結或微調,然后按照傳統的訓練模型進行。當然這個過程也是支持圖像-文本的交錯訓練數據。但是,其主要目標是使預訓練的視覺編碼器和大語言模型保持一致。

研究人員提出這種訓練框架的思路在于自然語言處理最近一項研究表明,現代語言模型的成功源于將訓練數據集壓縮為模型參數。這種壓縮學習也適用于多模態領域,只是要壓縮的數據從結構化純文本擴展到圖像-文本交錯的數據。因為圖像是原始像素和非結構化的,通常包含不必要和不可預測的細節。這些細節與高級語義任務無關,應該在壓縮學習中丟棄。所以應該調整這種壓縮算法,以便于能夠適應圖像數據的加入。另外文本-圖像交錯的學習數據的將會更好的提取語義抽象。

整體而言,Latent Compression Learning是一個新的視覺預訓練框架,旨在通過最大化因果注意模型輸出和輸入之間的互信息來進行有效的潛在壓縮學習。

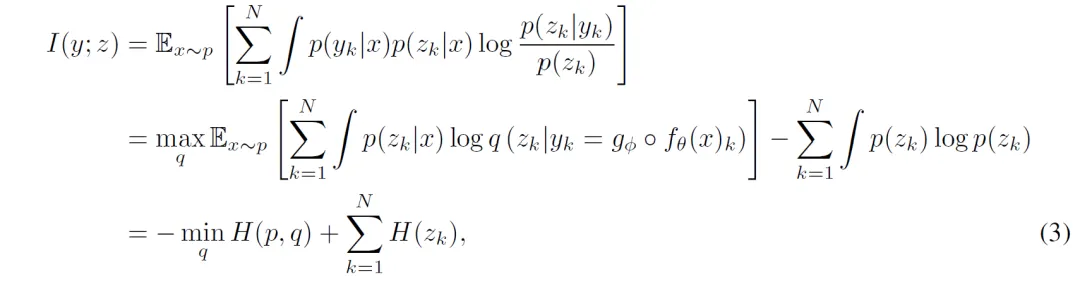

兩個隨機變量的互信息(mutual Information,MI)度量了兩個變量之間相互依賴的程度。具體來說,對于兩個隨機變量,MI是一個隨機變量由于已知另一個隨機變量而減少的“信息量”(單位通常為比特)。互信息的概念與隨機變量的熵緊密相關,熵是信息論中的基本概念,它量化的是隨機變量中所包含的“信息量”。

框架的核心思想是通過因果注意模型來實現潛在的信息壓縮學習。

因果注意模型通常用于序列預測或生成任務,確保每個輸出僅依賴于前面的輸入

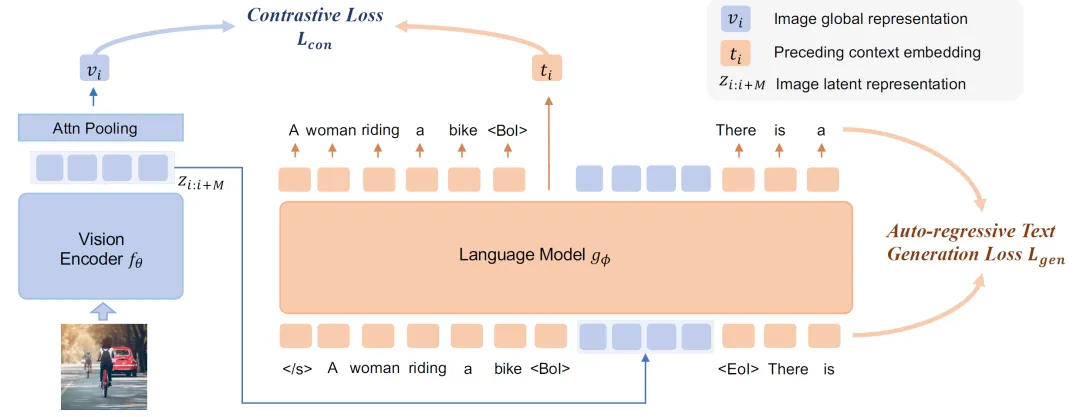

LCL 時的模型架構概覽如上圖所示。在交錯的圖像文本輸入序列中,引入特殊標記 <BoI> 和 <EoI>,分別作為圖像中視覺嵌入的開始和結束的特殊標記。原文采用 Vision Transformer (ViT) 作為視覺編碼器,它輸入一系列圖像塊并輸出一系列潛在表示。這最為關鍵的是損失函數,也就是訓練目標的設定。

目前優化目標可以分解為兩部分:第一部分為對比學習,就是上圖最上面的那根線,對比視覺“潛變量”和先前上下文的語義一致性(對比的對象是<BOI>標識的輸出)。第二部分為自回歸預測:就是傳統文本生成的對比,大白話就是將生成的字符和預期的字符比較。綜合兩者的差異,反向的微調和訓練模型。

這兩個訓練目標相互補充,學習到的視覺潛變量既保留了可以從先前上下文中預測的信息,又包含了預測后續上下文所需的信息,從而實現了有效的視覺預訓練。

2.潛在壓縮學習

自回歸語言建模等同于壓縮學習。假設 ???? 是一個具有可學習參數 ?? 的語言模型 (LM)。給定一個輸入文本序列 ??=(</s>,??1,??2,…,????) ,其中</s>是一個指示文本開頭的特殊標記,模型根據前面的上下文輸出 ??=?????(??)=(??1,??2,…,????) 預測下一個標記,即 ??k-estiamte=????=?????(??)?? 。

而其中x的概率為:

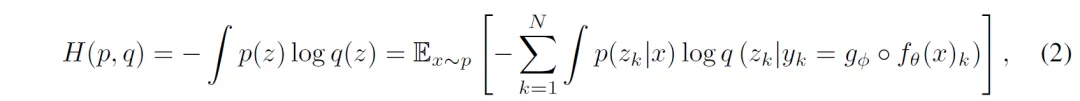

該模型使用NLL損失進行優化,這等于最小化數據分布 ?? 和模型分布 ?? 之間的交叉熵:

然而在訓練的過程中,卻出現了塌方。研究人員發現將潛在壓縮和最大熵約束相結合,完全等同于最大化模型輸入和輸出之間的互信息。

因此, 將??使用作為優化目標可以實現潛在壓縮,同時通過最大的熵約束避免視覺z的坍縮。壓縮??使模型提取有用的信息并丟棄圖像的不可預測信息。同時,最大化???要求每個????能從先前的潛伏??中獲得足夠的信息來預測 ???? 。每個 ???? 都應該攜帶可預測的信息。

這保證了圖像表示能夠將豐富的語義信息編碼,當然這些編碼和文本對齊。假設通過圖像表示學習到的上述屬性是視覺語言預訓練所需要的,因此使用方程該方程作為我們的預訓練目標。參數 ?? 和 ?? 在此目標下共同優化。直觀地,視覺編碼器 ???? 學習通過高級抽象來表示圖像,而因果注意力模型 ???? 學習壓縮數據集的高級抽象。

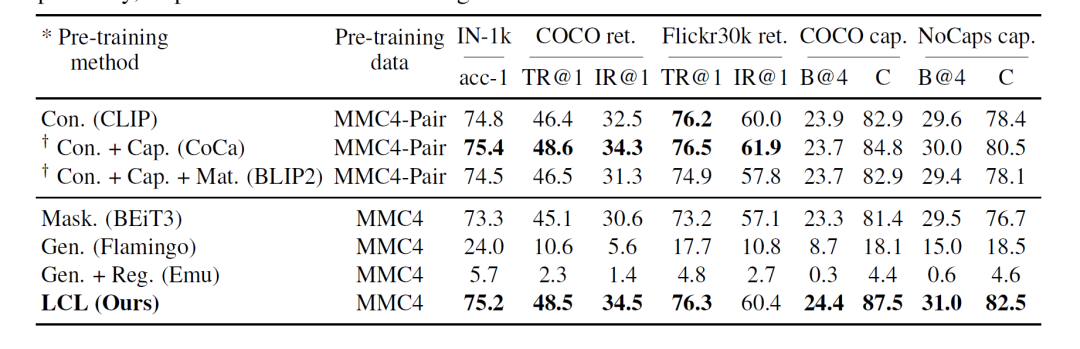

3.最終的效果

LCL首次探索了使用交錯圖像文本數據,進行視覺模型預訓練。這篇文章從理論上證明了latent compression等價于最大化因果模型的輸入和輸出之間的相互信息,并將該目標進一步分解為兩個基本的訓練任務(對比學習+生成任務),最終得到了更魯棒的視覺表征。

本文轉載自 ??魯班模錘??,作者: 龐德公