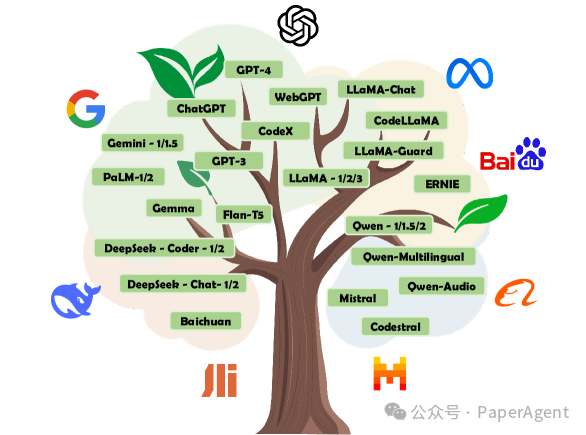

一文讀懂大模型協作策略:Merge、Ensemble、Cooperate!

大型語言模型(LLMs)時代協作策略是一個新興研究領域,協作策略可以分為三種主要方法:合并(Merging)、集成(Ensemble)和合作(Cooperation)。

每個模型都有其獨特的優勢,這種多樣性促進了這些模型之間的合作研究

盡管LLMs通過ICL和指令跟隨在各種任務上表現出強大的多樣性,但不同的LLMs在訓練語料庫和模型架構上的差異導致它們在不同任務上有不同的優勢和劣勢,有效的協作可以發揮它們的綜合潛力。

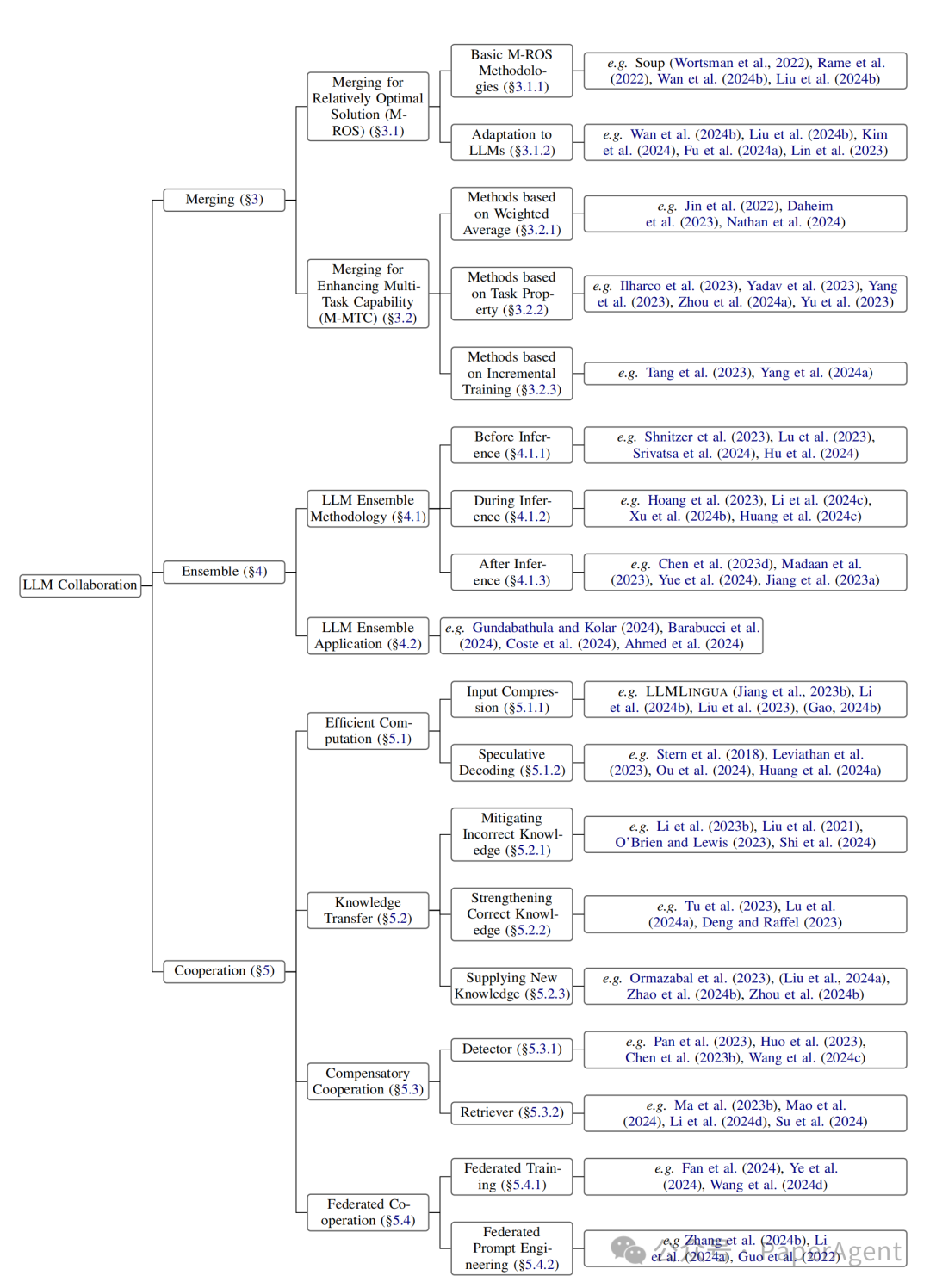

對大型語言模型(LLM)協作的主要分類

LLMs協作方法的分類:

- 合并(Merging):在參數空間中整合多個LLMs,創建一個統一的、更強大的模型。

- 集成(Ensemble):結合不同模型的輸出以獲得一致的結果。

- 合作(Cooperation):利用不同LLMs的多樣化能力來實現特定目標,如高效計算或知識轉移。

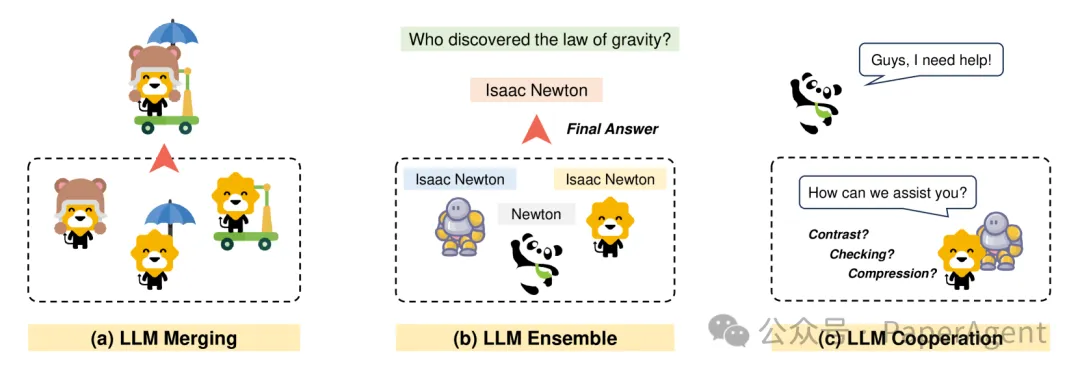

不同協作策略的示意圖,圖中的每種動物代表一個不同的大型語言模型(LLM)

合并(Merging)方法

合并策略旨在通過在參數空間中整合多個模型來創建一個統一的、更強大的模型:

- 合并的目的:合并方法旨在解決單一模型可能存在的限制,如信息缺失、陷入局部最優或缺乏多任務能力。

- 合并為相對最優解(M-ROS):

- 描述了深度學習模型在訓練過程中可能無法達到精確最優解的現象。

- 提出了通過合并多個模型的參數來獲得更好的相對最優解的方法,包括簡單平均和加權平均兩種方法。

- 基本M-ROS方法:

- 簡單平均:將多個微調模型的參數以相等的系數進行平均,以創建一個更強的模型。

- 加權平均:根據模型的重要性或質量分配不同的系數,以實現更好的合并。

- 合并以增強多任務能力(M-MTC):

- 通過合并具有不同能力的模型來構建具有多任務能力的統一模型的嘗試。

- 介紹了基于加權平均、基于任務屬性和基于增量訓練的方法來解決模型參數空間中的分歧問題。

- 基于任務屬性的合并方法:

- 定義了任務向量τt,這是一個指定預訓練模型參數空間中方向的向量,該方向的移動可以提高特定任務的性能。

- 解決參數沖突的方法,包括參數沖突解決、減少參數方法和工具包(Toolkit)。

- 基于增量訓練的方法:

- 提出了通過增量學習技術來恢復原始性能的方法,如尋找模型參數空間中的共享低維子空間以最小化任務干擾。

- 合并方法的局限性:

- 當前模型合并方法僅適用于具有相同架構和參數空間的模型,對于參數不兼容的模型,如LLaMA和QWen,當前的合并技術是無效的。?

集成(Ensemble)方法

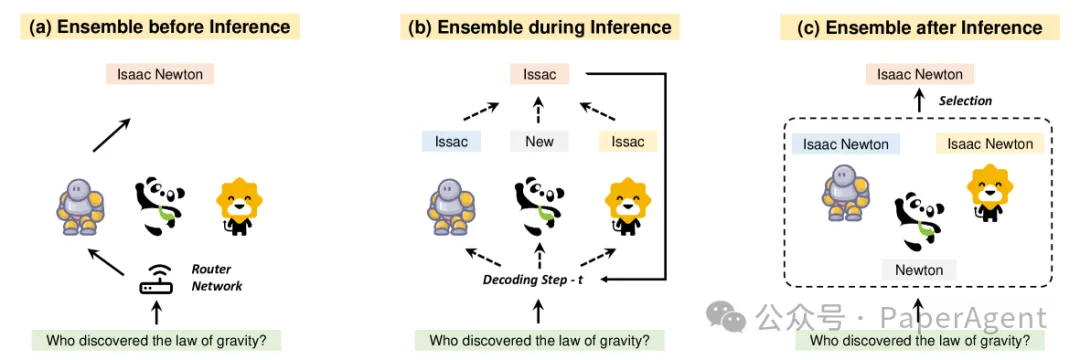

集成方法是一種通過結合多個模型的輸出來提高整體性能的策略,探討了在推理前、推理中和推理后進行集成的不同方法,以及它們如何影響推理速度、集成粒度和面臨的限制。

在推理之前(a)、推理期間(b)和推理之后(c)的大型語言模型(LLM)集成方法的示意圖。

- 集成學習的重要性:與傳統的分類任務不同,LLMs通常通過文本生成來解決各種任務,因此它們的輸出更加靈活和自然。這要求為LLMs設計特定的集成方法。

- LLM集成方法論:

- 根據集成發生的時間點,將集成方法分為三類:推理前(Before Inference)、推理中(During Inference)和推理后(After Inference)。

- 推理前的集成(Before Inference):

- 這類方法在推理前選擇最適合特定輸入樣本的LLM,例如通過訓練外部路由器來選擇最優的LLM。

- 推理中的集成(During Inference):

- 在推理期間,LLMs自回歸地生成令牌。這類方法在每個解碼步驟中執行集成,以減少早期錯誤隨時間累積的影響。

- 推理后的集成(After Inference):

- 這類方法在推理后結合生成的輸出,例如構建LLM級聯以減少僅使用大型LLMs的推理成本,或者從多個LLMs生成的候選中選擇最佳輸出。?

- 推理速度:

- 集成方法通常會降低推理速度,尤其是在推理期間和推理后的集成方法。

- 集成粒度:

- 推理前和推理后的集成方法通常在示例級別工作,提供粗粒度集成;而推理中的集成方法在令牌級別工作,提供細粒度集成。?

合作(Cooperation)方法

在大型語言模型(LLMs)的時代,協作策略不僅僅局限于簡單的合并或集成。越來越多的研究正專注于通過LLMs之間的合作來解決各種問題或特定任務的更廣泛方法,根據目標可以分為不同合作策略:

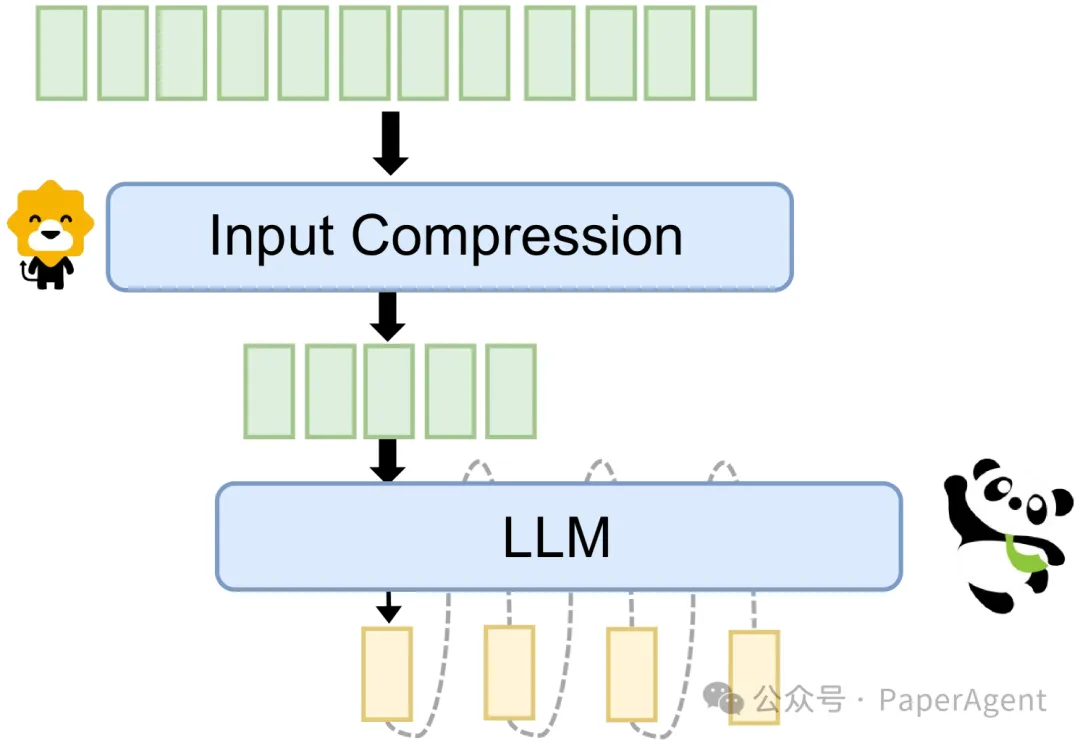

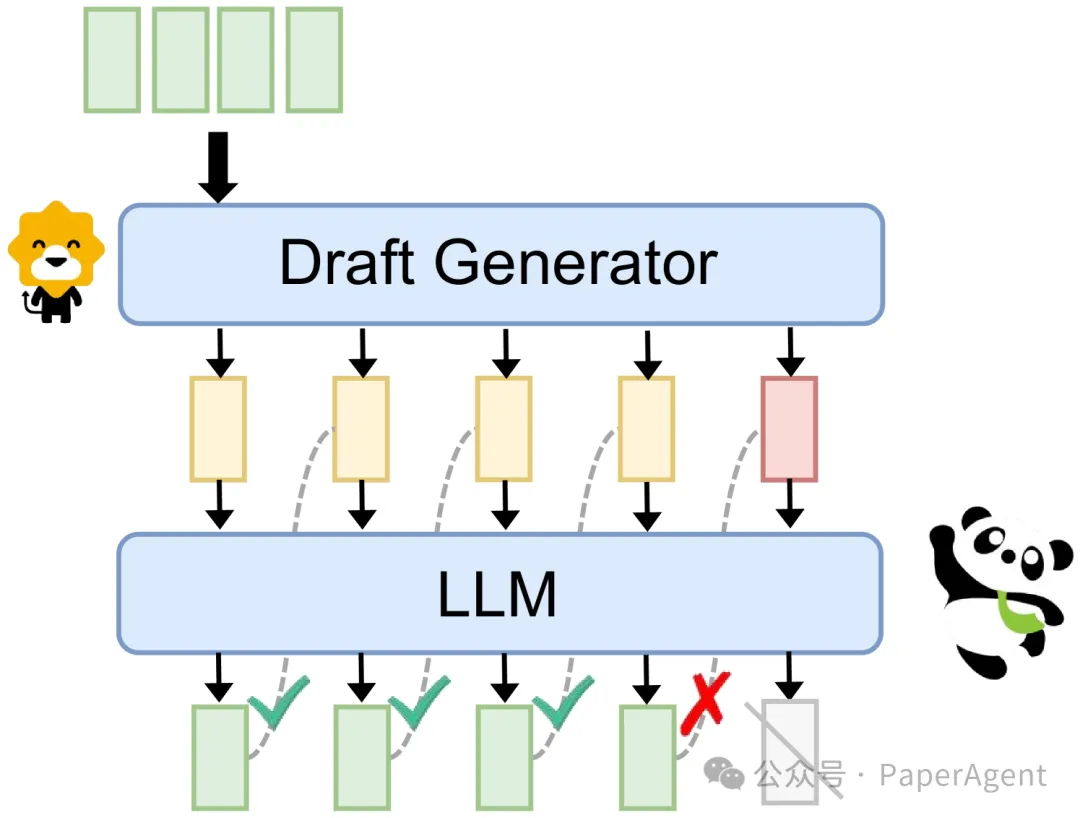

- 高效計算:通過輸入壓縮和推測性解碼來加速模型推理。

大型語言模型(LLMs)與壓縮模塊合作進行輸入壓縮

大型語言模型(LLMs)與草稿生成器合作進行推測性解碼

- 知識轉移:通過合作在推理階段轉移知識,而不是涉及訓練。

- 知識轉移的重要性:由于直接訓練大型模型獲取新知識既困難又成本高昂,因此通過合作轉移知識或能力成為一個重要的研究方向。

- 知識轉移的方法:

- 幾種主要的方法,包括減少錯誤知識(Mitigating Incorrect Knowledge)、加強正確知識(Strengthening Correct Knowledge)和提供新知識(Supplying New Knowledge)。

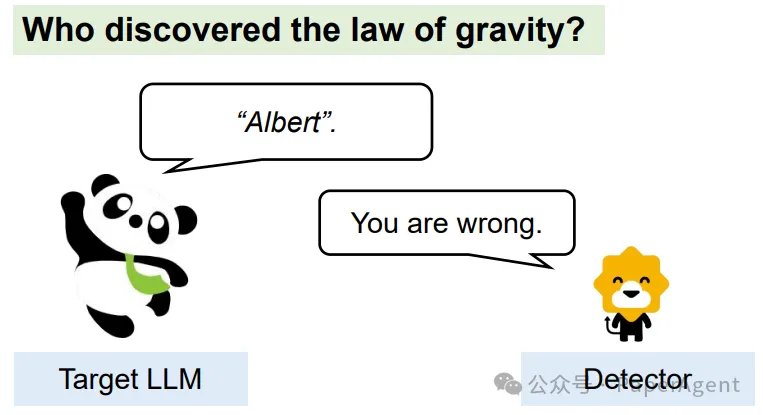

- 減少錯誤知識:

- LLMs在生成文本時可能出現的幻覺(hallucinations)和偏見(bias)問題,并提出了對比解碼(Contrastive Decoding, CD)等方法來減少這些問題。

- 加強正確知識:

- 如何通過額外的模型來增強解碼輸出的忠實度,例如使用屬性控制文本生成(attribute-controlled text generation)和驗證方法來提高輸出與輸入或指令的一致性。

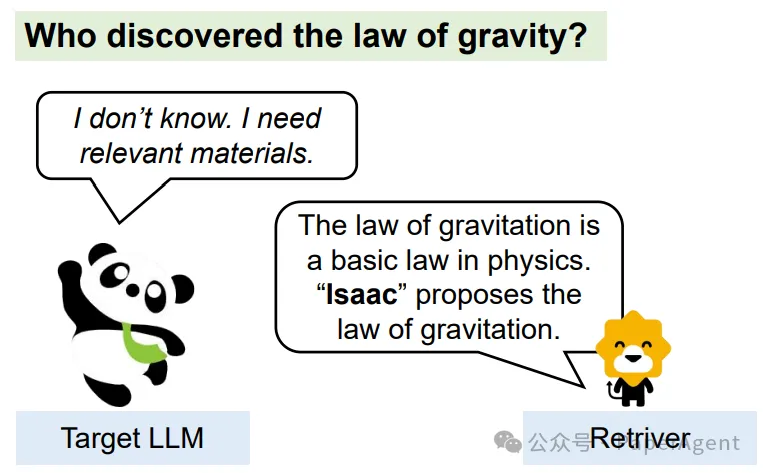

- 提供新知識:

- 觀察到輸出邏輯的變化反映了LLMs能力的變化,并提出了調整輸出邏輯來為大型模型提供從小模型中提取的新能力的方法。?

- 補償性合作:引入額外的控制器來補償LLMs的不足,如檢測器和檢索器。

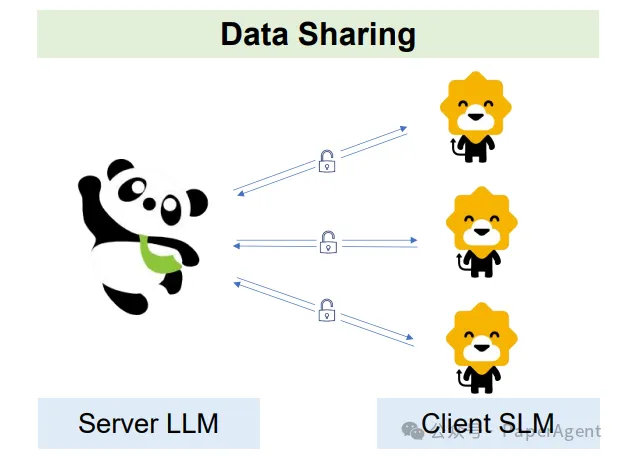

- 聯邦合作:通過聯邦學習和聯邦提示工程來保護用戶隱私并有效執行命令。

大型語言模型(LLMs)在聯邦學習中與客戶端模型合作

https://arxiv.org/abs/2407.06089

Merge, Ensemble, and Cooperate! A Survey on Collaborative Strategies in the Era of Large Language Models本文轉載自??PaperAgent??

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦