Entropix,終于找到了真正解決幻覺的方法了

最近,神秘大佬開源一個框架entropix, 2周不到收獲2.4k star。

Entropix的核心思想是通過量化模型的不確定性,來做出更多的“思考”,從而獲得更好的效果。

當大模型在預測下一個詞時,模型會為每個詞分配一個可能的概率。如果模型特別篤定的那個token的概率都很低,也就是不確定性很高的時候,熵越高。

很多時候,想減少模型的幻覺時,可能會將模型的采樣超參數如temperature設為 0。但是這樣做并不一定能提高模型不產生幻覺輸出的概率,只是迫使它對相對于其他單詞而言的一個單詞賦予更高的概率。

但是在 Entropix 和之前google的內置cot研究 驗證了,事實恰恰相反,采用貪婪解碼,反而可能會讓結果變得更壞。

google的研究,前不久發的推文:??cot-decoding,谷歌把o1的底褲都開源了??

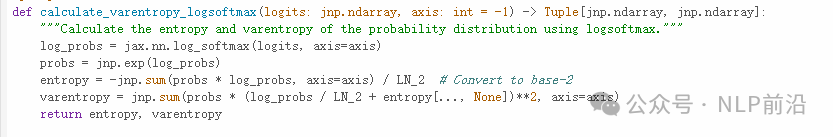

那如何衡量結果不確定性呢?在這個google的研究中使用的是top1和top2的token概率的差值。在Entropix中用到的是entropy和varentropy,varentropy是衡量entropy的方差的,提供了一個關于跨不同token不確定性的度量。

低varentropy意味著模型的不確定性在token間是恒定的,高則意味著token間不確定性很大。

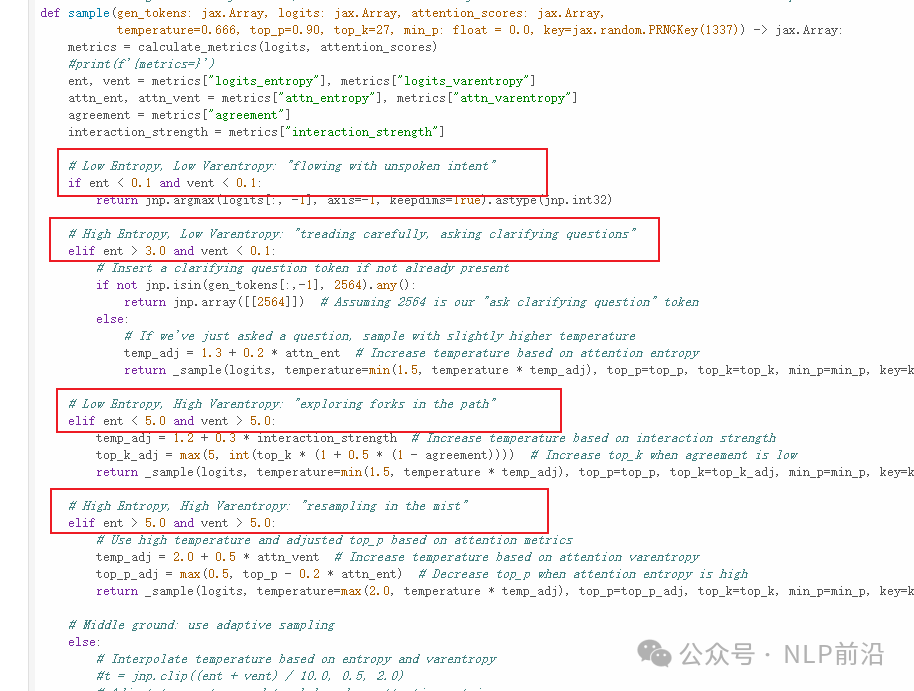

Entropix 方法中的采樣過程如下,核心思想是根據模型的不確定性調整其選擇策略:

- 當模型有信心(低entropy和低varentropy)時,它就會按常規進行。

- 當模型不確定(高entropy和/或高varentropy)時,它會探索替代標記或推理路徑。

這種自適應方法是在模擬思維鏈過程,當模型不確定時,它會“更努力的思考”,從而可能產生更準確連貫的輸出。

本文轉載自 ??NLP前沿??,作者: 熱愛AI的

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦