LLM訓練的隱秘危機:1%的合成數據或致模型崩潰 | 大模型的"內心戲":LLM比你想象的更聰明,卻在"裝傻"?

1、LLM訓練的隱秘危機:1%的合成數據或致模型崩潰

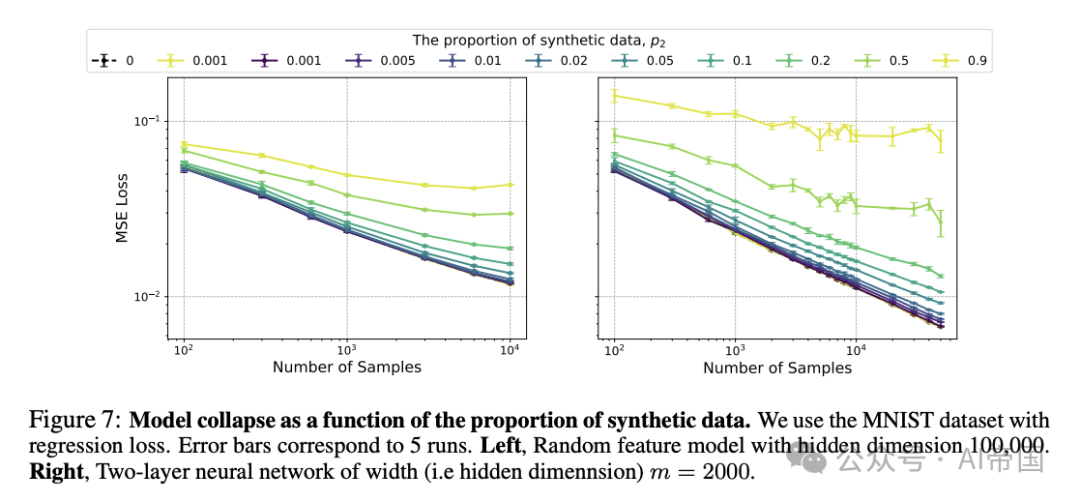

在LLM快速發展的今天,一個令人擔憂的現象正悄然出現——模型崩潰。研究發現,即便在訓練數據中僅包含1%的合成數據,也可能導致LLM模型性能嚴重下降,無論如何增加訓練數據量都無法提升效果。

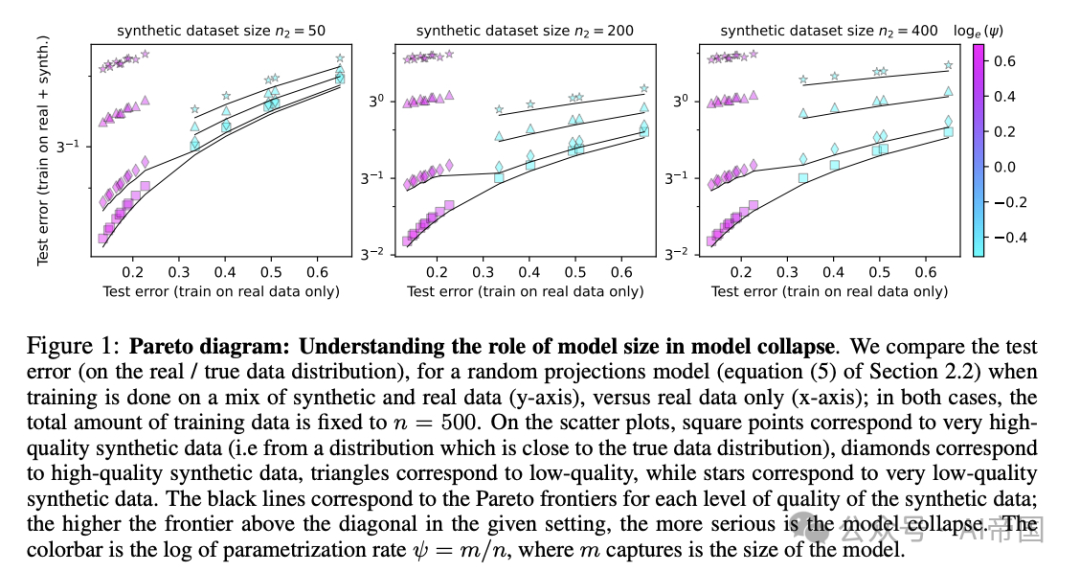

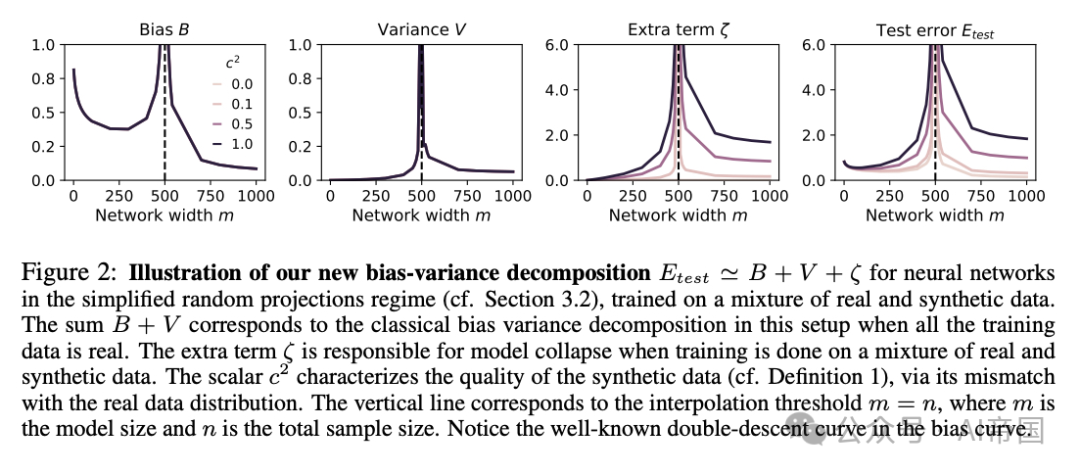

更令人意外的是,增加模型規模這一當前廣泛采用的方法,非但不能緩解問題,反而可能加劇模型崩潰。研究團隊通過理論分析和實驗證明,在某些情況下,更大的模型可能會放大這種崩潰效應。這一發現對目前流行的"越大越好"的LLM訓練理念提出了挑戰。

有趣的是,研究還指出,當模型達到"插值閾值"后(這個閾值對于超大數據集可能非常高),增大模型規模可能會在一定程度上緩解崩潰現象,盡管無法完全避免。這一理論預測在語言模型和圖像處理神經網絡的實驗中得到了驗證。

這項研究為LLM領域敲響了警鐘:我們需要重新審視數據質量對模型訓練的影響,特別是在合成數據日益普及的今天。它也為未來LLM的設計和訓練提供了新的思路,提醒我們在追求更大規模的同時,也要關注數據的真實性和代表性。在LLM競賽日益激烈的今天,這份研究無疑為從業者們提供了寶貴的見解。

論文標題:Strong Model Collapse

論文鏈接:??https://arxiv.org/abs/2410.04840??

2、大語言模型的"內心戲":LLM比你想象的更聰明,卻在"裝傻"?

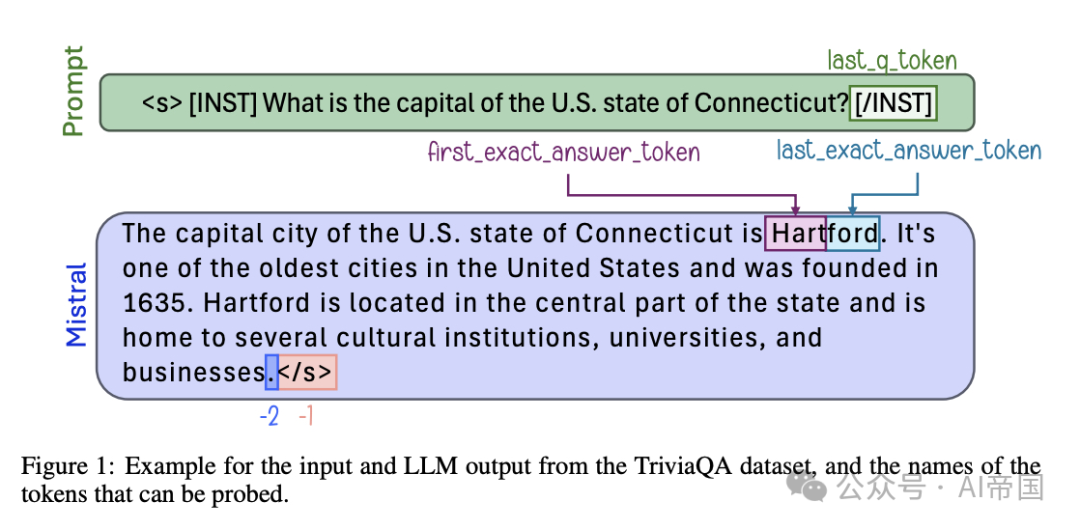

最新研究揭示,大語言模型(LLMs)可能比我們想象的更聰明,但它們似乎在"裝傻"。即使在LLM產生錯誤或"幻覺"時,其內部表征仍然編碼了大量關于真實性的信息。這一發現顛覆了我們對LLM錯誤的傳統認知。

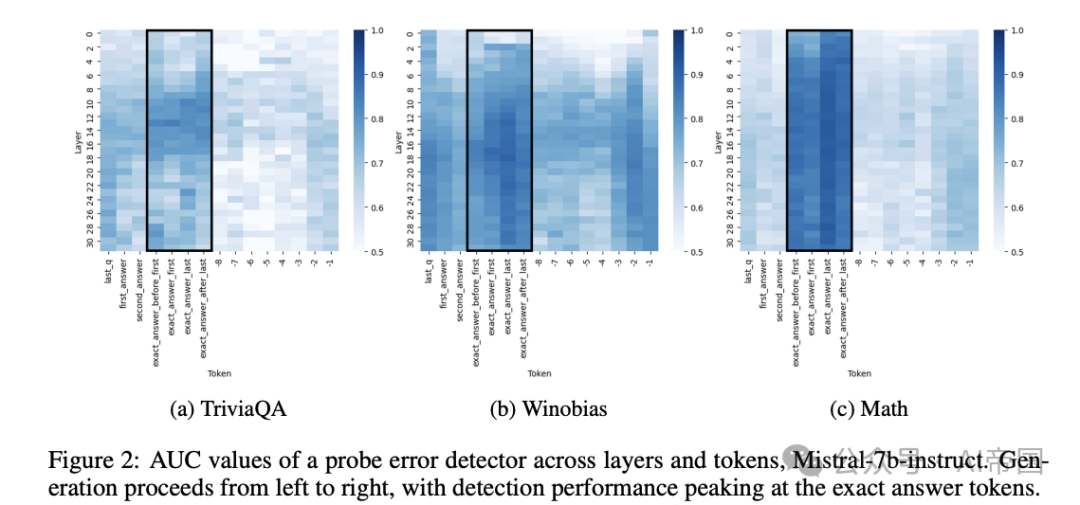

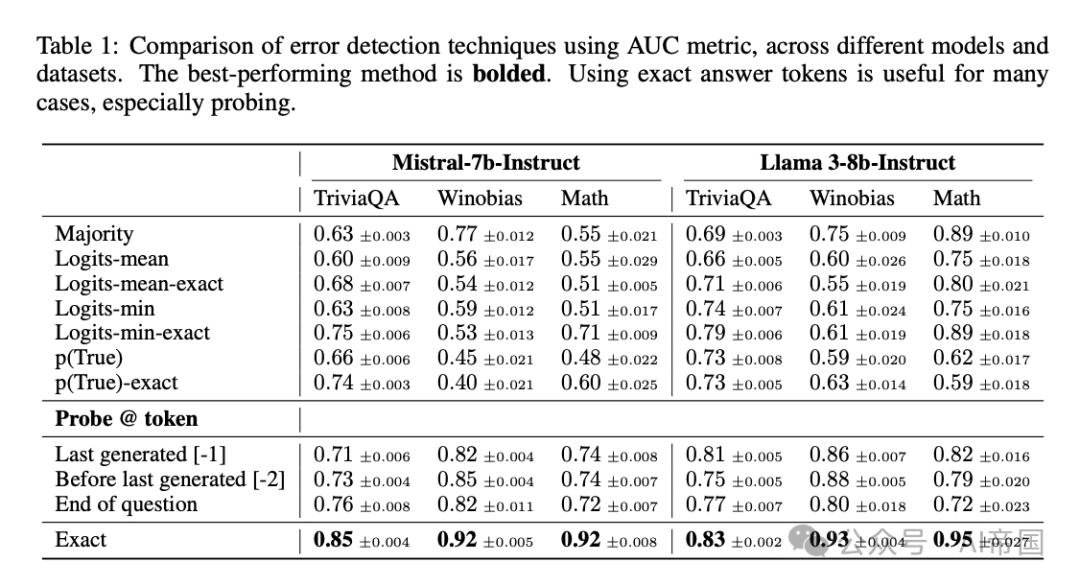

研究團隊通過一系列實驗發現,LLM的真實性信息集中在特定的詞元上,利用這一特性可以顯著提高錯誤檢測性能。然而,這種錯誤檢測器難以在不同數據集間泛化,暗示真實性編碼并非普遍性的,而是多方面的。更令人驚訝的是,研究發現LLM的內部表征與外部行為之間存在明顯差異:模型可能在內部編碼了正確答案,卻一致地生成錯誤回答。

這項研究不僅深化了我們對LLM錯誤的理解,還為未來的錯誤分析和緩解策略指明了方向。它揭示了LLM的內部"知識"可能比其外部表現更豐富,這一發現可能徹底改變我們設計和優化LLM系統的方式。

面對這個LLM似乎在"明知故犯"的現象,我們不禁要問:如何才能充分發揮LLM的潛力,讓它們"知行合一"?這個問題不僅關乎技術,更涉及到LLM的可信度和未來發展方向。隨著研究的深入,我們或許能找到讓LLM更好地展現其內在智慧的方法,推動人工智能向更可靠、更透明的方向發展。

論文標題:LLMs Know More Than They Show: On the Intrinsic Representation of LLM Hallucinations

論文鏈接:??https://arxiv.org/abs/2410.02707??

本文轉載自 ??AI帝國??,作者: 無影寺