人人都是音樂(lè)家!中科大&科大訊飛重磅開(kāi)源OpenMusic:音樂(lè)生成更高質(zhì)量,更有樂(lè)感 精華

文章鏈接:https://arxiv.org/pdf/2405.15863

代碼鏈接:https://github.com/ivcylc/qa-mdt

Huggingface鏈接:https://huggingface.co/spaces/jadechoghari/OpenMusic

Demo鏈接:https://qa-mdt.github.io/ (chatgpt * 30, musiccaps * 30)

亮點(diǎn)直擊

- 提出了一種質(zhì)量感知訓(xùn)練范式,使模型在訓(xùn)練過(guò)程中能夠感知數(shù)據(jù)集的質(zhì)量,從而在音樂(lè)性(美學(xué)角度)和音頻質(zhì)量方面實(shí)現(xiàn)卓越的音樂(lè)生成效果。

- 創(chuàng)新性地將masked擴(kuò)散Transformer引入到音樂(lè)信號(hào)中,展示了其在建模音樂(lè)潛在空間上的獨(dú)特效果,以及其在質(zhì)量控制感知方面的卓越能力,從而進(jìn)一步提升了生成音樂(lè)的質(zhì)量和音樂(lè)性。

- 解決了大型音樂(lè)數(shù)據(jù)集中文本與音頻低相關(guān)性的問(wèn)題,有效提高了文本對(duì)齊度和生成的多樣性。

背景

近年來(lái),基于擴(kuò)散的文本到音樂(lè)(TTM)生成方法逐漸受到重視,提供了一種創(chuàng)新的方法,將文本描述合成音樂(lè)內(nèi)容。要在這一生成過(guò)程中實(shí)現(xiàn)高準(zhǔn)確性和多樣性,必須依賴(lài)大量高質(zhì)量的數(shù)據(jù),包括高保真音頻波形和詳細(xì)的文本描述,但這些通常僅占現(xiàn)有數(shù)據(jù)集中的一小部分。在開(kāi)源數(shù)據(jù)集中,低質(zhì)量音樂(lè)波形、標(biāo)簽錯(cuò)誤、弱標(biāo)簽和無(wú)標(biāo)簽數(shù)據(jù)等問(wèn)題顯著阻礙了音樂(lè)生成模型的發(fā)展。為了解決這些挑戰(zhàn),今天和大家分享一種全新的高質(zhì)量音樂(lè)生成范式,該范式結(jié)合了質(zhì)量感知訓(xùn)練策略,使生成模型能夠在訓(xùn)練過(guò)程中辨別輸入音樂(lè)波形的質(zhì)量。利用音樂(lè)信號(hào)的獨(dú)特特性,首先針對(duì)TTM任務(wù)調(diào)整并實(shí)現(xiàn)了一個(gè)掩碼擴(kuò)散Transformer(MDT)模型,展現(xiàn)出其在質(zhì)量控制和音樂(lè)性增強(qiáng)方面的獨(dú)特能力。此外,還通過(guò)字幕優(yōu)化數(shù)據(jù)處理方法解決了TTM中低質(zhì)量字幕的問(wèn)題。實(shí)驗(yàn)結(jié)果表明,在MusicCaps和Song-Describer數(shù)據(jù)集上取得了當(dāng)前最先進(jìn)的(SOTA)性能。

當(dāng)前音樂(lè)生成(音效生成)領(lǐng)域的問(wèn)題為質(zhì)量低,具體來(lái)說(shuō)分為三個(gè)方面:

- 大部分的開(kāi)源數(shù)據(jù)集音質(zhì)低(FMA,AudioSet,MSD),旋律雜亂

- 音樂(lè)性(美學(xué)角度)差

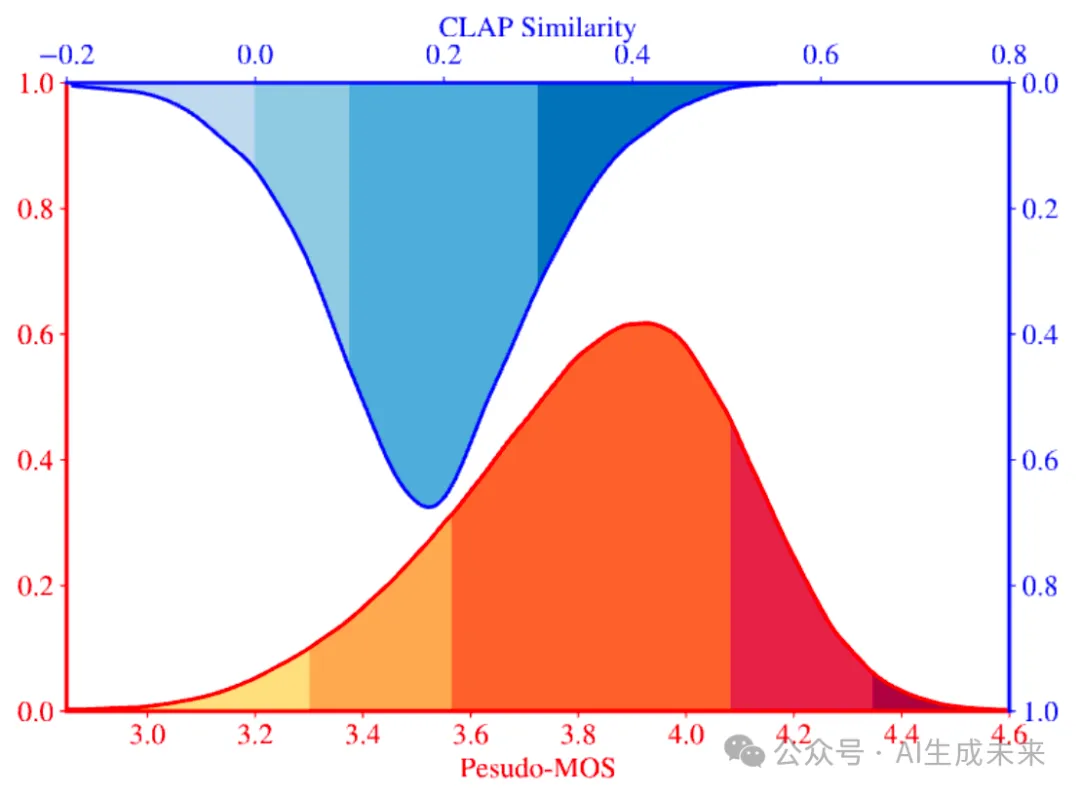

- 文本對(duì)齊度低,大多數(shù)的音頻處于少標(biāo)簽,弱標(biāo)簽,錯(cuò)標(biāo)簽。其中, 第1點(diǎn)可以由下圖藍(lán)色分布CLAP分?jǐn)?shù)表征,2,3點(diǎn)可以由數(shù)據(jù)集的平均MOS分布表征(顏色由 分割)

創(chuàng)新方法及思路

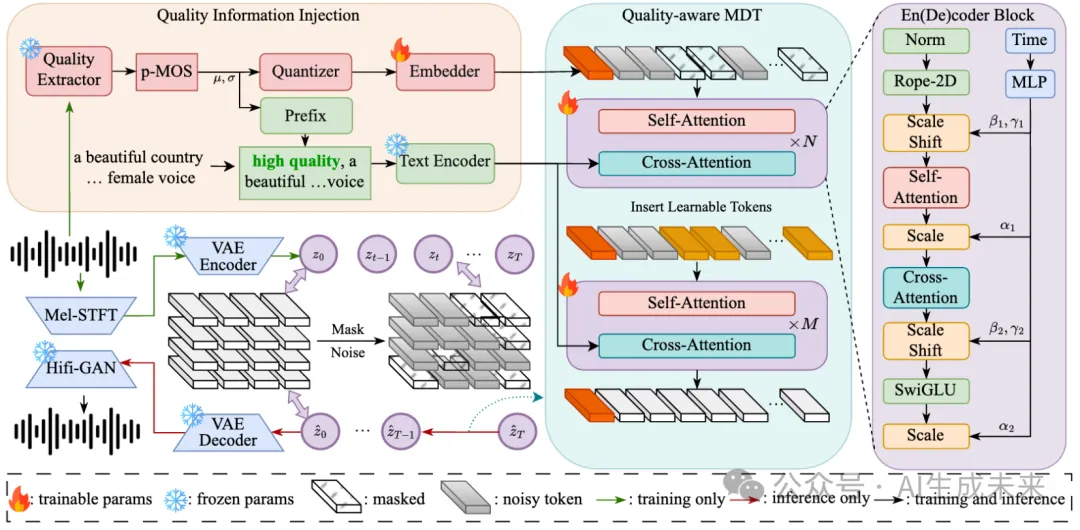

質(zhì)量信息注入

解決: 引入質(zhì)量感知訓(xùn)練策略。采用主觀數(shù)據(jù)集中的MOS分訓(xùn)練出的質(zhì)量評(píng)分模型,在訓(xùn)練過(guò)程中注入(偽MOS分)音頻質(zhì)量信息。

兩種注入方法:

- 利用text encoder對(duì)分級(jí)后的 low quality, medium quality, high quality 質(zhì)量文本進(jìn)行cross attn嵌入 【粗粒度,適配unet架構(gòu)和transformer類(lèi)架構(gòu)】

- 參考U-ViT內(nèi) 時(shí)間信息和label信息的融入方式,以量化(閾值由 決定)后轉(zhuǎn)換為quality embedding, 以token 形式進(jìn)行控制注入,【細(xì)粒度,并且只適配transformer類(lèi)架構(gòu)】

結(jié)論:質(zhì)量感知策略允許了在推理階段以高質(zhì)量文本和質(zhì)量token進(jìn)行引導(dǎo),從而生成顯著高于訓(xùn)練集平均質(zhì)量的音頻。

以類(lèi)似解耦的方式在訓(xùn)練中感知音頻的質(zhì)量(類(lèi)似TTS中分離出音色訓(xùn)練),從而更好地促進(jìn)了模型的訓(xùn)練(大幅降低FAD,KL,并提升IS,REL,CLAP等指標(biāo))。

我們還發(fā)現(xiàn),粗粒度文本控制和細(xì)粒度token控制相結(jié)合,更有助于模型訓(xùn)練中解耦,感知,并控制更高質(zhì)量音頻的生成,從而解決訓(xùn)練數(shù)據(jù)集影響的問(wèn)題

質(zhì)量感知型 masked擴(kuò)散Transformer

解決:從音樂(lè)性建模角度,我們發(fā)現(xiàn) U-ViT/DiT 類(lèi)架構(gòu)對(duì)頻譜隱空間建模也具有圖像上表達(dá)的scale ability,并能更好建模諧波,音色等方面(反應(yīng)在主觀評(píng)分)

優(yōu)化:

- 對(duì)頻譜切片而言,此類(lèi)結(jié)構(gòu)的收斂速度慢。消融數(shù)據(jù)集中,20w步時(shí)依然不能很好控制收斂,推測(cè)來(lái)源于時(shí)域/頻域相關(guān)性弱。故在預(yù)訓(xùn)練階段加入掩碼,加速訓(xùn)練速度和頻譜關(guān)聯(lián)性。微調(diào)階段以高質(zhì)量數(shù)據(jù)進(jìn)一步強(qiáng)化模型(5W步就有收斂跡象)。

- 相比于U-Net,transformer based架構(gòu)對(duì)text encoder的質(zhì)量信息感知能力增強(qiáng),并且U-ViT 式 token 質(zhì)量融入策略顯著有效進(jìn)一步提升質(zhì)量并降低客觀指標(biāo)

- 圖像中切塊未考慮 overlap,探究了overlap策略在合成中的作用(大幅降低FAD,但在主觀聽(tīng)感上有trade off)

優(yōu)化音樂(lè)標(biāo)注描述

解決:首次在音樂(lè)生成領(lǐng)域使用預(yù)訓(xùn)練標(biāo)注模型(LP-Musiccaps)進(jìn)行大規(guī)模標(biāo)注優(yōu)化:

- 考慮到標(biāo)注模型的不充分訓(xùn)練導(dǎo)致錯(cuò)標(biāo),以CLAP文本-音頻分?jǐn)?shù)+閾值篩選低分?jǐn)?shù)據(jù)

- 考慮到原始標(biāo)注中有些詞(例如說(shuō)American,R&B等標(biāo)注器不一定能標(biāo)注出的詞)。使用CLAP分?jǐn)?shù)過(guò)濾出生成的與原始的文本相似度低低數(shù)據(jù),利用語(yǔ)言模型 融合原始標(biāo)注中有用信息。

實(shí)驗(yàn)

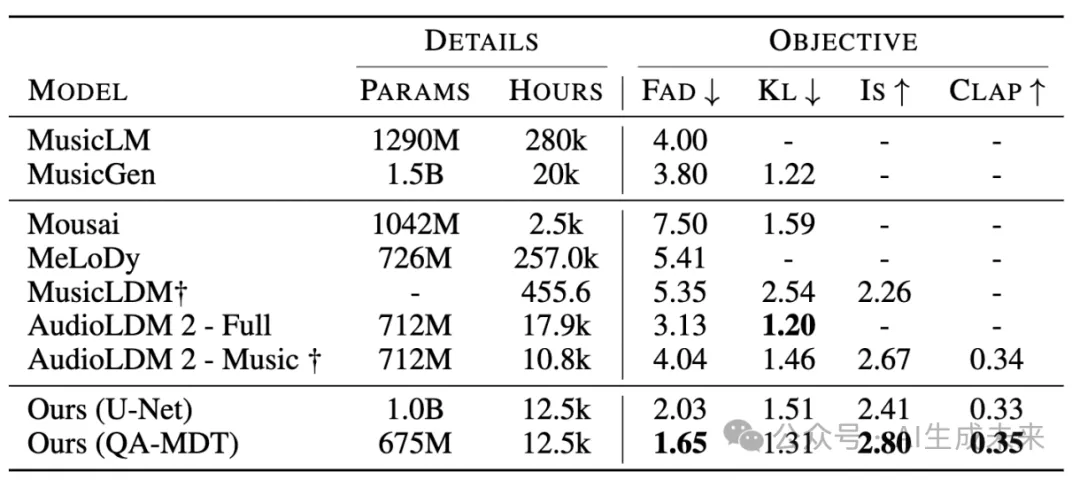

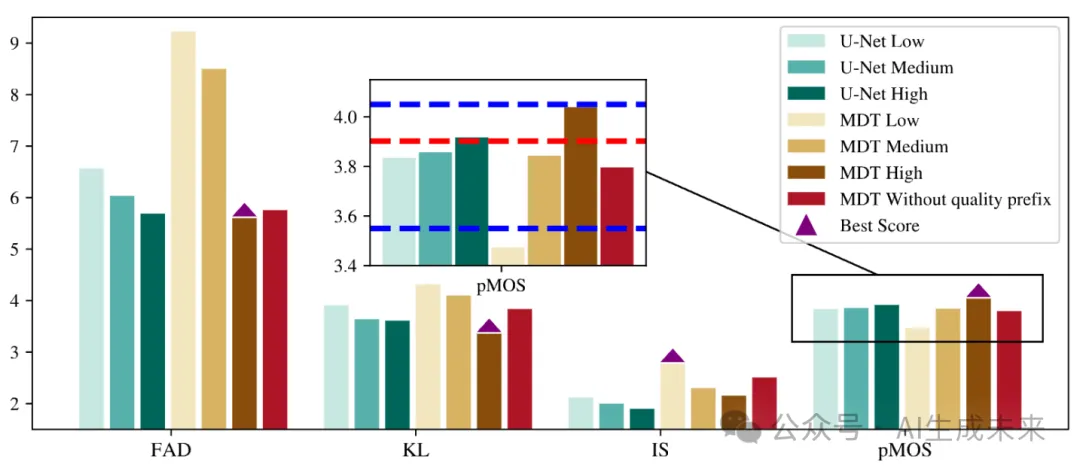

總體對(duì)比與,對(duì)比U-net架構(gòu)和transformer based架構(gòu)

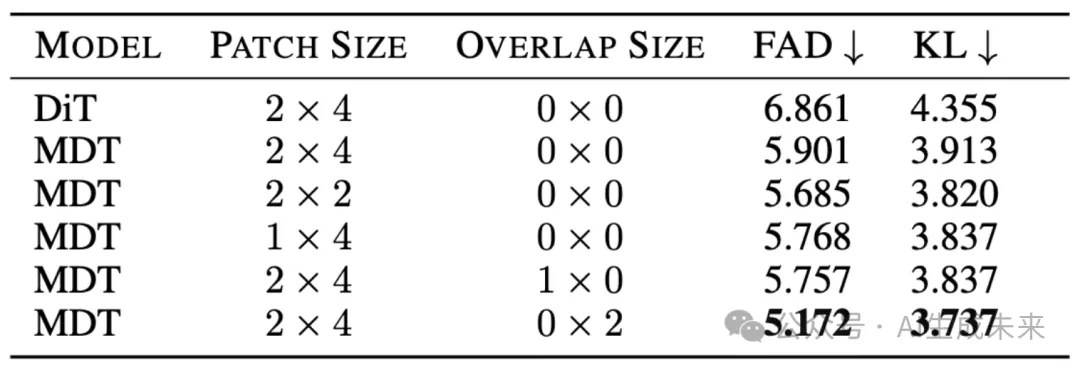

對(duì)比overlap策略和patch size

質(zhì)量感知消融

此圖證明了相比于無(wú)質(zhì)量感知,大幅提升了生成質(zhì)量和客觀指標(biāo)。并且,MDT(我們的架構(gòu))比 U-Net 在文本質(zhì)量控制感知上的獨(dú)特優(yōu)勢(shì)(生成質(zhì)量更高,總體客觀指標(biāo)更好)

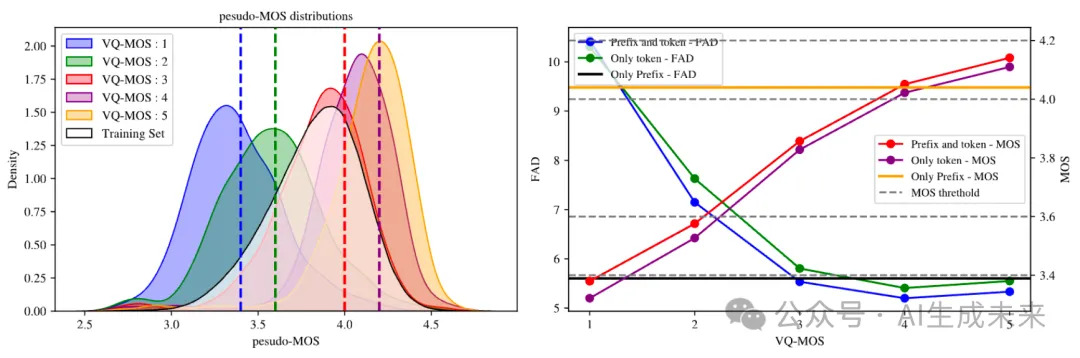

左圖展示了 token as control 的準(zhǔn)確感知控制生成能力,生成的高質(zhì)量數(shù)據(jù)(黃色區(qū)域)顯著高于訓(xùn)練集MOS分。

右圖展示了文本質(zhì)量控制和token質(zhì)量控制的結(jié)合效果與單純token和文本控制的對(duì)比。

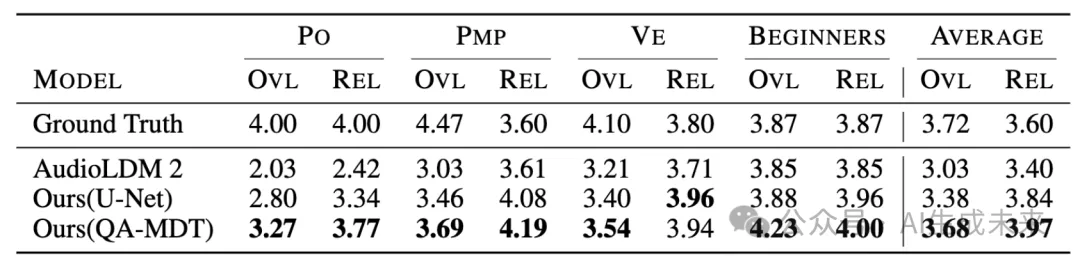

主觀評(píng)測(cè)結(jié)果

- PO:產(chǎn)品運(yùn)營(yíng)

- PMP:專(zhuān)業(yè)音樂(lè)制作人

- VE:視頻編輯人

- BEGINNERS:不懂音樂(lè)的小白

各個(gè)人的評(píng)分下,均有優(yōu)勢(shì)。

結(jié)論與展望

本研究識(shí)別出大規(guī)模音頻質(zhì)量不均和文本標(biāo)注未對(duì)齊所帶來(lái)的挑戰(zhàn),這些挑戰(zhàn)阻礙了基于擴(kuò)散的文本到音樂(lè)(TTM)生成的發(fā)展。通過(guò)采用基于p-MOS的新型質(zhì)量感知學(xué)習(xí)方法,以及以masked擴(kuò)散Transformer作為擴(kuò)散過(guò)程的主干,在音樂(lè)生成中實(shí)現(xiàn)了更高的生成質(zhì)量和音樂(lè)性。

本文轉(zhuǎn)自 AI生成未來(lái) ,作者:AI生成未來(lái)