百萬級高質(zhì)量視頻數(shù)據(jù)集發(fā)布,登頂抱抱臉數(shù)據(jù)集排行榜,中科大&上海AI Lab等出品

中科大、上海AI實驗室等組成的ShareGPT4V團隊,推出了新的視頻數(shù)據(jù)集,登頂HuggingFace排行榜!

數(shù)據(jù)集涵蓋了3000小時的高質(zhì)量視頻數(shù)據(jù),而且還配有高質(zhì)量的文字描述。

利用這一數(shù)據(jù)集,團隊重新測試了北大的Open-Sora-Plan,發(fā)現(xiàn)視頻生成質(zhì)量獲得了顯著提升。

作者認為,無論是視頻理解還是視頻生成任務,都離不開詳細高質(zhì)量的視頻-字幕數(shù)據(jù)。

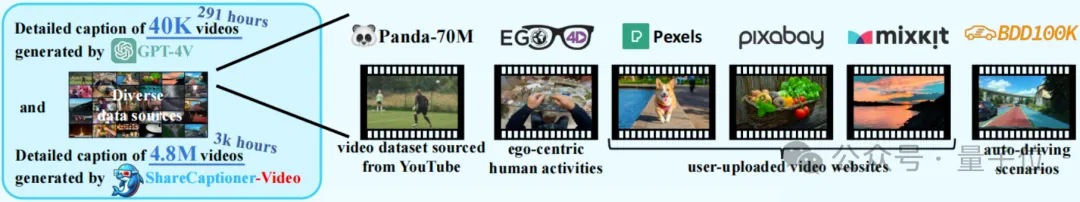

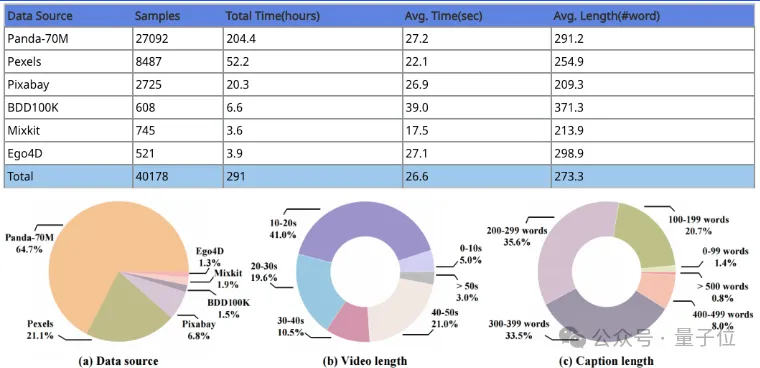

利用GPT-4v的視覺能力,團隊得到了4萬條(共291小時)帶有標注的視頻數(shù)據(jù),生成的描述包含了豐富的世界知識。

在此基礎之上,團隊得到了能自動生成視頻描述的模型,從而將數(shù)據(jù)規(guī)模拓展到了480萬條、近3000小時。

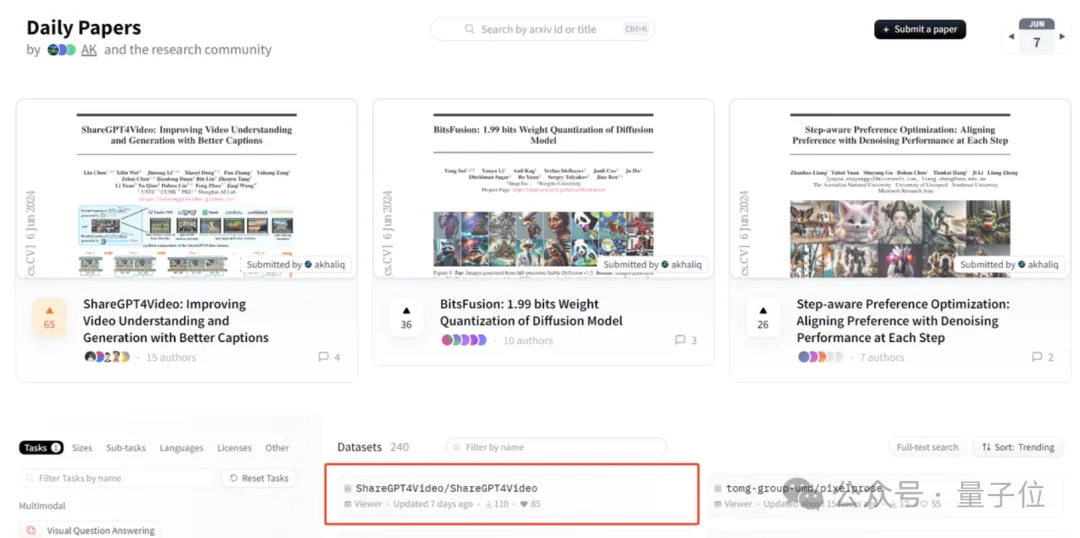

目前該項目已開源,論文登上了6月7日的抱抱臉Daily Papers榜首,同時數(shù)據(jù)集本身也成功登頂VQA類數(shù)據(jù)集榜單。

為視頻生成高質(zhì)量描述

視頻多模態(tài)領域中,閉源商業(yè)模型一直處于斷層領先的地位,而研究者們認為,這種領先優(yōu)勢,離不開詳細高質(zhì)量的視頻-字幕數(shù)據(jù)。

因此,該研究團隊致力于為視頻獲取大量詳細而精確的字幕,提升大型視頻語言模型的視頻理解能力和文生視頻模型的視頻生成能力。

經(jīng)過分析,研究者們認為,用現(xiàn)有的閉源模型生成高質(zhì)量視頻描述的挑戰(zhàn)有三個方面——

- 一是清晰地理解幀間的時序變化;

- 二是詳細準確地描述幀內(nèi)內(nèi)容;

- 另外,對任意長度視頻的可擴展性也是一大難點。

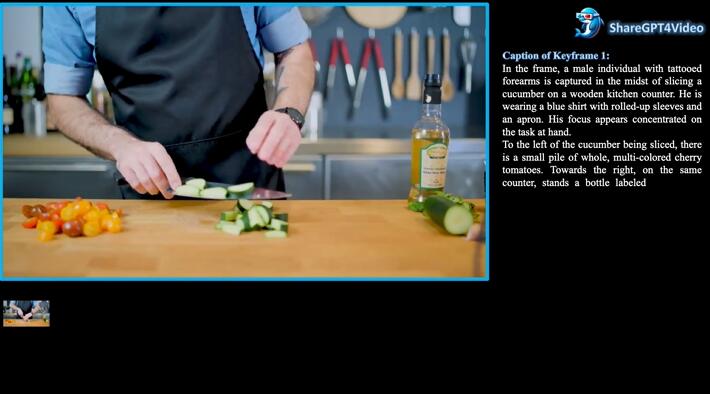

為此,研究者們精心設計了一種描述策略,先來看看它的效果。

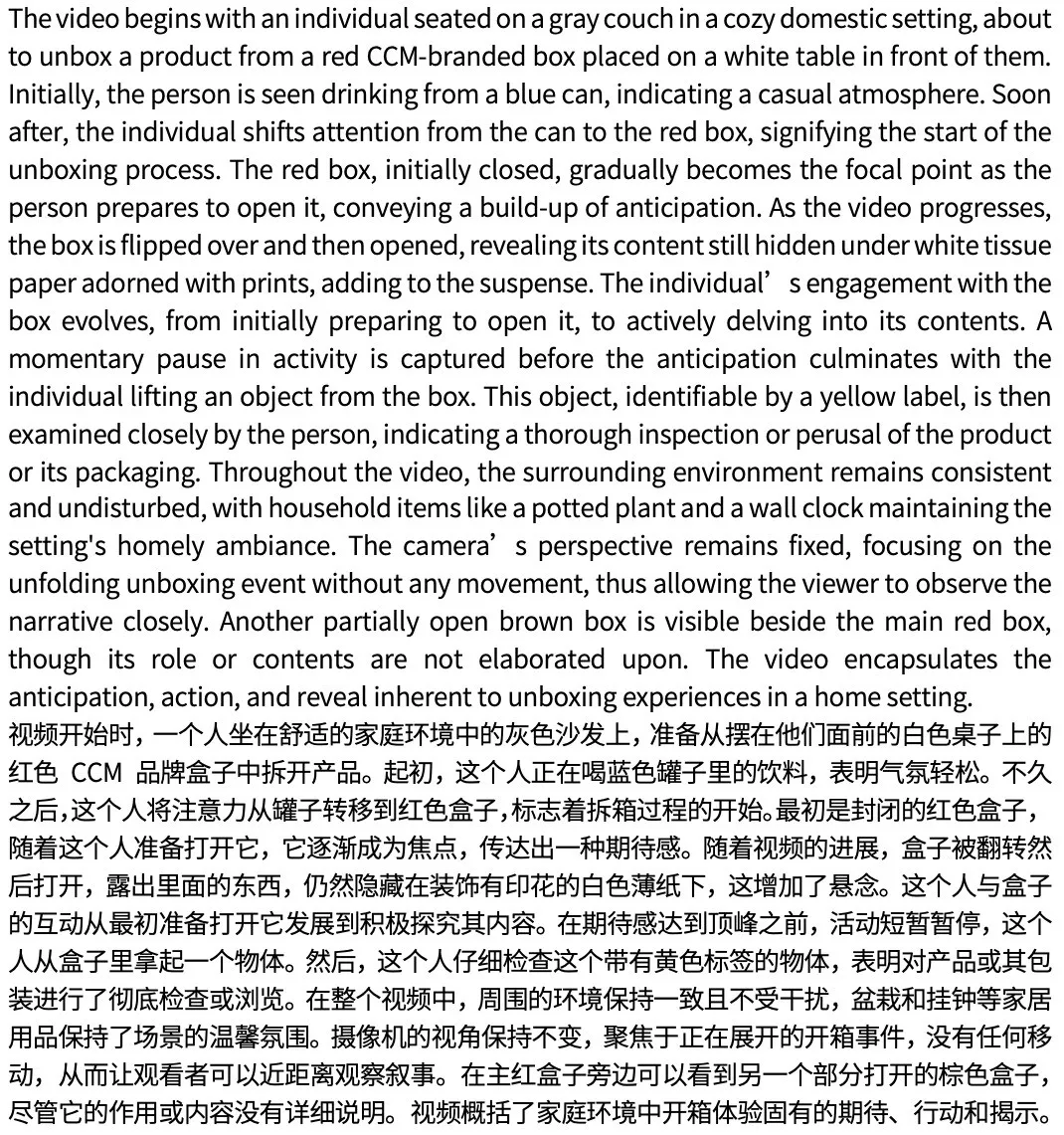

針對這段16秒的視頻,作者得到了以下的描述(共270詞):

△原文為英文,中文為機翻,僅供參考

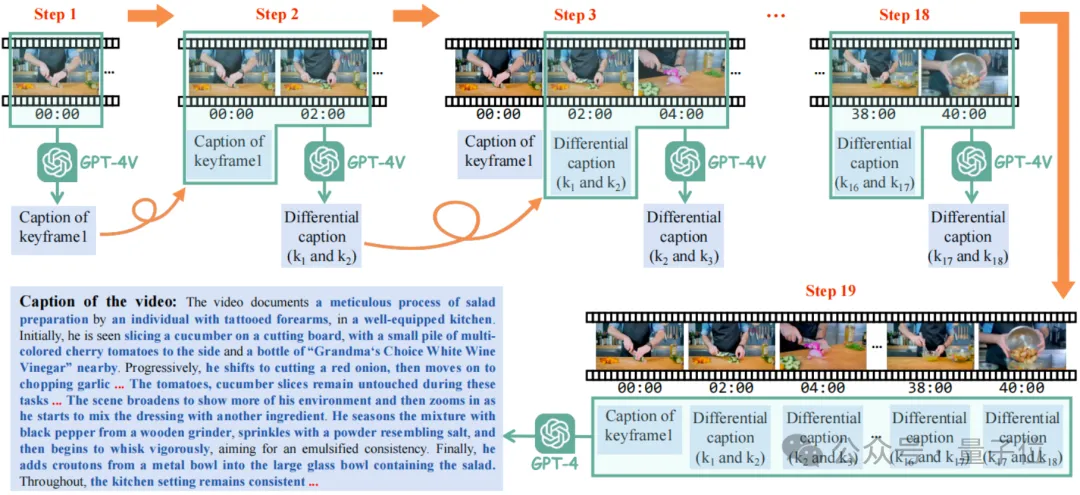

這種策略叫做差分滑窗視頻描述(Differential Sliding-Window Captioning, DiffSW),可以穩(wěn)定且高效地為任意分辨率、寬高比和長度的視頻生成高質(zhì)量描述。

具體而言,研究者們每次送入GPT-4V的輸入是當前關鍵幀、上一關鍵幀,以及上一關鍵幀對應的差分描述。

這樣做的目的是讓GPT-4V通過觀察兩幀之間的時間與空間變化,總結出當前幀相對于上一幀的重要空間、時序變化,也就是當前幀與上一幀對應的差分描述。

最終,所有差分描述會連同時間戳一起送入GPT4中,從而總結出最終的關于整個視頻的高質(zhì)量字幕。

具體的操作過程,可以通過下面這段視頻感受一下:

通過這一方法,研究者們推出了大型“視頻-文本描述”數(shù)據(jù)集——ShareGPT4Video數(shù)據(jù)集,其中包括4萬條(共291小時)由GPT-4V標注的視頻數(shù)據(jù)。

這些數(shù)據(jù)涵蓋了廣泛的類別,生成的描述包含豐富的世界知識、對象屬性、攝像機運動,以及詳細和精確的事件時間描述。

描述文本的字數(shù)主要在200-400之間,提供了豐富的時間信息,可以很好地完成視頻理解和生成任務。

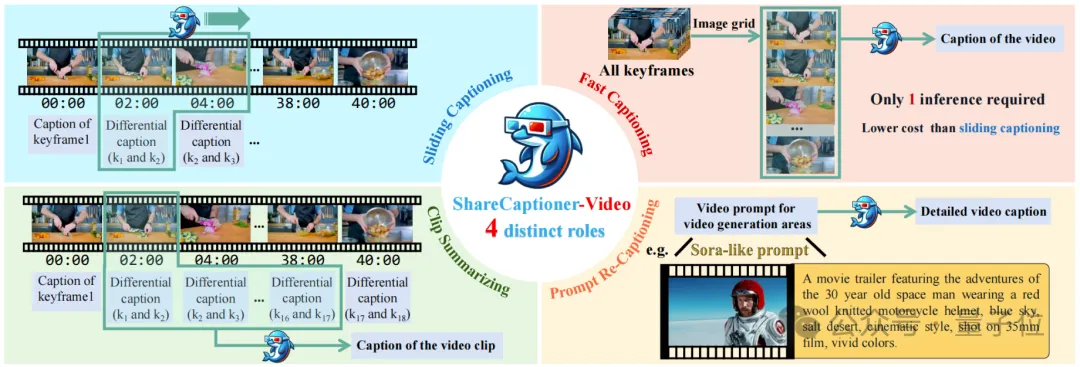

為了進一步擴大數(shù)據(jù)集規(guī)模,以及便于開源社區(qū)在自有數(shù)據(jù)上的使用,在ShareGPT4Video數(shù)據(jù)集的基礎上,研究者們進一步設計開發(fā)了ShareCaptioner-Video,一個能夠有效地為任意視頻生成高質(zhì)量描述的多功能多模態(tài)大模型。

ShareCaptioner-Video是一款四合一的特殊視頻描述模型,具有滑動窗口生成視頻描述、快速生成視頻描述、視頻片段對應描述整合,以及提示詞生成詳細描述四種功能。

具體而言,滑窗視頻描述功能可以擔任GPT-4V收集標注數(shù)據(jù)中的全部角色,并且通過滑窗的方式來產(chǎn)生差分描述并匯總出最終的字幕。

快速視頻描述功能則是把所有關鍵幀沿豎直方向拼成一張長圖一次性產(chǎn)生最終的字幕,在略微犧牲性能的情況下大幅提升標注速度。

視頻片段總結功能則可以在對完整視頻進行一次滑窗描述后,對其中任意的視頻片段直接總結出字幕而不需要再次進行滑窗描述過程。

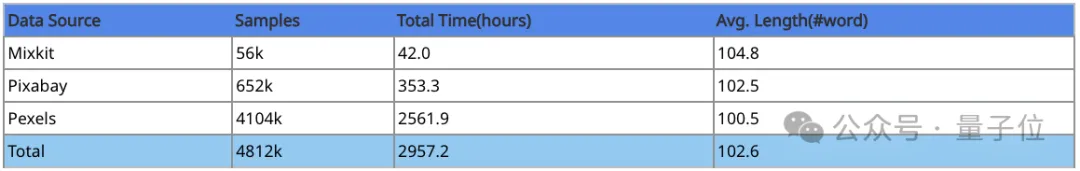

在得到了優(yōu)異的視頻描述模型后,研究者們用它進一步標注了480萬條,總時長3000小時的豐富的視頻數(shù)據(jù)。

這些視頻具有較高的美學評分以及較少的轉場效果,可以進一步為視頻生成任務服務,其具體構成如下:

讓視頻理解和視頻生成模型更好

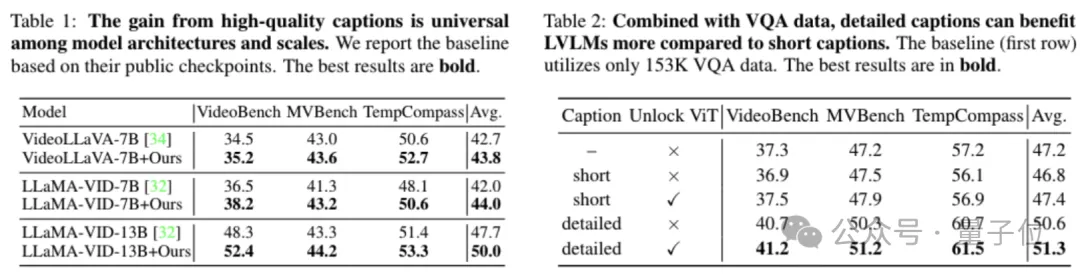

在視頻理解方面,研究者們首先通過簡單的等量替換實驗,驗證了ShareGPT4Video數(shù)據(jù)集在幾種當前LVLM架構上的有效性。

研究者們把VideoChatGPT數(shù)據(jù)集中的100K視頻訓練數(shù)據(jù)中的與詳細caption相關的28K數(shù)據(jù),等量替換成了ShareGPT4Video數(shù)據(jù)集中的子集。

結果立竿見影,從下表可以看到,通過簡單的數(shù)據(jù)替換,僅僅是字幕數(shù)據(jù)質(zhì)量上的提升,便可以一致地為不同架構、不同規(guī)模的視頻理解多模態(tài)大模型帶來顯著的性能增益。

之后,研究者們自主收集了153K的視頻VQA數(shù)據(jù),并結合ShareGPT4Video數(shù)據(jù)集中與視頻理解相關的28K高質(zhì)量字幕數(shù)據(jù),提出了新的LVLM ShareGPT4Video-8B。

僅需8卡以及5個小時的訓練開銷,該模型就能在多項Benchmark上取得優(yōu)異的結果。

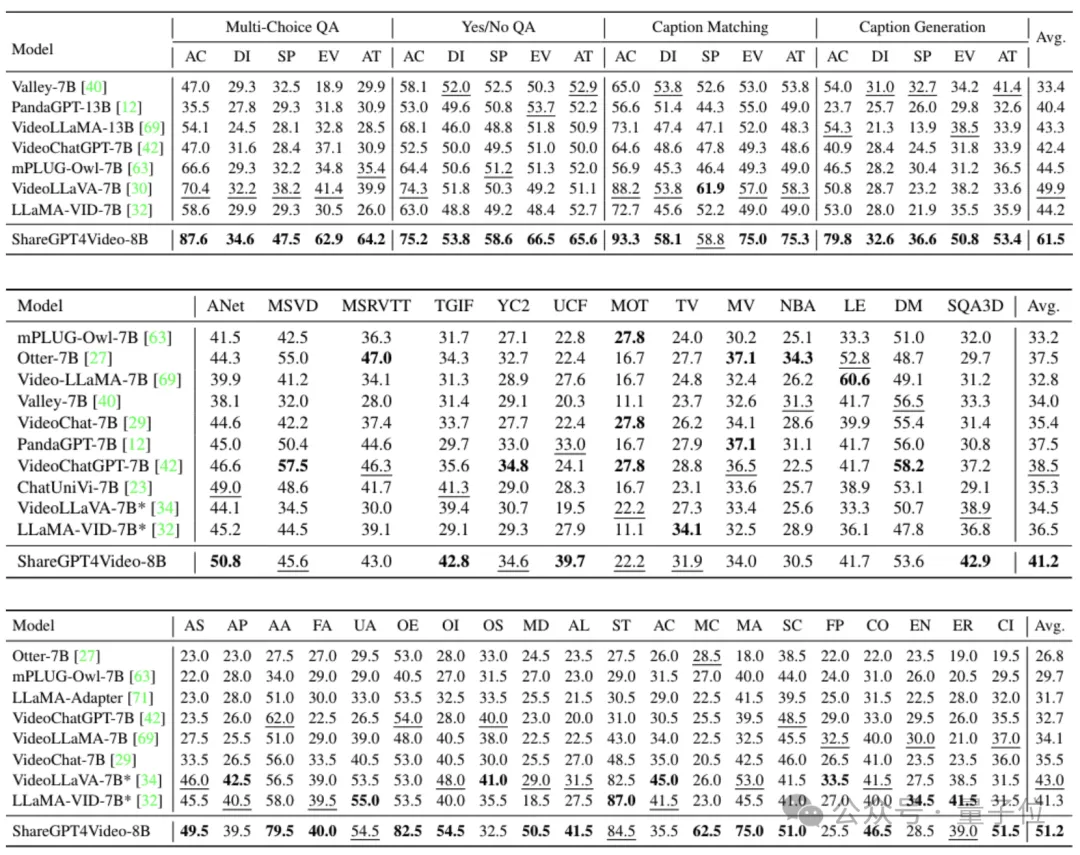

下圖中,從上到下依次為TempCompass、 VideoBench和MVBench上的性能對比。

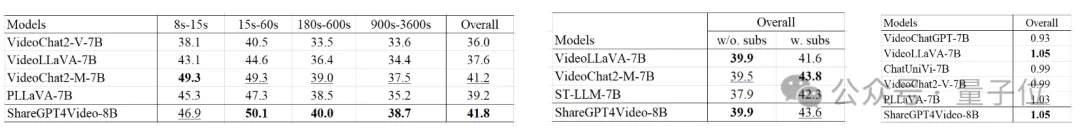

即使是在最近新出現(xiàn)的幾個視頻理解基準上,ShareGPT4Video-8B也可以在7B參數(shù)規(guī)模上一致地展現(xiàn)出具有競爭力的性能。

下圖從左到右依次展示了LongVideoBench、Video-MME與MMBench-Video數(shù)據(jù)集上的性能對比。

在視頻生成方面,研究者們基于Open-Sora-Plan項目簡單直接地驗證了詳細的字幕數(shù)據(jù)對于文生視頻模型的幫助。

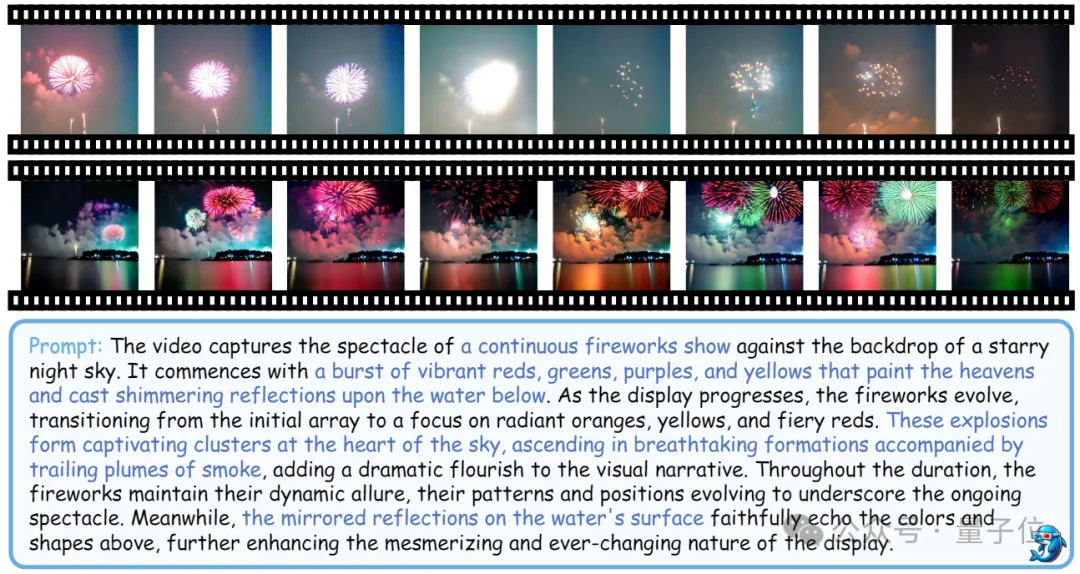

下圖中,第一行的結果是使用了短字幕數(shù)據(jù)訓練出的文生視頻模型得到的,第二行的結果是使用了ShareCaptioner-Video標注的高質(zhì)量字幕數(shù)據(jù)訓練出的文生視頻模型得到的。

可以看到,使用詳細的字幕數(shù)據(jù),可以讓文生視頻模型具備優(yōu)異的鏡頭移動控制以及語義內(nèi)容控制能力。

論文地址:

???https://arxiv.org/abs/2406.04325v1???項目主頁:

??https://ShareGPT4Video.github.io/??GitHub:

https://github.com/ShareGPT4Omni/ShareGPT4Video?

本文轉自 量子位 ,作者:量子位