超越GPT-4!LoRA技術引領大型語言模型新革命

引言:探索LoRA在大型語言模型中的應用

在人工智能領域,大型語言模型(LLMs)的發展日新月異,它們在多種任務中展示了卓越的性能。然而,這些模型通常需要大量的計算資源和內存,這限制了它們的實用性和可訪問性。為了解決這一問題,低秩適應(LoRA)技術應運而生,它通過在保持模型性能的同時減少可訓練參數的數量和內存使用,為參數高效的微調提供了一種有效的方法。

LoRA的核心思想是在大型語言模型的凍結層之間插入低秩矩陣,這些矩陣較小且易于訓練,能夠顯著減少模型調整的復雜性和成本。這種方法不僅保持了模型的靈活性,還大大降低了部署和運行大型模型所需的資源。本文將深入探討LoRA在實際應用中的表現和潛力,特別是它如何在不犧牲性能的情況下,實現對大型語言模型的高效微調。

論文概覽

標題: LoRA Land: 310 Fine-tuned LLMs that Rival GPT-4, A Technical Report

作者: Justin Zhao, Timothy Wang, Wael Abid, Geoffrey Angus, Arnav Garg, Jeffery Kinnison, Alex Sherstinsky, Piero Molino, Travis Addair, Devvret Rishi

鏈接: https://arxiv.org/pdf/2405.00732.pdf

本文通過對310個使用LoRA微調的大型語言模型(LLMs)進行綜合評估,展示了LoRA技術在提升模型性能方面的有效性。研究團隊不僅探討了LoRA微調模型在多種任務上的表現,還評估了這些模型在實際應用中的部署效率。此外,文章還詳細介紹了LoRA技術的實現細節和優化策略,為未來的研究和應用提供了寶貴的參考。

LoRA技術簡介

Low Rank Adaptation(LoRA)是一種用于大型語言模型(LLMs)的參數高效微調(PEFT)方法,近年來得到了廣泛的采用。LoRA通過在模型的凍結權重層旁增加少量的可訓練低秩矩陣,顯著減少了可訓練參數的數量,同時幾乎不增加推理時的計算負擔。這種方法不僅節省了內存使用,還能在保持與全參數微調相當的性能的同時,實現更高的計算效率。

LoRA的核心思想是在不完全解凍原始模型的情況下,通過微調少量的參數來適應下游任務。這種策略與傳統的微調方法相比,可以顯著減少對計算資源的需求,使得在資源受限的環境中部署大型語言模型成為可能。此外,LoRA的設計允許它與其他參數高效的微調技術(如Prompt-based和Adapter-based方法)結合使用,進一步提升模型的靈活性和效能。

在實際應用中,LoRA已被證明能夠有效提升模型在特定任務上的表現,例如在多個基準測試中超越了GPT-4等先進模型。通過對比不同的基模型和任務復雜性,LoRA不僅展示了其在提升模型性能方面的潛力,還揭示了其在處理特定類型任務時的優勢,特別是在那些對參數數量和計算效率要求較高的場景中。

實驗設計與數據集選擇

1. 數據集的選擇

在本研究中,我們選擇了多種數據集來評估LoRA微調方法的效果。這些數據集包括廣泛的領域知識(如MMLU)、內容審查(如Jigsaw)、SQL生成(如WikiSQL)以及GLUE基準測試。這些數據集不僅在學術界和工業界廣泛使用,而且它們的多樣性和復雜性可以充分測試LoRA微調方法在不同任務上的適應性和效果。

2. 任務類型的分類

我們將這些數據集涵蓋的任務分為五類,以便更系統地評估LoRA的效果:

- 經典NLP任務:涉及命名實體識別、數據到文本生成等。

- 知識型任務:包括多項選擇題等。

- 推理型任務:涉及邏輯和推理的多項選擇題。

- 數學問題:基于數學的文字問題。

- 內容生成:如新聞頭條生成等。

這種分類方法不僅幫助我們系統地評估LoRA在不同類型任務上的表現,還為后續的模型優化和應用提供了重要的指導。

3. 實驗設計

所有的LLMs都使用相同的訓練參數進行微調,以確保實驗結果的一致性和可比性。我們采用零或單次射擊的完成式提示,簡化了查詢過程,并盡可能減少了因提示設計差異引起的性能變異。此外,我們還特別關注模型在單一GPU上的訓練和部署效率,通過動態適配器加載技術,實現了在單一硬件上部署和服務多個LoRA微調模型的能力。

通過這種嚴謹的實驗設計和多樣化的數據集選擇,我們的研究不僅展示了LoRA在多個任務和模型上的廣泛適用性,還驗證了其在實際應用中的高效性和經濟效益。

LoRA微調的效果分析

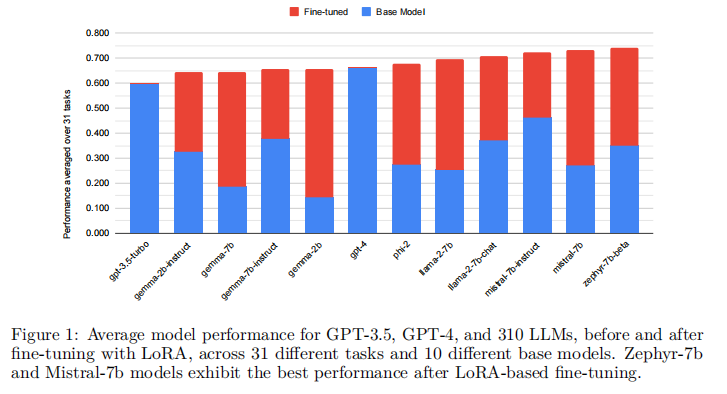

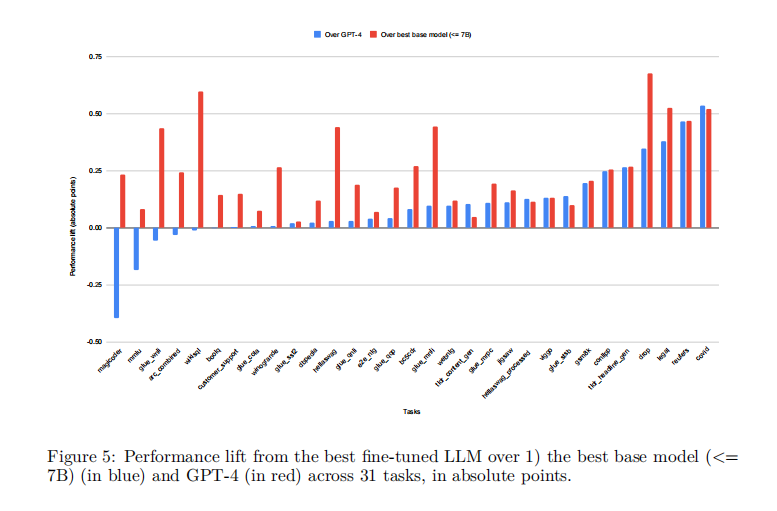

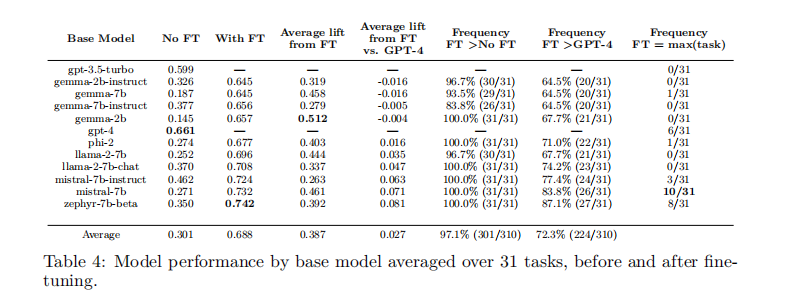

在對大型語言模型(LLMs)進行微調的過程中,低秩適應(LoRA)方法已被廣泛采用,因為它在減少可訓練參數數量和內存使用的同時,能夠達到與全面微調相媲美的性能。通過對310個使用LoRA微調的模型進行評估,我們發現這些模型在多種任務上的表現普遍優于基礎模型。具體來說,使用4位LoRA微調的模型平均比基礎模型高出34分,比GPT-4高出10分。

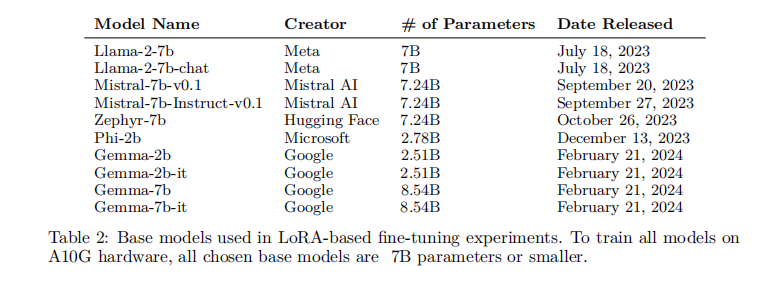

我們的實驗涵蓋了10種基礎模型和31種任務,總計310個LLM經過LoRA微調。這些模型在相同的訓練參數下進行微調,并使用簡單的單次提示進行查詢,以確保評估的一致性。通過這種標準化的比較框架,我們能夠準確地評估不同基礎模型在經過LoRA微調后的內在能力。

在所有任務中,經過LoRA微調的模型平均性能(0.756)顯著高于GPT-4(0.661)。這一發現不僅驗證了LoRA微調的有效性,也突顯了在特定任務上使用專門化的小模型而非單一的通用大模型的優勢。

LoRAX服務器:多模型高效服務

LoRAX是一個開源的多LoRA推理服務器,專為在單個GPU上同時服務多個LoRA微調模型而設計。與傳統的獨立LLM部署相比,LoRAX具有幾個創新的組件:

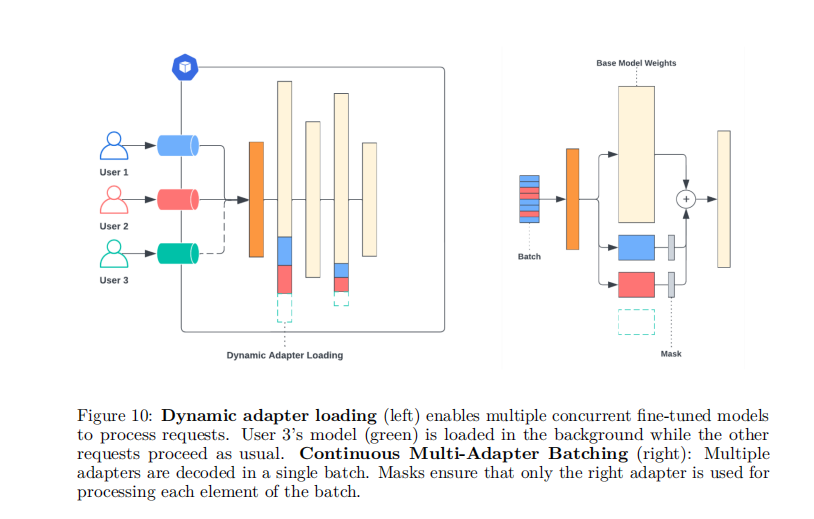

動態適配器加載:允許在運行時按需從存儲中加載每組微調LoRA權重,而不會阻塞并發請求。

連續多適配器批處理:一種公平的調度策略,通過在多個LoRA適配器集上并行工作來優化系統的總體吞吐量。

分層權重緩存:支持在請求之間快速交換LoRA適配器,并將適配器權重卸載到CPU和磁盤,以避免內存溢出錯誤。

在實際應用中,LoRAX成功部署了25個LoRA微調的Mistral-7B LLM,這些模型被用于服務數千名用戶,所有模型均部署在單個NVIDIA A100 GPU上。我們的基準測試顯示,即使在負載增加的情況下,系統的延遲和吞吐量表現仍然穩定,證明了LoRAX在處理高并發和大規模部署方面的有效性。

總體而言,LoRAX不僅提高了部署效率,還通過支持多模型并發處理,顯著降低了成本和資源消耗,使得在實際生產環境中使用多個專門化的LLM成為可能。

性能基準與部署效果

在本研究中,我們對310個使用LoRA方法微調的大型語言模型(LLM)進行了性能評估。這些模型覆蓋了10種基礎模型和31種任務。通過對比微調前后的性能,我們發現LoRA微調顯著提升了模型的表現。

1. 性能提升概覽

根據我們的數據,使用LoRA微調的模型在多數任務中表現優于基礎模型。具體來說,微調后的模型在31個任務中的平均表現比GPT-4高出約10個百分點。這一發現突出了LoRA微調策略在提升特定任務性能方面的有效性。

2. 部署效果

我們使用LoRAX,一個開源的多LoRA推理服務器,來部署這些微調后的模型。LoRAX支持在單個GPU上同時服務多個LoRA微調模型,通過共享基礎模型權重和動態適配器加載來優化資源使用。在實際部署中,LoRA Land網應用能夠在單個NVIDIA A100 GPU上托管25個LoRA微調的Mistral-7B LLM,展示了在單一硬件資源上部署多個專業化LLM的經濟效率和實用性。

討論與分析

1. 基礎模型和任務選擇的影響

我們的分析顯示,不同的基礎模型和任務類型對微調效果有顯著影響。例如,Mistral-7B和Zephyr-7b模型在多數任務中表現出色,這可能與它們的架構特性和適應性有關。此外,我們發現任務的復雜性也是一個重要因素,簡單的分類任務往往能夠通過微調獲得更大的性能提升。

2. 微調與任務復雜性的關系

通過對任務復雜性和微調質量提升的相關性分析,我們發現一些有趣的模式。例如,任務的輸入輸出長度、內容多樣性和壓縮性等因素與模型性能提升之間存在相關性。這些發現為未來在選擇微調策略和預測微調效果時提供了有價值的見解。

3. 部署性能的實際觀察

在LoRA Land的實際部署中,我們觀察到即使在用戶并發量大幅增加時,系統的響應時間和吞吐量仍能保持在合理范圍內。這證明了LoRAX在實際應用中處理高并發請求的能力,同時也突顯了使用動態適配器加載技術的優勢。

總體而言,我們的研究不僅展示了LoRA微調方法在提升LLM性能方面的有效性,也驗證了在實際應用中部署多個微調模型的可行性和效率。未來的工作可以進一步探索不同微調策略和基礎模型選擇對性能的具體影響,以及如何進一步優化模型部署的成本效益。

結論與未來展望

在本研究中,我們探討了低秩適應(LoRA)對大型語言模型(LLM)進行微調的有效性,以及在生產環境中同時服務多個微調后的LoRA LLM的可行性。

1. 模型質量

我們的結果驗證了LoRA微調顯著提升了LLM的性能,超越了未經微調的基礎模型和GPT-4。特別是像Mistral-7B這樣的模型在多個任務上表現出色,突顯了在微調成功中選擇合適的基礎模型的重要性。我們發現,任務的復雜性啟發式可以作為預測微調成功的潛在指標,這表明任務的性質在微調的有效性中扮演重要角色。

2. 模型服務

通過LoRAX框架,我們展示了在LoRA Land網絡應用中實際部署這些模型的情況。我們提供了首次令牌時間(TFTT)、總請求時間和令牌流時間的基準,并測量了LoRAX在多達100個并發用戶的情況下的延遲穩健性。

LoRA Land強調了使用多個專門的LLM而不是單一的通用LLM的質量和成本效益。

3. 限制與改進方向

盡管取得了這些成果,但評估的規模、訓練限制和我們的提示工程方法的簡單性表明了未來改進的領域。我們釋放了所有的模型和訓練設置,以供社區進一步驗證和實驗。

4. 未來研究方向

未來的研究應考慮更全面的評估,以允許資源允許的情況下,更好地理解微調在不同任務和模型規模上的效果。此外,探索更廣泛的模型大小,包括更大的模型,如13B或70B,可能提供關于不同計算能力下微調的可擴展性和有效性的見解。

總之,本研究不僅展示了LoRA在提升特定任務的LLM性能方面的潛力,還成功地展示了在實際應用中訓練和服務多個任務專用LLM的實際效率。

本文轉載自 ??AI論文解讀??,作者: 柏企